AMDは、EPYCサーバーCPUのアップデートと同時に、「Instinct MI300」アクセラレータファミリーについても新たな情報を提供している。Zen 4 CPUコアとCDNA 3 GPUコアの両方を1つのパッケージに搭載した同社の次世代HPCクラス・プロセッサーは、現在、XPUのマルチSKUファミリーとなった。

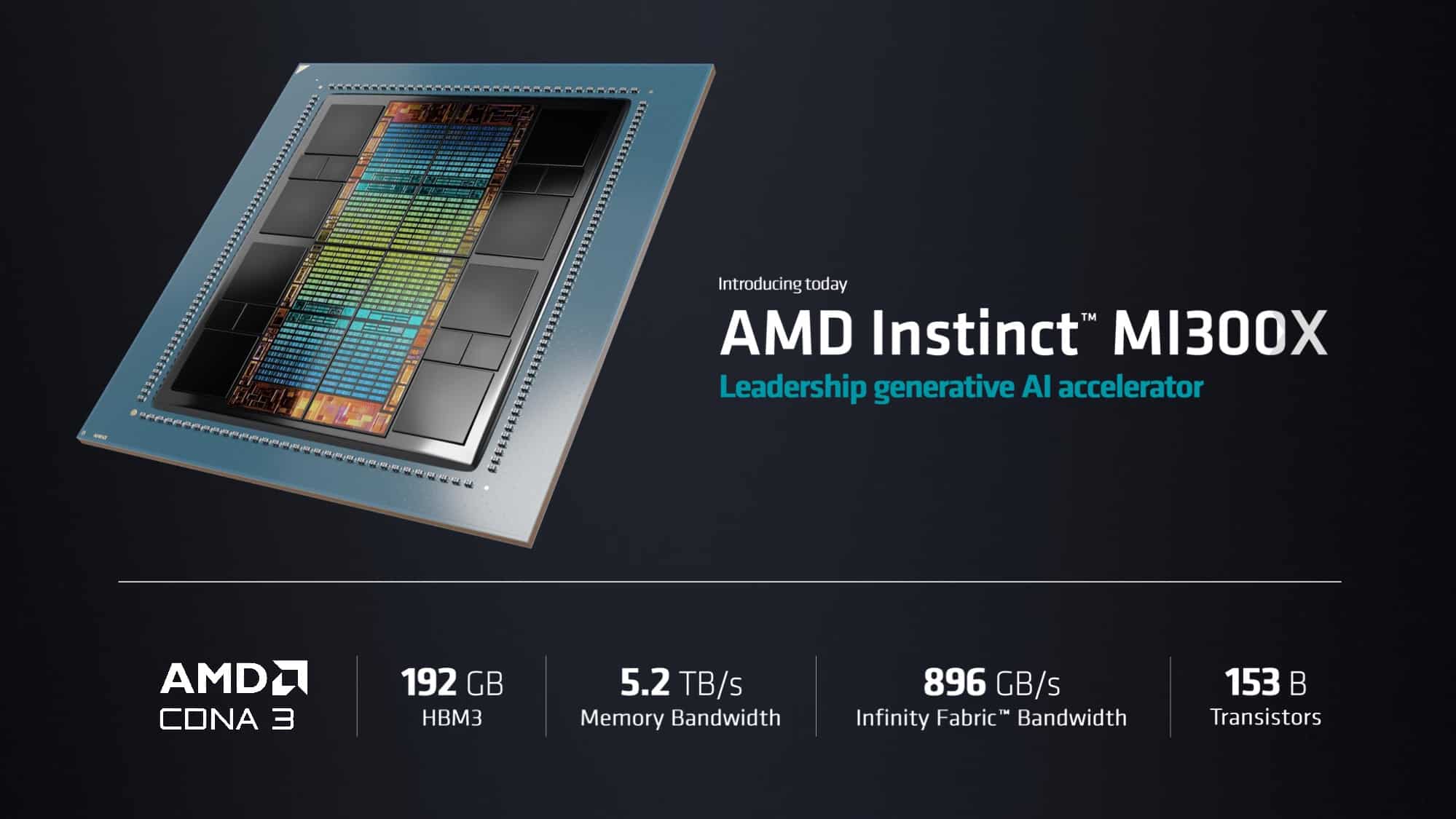

先に発表された128GBのMI300 APU(現在はMI300Aと呼ばれている)に加えて、AMDは同じ設計を用いた純粋なGPUパーツも製造している。MI300Xと名付けられたこのチップは、MI300AのCPUとGPUタイルの混合ではなく、CDNA 3 GPUタイルのみを使用しており、192GBのHBM3メモリと組み合わされる純粋で高性能なGPUになっている。MI300Xは、大規模言語モデル市場をターゲットとしており、最大規模のモデルを動かすためにあらゆるメモリ容量が必要な顧客向けに設計されている。

昨年6月に初めて発表され、CES 2023でさらに詳しく説明されたAMD Instinct MI300は、AIおよびHPC市場へのAMDの大きな挑戦だ。このユニークなサーバーグレードのAPUは、Zen 4 CPUコアとCDNA 3 GPUコアの両方を、チップレットベースの1つのチップに搭載している。AMDの競合他社には、今年、MI300シリーズのようなCPU+GPUの組み合わせの製品がない(あるいは、ある予定)ので、真に一体化したメモリ・アーキテクチャと、CPUとGPUタイル間の十分な帯域幅を備えた興味深いソリューションをAMDに提供する。

MI300は、HBM3によるオンチップ・メモリも搭載しており、8スタックのHBM3が使用されている。CESで発表された時点では、HBM3スタックの最大容量は16GBで、最大128GBのローカル・メモリ・プールを持つチップ設計になっていた。しかし、最近24GBのHBM3スタックが登場したおかげで、AMDは50%増の192GBのメモリを搭載したMI300のバージョンを提供することができるようになったのだた。MI300Xに搭載された追加のGPUチップレットとともに、最大かつ最も複雑なLLMを処理するための強力な武器となることを意図している。

MI300Xは、MI300Aよりも少しシンプルなチップだ。AMDは、MI300Aの3つのCPUチップレットを、わずか2つのCDNA 3 GPUチップレットに置き換え、8つのGPUチップレットと4つのIOメモリチップレットと思われる、全体で12チップレットの設計になっている。その他、CPUコアの削除(およびAPUの脱APU化)にもかかわらず、GPUのみのMI300XはMI300Aによく似ているように見える。そして明らかに、AMDはAPUとフラッグシップCPUの両方を同じパッケージで提供することで、相乗効果を狙っているようだ。

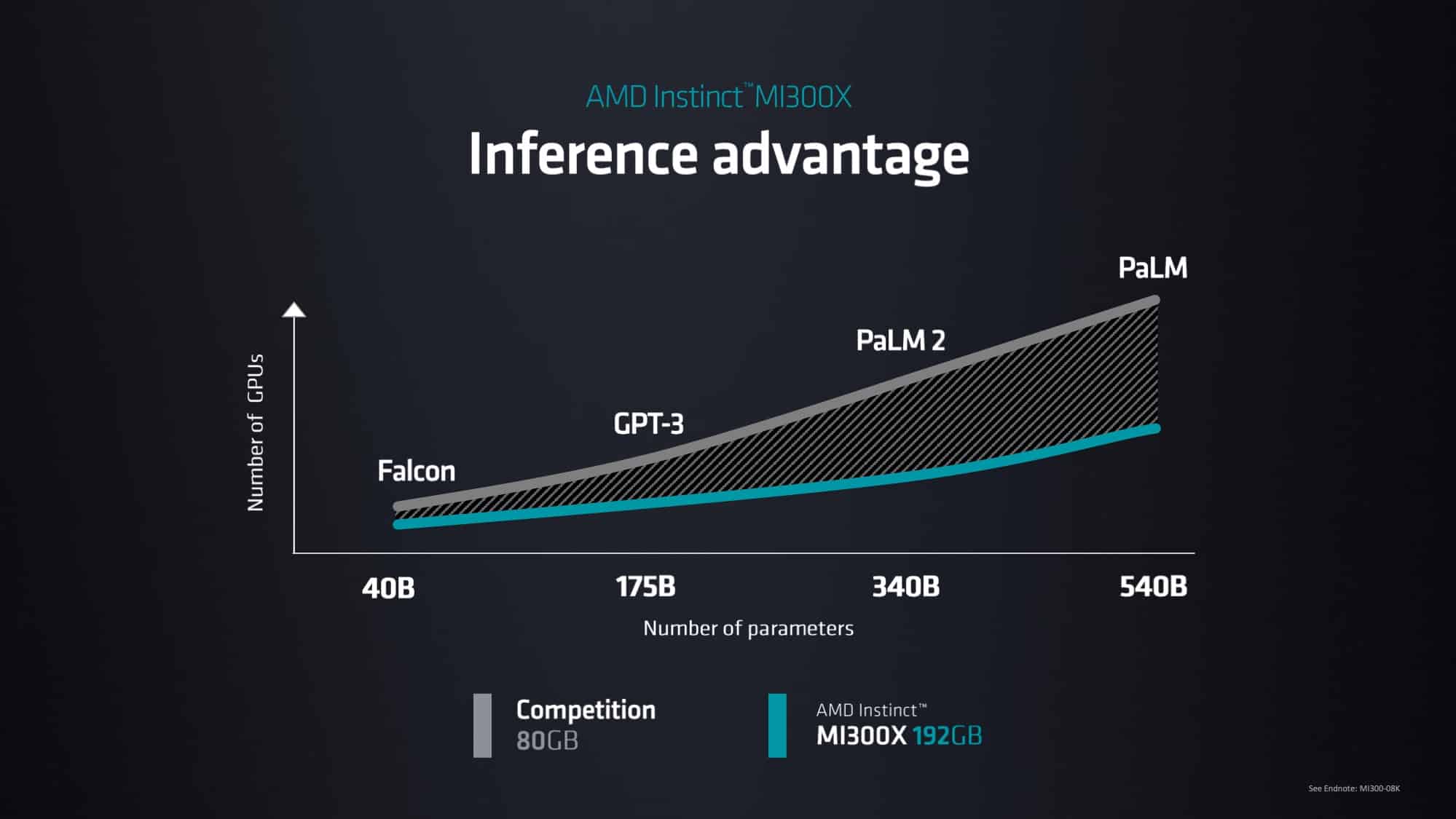

GPUの性能はともかくとして、AMDがMI300Xを語る上で重要なのは、メモリ容量だ。現在のAI用大規模言語モデル(LLM)にとって、メモリ容量が制約要因であることを考えると、192GBのチップを単体で提供するだけでも大きな意味があるNVIDIAなどの最近の動向を見てもわかるように、AIの顧客はGPUやその他のアクセラレータを手に入れるやいなや、さらに大きなモデルを実行するために、より多くのメモリを要求している。そのため、8チャンネルのHBM3メモリを使用する192GBの巨大なGPUを提供できることは、現在の市場において、AMDにとって相当なアドバンテージとなるはずだ–少なくとも、MI300Xが出荷を開始すれば。

MI300ファミリーは、今年後半のある時点で出荷される予定だ。AMDによると、128GBのMI300A APUは、現在すでに顧客にサンプリングされているとのこと。一方、192GBのMI300X GPUは、今年の第3四半期に顧客向けにサンプリングされる予定だ。

また、今回の発表で、AMDはライバルのIntelより少なくとも3年早く、フレキシブルXPU設計を行なうことを固めたことは言うまでもない。IntelがCPU+GPUの複合製品「Falcon Shores」を廃止して純粋なGPU「Falcon Shores」にしたのに対し、AMDは早ければ今年末にCPU+GPU/GPUのみの柔軟な製品を提供する予定になっている。APU/XPUではないものの、NVIDIAのGrace CPUとHopper GPUを高帯域のNVLinkで連携させることで、非常に近い存在となるNVIDIAのGrace Hopperスーパーチップなどの製品と、この時間枠では対決することになる。そのため、MI300Xの詳細が待たれるところだが、2つのGPUタイタンの間で非常に興味深い戦いになるはずだ。

全体として、MI300ファミリに関してAMDにかかるプレッシャーは大きい。AIアクセラレータの需要は、この1年の大半で急上昇しており、MI300は、AMDが市場で大きな勝負をする最初のチャンスとなる。MI300は、AMDの命運を左右するような製品ではないが、シングルチップのサーバー用APUを初めて出荷したという技術的優位性(とそれに伴う自画自賛権)を得られるほか、ハードウェアを買い占める市場に売り込むための新鮮な製品を提供することができるだろう。つまり、MI300は、NVIDIAのH100のように、作れば作るだけお金になるような物になることが期待されており、AMDの熱心な投資家はそう願っているだろう。

AMD Infinityアーキテクチャ・プラットフォーム

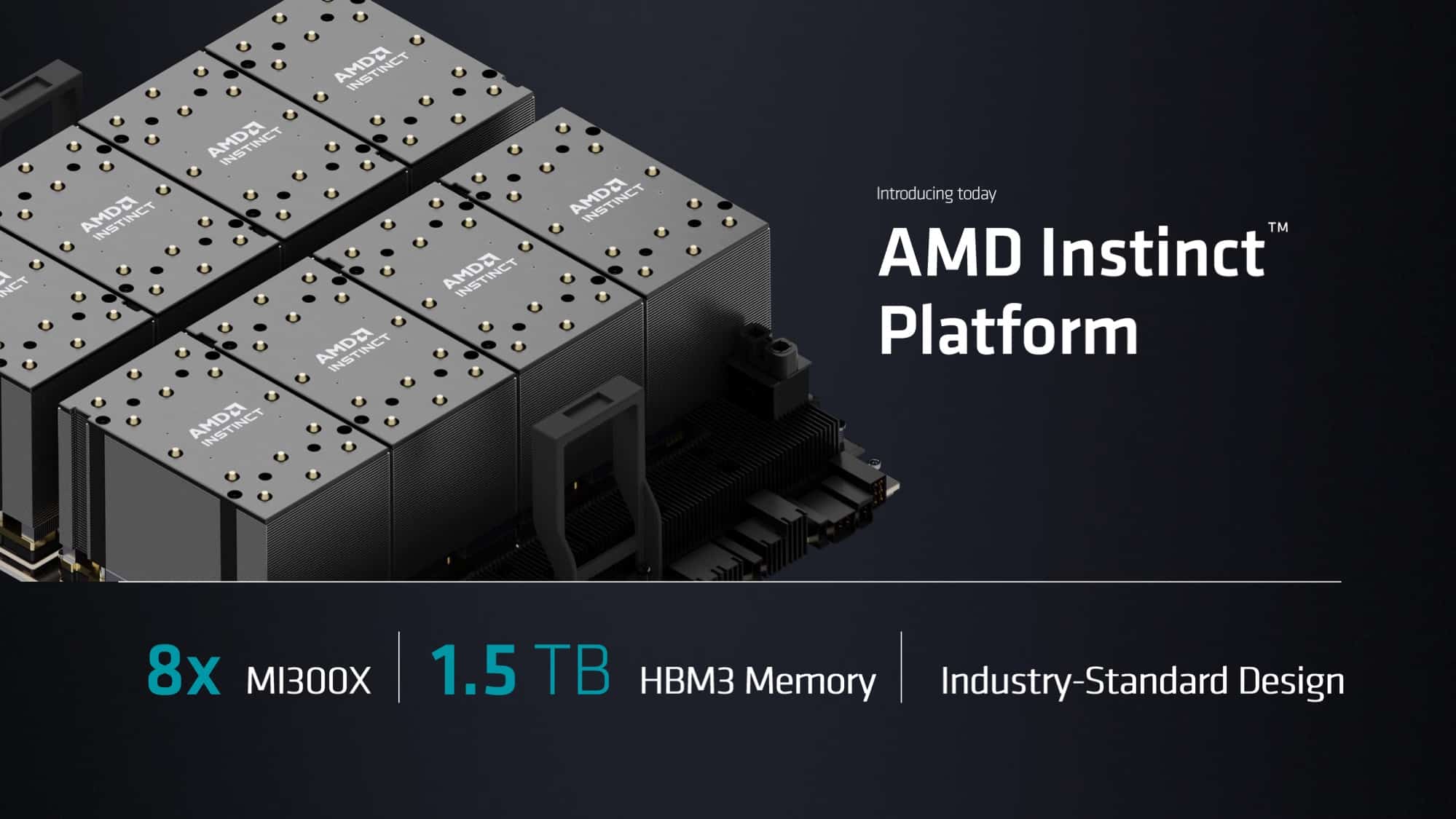

今日の192GB MI300Xのニュースと同時に、AMDはAMD Infinityアーキテクチャ・プラットフォームと呼ぶものを簡単に発表している。これは8ウェイMI300Xデザインで、AMDのトップエンドGPUを最大8個まで連結して、より大きなワークロードに取り組むことを可能にする。

NVIDIAの8ウェイHGXボードやIntelのPonte Vecchio用x8 UBBに見られるように、8ウェイプロセッサ構成は、現在ハイエンドサーバのスイートスポットとなっている。これは、物理的な設計上の理由(チップを配置するスペースや冷却経路を確保するスペース)と、多数のチップをホップをかけずに連結するための最良のトポロジーの両方があるためだ。AMDがNVIDIAと直接対決し、HPC GPU市場の一部を獲得しようとするならば、NVIDIAのハードウェア製品に対抗する必要があるのは、この分野だけでないだろう。

AMDは、Infinityアーキテクチャ・プラットフォームを「業界標準」の設計と呼んでいる。AMDによれば、彼らはOCPサーバープラットフォームをベースとして使用しているとのことで、これはMI300XがOAMフォームファクターを使用していることを示唆しているが、これについてはまだ明確な確認が得られていない。

Source

コメントを残す