一般的な人工知能と特に生成AIの幅広い採用により、広帯域メモリの需要は今後数四半期および数年で爆発的に増加することが予想される。TrendForceによると、SK hynixはこのタイプのメモリの出荷をリードし、2022年には50%のシェアを占めるため、HBM分野での主な受益者となる可能性が高い。

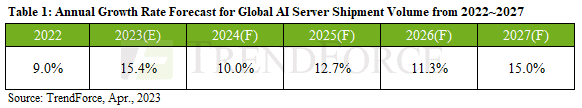

TrendForceのアナリストは、NvidiaのA100やH100のようなコンピュートGPUを搭載したAIサーバーの出荷台数は、2022年に前年比約9%増加すると考えている。ただし、出荷台数なのか、出荷額なのかについては詳しく説明していない。そして、生成AIの台頭がAIサーバーの需要を喚起し、この市場は2023年に15.4%成長し、2027年まで年平均成長率12.2%で成長し続けると予測している。

また、AIサーバーの利用拡大により、汎用DDR5 SDRAM、HBM2eやHBM3などのコンピュートGPU、高性能・大容量ストレージの3D NANDメモリなど、あらゆる種類のメモリの需要が高まると予想する。

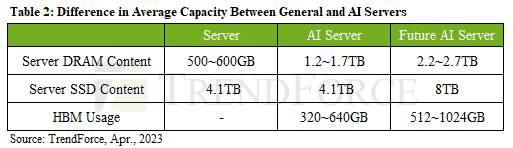

TrendForceの試算では、汎用サーバーが500GB~600GBの汎用メモリを搭載しているのに対し、AIサーバーは1.2TB~1.7TBを使用している。さらに、80GB以上のHBM2e/HBM3メモリを搭載したコンピュートGPUが使用されている。各AIマシンには複数のコンピュートGPUが搭載されているため、1台あたりのHBMの総内容は現在320GB~640GBとなっており、AMDのInstinct MI300やNvidia H100 NVLなどのアクセラレータがより多くのHBM3メモリを搭載するため、さらに増加すると予想される。

HBM3の採用について言えば、TrendForceによると、このタイプのメモリを量産しているメーカーは現在SK Hynixだけであることに注目する必要がある。そのため、このタイプのメモリの需要が高まれば、最も大きな恩恵を受けることになる。昨年、SK HynixはHBM出荷量の50%を占め、Samsungが40%、Micronが10%と続いた。一方、SamsungとMicronのシェアはそれぞれ38%と9%に低下するとTrendForceは主張している。

現在、AIサーバーは主にAWS、Google、Meta、Microsoftといった米国の大手クラウドサービスプロバイダーで利用されている。今後、多くの企業が生成AI製品を発売するようになると、必然的にオンプレミスかAWSやMicrosoftでAIサーバーを利用する必要が出てくる。例えば、BaiduとByteDanceは、今後四半期に生成AI製品およびサービスを導入する予定だ。

Source

コメントを残す