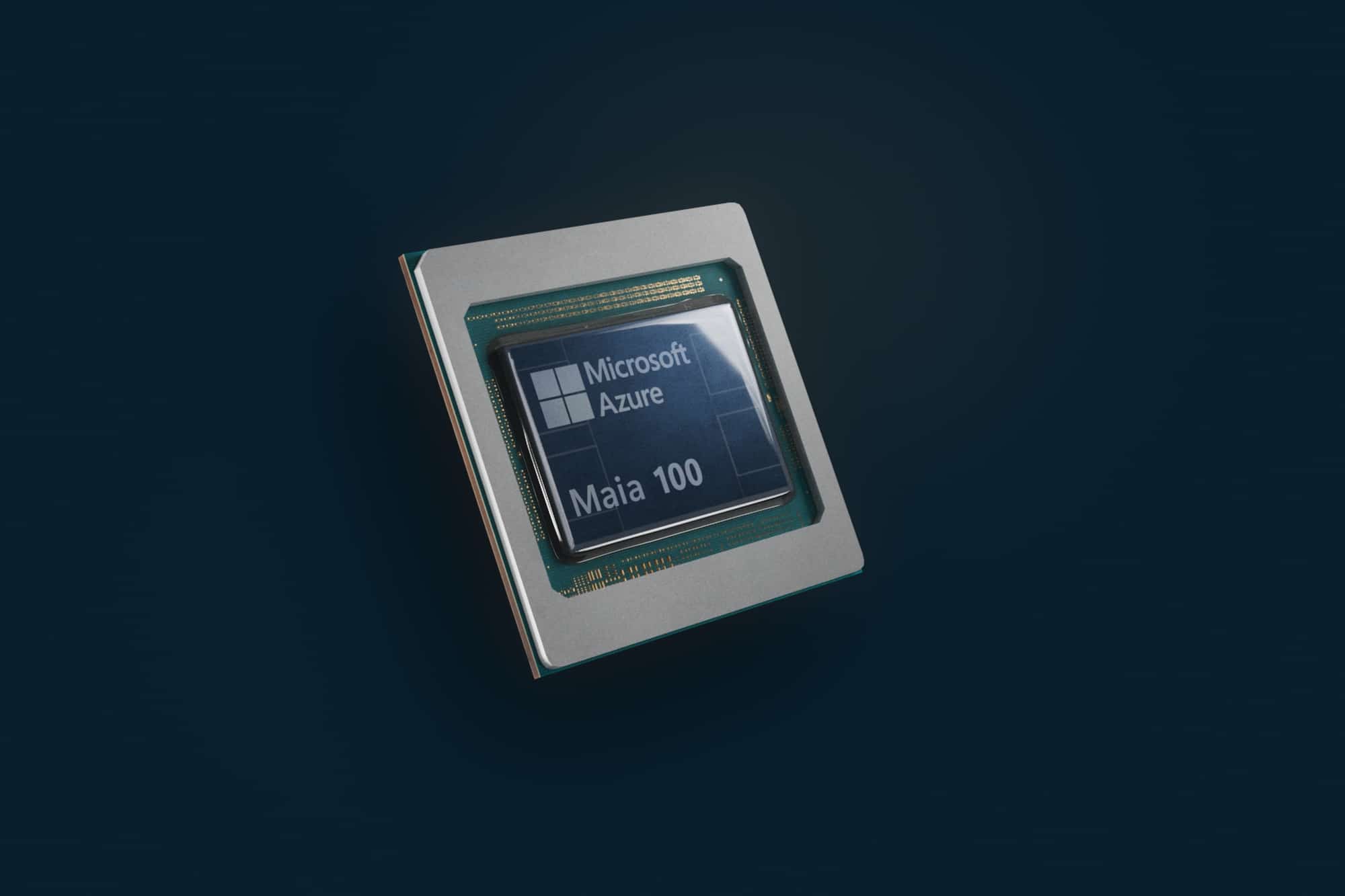

Microsoftは、以前から噂されていた同社独自のカスタムチップAthenaの詳細を、開発者向けカンファレンス「Microsoft Ignite」にてに明らかにした。1つはAIタスクや生成AI向けの処理を加速する「Azure Maia 100 AI Accelerator」であり、もう一つはMicrosoft Cloud上の汎用コンピュートワークロード向けのArmベースの「Azure Cobalt 100 CPU」だ。両チップは最新のプロセスノードで製造され、最先端の計算性能を実現するという。

このプロジェクトの背景には、AIに対する現代の需要を満たすために、「シリコンからサービスまでのすべて」を調整するという考えがある。Microsoftは、自社製チップを開発する以外にも、ソフトウェア、サーバーラック、冷却システムなど、あらゆるものをAIワークロード用に最適化した。

これらのチップは、Microsoftのデータセンターで「来年初め」に登場し、MicrosoftのCopilot、Azure OpenAI、その他のサービスを稼働させることからスタートする。具体的にどの程度の規模で稼働するのかは明らかにされておらず、同社は今後も、NVIDIAやAMDといったパートナーのチップも希望する顧客に提供する予定だ。

Maia 100は特にAzureハードウェア・スタックをターゲットにしており、チップ設計とAIインフラの世代的な改善により、Microsoftはその製品で「大きな利益」を出力できると考えている

スペック自体も詳細が明らかにされておらず、既存のNVIDIA製品等との比較も行う事は出来ない。

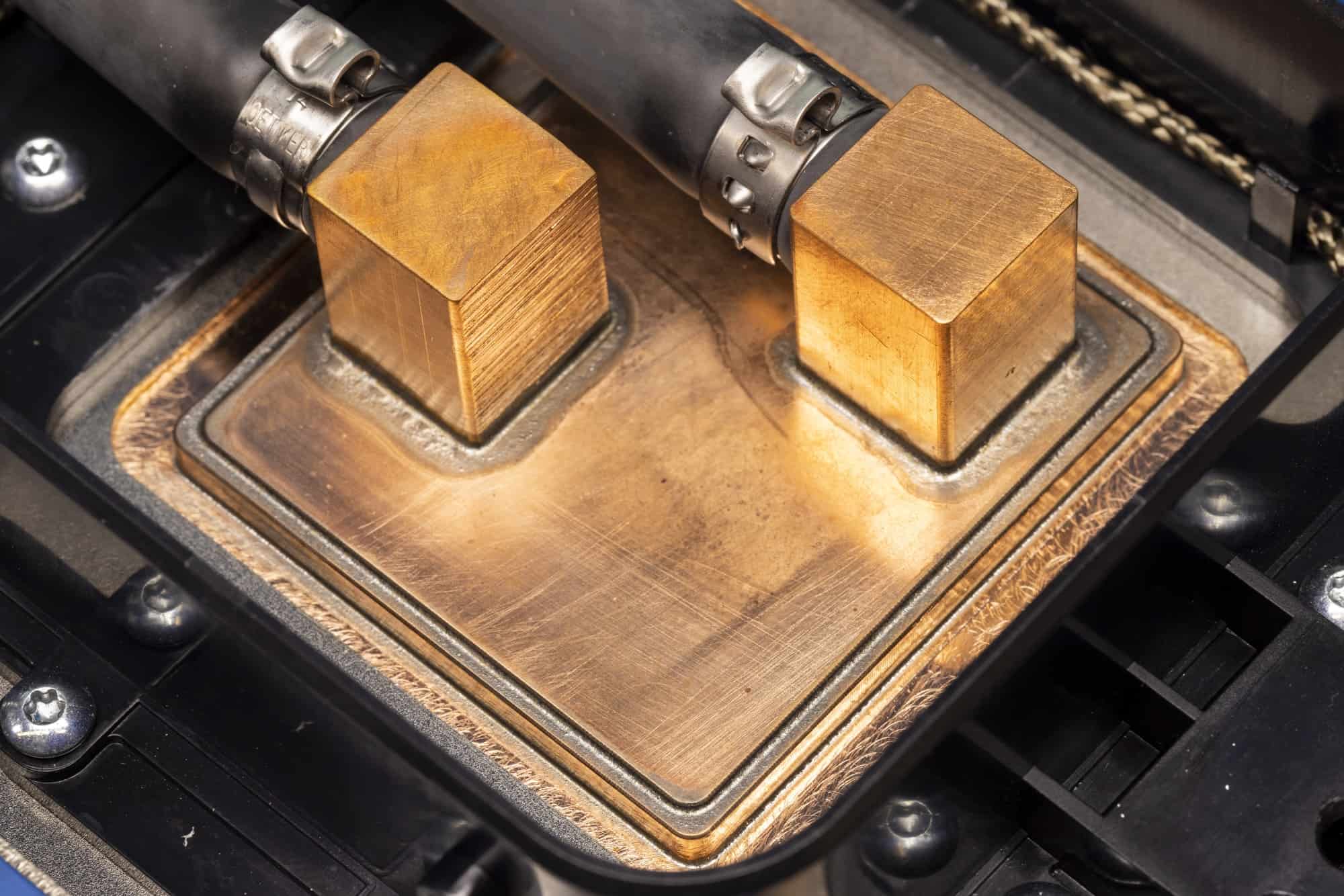

Microsoft Azure Maia 100はTSMCの5nmノードで作られたASICで、x86ホストを使用する。新しいチップを既存のデータセンター・インフラに搭載するため、Microsoftはサーバーラックの設計を変更し(新しいプロセッサーにはより幅の広いボードが必要)、液冷ソリューションを導入した。Maia 100サーバーのラックの隣に配置でき、Maia 100チップに取り付けられたコールドプレートに冷たい液体を送り、温かい液体を戻して熱を取り除き、再びラックに冷たい液体を戻すことができる「サイドキック」と呼ぶものを使用している。

Maia 100は、カスタム液冷ラックに搭載され、最大4個のチップを提供する。チップは標準的なINT8とINT4のデータフォーマットをサポートし、組み込みイーサネット・インターフェースを利用する。加えて、MicrosoftのAIの最大のパートナーであるOpenAIもMaia 100の設計に当たってはフィードバックを提供しているという。

OpenAIのSam Altman CEOは以下のように述べている:

「Microsoftとの最初の提携以来、私たちは、私たちのモデルと前例のないトレーニングのニーズに合わせて、AzureのAIインフラストラクチャをあらゆるレイヤーで共同設計するために協力してきました。Microsoftが初めてMaiaチップの設計を共有したとき、私たちは興奮しました。AzureのエンドツーエンドのAIアーキテクチャは、Maiaによってシリコンまで最適化され、より高性能なモデルをトレーニングし、そのモデルを我々の顧客にとってより安価なものにする道を開いています」。

もう一つのカスタムチップAzure Cobalt 100のCPUはArmベースで、ハードウェア製品開発担当のWes McCullough副社長はブログの中で「電力効率を念頭に置いて設計されている」と述べている。

明らかにされている使用としては、合計128個のNeoverse N2コアを搭載し、12チャンネルのDDR5メモリをサポートし、従来のArmサーバーチップと比較してコアあたりの性能が最大40%向上しているとのことだ。

同社はすでに、Maia AIアクセラレータとAzure Cobalt CPUの両方の第2世代バージョンに取り組んでいるとのことだ。

新しいハードウェアに加え、MicrosoftはAzure Boostも発表した。Azure Boostは、ストレージとネットワーキングのプロセスをホストサーバーから、これらの目的専用に設計されたハードウェアとソフトウェアに移行することで、より迅速な処理が可能になるとしている。

Microsoftはまた、AMDとNVIDIAの両社とのさらなるパートナーシップも発表した。AMD側では、MicrosoftはAzureプラットフォームにAMD MI300X仮想マシンを追加する。NVIDIAについては、NVIDIAのH00 Tensor Core GPU向けに設計された新しいNC H100 v5仮想マシンシリーズのプレビューがある。

Meta、Amazon、Googleなど、クラウドに特化した特注のデータセンター向けCPUがひしめく中、Microsoftのこの動きは大きなインパクトを与えそうだ。Intel、AMD、NVIDIAのような古くからのデータセンターの主力企業はもちろん、Ampereのような比較的に新しい企業も、これらの発表の影響を受け、独自の大胆な動きをしなければならないだろう。

Source

コメントを残す