先週末、OpenAIは、テキストプロンプトから短い動画を生成する新しい生成AIシステム「Sora」を発表した。Soraはまだ一般公開されていないが、これまでに発表されたサンプル出力の質の高さは、興奮と懸念の両方の反応を引き起こしている。

OpenAIが公開したサンプル動画は、Soraが手を加えることなく直接作成したもので、「コーヒーカップの中を航行する2隻の海賊船が戦う様子を写実的にクローズアップした動画」や「ゴールドラッシュ時のカリフォルニアの歴史的映像」といったプロンプトからの出力を示しているという。

映像のクオリティの高さ、テクスチャ、シーンのダイナミクス、カメラの動き、一貫性の高さなどから、一見しただけではAIが生成したものだとわからないことが多い。

OpenAIの最高責任者であるSam Altman氏は、ユーザーが提案したプロンプトに応じて生成されたいくつかの動画をX(旧Twitter)にも投稿し、Soraの能力を実証している。

Soraの仕組み

Soraは「diffusion transformer model」と呼ばれるもので、テキスト生成ツールと画像生成ツールの機能を組み合わせたものだ。

Transformerモデルは、2017年にGoogleが初めて導入したニューラルネットワークの一種である。ChatGPTやGoogle Geminiのような大規模な言語モデルでの使用でよく知られている。

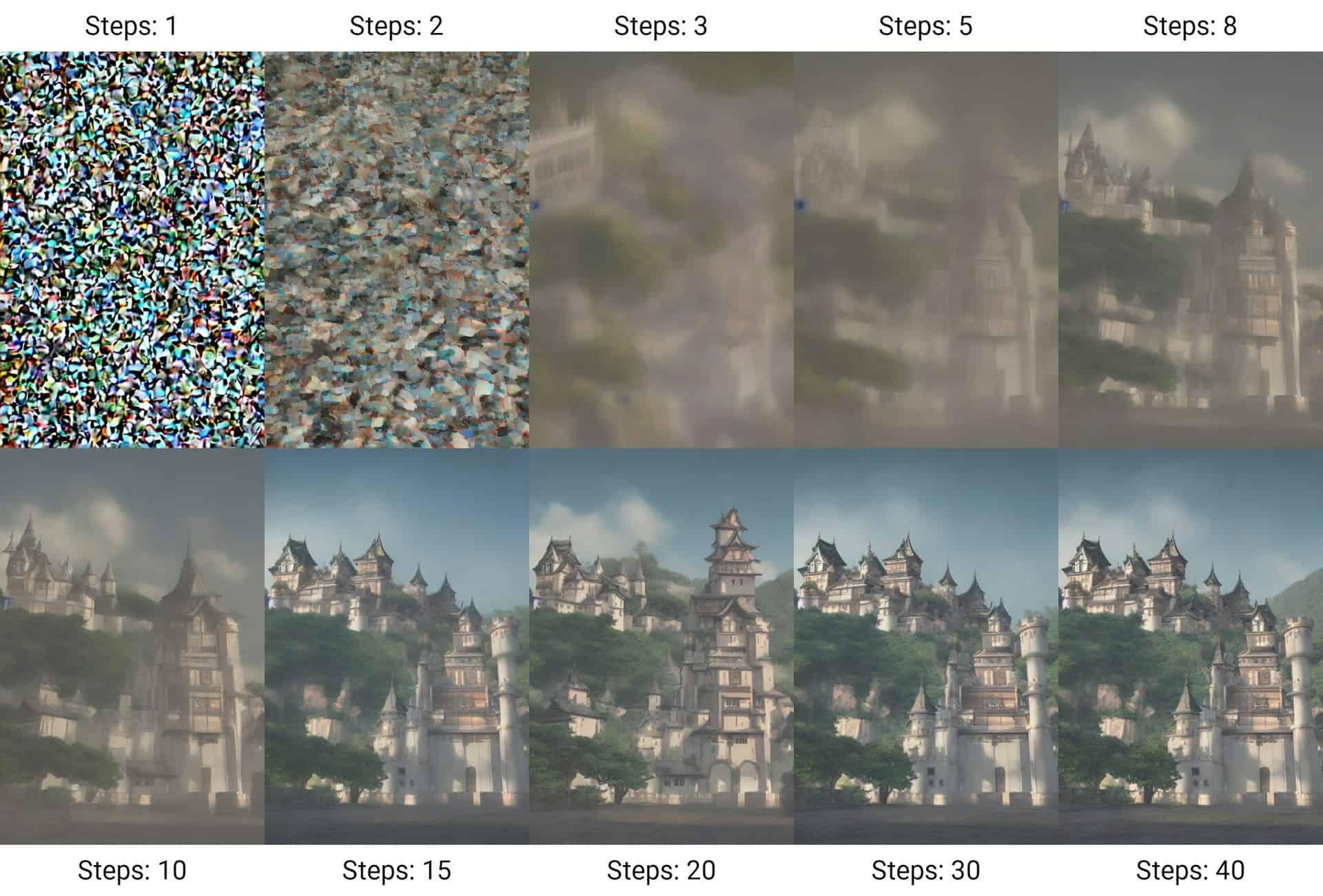

一方、Diffusionモデルは、多くのAI画像ジェネレーターの基盤となっている。ランダムなノイズから始まり、入力プロンプトに適合する「きれいな」画像に向かって反復することで機能する。

ビデオは、このような画像の連続から作ることができる。しかしビデオでは、フレーム間の一貫性と整合性が不可欠である。

Soraは、フレームが互いにどのように関連しているかを処理するために、Transformerアーキテクチャを使用する。Transformerは当初、テキストを表すトークンのパターンを見つけるために設計されたが、Soraは代わりに空間と時間の小さなパッチを表すトークンを使う。

先頭を走る

Soraは最初のテキストから動画への変換モデルではない。それ以前のモデルには、Meta社のEmu、Runway社のGen-2 、Stability AI社のStable Video Diffusion、そして最近ではGoogle社のLumiereがある。

つい数週間前にリリースされたLumiereは、先行モデルよりも優れた動画を生成すると主張している。しかし、Soraは少なくともいくつかの点でLumiereよりも強力なようだ。

Lumiereが512×512ピクセルに制限されているのに対し、Soraは最大1920×1080ピクセルの解像度と様々なアスペクト比の動画を生成できる。Lumiereのビデオは5秒程度であるのに対し、Soraは60秒までのビデオを作成できる。

また、Lumiereでは複数のショットを組み合わせた動画は作成できないが、Soraでは可能である。また、他の機種と同様に、画像や他の動画から動画を作成したり、異なる動画の要素を組み合わせたり、動画を時間軸で延長するなどの動画編集が可能だという。

どちらのモデルもおおむねリアルな映像を生成するが、幻覚に悩まされることもある。Lumiereの映像は、AIが生成したものだと認識されやすいかもしれない。Soraの動画は、よりダイナミックで、要素間の相互作用があるように見える。

しかし、多くの動画例では、よく見ると矛盾が明らかになる。

有望なアプリケーション

現在、映像コンテンツは実世界を撮影するか、特殊効果を用いて制作されているが、いずれもコストと時間がかかる。Soraがリーズナブルな価格で入手できるようになれば、アイデアを視覚化するプロトタイピング・ソフトウェアとして、より低コストで利用されるようになるかもしれない。

私たちが知っているSoraの能力からすると、エンターテイメント、広告、教育などの用途で短いビデオを作成するのに使うこともできるだろう。

Soraに関するOpenAIの技術論文のタイトルは「世界シミュレータとしてのビデオ生成モデル(Video generation models as world simulators)」である。この論文では、Soraのようなビデオジェネレーターの大きなバージョンは、「物理的、デジタル的な世界と、その中に住む物体、動物、人間の有能なシミュレーター」になるかもしれないと論じている。

もしこれが正しければ、将来のバージョンは物理的、化学的、さらには社会的な実験に科学的に応用できるかもしれない。例えば、さまざまな大きさの津波が、さまざまな種類のインフラに与える影響や、近隣の人々の身体的・精神的健康に与える影響を調べることができるかもしれない。

このレベルのシミュレーションを実現するのは非常に困難であり、専門家の中には、Soraのようなシステムでは根本的に無理だと言う人もいる。

完全なシミュレーターは、宇宙の最も詳細なレベルで物理的・化学的反応を計算する必要がある。しかし、世界の大まかな近似をシミュレートし、人間の目にリアルな映像を作ることは、今後数年で手の届くところまで来ているかもしれない。

リスクと倫理的懸念

Soraのようなツールをめぐる主な懸念は、その社会的・倫理的影響に集約される。すでに偽情報に悩まされている世界では、Soraのようなツールは事態を悪化させるかもしれない。

どんなシーンでもリアルな映像を生成できる能力は、説得力のあるフェイクニュースを流したり、実際の映像に疑いを投げかけたりするために使われる可能性があることは容易に想像できる。公衆衛生対策を危険にさらしたり、選挙に影響を与えるために使われたり、あるいは偽の証拠で司法制度に負担をかける可能性さえある。

ビデオジェネレーターは、ディープフェイク(特にポルノ)を通じて、標的となる個人を直接脅すこともできる。これらは、被害を受けた個人やその家族の生活に深刻な影響を及ぼす可能性がある。

こうした懸念のほかに、著作権や知的財産の問題もある。生成AIツールはトレーニングのために膨大な量のデータを必要とするが、OpenAIはSoraのトレーニングデータの出所を明らかにしていない。

大規模言語モデルや画像生成ツールも、この理由から批判されている。米国では、著名な作家のグループが、彼らの著作物が悪用された可能性があるとしてOpenAIを提訴した。この訴訟では、大規模言語モデルとそれを使用する企業が、新しいコンテンツを作成するために著者の作品を盗んでいると主張している。

テクノロジーが法律を先取りするのは、最近に始まったことではない。例えば、ソーシャルメディア・プラットフォームがコンテンツを管理する際の義務については、ここ数年、米国法230条をめぐって激しい議論が交わされてきた。

このような懸念は現実に存在するが、過去の経験に基づけば、動画生成技術の開発が止まることはないだろう。OpenAIは、Soraを一般公開する前に、「誤報、憎悪に満ちたコンテンツ、偏見」の専門家と協力し、「誤解を招くコンテンツの検出を支援するツールを構築する」など、「いくつかの重要な安全策を講じている」と述べている。

コメントを残す