Googleはこのほど、動画作成のための同社の最新AIモデル「Lumiere」を発表した。Lumiereは映像合成を大幅に改善するもので、Googleは、「リアルで多様かつ一貫性のある動き」を作り出すことが、AIベースの映像生成の主要課題のひとつであったと述べている。Lumiereは時空間拡散モデルを提供することで、この問題を解決する(あるいは解決しようとする)ことができるようだ。

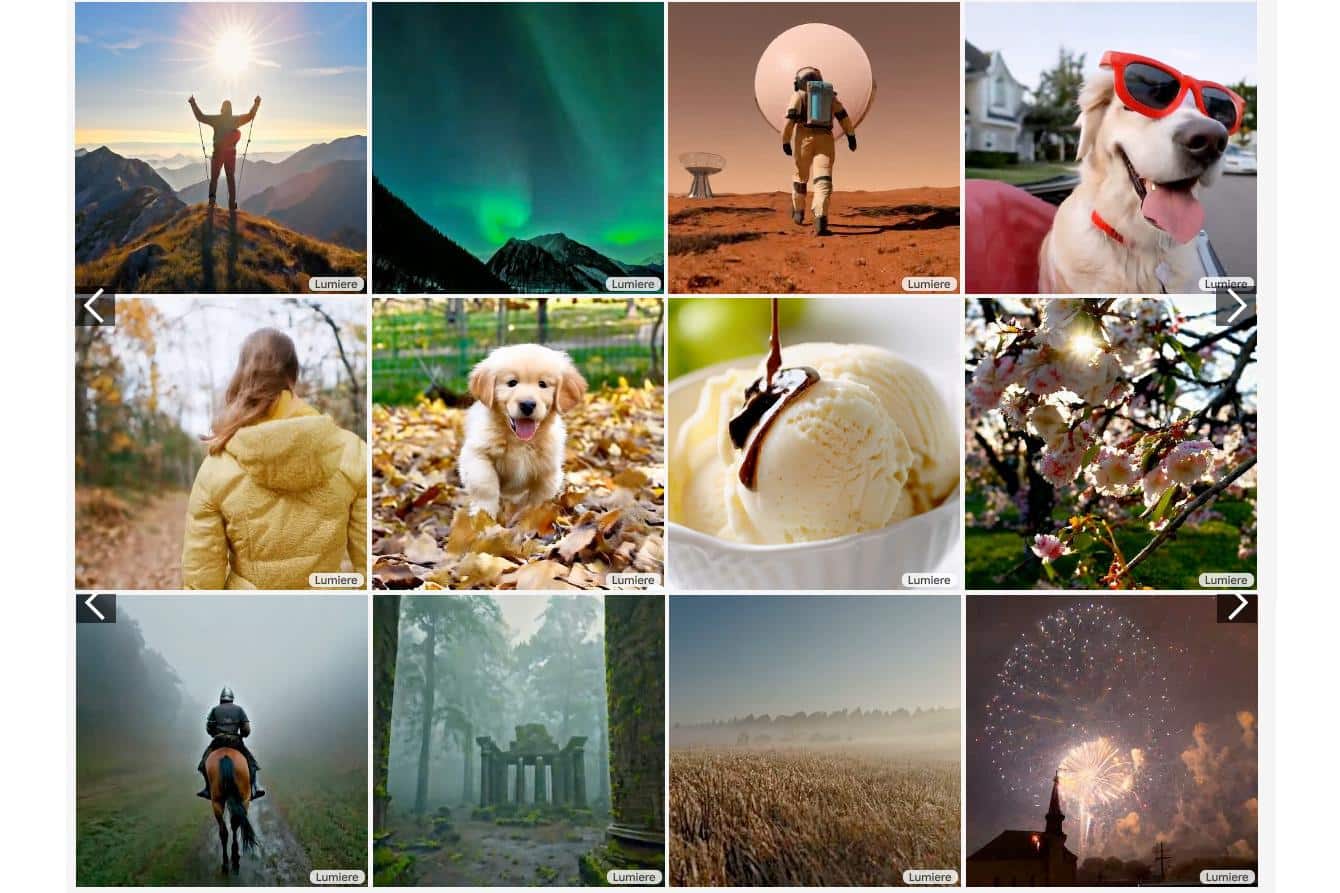

Lumiereでは、ユーザーは、テキストによるプロンプトを書いたり、ソース画像を提供したり(その画像が本物であろうと、リアルであろうと、編集されていようと関係ない)、ターゲットスタイルとして参照画像を使用することで、まったく新しいビデオクリップを作成することができる。

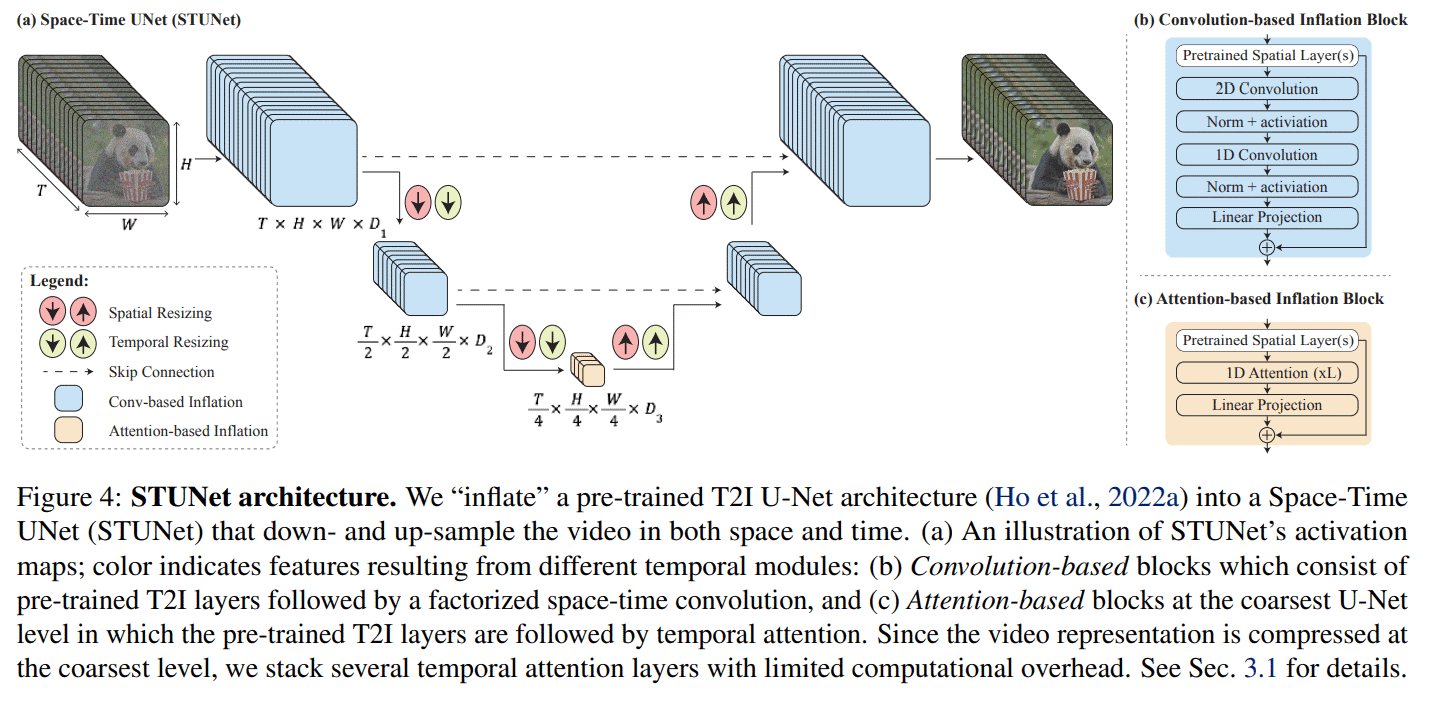

Lumiereは、AIモデルのシングルパスによってビデオクリップ全体を一度に生成する、斬新な「時空間U-Netアーキテクチャ(STUNet)」を採用している。この手法は、一度に映像の一部分しか処理できないモデルのカスケードに基づく従来のアプローチとは根本的に異なる。

Lumiereは、ビデオのインペインティング、画像からビデオへの生成、様式化されたビデオなどの他のアプリケーションにも使用できる。このモデルは3,000万本の動画で学習され、他の手法と比較して、動画の品質とテキストマッチングの点で競争力のある結果を示している。このモデルは、関連するテキストキャプションを持つ3,000万本の動画で学習された。動画の長さは80フレーム、1秒あたり16フレーム(fps)で、それぞれ5秒である。このモデルは、事前に訓練された凍結テキスト-画像モデルに基づいており、時間次元などの動画に関連する側面のための追加レイヤによって拡張された。

Lumiereは、空間的・時間的ダウンサンプリングとアップサンプリングに依存している

まずキーフレームを生成し、そのキーフレーム間に欠落したフレームを挿入するために時間的超解像(TSR)モデルを使用する従来のT2Vモデルとは異なり、Lumiereはビデオシーケンス全体を一度に生成する。これにより、映像全体を通してより一貫性のあるリアルな動きを実現することができる。

これは、既存の手法のように空間解像度をダウンサンプリングしてからアップサンプリングするだけでなく、時間解像度もアップサンプリングするSTUNetアーキテクチャによって可能になる。映像の1秒あたりのフレーム数がダウンサンプリングされ、その後再びアップサンプリングされる。ダウンサンプリングによって、モデルは時間解像度を下げてビデオを処理するが、それでもビデオの全長を見ることができる。こうすることで、このモデルは、オブジェクトやシーンがこの少ないフレーム数でどのように動き、変化するかを学習する。

いったんモデルがこの縮小された解像度での基本的なモーションパターンを学習すると、それを基に、完全な時間解像度での最終的なビデオ品質を向上させることができる。このプロセスにより、生成されたモーションとシーンの品質を損なうことなく、ビデオをより効率的に扱うことができる。

一旦ビデオがこの低い時間的・空間的解像度で生成されると、Lumiereは空間的超解像(SSR)のためにマルチ拡散を使用する。これは、ビデオをオーバーラップするセグメントに分割し、解像度を上げるために各セグメントを個別にエンハンスメントすることを含む。その後、これらのセグメントをつなぎ合わせ、一貫性のある高解像度ビデオを作成する。このプロセスにより、直接の高解像度制作に必要な膨大なリソースを必要とせずに、高品質の映像を制作することが可能になる。

研究論文の中で、Googleの研究者たちは、Lumiereは5秒間の1024×1024ピクセルの動画を出力すると述べている。このような制約があるにもかかわらず、研究者らはユーザー調査において、Imagen Video、Pika、Stable Video Diffusion、Gen-2といった既存のテキストから動画への変換モデルを凌駕したという。

AIが生成する動画はまだ原始的な状態だが、この2年間で品質は進歩している。Metaは2022年9月にAIビデオジェネレーター「Make-A-Video」をデビューさせた。そのすぐ後の2022年10月、Googleが初めて公開した画像合成モデル「Imagen Video」は、書かれたプロンプトから毎秒24フレームで1280×768の短いビデオクリップを生成することができたが、結果は必ずしも首尾一貫していなかった。2023年3月には、RunwayのGen2ビデオ合成モデルが、テキストプロンプトからのビデオクリップ作成で大きな品質の改善を見せた。そして11月には、Stability AIからは静止画像から短いクリップを生成できるStable Video Diffusionが登場している。

こうした、テキストから画像や動画を作成するAIモデルがより高性能になる事が取り上げられる度に、ディープフェイク等の欺瞞的な作り物による現実世界への影響を考えずにはいられない。圧倒的なリアリズムを備えた衝撃的な映像を作成し、瞬く間にWeb上で拡散することにより、容易に社会を混乱に陥れ、実社会に経済的な損失を生み出すことも可能になるかも知れない。

そのために、研究者たちはLumiereの論文の「社会的インパクト」のセクションで、「この研究の第一の目標は、初心者ユーザーが創造的で柔軟な方法で映像コンテンツを生成できるようにすることです」と書いている。「しかし、我々の技術には、偽のコンテンツや有害なコンテンツを作成する悪用される危険性があり、安全で公正な使用を保証するためには、偏見や悪意のある使用例を検出するツールを開発し、適用することが極めて重要だと考えています」 と書いている。

論文

参考文献

- Google Research: Lumiere

研究の要旨

ビデオ合成における極めて重要な課題である、リアルで多様かつコヒーレントな動きを描写するビデオの合成のために設計された、テキストからビデオへの拡散モデルであるLumiereを紹介する。この目的のために、我々は時空間U-Netアーキテクチャを導入し、モデルのシングルパスを通して、ビデオの全時間的持続時間を一度に生成する。これは、離れたキーフレームを合成した後に時間的な超解像を行う既存のビデオモデルとは対照的である。空間的および(重要な)時間的ダウンサンプリングとアップサンプリングの両方を導入し、事前に訓練されたテキストから画像への拡散モデルを活用することで、我々のモデルは、複数の時空間スケールで処理することにより、フルフレームレートの低解像度ビデオを直接生成することを学習する。我々は、最先端のテキストからビデオへの生成結果を実証し、我々の設計が、画像からビデオ、ビデオのインペインティング、定型化された生成など、幅広いコンテンツ作成タスクやビデオ編集アプリケーションを容易に促進することを示す。

コメントを残す