Micronが世界初のHBM3Eチップの量産を開始したばかりだが、Samsungもこれに負けじと業界初の12スタックHBM3E DRAMチップを開発した事を発表した。

これはこれまでのHBMメモリーチップとしては世界最高容量であり、同社は、前世代のHBMメモリーチップよりも容量と性能が50%向上しているとしている。

Samsungによると、同社のHBM3E 12Hチップは、最大1,280GB/秒の帯域幅と最大36GBの容量を提供する。これは、8スタックの現行世代のHBM3 8Hチップよりも50%高い。

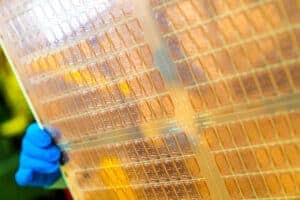

このチップは先進の熱圧着非導電性フィルム(TC NCF)を使用しており、12層の製品で8層のHBMチップと同じ高さを実現している。これにより、互換性が容易になり、システム構築者の柔軟性が向上します。また、ダイの薄型化に伴うチップのダイラッピングを緩和するなどの利点もあります。

Samsungによれば、HBM3Eチップのチップ間ギャップは業界最小の7µmとのことだ。これにより、チップ内部のレイヤー間のボイドがなくなり、8レイヤーのHBM3チップと比較して垂直密度が20%向上している。

Samsungの新しいTC NCF技術は、チップ間にさまざまな大きさのバンプを使用することで、HBMチップ内部の熱を改善する。小さいバンプは信号伝達のための領域に使用され、大きいバンプは放熱が必要な場所に使用される。Samsungによれば、この方法によって製品の歩留まりも向上するようだ。これらのチップは、より大容量のメモリーを必要とするシステムに使用できる。

新たなHBM3Eチップによって、これを利用する企業はより高い性能と容量を得ることができ、データセンターの総所有コストを削減することができる。AIアプリケーションに使用した場合、AIトレーニングの平均速度は34%向上し、サービスの同時使用は11.5倍に増加する。

Samsungによれば、HBM3E 12Hチップのサンプルを顧客に送り始めており、量産は今年前半に開始される予定だという。

Samsungのメモリ製品企画担当エグゼクティブ・バイス・プレジデントであるYongcheol Bae氏は、「業界のAIサービス・プロバイダーは、より大容量のHBMをますます必要としており、当社の新製品HBM3E 12Hは、そのニーズに応えるために設計されました。この新しいメモリー・ソリューションは、ハイスタックHBMのコア技術を開発し、AI時代の大容量HBM市場に技術的リーダーシップを提供することを目指す当社のドライブの一部を形成するものです」と、述べている。

Sources

コメントを残す