OpenAIのGPT-4や、Googleが昨日発表したPaLM 2のような大規模言語モデル(LLM)は、その動作に謎が多く、ブラックボックスだと言われている。研究者達も、LLMがなぜそのような反応をするのかを完全には理解しておらず、それは時に、AIが新たな知能であり、人間にとって未知の存在に近付いていることを喧伝するためにも利用されているが、OpenAIはこのブラックボックスに光を当てようとしている。大規模言語モデルのどの部分がどの動作に関与しているのかを明らかにし、ニューラルネットワークの動作を説明しようとするAIの分野である「解釈可能性」の進展に寄与する新たなツールを、論文と共に公開した。このツールでは、「LLMによってLLM自身を説明させる」ことで、ニューラルネットワークの動作を明らかにしようとしている。

GPT-4にGPT-2の挙動を説明させた

このツールを開発したエンジニアは、初期段階であることを強調しているが、このツールを実行するためのコードは、GitHubにオープンソースとして公開されている。

OpenAIのブラックボックスの中を覗き見する試みとして、OpenAIの研究者は、GPT-4言語モデルを利用して、旧世代であまり複雑ではないGPT-2言語モデルのニューラルネットワークの動作に対する自然言語の説明を生成し評価した。理想的には、解釈可能なAIモデルを持つことは、AIシステムが意図した通りに動作し、人間の価値観を反映することを保証する「AIアライメント」と呼ばれる広い目標に貢献することになる。また、解釈プロセスを自動化することで、OpenAIは、数十億のパラメータを持つ大規模なニューラルネットワークではスケーラブルでない、従来の手動による人間検査の限界を克服しようとしている。

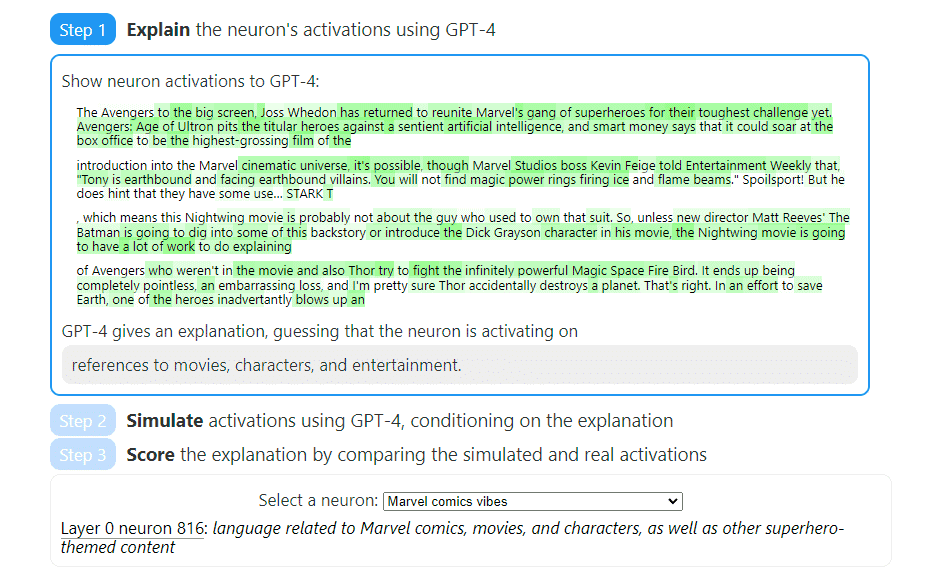

OpenAIの手法は、”テキストのどのようなパターンがニューロンを活性化させるかを説明しようとするもの“だ。その手法は3つのステップで構成されている:

- GPT-4を用いてニューロンの活性化を説明する。

- GPT-4を使ってニューロンの活性化動作をシミュレートする。

- シミュレーションした活性化と実際の活性化を比較する。

OpenAIの手法を理解するためには、ニューロン、回路、アテンションヘッドといういくつかの用語を知っておく必要がある。ニューラルネットワークにおいて、ニューロンは、情報を取り込み、処理し、出力を出す小さな意思決定ユニットのようなもので、ちょうど小さな脳細胞が受け取った信号に基づいて意思決定を行うようなものだ。ニューラルネットワークの回路は、相互に接続されたニューロンのネットワークのようなもので、情報を伝達し、集団で意思決定を行う。これは、ある問題を解決するために協力し、コミュニケーションをとる人々の集団に似ている。また、アテンションヘッドは、言語モデルが特定の単語や文の一部に注意を払うのを助けるスポットライトのようなもので、テキストを処理しながら重要な情報をよりよく理解し、捉えることができるようにするものだ。

GPT-4は、モデル内で解釈が必要な特定のニューロンやアテンションヘッドを特定することで、これらのコンポーネントの機能や役割について、人間が読めるような説明を作成する。また、OpenAIが 「自然言語を用いてニューロンの活性化を圧縮・再構築する言語モデルの能力の指標」と呼ぶ「説明スコア」も生成される。研究者らは、このスコアリングシステムの定量的な性質により、ニューラルネットワークの計算を人間に理解できるようにするための測定可能な進歩が可能になることを期待している。

結果は芳しいものではないが、道筋は見えた

とはいえ、まだ未完成でもあり、今のところ、実際の成果はそれほどでもない。テスト中、OpenAIはその技術を、同様の評価を手作業で行う人間の請負業者と比較したところ、GPT-4も人間の請負業者も「絶対的にスコアが悪い」、つまりニューロンの解釈が難しいことが分かった。

この失敗についてOpenAIが提示した説明の1つは、ニューロンが「多義的」である可能性があるというもので、これは研究の文脈における典型的なニューロンが複数の意味を示し、複数の概念と関連している可能性があることを意味する。OpenAIの研究者は、限界に関するセクションで、多義的なニューロンと、「異質な特徴」の両方を、自分たちの手法の限界として論じている:

さらに、言語モデルは、人間が言葉を持たない異質な概念を表現することもあります。これは、言語モデルが異なるもの、例えばネクストトークン予測タスクに有用な統計的構成要素に関心を持つため、あるいは、モデルが人間がまだ発見していない自然な抽象化、例えば、異なるドメインにおける類似概念のファミリーを発見したために起こり得る。

その他の制限としては、計算量が多いこと、短い自然言語による説明しか提供できないことなどがある。しかし、OpenAIの研究者は、機械による解釈可能性と、将来的に技術を向上させることで解釈可能性の向上を測定する定量的な手段の両方を実現する枠組みができたと楽観視している。AIモデルがより高度になるにつれて、生成される説明の質が向上し、複雑なシステムの内部構造をより深く理解できるようになることを、OpenAIの研究者は期待している。

OpenAIは、研究論文をインタラクティブなWebサイトで公開している。このWebサイトには、各ステップの分解例が掲載されており、テキストのハイライト部分と、それが特定のニューロンにどのように対応しているかが示されている。さらにOpenAIは、「自動解釈可能性」コードとGPT-2 XLニューロンと説明のデータセットをGitHubで提供している。

もし、ChatGPTがデタラメを吐き出す理由を正確に解明することができれば、大規模言語モデルの最大の問題の1つが解決する可能性があるだろう。

Source

コメントを残す