OpenAIは、長らく噂されいてた同社の次世代大規模言語モデル「GPT-4」をついにリリースした。

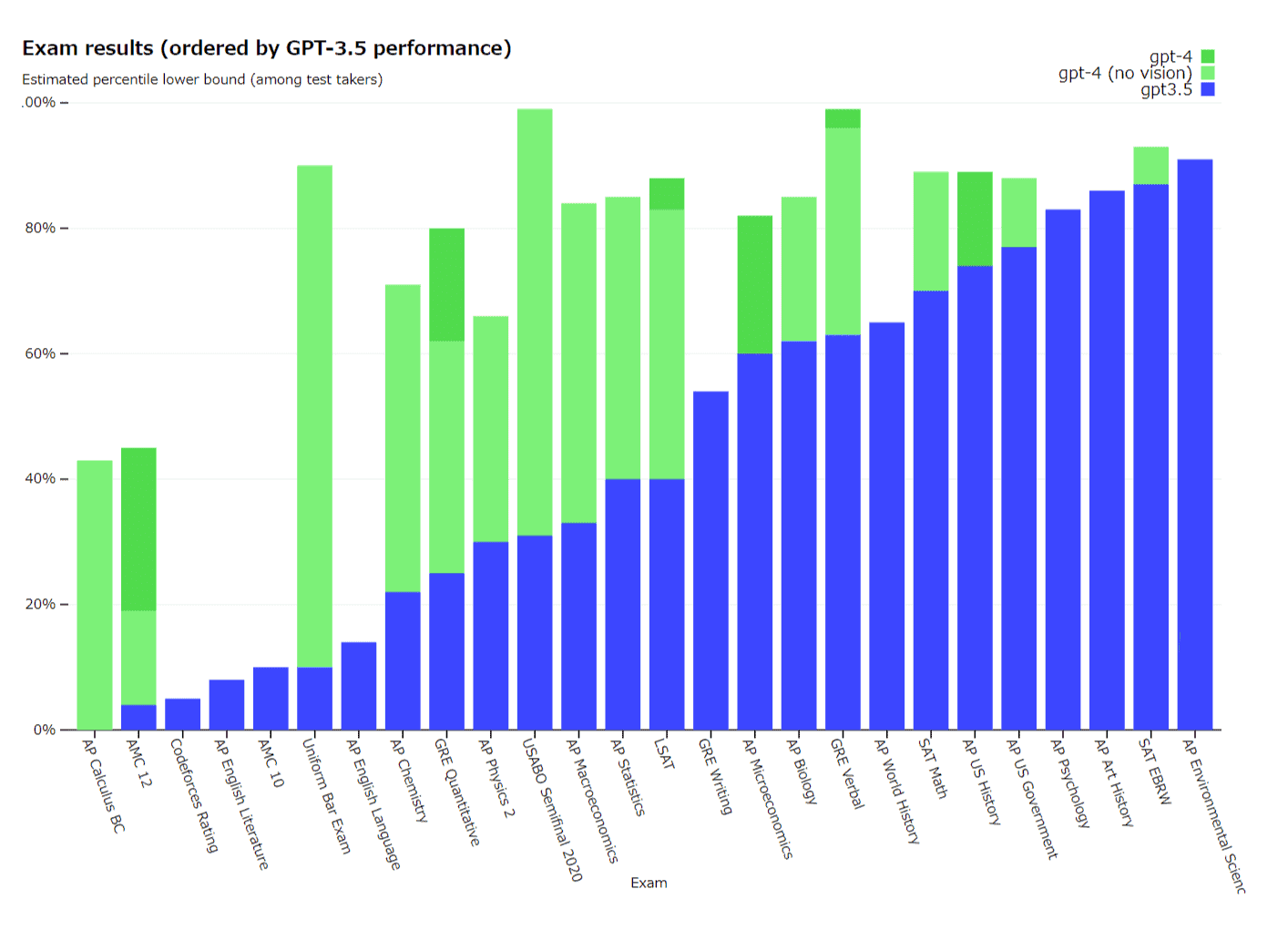

GPT-4は、多くの専門的なテストで「人間レベルの性能」を示すものとなっており、以前のモデルより、より創造的であり、幻覚(情報をでっち上げる傾向)が少なく、司法試験に合格し、いくつかのAP試験で5点(満点)を取ることが出来る性能を備えているという。また、GPT-4は、大規模なマルチモーダルモデルであり、テキストや画像の入力を受け付けることで、テキストによる返答を返す事が出来る様になっている。画像を入力することで、その画像のどこがおかしいのか判断することも可能と言うことだ。

OpenAIによると、すでにDuolingo、Stripe、Khan Academyなど多くの提携した企業が、既にGPT-4を自社製品に組み込んでいるという。また、GPT-4は、OpenAIの月額20ドルのChatGPTサブスクリプションであるChatGPT Plusを通じて一般に提供され、既にMicrosoftのBingチャットボットに搭載されているとのことだ。

さらに、開発者が構築するためのAPIとしてもアクセスできるようになる予定だという。(OpenAIの発表によると、今日からウェイティングリストを公開するとのこと)。価格は、「プロンプト」トークン1,000個(約750語)あたり0.03ドル、「コンプリート」トークン1,000個(やはり約750語)あたり0.06ドルとなる。トークンは生のテキストを表す。例えば、”fantastic”という単語は、”fan”, “tas”, “tic”というトークンに分割される。プロンプトトークンはGPT-4に入力される単語の部分であり、コンプリーショントークンはGPT-4が生成するコンテンツである。

マルチモーダルモデルとなった「GPT-4」

GPT-4は、画像とテキストの入力を受け付けることができ、テキストしか受け付けなかった前身のGPT-3.5から大きな進化が見られる。さらに性能も改善し、様々な専門的・学術的ベンチマークで「人間レベル」の性能を発揮している。例えば、司法試験の模擬試験では、GPT-4は受験者の上位10%程度のスコアで合格、一方、GPT-3.5は下位10%程度のスコアだったとのことだ。

また、GPT-4では最大32,768トークン(約25,000語のテキスト)の生成・処理に対応しており、従来機よりもはるかに長いコンテンツの作成や文書解析が可能だという。

OpenAIは、社内の敵対的テストプログラムおよびChatGPTの教訓を用いてGPT-4を6ヶ月かけて「反復調整」した結果、事実性、操縦性、ガードレールから外れることの拒否について「過去最高の結果」を出したという。GPT-4は、これまでのGPTモデルと同様、一般公開されているWebページのデータや、OpenAIがライセンス供与したデータなどを用いて学習させている。

これに関しては、OpenAIはMicrosoftと共同で、Azureクラウド上に「スーパーコンピューター」を一から開発し、GPT-4の訓練に使用したとのことだ。

「カジュアルな会話では、GPT-3.5とGPT-4の区別は微妙なことがあります。タスクの複雑さが十分な閾値に達したときに違いが出てきます。GPT-4はGPT-3.5よりも信頼性が高く、創造的で、はるかにニュアンスのある指示を扱うことができるのです」と、OpenAIはプレスリリースで述べている。

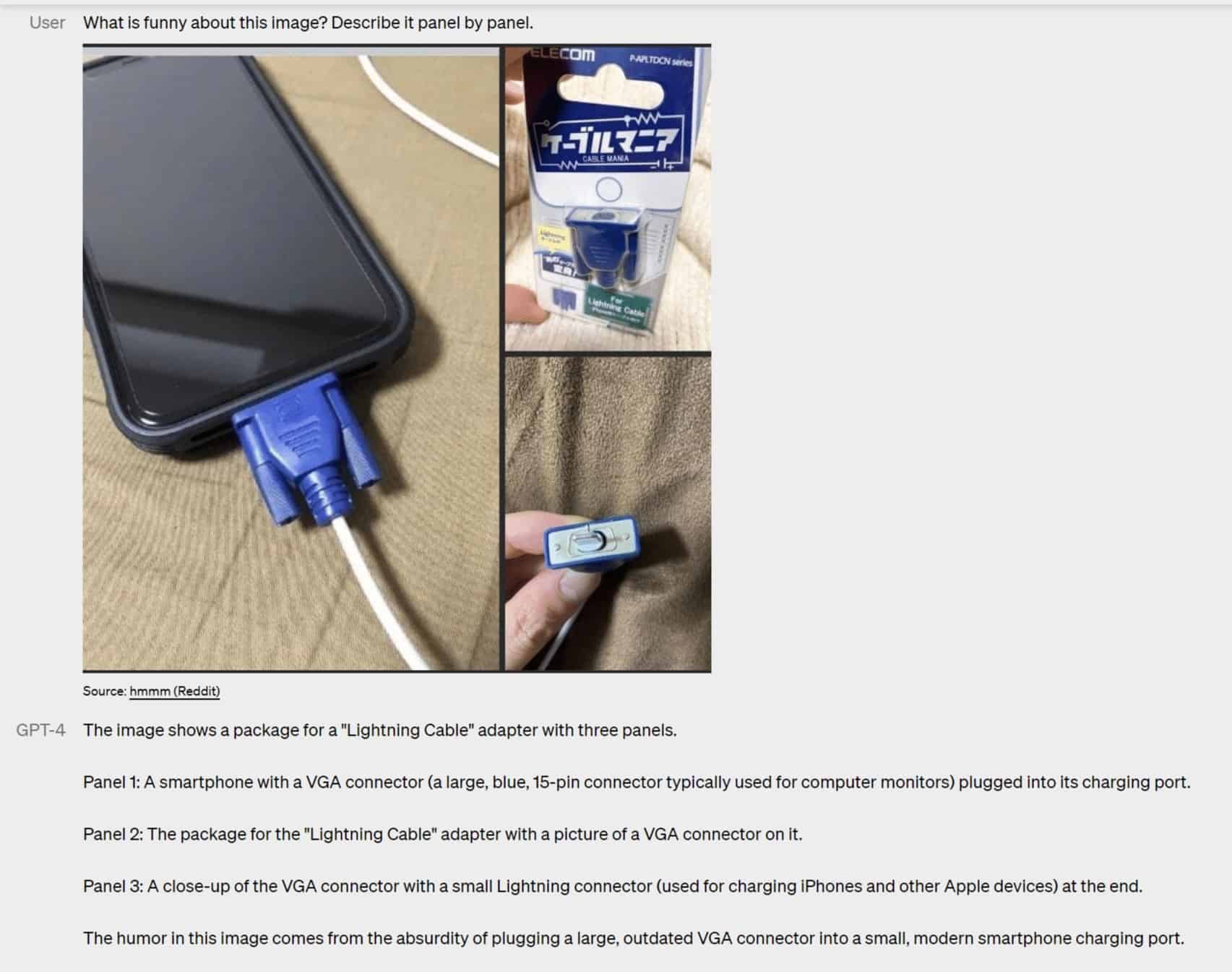

加えて、GPT-4は画像入力を受け付け、理解できるマルチモーダルモデルとなっている点も大きな進化だろう。例えば、iPhoneを接続した写真からLightningケーブルアダプターを識別するなど、比較的複雑な画像にもキャプションを付け、解釈することができる。さらに、Redditに投稿されたジョーク画像から、この画像のどこがおかしいのかを判断して指摘することも出来ると言う。

この画像理解機能は、まだすべてのOpenAIの顧客が利用できるわけではなく、OpenAIはまず1つのパートナーであるBe My Eyesとテストを行っている。GPT-4を搭載したBe My Eyesの新しいバーチャルボランティア機能は、送られてきた画像に関する質問に答えることが出来ると言う。同社はブログ記事でその仕組みを説明している。

「例えば、ユーザーが冷蔵庫の中の写真を送ると、Virtual Volunteerは、その中に何が入っているかを正しく認識するだけでなく、その食材を使って何が作れるかを推定・分析することができます。そして、そのツールはその食材を使ったレシピをいくつも提示し、作り方のステップバイステップを送ることもできるのです」

GPT-4では、OpenAIが新しいAPI機能として「システム」メッセージを導入し、開発者が特定の指示を記述することでスタイルやタスクを規定することを可能にする。システムメッセージは、将来的にChatGPTにも導入される予定だが、基本的には、AIが次に行うインタラクションのトーンを設定し、境界を確立するための指示だ。

例えば、システムメッセージには次のようなものがある。「あなたは、常にソクラテススタイルで対応する教師です。答えを教えるのではなく、生徒が自分で考える力を身につけるために、適切な質問をするように心がけます。生徒の興味や知識に合わせて質問を調整し、問題をより単純な部分に分解して、生徒にとってちょうどいいレベルになるようにする必要があります」

しかし、システムメッセージやその他のアップグレードがあっても、GPT-4は完璧とは言い難いことをOpenAIも、CEOのSam Altman氏も警告している。GPT-4はまだ事実を「でっちあげ」、時には自信満々に推論を誤ることがあります。

「GPT-4は一般的に、そのデータの大部分が途切れた後(2021年9月)に発生した事象についての知識が不足しており、その経験から学習しない。多くの領域にわたる能力と一致しないような単純な推論ミスをすることもあれば、ユーザーからの明らかな虚偽の発言を受け入れて過度に騙されることもあります。そして時には、生成したコードにセキュリティの脆弱性を持ち込むなど、人間と同じように難しい問題で失敗することもあります」

しかし、OpenAIは、GPT-4が危険な化学物質の合成方法に関する要求を拒否する可能性が低くなったなど、特定の分野で改善されたことを指摘している。同社によると、GPT-4はGPT-3.5と比較して、「許可されない」コンテンツに対するリクエストに応答する可能性が全体として82%低く、医療アドバイスや自傷行為に関するものなど、機密性の高いリクエストには29%多く、OpenAIのポリシーに従って応答するとのことだ。

Source

コメントを残す