「Microsoftは小規模言語モデル(SLM)が大好きだ」と、Ignite 2023でCEOのSatya Nadella氏が言っていたが、同社はOpenAIとの提携によってGPT-4などの大規模言語モデル(LLM)の利用を大々的に進めつつ、独自に言語モデルの研究も続けており、以前発表したSLM「Orca」[PDF]の第2バージョンである「Orca 2」をリリースした。

GPT-4のコストが高いため、Microsoftは、最近Phi-2で実証されたように、より効率的な生成AIモデルの研究を強化している。

Microsoftはブログの中で、Orca 2はより小さなLMでありながら、LLMのような複雑な質問にも答えられるように設計されていると述べている。Orca 2には2つのサイズ(70億と130億のパラメータ)があり、今年の初めにMetaと共に発表に協力したLlama 2を一部使用して作られたとのことだ。同社はLlama 2をベースとしたモデルを “カスタマイズされた高品質の合成データに基づいて”微調整したとしている。

研究チームは、小さなモデルが大きなモデルの出力を単純に再現する模倣学習に焦点を当てすぎると、その可能性が制限される可能性があると主張している。

その代わりに研究チームは、「Orca Method」を用いて、単にLLMの出力スタイルを模倣するのではなく、LLMの段階的な思考プロセスを用いてSLMを訓練する。これにより、モデルは各タスクに対して最も効果的な解決策を見つけることができる。

このような実験の目標は、大型AIモデルと同様の性能を持ちながら、より少ない計算能力で動作する小型AIモデルを開発することである。

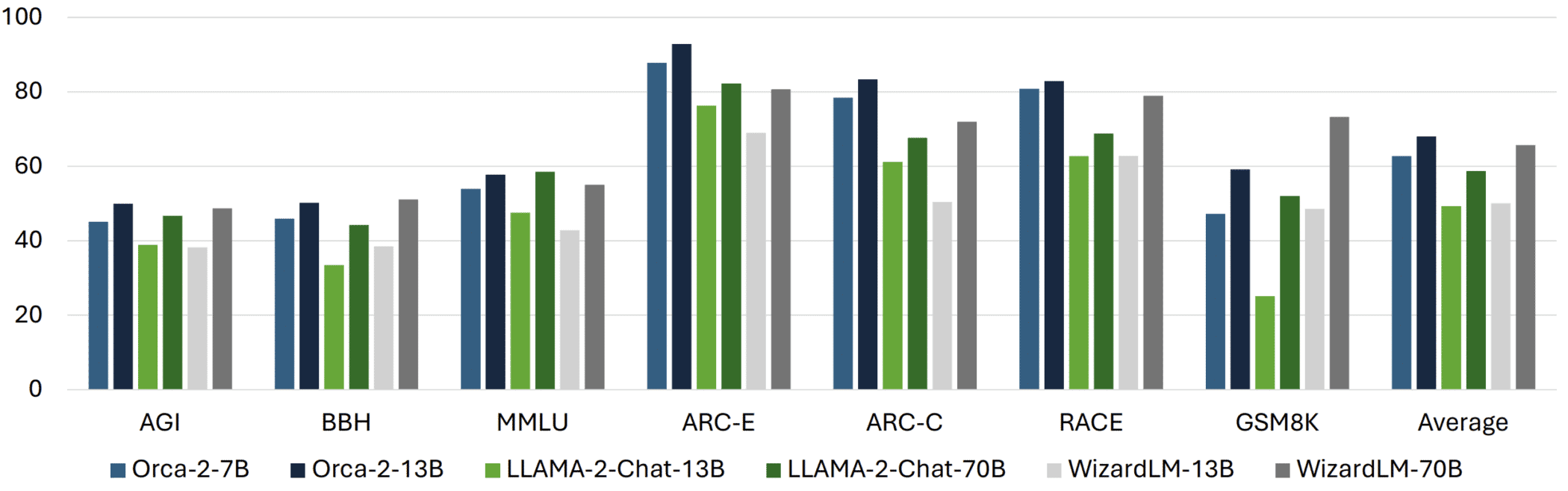

Microsoftは、これによってOrca 2モデルは、他の “5-10倍大きい”言語モデルの性能に匹敵する問題を扱うことができるようになったと述べている:

Orca 2は、拡張された高度に調整された合成データセットで学習されています。この学習データは、Orca 2に段階的処理、想起→生成、想起→理由→生成、抽出→生成、直接回答法などの様々な推論技法を教えると同時に、異なるタスクに対して異なる解答戦略を選択するように教えるように生成されました。

訓練データは、より強力な教師モデルから提供され、より小さなモデルが基礎となる生成戦略と推論スキルを学習するのを助ける。研究者はこのプロセスを “説明チューニング”と呼んでいる。

Orca 2の背後にある重要な洞察は、異なるタスクには異なる解法(例えば、ステップ・バイ・ステップ処理、想起→生成、想起→理由→生成、抽出→生成、直接回答など)が有効であり、大規模なモデルが採用する解法が小規模なモデルにとって最良の選択とは限らないということです。例えば、GPT-4のような非常に能力の高いモデルは複雑なタスクに直接答えることができますが、より小さなモデルはタスクをステップに分割することで利益を得ることができます。

一つの側面は、教師モデルの質がこのメソッドの有効性に不可欠であるということだ。彼らの実験では、現在市販されている中で最も強力なモデルであるChatGPT経由のGPT-4を使用した。

Microsoftは、Orca 2には限界があることを認めたが、これまでのテストは “将来の進歩の可能性”を示している。MicrosoftはOrca 2をオープンソースプロジェクトとして公開しており、他の人たちもそれに取り組むことができる。

Source

- Microsoft Research Blog: Orca 2: Teaching Small Language Models How to Reason

コメントを残す