ビッグデータ全盛の時代、データモデルは大きければ大きいほど必然的に精度が高いと一般的に考えられているが、MicrosoftはMicrosoft Research Forum イベントで、「Layer-Selective Rank Reduction (LASER)」と呼ばれるアプローチを発表し、大規模言語モデル (LLM) の精度を損なうことなく、広範なデータセットを巧みにトリミングする方法を明らかにした。

Microsoft Research Forumで、Microsoft Research Lab NYCとAI FrontiersのシニアリサーチャーであるDipendra Misra氏は、LASERが大規模言語モデルをより正確にする方法について説明した。

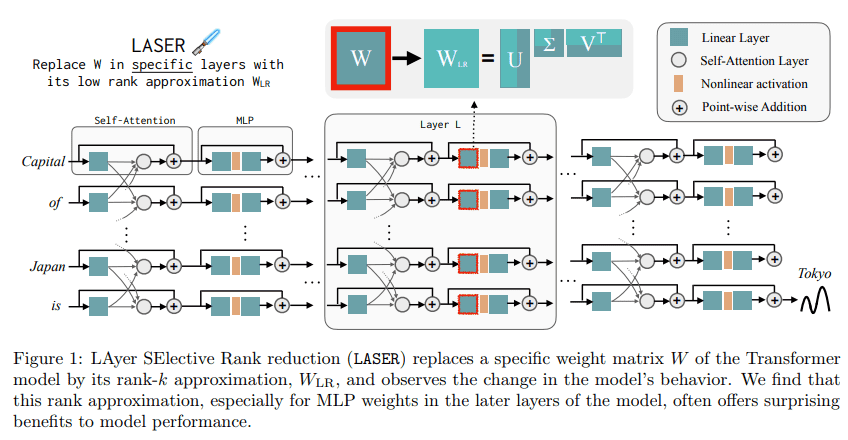

LASERは、マサチューセッツ工科大学(MIT)とMicrosoft Researchの研究者らが共同開発したアプローチだ。これは、重み行列の高次成分を選択的に削減対象とすることで、LLMの最適化に革命をもたらす可能性がある。モデル全体のパラメータを一律に削減する従来の手法とは異なり、LASERはTransformerモデル内の特定の層に焦点を当て、特に多層パーセプトロン(MLP)と注意層をターゲットとしている。この、より微妙なアプローチにより、冗長性を排除しつつ、本質的な構成要素を保持することができる。

LASERの背後にある方法論は、特異値分解の原理に基づいている。この数学的技法は、重み行列の高次成分を特定し、その後削減する。MLPと注意層内の特定の行列に集中することで、LASERは最も関連性が高く必要な成分のみが保持されるようにする。このように対象を絞った削減を行うことで、より洗練されたモデルの改良が可能になり、全体的な効率を高めながら中核となる機能を維持することが可能となる

LASERを実装することで、Microsoft Research Lab NYCのチームはデータサイエンスコミュニティを驚かせ、モデルの精度がデータ削減の影響を受けないだけでなく、多くの場合、大幅に改善されることを明らかにした。

「我々は、LLM上でLASERを使った介入を行っているので、近似を行うほどモデルの損失が増えるはずだと予想されます。しかし、驚いたことに、適切なタイプのLASER介入を行えば、モデル損失は増加せず、むしろ減少することがわかりました」と、Misra氏は述べている。

このテクノロジーは、RoBERTa、Llama 2、EleutherのGPT-Jを含むいくつかのオープンソースモデルでテストされ、いくつかのトライアルでは、LASER適用後のパフォーマンス精度が70.9%から97.5%へと飛躍的に向上しました。これは大幅な強化であり、AI性能を決定的に向上させる技術の可能性を強調している。

LASERはLLMの最適化における重要な進歩である。計算負荷を増やすことなく、重み行列の成分を選択的に削減することで、モデルの効率を向上させることができる。この技術は、馴染みのあるタスクにおけるLLMの性能を向上させるだけでなく、頻度が低くニュアンスの異なるデータの処理と理解におけるLLMの能力を拡張するものだ。LASERは、より洗練された効率的な言語モデルへの道を開く可能性を示す、注目すべき成果と言える。

論文

- Microsoft Research: The Truth is in There: Improving Reasoning in Language Models with Layer-Selective Rank Reduction

参考文献

- Microsoft Research: Improving Reasoning in Language Models with LASER: Layer-Selective Rank Reduction

- via The Verge: Microsoft LASERs away LLM inaccuracies

研究の要旨

Transformerベースの大規模言語モデル(LLM)は、現代の機械学習においてすっかり定着した。それに応じて、この技術をさらに発展させることを目的とした研究に多大なリソースが割かれており、通常、増大するデータ量に対して学習される、増大するサイズのモデルが生み出されている。しかし本研究では、重み行列の高次成分を選択的に除去することで、LLMの性能を大幅に向上させることが可能であるという驚くべき結果を示す。この単純な介入は、LAyer-Selective Rank reduction (LASER)と呼ばれ、学習終了後にモデルに対して行うことができ、追加のパラメータやデータを必要としない。また、LASERがどのような場合に有効で、どのようなメカニズムで機能するのかについて、詳細な分析を行う。

コメントを残す