この数ヶ月、大規模言語モデル(LLM)の話題を聞かない日はない程だ。世界を大きく変えると言われるChatGPTの登場から、最新のGPT-4の登場、そしてより大きく、より優れたリソースの探求は終わりを告げていない。そこで、ここではこれまでに登場したオープンソースのLLMを一挙に紹介しよう。

Dolly & Dolly 2.0

Databricksは、Dollyのリリースから数週間で、APIアクセスや第三者とのデータ共有に支払いを必要としない商用利用可能なモデル、Dolly 2.0を発表した。このモデルは、これまでChatGPTの出力でトレーニングされていた大規模な言語モデルをめぐる法的な曖昧さを解決する可能性があるものである。

BLOOM

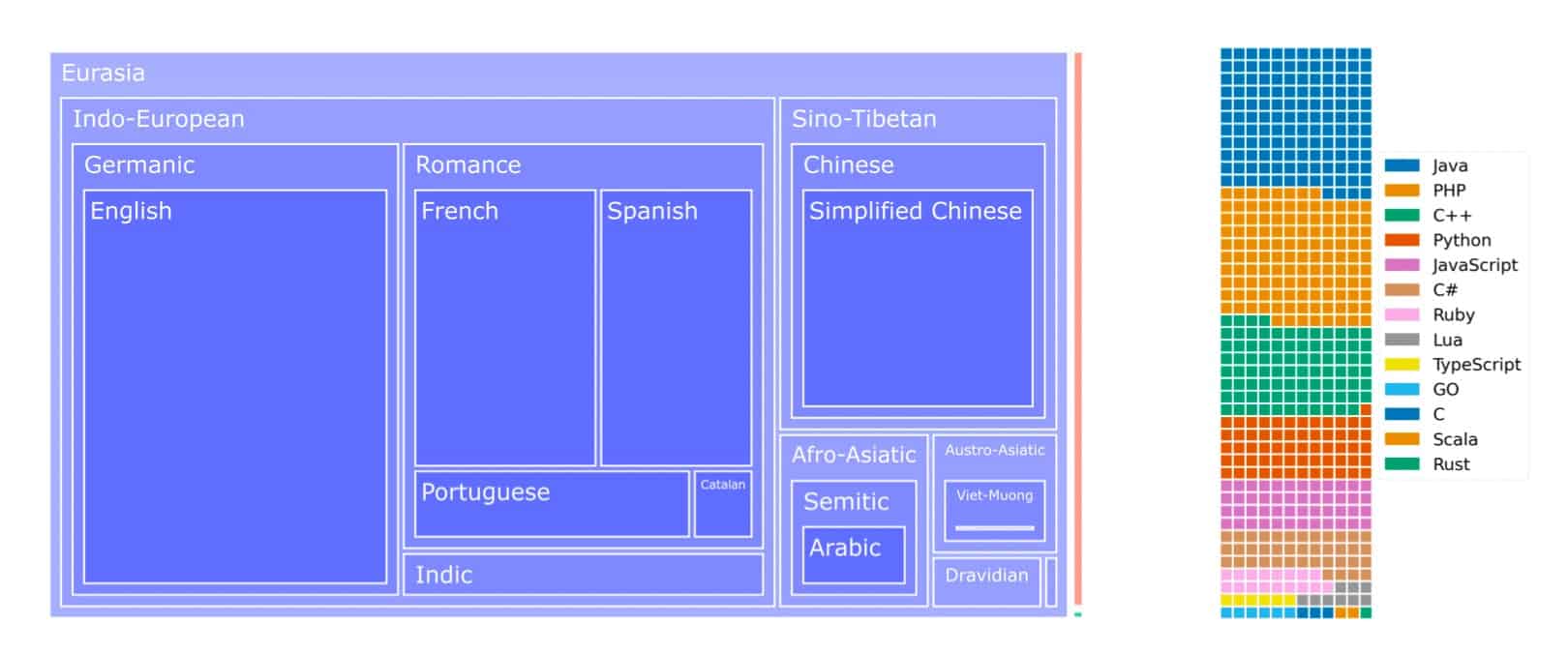

Hugging Faceがリリースしたのは、世界最大のオープンソース大規模言語モデル「BLOOM」だ。 世界中から集まった1,000人の優秀な頭脳の共同作業により、BigScienceはBLOOMを誕生させた。

GLM-130B

このモデルは、様々なベンチマークでGPT-3や中国語最大のモデルを印象的に上回り、まさにゲームチェンジャーと言えるだろう。しかし、それだけではなく、手頃な価格のGPUで効率的な推論を可能にする独自のスケーリング特性も誇っている。さらに素晴らしいのはモデルの重み、コード、トレーニングログが全て公開されていることだ。

GPT-Neo, GPT-NeoX & GPT-J

自然言語処理(NLP)の領域では、GPT-Neo、GPT-J、GPT-NeoXの各モデルが相次いで登場し、強力なツールを提供する。

EleutherAIは、OpenAIが鍵をかけて管理していたGPT-3をオープンソースとして公開し、これらのモデルを作成した。GPT-JとGPT-Neoは、様々なドメインにまたがる言語データのコレクションである強大なPileデータセットで学習され、様々な自然言語処理タスクに汎用的に適応できるようになっている。

GPT-NeoXは、Megatron-LMとMetaのDeepSeedを土台に、GPUの利用で輝くためのモデルだ。200億もの膨大なパラメータを持つこのモデルは、公開されているモデルの中では最大規模となる。GPT-NeoXは、少数精鋭学習の限界をさらに押し広げる概念実証だ。

GPT-2

GPT-2は、偽情報、スパム、フェイクニュースを拡散する可能性があるとの懸念から、当初9ヶ月間公開を控えていたが、OpenAIはテスト目的で、より小さく複雑でないバージョンを公開した。OpenAIは、「悪用された強い証拠はない」と報告し、その結果、GPT-2のフルモデルを使用できるようにしている。

PaLM

Google AIは、パラメータ数の多寡が注目を集めるLLMレースにおいて、この「大きければ大きいほど良い」という仮定に異を唱えるものだ。この研究では、より大きな言語モデルの方が、過去のタスクからより効果的に学習できるため、より効果的であることを発見した。これに基づいてGoogleが作ったPaLM(Pathways Language Model)は、5,400億のパラメータを持つ、デコーダのみのTransformerモデルとなる。

OPT

Metaは2022年5月にOPT(Open Pre-trained Transformer)モデルをリリースし、大きな話題を呼んだ。1億2,500万から1,750億という膨大なパラメータを持つこれらのTransformerは、前例のない規模で言語タスクを処理することが出来ると言う。

小さなバリエーションはGithubからダウンロード出来るが、最大のバリエーションはリクエストに応じなければアクセス出来ない。

CerebrasGPT

AIインフラをベースとするCerebras社は、オープンソースのGPTモデル7種類をリリースするという大胆な行動を起こした。これらのモデルは、ウェイトやトレーニングレシピを含め、Apache 2.0ライセンスのもと無料で公開されており、現在の閉鎖的な業界の独自システムに挑戦している。

Flan-T5

Google AIは、1,800以上の多様なタスクに取り組むことができるオープンソースの言語モデル – Flan-T5を発表した。研究者は、Flan-T5モデルの高度なプロンプティングとマルチステップ推論機能により、大幅な改善が期待できると主張している。

LLama

Metaは2023年2月末にLLaMAを発表した。LLaMAは、対応するOpenAIのChatGPTやMicrosoftのBingとは異なり、一般には公開されず、Metaがオープンソースのパッケージとして公開し、AIコミュニティがアクセスを要求できるようにした。

しかし、MetaがLLaMAへのアクセス要求を受け付け始めてからわずか1週間後、このモデルがネット上に流出し、技術コミュニティに衝撃が走った。

Alpaca

スタンフォード大学からは、Alpacaが登場している。このモデルは、GPT 3.5の指示に従って、5万回以上のデモを行ったLLaMA 7Bを微調整して作られたものです。何百万ドルもかかるトレーニングやテストを、わずか600ドルで済ませることが出来たとのことだ。

リリース以来、Alpacaは画期的なモデルとして評価されている。当初はHomer Simpsonのボットからスタートしましたが、すぐにその汎用性の高さを証明した。

コメントを残す