スタンフォード大学のCenter for Research on Foundation Models(CRFM)は、OpenAIのGPT APIを使ってMetaの大規模言語モデル「LLaMA」の7Bモデルに「微調整」を行った、「Alpaca 7B」をオープンソースで公開した。

このAlpaca 7Bは、OpenAIの“text-davinci-003(GPT-3.5)”、いわゆるChatGPTと類似した多くの行動を示す事が出来、遥かに軽量で安価な環境で実行可能であるという。

Webデモはこちらのサイトで試す事が可能だ。

LLaMAとは、Meta AI Researchが開発した基礎的な大規模言語モデル(LLM)であり、AI分野の研究を促進することを目的として開発されたものだ。LLaMAは、パラメータ数が少なくても高い性能を発揮することが特徴で、70億から650億までの4種類のバリエーションがある。例えば、パラメータ数130億のLLaMA 13Bは、パラメータ数1,750億のGPT-3と同等のベンチマークスコアを達成している 。LLaMAは、20種類の言語に対応し、テキスト生成や質問応答など様々なタスクに適用出来る。Metaはオープンサイエンスに貢献するために、LLaMAのコードやモデルカードを公開しており 、他の研究者が容易に利用できるようにしている。

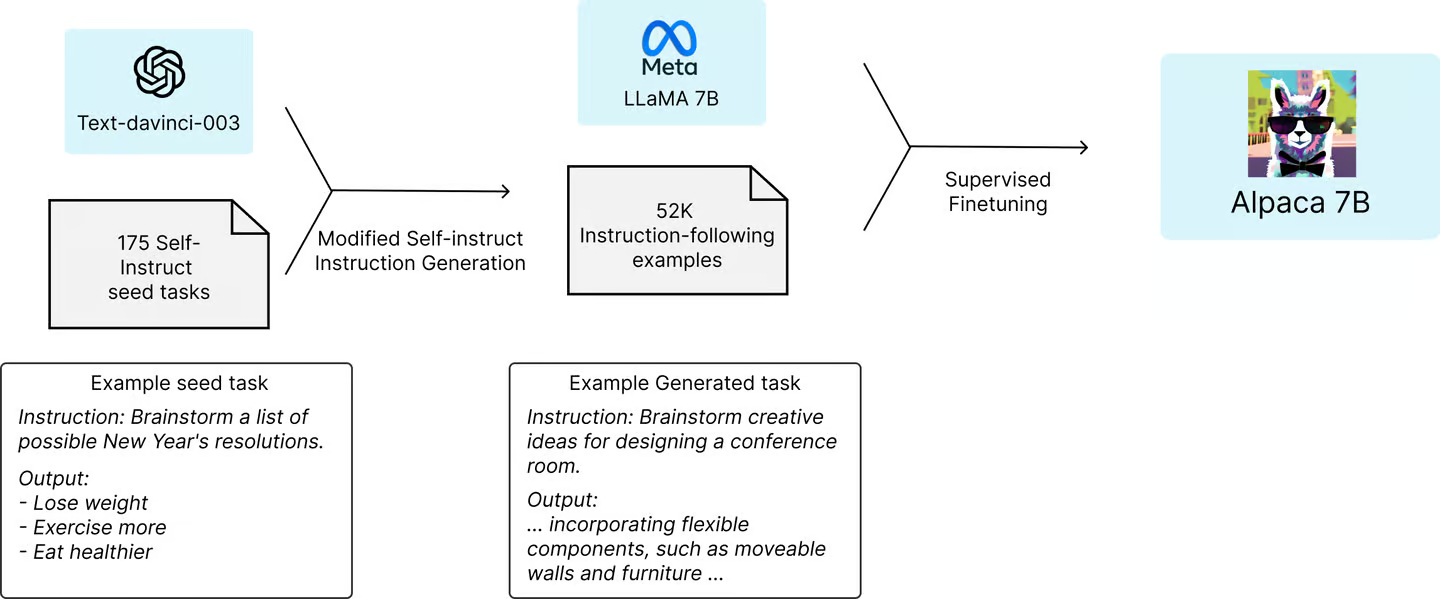

研究チームは、このオープンソース化されているLLaMAの70億パラメータのモデル「LLaMA 7B」からスタートした。LLaMA 7Bは、1兆個の「トークン」で事前学習したもので、LLaMAモデルの中では最も小さな言語モデルとなる。LLaMA 7Bはある程度の能力を備えているが、ほとんどのタスクでChatGPTに大きく遅れをとっていた。GPTモデルのコスト、そして競争力の源泉は、OpenAIがポストトレーニングにかけた膨大な時間と労力によるものだ。

そこで、LLaMA 7Bモデルを稼働させた後、研究チームはGPTに、人間が書いた175の命令と出力のペアを、一度に20ずつ、同じスタイルとフォーマットで生成し始めるよう依頼した。これはOpenAIが提供するAPIを利用して自動化され、短期間でLLaMAモデルのポストトレーニングに使用する約52,000のサンプル会話を得ることが出来た。この大量の学習データの作成にかかった費用は、500ドル(65,000円)以下で済んだとのことだ。

そして、そのデータを使ってLLaMAモデルの微調整を行った。この作業は、80GBのA100クラウドプロセッサー8台で約3時間かかった。これには100ドル(13,000円)もかかっていないのだ。

一般的に、LLMのトレーニングには高いコストがかかる。例えば、15億パラメーターのテキスト生成モデルの開発費用は160万ドル(約1億8000万円)、GPT-3(1750億パラメーター)の開発費用は1200万ドル(約13億6000万円)と見積もられている 。また、学習済みのモデルを実際に動かす推論コストも高く、GPT-3を1台のAWSインスタンスで動かす場合は年間87,000ドル(約990万円)がかかると見積もられている。これに比較すると、如何に安価に済ませることが出来たかが分かるだろう。

AlpacaをChatGPTの言語モデルと比較し、メール作成、ソーシャルメディア、生産性向上ツールなどでテストしたところ、Alpacaは90勝、GPTは89勝をあげましたとのことだった。スタンフォード大学の研究者は、自分たちのモデルとOpenAIのモデルが「モデルサイズが小さく、命令追従のデータ量も少ないことから、この結果には非常に驚きました」と、述べている。

さらにチームは、プロセスの最適化を図れば、おそらくもっと安くできただろうと述べている。また、AIを再現しようとする人は、より高性能なGPT 4.0や、より強力なLLaMAモデルを利用できるようになったので、52,000問で終わらせる必要もないとのことだ。

Stanford CRFMの研究チームは、今回の研究で使用した52,000問の質問と、それを生成するためのコード、LLaMAモデルの微調整に使用したコードをGithubで公開した。研究チームは、「Alpacaモデルが安全で無害であるような微調整はまだ行っていない」とし、設置した人は安全性や倫理的な問題について報告するよう求めている。

しかし、Alpacaは、Stanford CRFMが指摘するように、「幻覚、毒性、ステレオタイプなど、言語モデルに共通するいくつかの欠点」を抱えており、特に幻覚は、OpenAIのtextdavinci-003と比較する、より顕著であるとの事だ。

また、これとは別にRaspberry Piで実行できるコードが別のグループからGithubに公開されており、ハイエンドのNVIDIA RTX 4090グラフィックカード1枚で5時間以内にトレーニングプロセスを完了させた例も報告されている。

これは、これまで莫大な費用が必要であると考えられていた大規模言語モデルの構築が、知識さえあれば少額でセットアップできるようになったということだ。無制限の数の制御不能な言語モデルがこれから更に登場してくることが予想される。そして、その素晴らしい性能が、フィッシング詐欺、スパム業者、その他多くの犯罪に利用される可能性も出てくるということだ。

Source

- Stanford University: Alpaca: A Strong, Replicable Instruction-Following Model

- via New Atlas: The genie escapes: Stanford copies the ChatGPT AI for less than $600

コメントを残す