OpenAIのGPT-4の登場で、マルチモーダルシステムが注目される中、Googleの研究者は、異なる環境で異なるタスクを行う方法を学習できる「UniPi」という新しいモデルを作成した。Googleは、ブログ投稿の中で、テキストガイドを使用して異なるタスクを実行するモデルの能力について説明している。

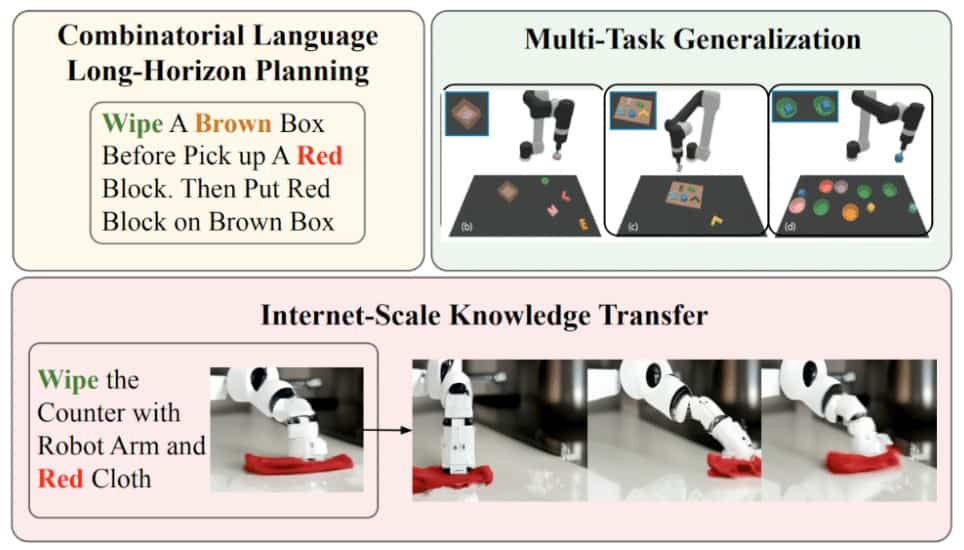

この普遍的なポリシー(UniPi)は、環境の多様性と報酬仕様の課題を解決する。これは、テキスト入力を用いて、異なる環境で異なるタスクを行うロボットを誘導するために重要となるだろう。

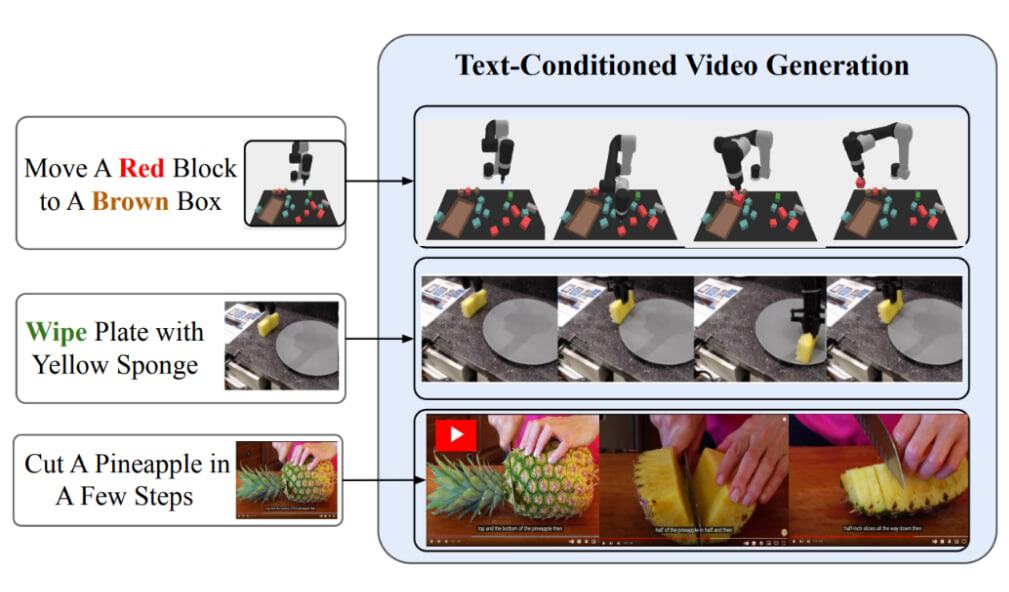

そのため、このポリシーでは、タスクを説明するテキストと、タスクを完了する方法を示すビデオを活用する。UniPiは特別なプログラムを使って、エージェントがタスクを完了するために取るべきステップを示すビデオを生成する。次に、UniPiは別のプログラムを使って、そのステップを実現するために必要なアクションを導き出す。そして、UniPiはそのアクションを使って、現実世界やシミュレーションの中でタスクを完了させることができるのだ。

研究者によると、UniPiは、見たことのある言語プロンプトと新しい言語プロンプトの組み合わせの両方で汎化することが出来るとのことだ。UniPiは、エージェントが実世界のさまざまな環境で、さまざまなタスクをこなす方法を学ぶのを助けることができるだろう。

研究者は、非ロボットデータで事前学習した後、UniPiによって生成されたビデオの品質を、Fréchet Inception Distance(FID)とFréchet Video Distance(FVD)メトリクスを用いて評価した。また、言語-画像のアライメントをContrastive Language-Image Pre-training scores (CLIPScores)を用いて測定しました。その結果、事前トレーニングを行ったUniPiは、事前トレーニングを行わないUniPiに比べて、FIDとFVDのスコアが有意に良く、CLIPScoreが高いことが分かった。これらの結果は、ロボット以外のデータに対する事前訓練が、ロボットの計画生成を支援することを示唆している。

Source

コメントを残す