Appleの研究者らは、ユーザーが写真編集ソフトに触れることなく、写真のどこを変更したいかを説明するだけで写真の編集ができる新しいオープンソースのAIモデル「MGIE」を発表した。

Appleがカリフォルニア大学サンタバーバラ校と共同開発したMGIEモデルは、「Multimodal Large Language Models Guided Image Editing」の略で、画像の切り抜き、サイズ変更、反転、フィルターの追加などをすべて自然言語命令を使って、テキストプロンプトで行うことができる。

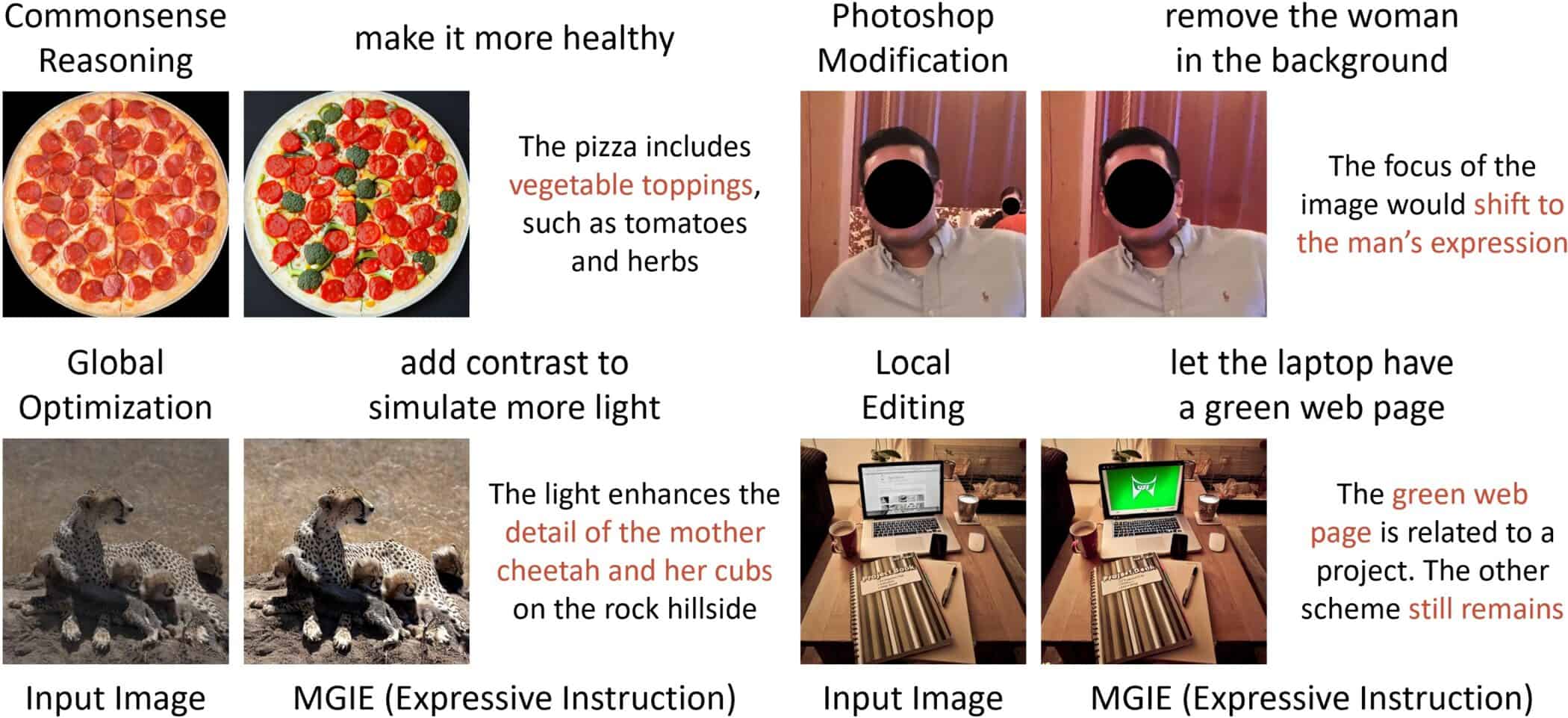

MGIEで写真を編集する場合、ユーザーは写真のどこを変更したいかを入力するだけで良い。論文では、ペパロニ・ピザの画像を編集する例を挙げている。「もっとヘルシーに」と入力すると、野菜のトッピングが追加される。サハラ砂漠のトラの写真は暗く見えるが、「もっとコントラストを強くして光をシミュレートして」と指示すると、明るく見せてくれる。

MGIE は、MLLM(Multimodal Large Language Models)を用いてユーザコマンドを解釈し、ピクセ ル精度の画像操作を実行する。MLLMはテキストと画像の両方を処理することができるが、その性能については、GPT-4Vを使用して画像を理解し、DALL-E 3を使用して新しい画像を生成するChatGPTのようなアプリケーションで既に実証されている。

MGIEはこれらの機能を活用し、単純な色調整から複雑なオブジェクト操作まで、包括的な画像処理タスクを初めて可能にした。

「簡潔だが曖昧なガイダンスの代わりに、MGIEは視覚を意識した明示的な意図を導き出し、合理的な画像編集を導く。我々は、様々な編集の側面から広範な研究を行い、我々のMGIEが競争効率を維持しながらパフォーマンスを効果的に向上させることを実証した。また、MLLMガイドフレームワークは、将来の視覚と言語の研究に貢献できると考えています」と、研究者らは論文で述べている。

グローバル操作とローカル操作

MGIEのもう一つの特徴は、グローバル操作とローカル操作を実行できることだ。このモデルは、表現力豊かな命令ベースの編集を実行し、トリミング、拡大縮小、回転、ミラーリング、フィルターの追加など、Photoshopのような一般的な編集を適用できる。

また、背景の変更、オブジェクトの追加や削除、複数の画像の結合など、高度な指示も理解する。

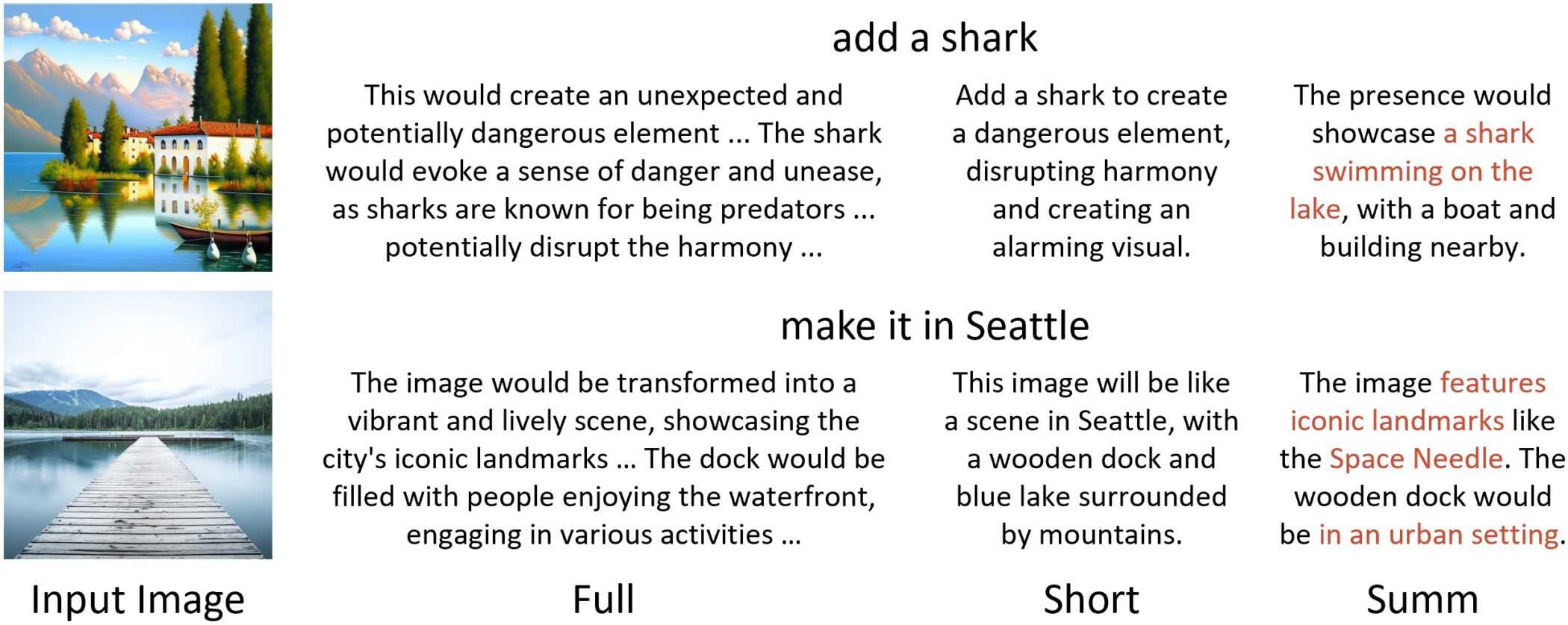

この方法は2つのステップからなる。1つ目は、ユーザーの指示が短すぎるという問題を解決することだ。

そこで研究者らは、ユーザーの指示の前に「この画像はもしこうなったら」というプロンプトを付け、大規模言語モデルを用いて非常に詳細なプロンプトを策定する。

これらのプロンプトは長すぎることが多いため、事前に訓練されたモデルを使用して詳細なプロンプトを要約する。「砂漠」のような単語は、「砂丘」や「サボテン」と関連付けられる。第2のステップでは、モデルが画像を生成する。OpenAIはChatGPTのDALL-E 3で同様のアプローチを使用している。

MGIEはオープンソースのプロジェクトとしてGitHubで公開されている。また、Hugging Faceにもデモがある。

MGIEのリリースは、AIの研究開発におけるAppleの意欲の高まりを強調するものだ。AppleのTim Cook CEOは最近、iOS 18に生成AI機能を導入することを確認し、この分野でのAppleの取り組みについて「信じられないほど興奮している」と表明した。上記のような研究は、AppleがiOSの新機能に関して何を計画しているのか、ある程度の洞察を与えてくれるはずだ。

同様の命令ベースの画像処理の古いモデルにInstructPix2Pixがある。しかし、この方法はStable Diffusionをベースにしており、画像内の個々のオブジェクトを修正することのみを目的としており、MGIEよりもはるかに精度が低い。

論文

参考文献

研究の要旨

指示ベースの画像編集は、精巧な説明や領域マスクのない自然なコマンドによって、画像操作の制御性と柔軟性を向上させる。しかし、人間の指示は時として簡潔すぎて、現在の手法では理解・追従が困難である。マルチモーダル大規模言語モデル(MLLM)は、LMを介したクロスモーダル理解と視覚認識応答生成において有望な能力を示す。我々は、MLLMがどのように編集指示を促進するかを調査し、MLLM-Guided Image Editing (MGIE)を発表する。MGIEは表現的な指示を導き出すことを学習し、明示的なガイダンスを提供する。編集モデルは、エンドツーエンドの学習を通じて、この視覚的想像力を共同で捉え、操作を実行する。我々は、Photoshopスタイルの修正、大域的な写真の最適化、局所的な編集の様々な側面を評価する。広範な実験結果は、表現的命令が命令ベースの画像編集にとって重要であり、我々のMGIEは、競争力のある推論効率を維持しながら、自動メトリクスと人間評価において顕著な改善をもたらすことができることを示している。

コメントを残す