Adobeは、デザイナー向けのより正確なAIツール「Project Gingerbread」で、画像生成処理の未来を垣間見せている。

Fireflyに続き、Adobeは、ユーザーが作成した3Dシーンのプリセットを基に画像生成を行うことで、より正確かつ柔軟な生成を可能にする別の画像AIツールを発表した。生成された画像は、単にランダムなコンポジションで出力されるのではなく、これらのプリセットの上にレイヤーされる。

「AIは、画像の真ん中に何かを配置する傾向があります。しかし、その周りに合成したい場合はどうすればいいのでしょうか」と、Adobeのエマージングデザイン担当プリンシパル・デザイナーのBrooke Hopper氏はこれまでの問題点を指摘する。

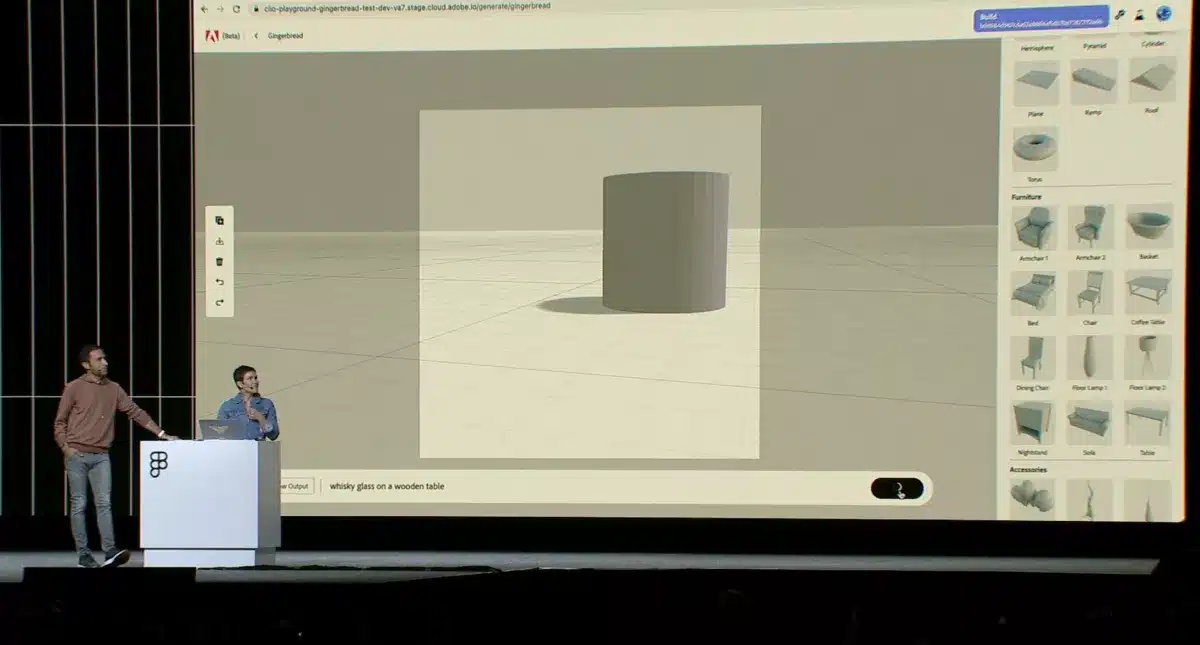

テキストプロンプトによる3Dモデリング

まず、ユーザーは画像のシーンを3Dオブジェクトで大まかにモデリングする。Adobeはこれをウイスキーグラスの例で示している。グラスの形に似た3D形状が、背景と画像の右端にわずかに押し出されている。

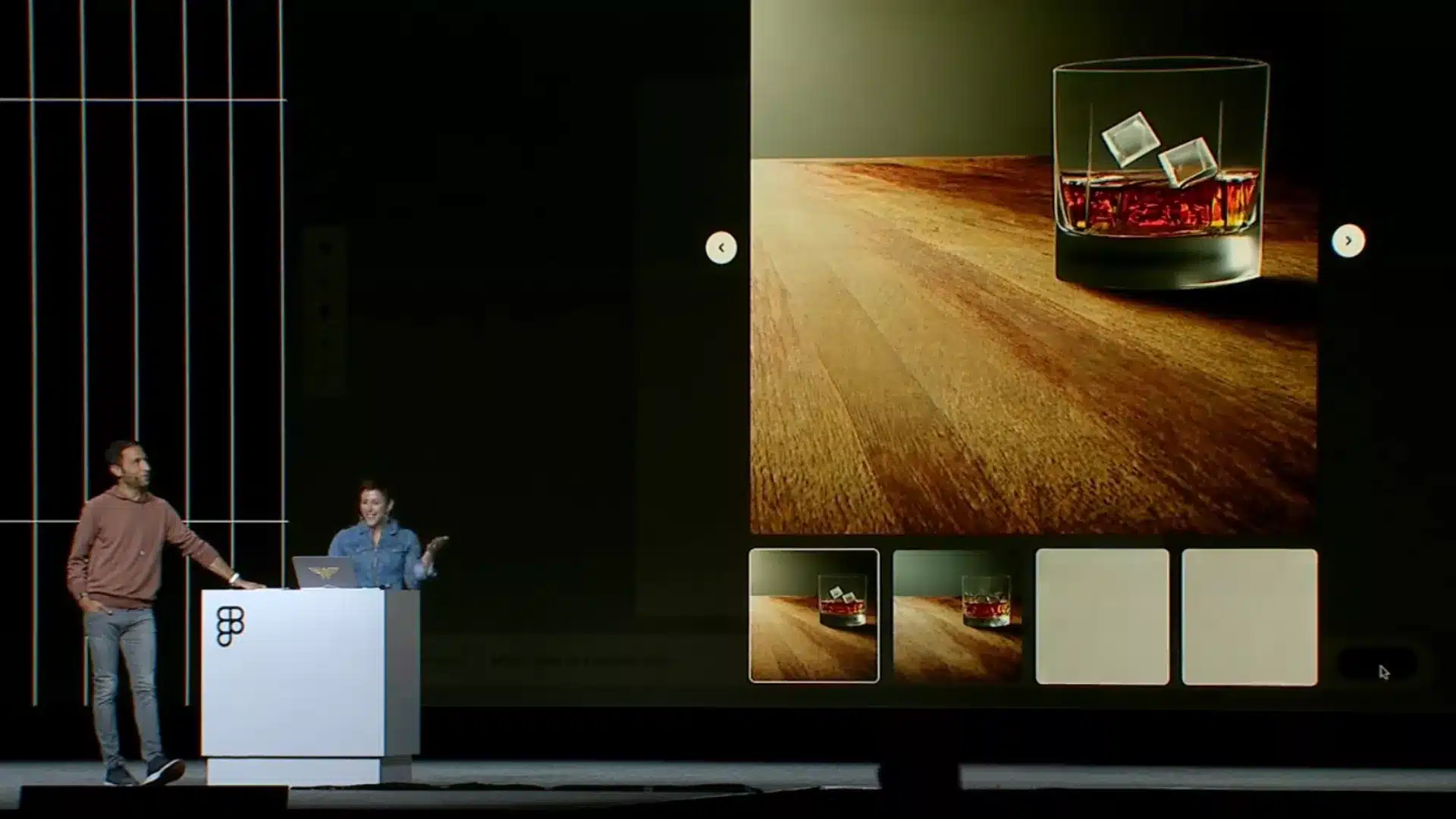

Gingerbreadは、「木製テーブルの上のウイスキーグラス」というテキストプロンプトを処理する際、このガイドラインに従い、3Dモデル上に画像を配置する。ウィスキーグラスは、3D形状が以前に配置された画像とほぼ同じ位置に表示される。

このようにして、Gingerbreadは画像生成におけるランダム性を低減する。ユーザーは、視覚化したい対象により近いカスタム3Dオブジェクトをアップロードすることもできる。

AI画像生成がより正確に

Midjourneyのような画像AIシステムは現在、テキストプロンプトを除けば、生成される画像をほとんど制御できない。

しかし、DragGANのような研究プロジェクトは、正確なAI画像生成が技術的に可能であることを示している。MetaのMake-A-SceneやプロジェクトGLIGENは、AI画像充填のテンプレートとして2Dスケッチを使用しており、テキストのみの画像システムよりも制御性が高い。

つまり、AI生成をよりコントロールしやすくするというAdobeのアイデアは新しいものではない。しかし、それがPhotoshopのような広く使われているツールに生産的に統合されれば、研究室から現実の世界に初めて進出することになるかもしれない。

Source