Reutersの報道によると、NVIDIAがクラウドコンピューティングやその他のハイパースケール企業のカスタムシリコン開発を支援する新事業部を設立したとのことだ。Reutersの情報は9つの情報源に基づいており、NVIDIAは、独自のカスタムシリコンソリューションを追求する企業に先んじ、成長するカスタムAIチップ市場でシェアを獲得したい考えだ。

現在、NVIDIAはハイエンドAIチップ市場の約80%を支配しており、OpenAI、Microsoft、Alphabet、Metaを顧客に抱えている。しかし、これらのハイテク大手は、特定のニーズに合わせて独自のチップを開発している。特にOpenAIは、大規模なチップ構想を計画していると報じられている。今回のNVIDIAがの動きは、NVIDIAのGPUに代わる自社製GPUを構築するケースが増えていることに対応するための企業シフトだと、Reutersは情報筋の話を引用して伝えている。

Amazon Web Services (AWS)は、5年以上前に自社のデータセンターにGraviton GPUを搭載したカスタムシリコンをいち早く展開し、その後もsmartNICやAIアクセラレータなどラインナップを拡大してきた。同様に、GoogleのTensor Processing Unit(TPU)は、AIのトレーニングや推論ワークロード向けのGPUに代わるもので、2015年から開発が進められてきたが、一般に利用可能になったのは2017年からだ。

加えて、生成AI用のNVIDIA GPUの最大消費者の2つであるMicrosoftとMetaが、独自のカスタムシリコンを展開し始めた。先週にはMetaがディープラーニングのレコメンダーモデルを動かすために、自社のデータセンター全体に新たな推論チップを大規模に展開する計画も伝えられた。一方、Microsoftは昨年秋、大規模言語モデルのトレーニングと推論用に設計されたMaia 100 AIアクセラレーターを発表した。

クラウドプロバイダーの内部ワークロード用に構築され最適化されているという意味ではカスタムだが、これらのチップは多くの場合、MarvellやBroadcomなどの知的財産に依存している。GoogleのTPUは、高速シリアライザー・デシリアライザー(SerDes)インターフェースなど、チップが外部と通信するためのBroadcomの技術を幅広く利用している。同紙は、NVIDIAがすでにカスタムチップ事業をMarvellやBroadcomといった競合他社に奪われていると指摘している。

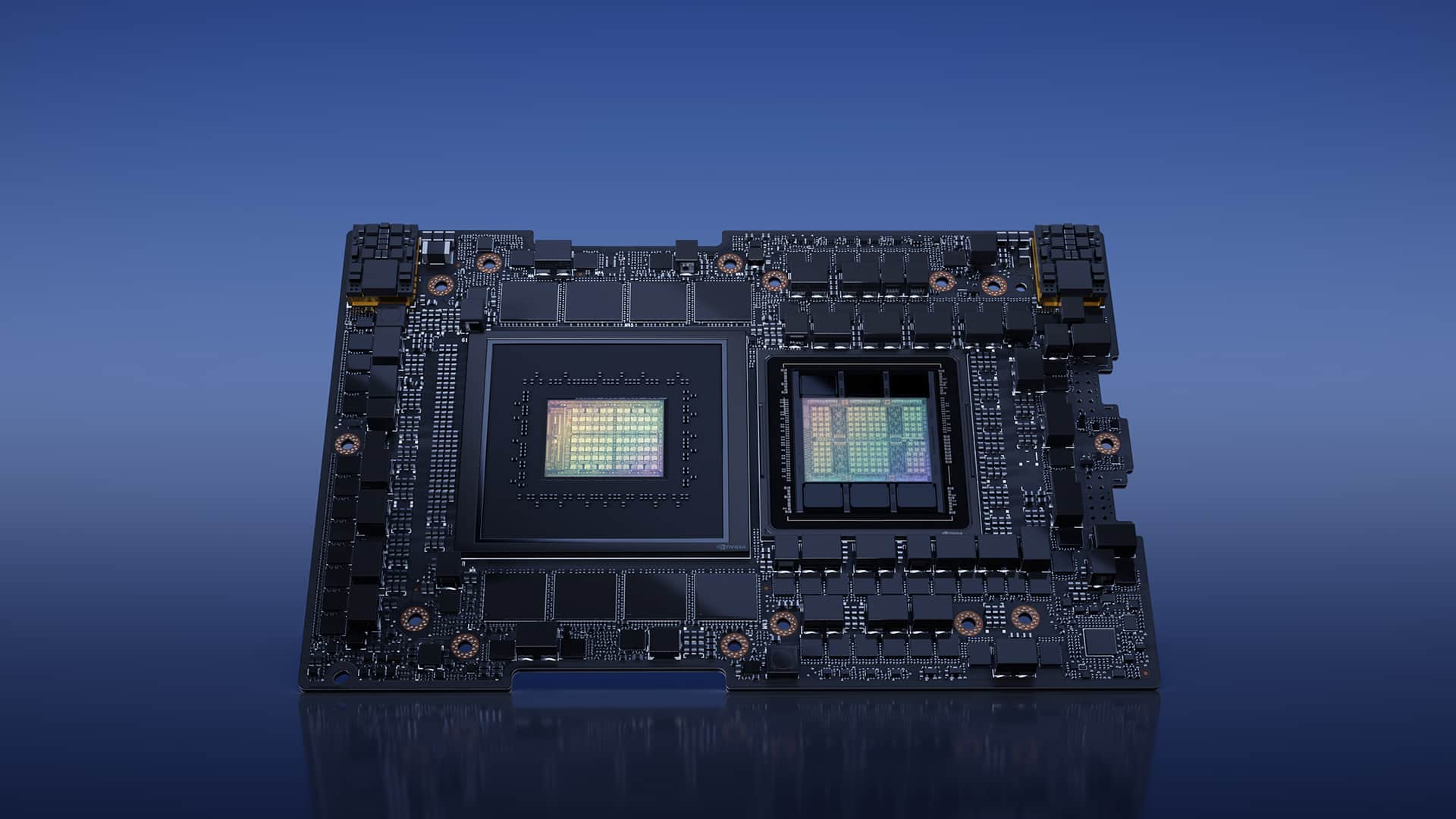

NVIDIAは、並列処理からネットワーキング、相互接続ファブリックに至るまで、あらゆるものに関連する相当量の知的財産を開発し、獲得してきた。特に、Mellanoxのコネクティビティおよびネットワーキング製品も、クラウドサービスプロバイダーの間で高い需要がある。

報道によると、NVIDIAの幹部は、Broadcomを模倣してこれらの技術を小分けにする好機と見ており、すでにAmazon、Meta、Microsoft、Google、OpenAIに、同社の設計に基づくカスタムチップ開発の見込みについて打診しているという。NVIDIAはまた、電気通信、自動車、ビデオゲームの顧客にも同様の提案を持ちかけているという。

特に、NVIDIAは、車載市場に関しては、収益性の高いデータセンター、ゲーム、プロフェッショナル向けビジュアライゼーション・ソリューションに遅れをとっている。これは、多くの自動車メーカーがSoftware-Defined Vehicleを実現するためにカスタムシリコンを検討しているためであり、NVIDIA Driveプラットフォームは多くの開発に先行しているものの、少なくとも一部の自動車メーカーは、コスト、競争力、IP制御の観点から、高度にカスタマイズされた自社製プラットフォームを希望している。

このアプローチは、NVIDIAにとって新たな道を開くだけでなく、AMD、Alchip、Broadcom、Marvell Technology、Sondrelといった他のカスタムチップ設計者と直接競合することになる。これらの企業は豊富な経験を積んでいるが、NVIDIAはCPU、GPU、AI、HPC、ネットワーキング、センサー処理技術など、すでに競争力の高いIPを数多く保有している。これらのIPの一部をカスタムパッケージで販売することで、NVIDIAのTAM(Total Addressable Market)を大幅に改善し、最終的に収益を増加させることができるだろう。

Sources

コメントを残す