2024年に、現行の物より高速で大容量のHBM3eメモリが各社から利用可能になる中で、このメモリの最大の消費者であるAIトレーニング分野において、GPUで独占的地位を築いているNVIDIAは既に8月の時点でGrace Hopper GH200 SuperchipのHBM3e搭載バージョンを明らかにしていた。そして本日、NVIDIAはスタンドアロンアクセラレータチップ H100のHBM3eメモリ対応バージョンである「H200 」チップを市場に投入する計画を明らかにし、AI分野における同社の地位を堅固な物にしようとしている。

H200は、メモリ以外はH100と実質的に同じ物と見える。H200の目的は、より高速で大容量のメモリを搭載したバージョンのチップを展開することで、Hx00製品ラインの中間世代のアップグレードとして機能することだ。NVIDIAは、Micronや他の企業がNANDを展開する予定のHBM3eメモリを利用することで、メモリ帯域幅に制約のあるワークロードにおいて、より優れた実パフォーマンスを持つアクセラレータを提供できるようになるだけでなく、より大きなワークロードを処理できるパーツも提供できるようになる。これは、これまでH100アクセラレータのほぼすべての需要を牽引してきた生成AIの分野で特に役立つだろう。

| H200 | H100 | A100(80GB) | |

|---|---|---|---|

| FP32 CUDA コア | 16896? | 16896 | 6912 |

| Tensorコア | 528? | 528 | 432 |

| ブーストクロック | 1.83GHz? | 1.83GHz | 1.41GHz |

| メモリクロック | ~6.5Gbps HBM3E | 5.24Gbps HBM3 | 3.2Gbps HBM2e |

| メモリバス幅 | 6144-bit | 5120-bit | 5120-bit |

| メモリ帯域幅 | 4.8TB/sec | 3.35TB/sec | 2TB/sec |

| VRAM | 141GB | 80GB | 80GB |

| FP64 ベクトル | 33.5 TFLOPS? | 33.5 TFLOPS | 9.7 TFLOPS |

| INT8 テンソル | 1979 TOPS? | 1979 TOPS | 624 TOPS |

| FP16 テンソル | 989 TFLOPS? | 989 TFLOPS | 312 TFLOPS |

| FP64 テンソル | 66.9 TFLOPS? | 66.9 TFLOPS | 19.5 TFLOPS |

| 相互接続 | NVLink 4 18 Links (900GB/sec) | NVLink 4 18 Links (900GB/sec) | NVLink 3 12 Links (600GB/sec) |

| GPU | GH100 (814mm2) | GH100 (814mm2) | GA100 (826mm2) |

| トランジスタ数 | 800億 | 800億 | 542億 |

| TDP | 700W | 700W | 400W |

| 製造プロセス | TSMC 4N | TSMC 4N | TSMC 7N |

| インターフェース | SXM5 | SXM5 | SXM4 |

| アーキテクチャ | Hopper | Hopper | Ampere |

HBM3eの採用により、GPUのメモリ帯域幅はH100の3.35TB/秒から4.8TB/秒に、総メモリ容量は前モデルの80GBから141GBに増加している。

NVIDIAのハイパフォーマンス・コンピューティング製品担当副社長であるIan Buck氏は、ビデオ・プレゼンテーションで、「より高速で広範なHBMメモリの統合は、GPUの使用率と効率を最適化しながら、生成AIモデルや(ハイパフォーマンス・コンピューティング)アプリケーションを含む、計算負荷の高いタスク全体のパフォーマンスを加速させる役割を果たす」と述べた。

NVIDIAがこれまでに開示している情報からは、H200が前モデルよりも計算スループットが向上するとは示されていない。メモリの変更により、実際の性能は向上するはずだが、NVIDIAがHGX H200クラスタに対して提示している32 PFLOPSのFP8性能は、現在市販されているHGX H100クラスタと同じだ。

HBM3Eを搭載したGH200システムと同様、NVIDIAはH200アクセラレータが2024年第2四半期に利用可能になることしている。

HGX H200

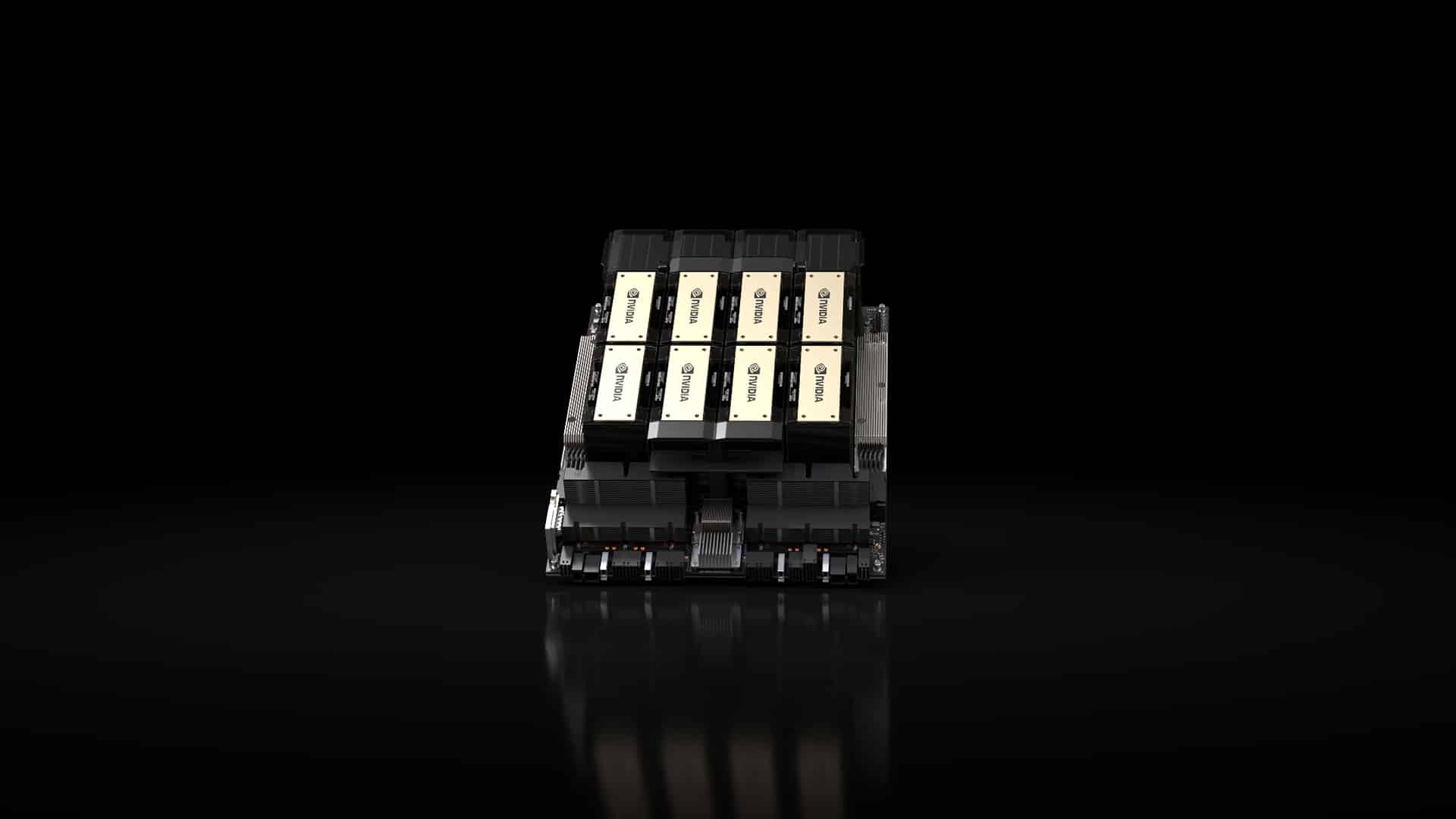

H200アクセラレータと並行して、NVIDIAはHGX H200プラットフォームも発表した。これは、新しいアクセラレータを使用する8ウェイHGX H100の更新バージョンとなる。NVIDIAのH100/H200ファミリーの真のバックボーンであるHGXキャリアボードは、8個のSXMフォームファクタ・アクセラレータを搭載し、あらかじめ配置された完全接続トポロジーでリンクされている。HGXボードはスタンドアロンであるため、適切なホスト・システムに接続することができ、OEMはハイエンド・サーバーの非GPU部分をカスタマイズすることができる。

Quad GH200:4つのGH200をシングルボードに統合

NVIDIAは現在、GraceとHopper(およびGrace Hopper)の両チップを大量に出荷しており、これらのチップを使用した、いくつかの追加製品も発表している。その最新のものが、NVIDIAが単に「Quad GH200」と呼んでいる4ウェイGrace Hopper GH200ボードだ。

Quad GH200は、その名の通り4つのGH200アクセラレータを1枚のボードに搭載し、より大きなシステムに取り付けることができる。個々のGH200は、8チップ、4ウェイのNVLinkトポロジーで互いに配線されており、これらのボードをより大規模なシステムの構成要素として使用することを想定している。

実際には、Quad GH200は、HGXプラットフォームと同等のGrace Hopperで構成される。Grace CPUを搭載することで、GPUのみのHGXボードとは異なり、技術的には各ボードが独立することになるが、ホストインフラに接続する必要性は変わらない。

Quad GH200ノードは、288のArm CPUコアと合計2.3TBの高速メモリを提供する。注目すべきことに、NVIDIAはここでGH200のHBM3eバージョンを使用することに言及していない(少なくとも当初は)ため、これらの数値はオリジナルのHBM3バージョンと思われる。つまり、Grace CPUあたり480GBのLPDDR5X、Hopper GPUあたり96GBのHBM3、合計1920GBのLPDDR5Xと384GBのHBM3メモリということになる。

JUPITERスーパーコンピューター:18.2メガワットで24K GH200、2024年設置予定

最後に、NVIIDAは、JUPITERと呼ばれる新たなスーパーコンピュータ設計を明らかにした。EuroHPC Joint Undertakingが発注したJUPITERは、23,762 GH200ノードからなる新しいスーパーコンピュータである。オンラインになれば、JUPITERはこれまで発表されたHopperベースのスパコンで最大となり、これまで発表されたHopperベースのスパコンを定義するようになった低精度テンソル駆動のAIワークロードだけでなく、標準的なHPCワークロードを明確に(そして公に)ターゲットにした最初のスパコンとなる。

EvidenとParTecと契約したJUPITERは、NVIDIAのテクノロジーを余すところなく披露している。NVIDIAが本日発表したQuad GH200ノードをベースに、Grace CPUとHopper GPUがスーパーコンピューターの中核を担っている。個々のノードは、NVIDIAのConnectXアダプタをベースとしたQuantum-2 InfiniBandネットワークによって支えられている。

同社は具体的なコア数やメモリ容量の数字を開示していないが、1枚のQuad GH200ボードが何を提供するかわかっているので、計算は簡単だ。トップエンドでは(歩留まりを考慮してサルベージ/ビニングを行わないと仮定すると)、23,762個のGrace CPU、23,762個のHopper H100クラスGPU、およそ10.9PBのLPDDR5X、さらに2.2PBのHBM3メモリとなる。

このシステムは、AI用途には93EFLOPSの低精度性能を、従来のHPCワークロードには1EFLOPS以上の高精度(FP64)性能を提供する予定だ。後者の数値は特に注目すべきもので、これによりJUPITERはHPCワークロード向けの初のNVIDIAベースのエクサスケールシステムとなる。

1EFLOPSは、23,762基のH100がFP64テンソル演算でしか提供できないものだからだ。理論的なHPCスーパーコンピュータのスループットの伝統的な指標は、行列性能ではなくベクトル性能であるため、この数値は他のシステムと完全に比較できるものではない。とはいえ、HPCワークロードも部分的に行列演算を多用しているため、まったく無関係な主張でもない。その他、Frontierとの比較のために、JUPITERのストレートベクター性能は約800TFLOPSであるのに対し、Frontierはその2倍以上である。一方、この2つのシステムが実環境でどの程度近づくかは、それぞれのワークロードでどの程度行列演算が使われているかによるだろう(LINPACKの結果は興味深い)。

このシステムの価格は発表されていないが、消費電力は18.2メガワット(フロンティアより3メガワット少ない)となっている。

Sources

コメントを残す