大規模言語モデルは、より長いシーケンスを処理する必要があるが、現在の方法は遅すぎるか、制限されすぎているため、ある長さを超えることは難しい。ChatGPTは4096個のトークンしか読むことが出来ず(有料版で使えるGPT-4は3万2768トークン)これがボトルネックになっている面もあった。この障害を克服するために、Microsoftは新たなTransformerモデル「LongNet」を考案している。LongNetは、ChatGPTの25万倍である10億トークンを超えるシーケンスを扱うことができる新しい種類のTransformerモデルで、より短いシーケンスのパフォーマンスを低下させることがない。10億トークンと言うと、これは約7億5,000,000ワードまたは2,000,000ページに相当する膨大な量だ。

同社は、Microsoft LongNetと呼ばれる新しいAIトランスフォーマーモデルを提案する論文を発表した。 Transformerモデルとは、自然言語や音声などのシーケンシャルデータを処理できるニューラルネットワークアーキテクチャの一種である。OpenAIのGPT-4、MetaのLLaMA、GoogleのPaLM 2などの大規模言語モデル(LLM)は、膨大なテキストデータで学習されたTransformerモデルに基づいている。

Microsoft LongNetの主な革新点は拡張アテンションであり、長くなるにつれてより多くのトークンをカバーし、計算の複雑さとトークン間の依存関係を軽減する。

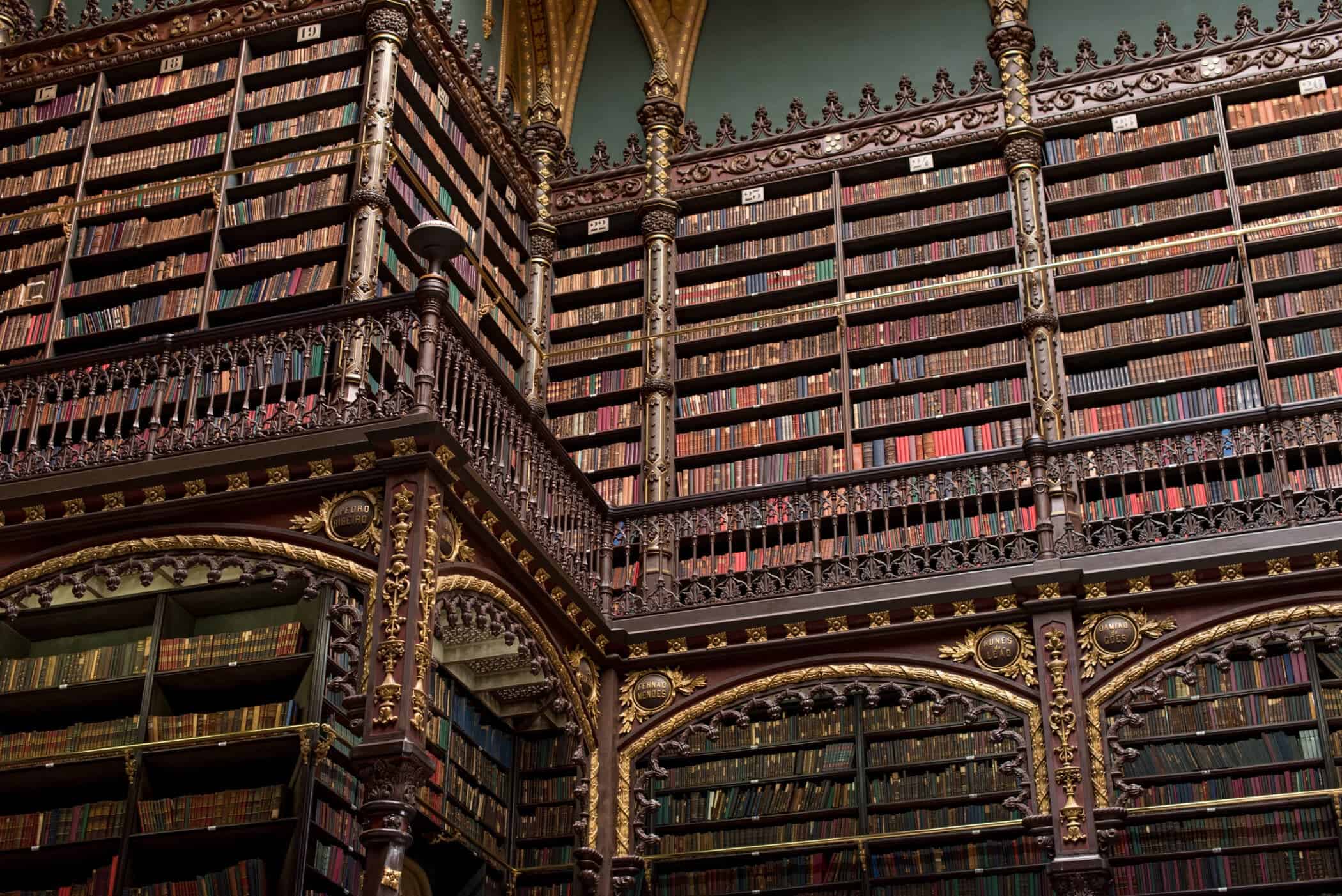

AIの専門家であるDavid Shapiro氏は、Microsoft LongNetがなぜ大きなブレークスルーなのかについて、YouTubeにビデオを投稿している。億を超えるトークンを取り扱えることが何を意味するのか、Shapiro氏は3GBの画像を例に説明する。Shapiro氏は、人間が画像全体を見てそれを理解し、その後画像の細かい部分を見て理解を深める事が出来ることを例に出して説明している。

AIは常に細かい部分を見ることに長けているわけではない。AIはしばしば全体像を把握することができるが、見ているものの小さな側面に目を奪われてしまうことがある。その好例が、Google BardやBing Chatのようなチャットボットを支える現在の大規模な言語モデルだ。これらの強力なAIツールは、あるトピックをカバーする情報を表示することはできるが、細かい部分に入り込むと誤った情報を提供することがある。

トークン化とは何か、なぜAIにとって重要なのか

自然言語処理(NLP)は、人間の言語を理解し生成することを扱うAIの分野である。しかし、テキストをコンピュータに送り込む前に、コンピュータが扱えるような小さな断片に分解する必要がある。このプロセスはトークン化と呼ばれ、NLPにおいて最も基本的かつ不可欠なステップのひとつである。

トークン化はケーキをスライスに切るようなもので、大きくて複雑なテキストを、単語、文、文字など、小さくて単純な単位に分割する。例えば、英語で「I love NLP.」という文章は3つの単語にトークン化できる:「I」、「love」、「NLP」。

しかし、トークン化は単なるスライス作業ではない。言語やタスクによって、トークン化の方法は異なるからだ。例えば、中国語や日本語のように単語と単語の間にスペースがない言語もあるので、単語の境界を見つけるために特別なアルゴリズムを使う必要がある。センチメント分析やテキスト要約のように、句読点やエモーティコンをトークンとして残すことが有益なタスクもある。

トークン化はまた、伝統的なNLP手法と最新のNLP手法の両方で重要な要素だ。Count Vectorizerのような伝統的な手法では、トークン化を使用して、各トークンの頻度に基づいてテキストの数値表現を作成する。Transformerなどの最新の手法では、トークン化を使って、ニューラルネットワークで処理できるトークンのシーケンスを作成する。

トークン化は、テキストがどのように表現され、コンピューターに理解されるかを決定するため、NLPにおいて非常に重要なステップである。また、自然言語の多様性と複雑性を明らかにする、魅力的なトピックでもある。

トークン数の拡大がAI開発にもたらすもの

トークン数を拡大することで、AIモデルは基本的に全体像を把握することができ、同時に細かい部分にも集中することができる。Microsoft LongNetのアイデアは、距離が拡大するにつれて使用するトークン数を拡大する拡張注意を使用することである。

LongNetにはいくつかの利点がある:

- 計算速度が速く、トークン間の依存関係が小さい

- 非常に長いシーケンスの分散トレーナーとして使用できる

- その拡張された注意は、既存のTransformerベースの最適化に簡単に追加することができる

つまり、LongNetは長いシーケンスや一般的な言語タスクをモデル化することができる。Shapiro氏は、Microsoftの論文は人工知能(AGI)へのプッシュを示唆するものだと説明する。より多くのトークンを持つことができるということは、膨大なタスクを瞬時に正確にカバーできるということだと指摘する。Shapiro氏は、AIが何千もの雑誌を読むことができる例として、医学研究を挙げている。

LongNetはまだ始まったばかりであることも注目に値する。このコンセプトがより強力になれば、最終的には何兆ものトークンを見ることができるようになり、そのうちインターネット全体を数秒で確認出来るようになるだろうとShapiro氏は言う。そうなれば、成長は人間の能力を超え、AIはAGIへと向かうだろう。

LongNetは研究段階にあり、少なくとも1年はその能力を見ることができないだろうとShapiro氏は予測している。とはいえ、AIの急速な発展により、非常に強力な知性は、当初多くの人々が予想していたよりも近づいている可能性がある。超知能の開発には少なくとも20年はかかるという予測もあれば、実現は不可能だろうという意見もある。

論文

参考文献

研究の要旨

大規模言語モデルの時代において、配列長のスケーリングは重要な要求となっている。しかし、既存の手法は、計算の複雑さとモデルの表現力のどちらにも苦戦しており、最大シーケンス長が制限されている。本研究では、より短いシーケンスに対する性能を犠牲にすることなく、シーケンス長を10億トークン以上に拡張できるTransformerの変種であるLongNetを紹介する。具体的には、距離が長くなるにつれて指数関数的に注意フィールドを拡大する拡張注意を提案する。LongNetには大きな利点がある:1)計算の複雑さが線形であり、トークン間の依存性が対数であること、2)非常に長いシーケンスの分散トレーナーとして使用できること、3)その拡張された注意は標準的な注意のドロップイン置き換えであり、既存のTransformerベースの最適化とシームレスに統合できること。実験の結果、LongNetは長いシーケンスのモデリングと一般的な言語タスクの両方で強力な性能を発揮することが実証された。我々の研究は、例えばコーパス全体やインターネット全体をシーケンスとして扱うなど、非常に長いシーケンスをモデル化するための新たな可能性を開くものである。

コメントを残す