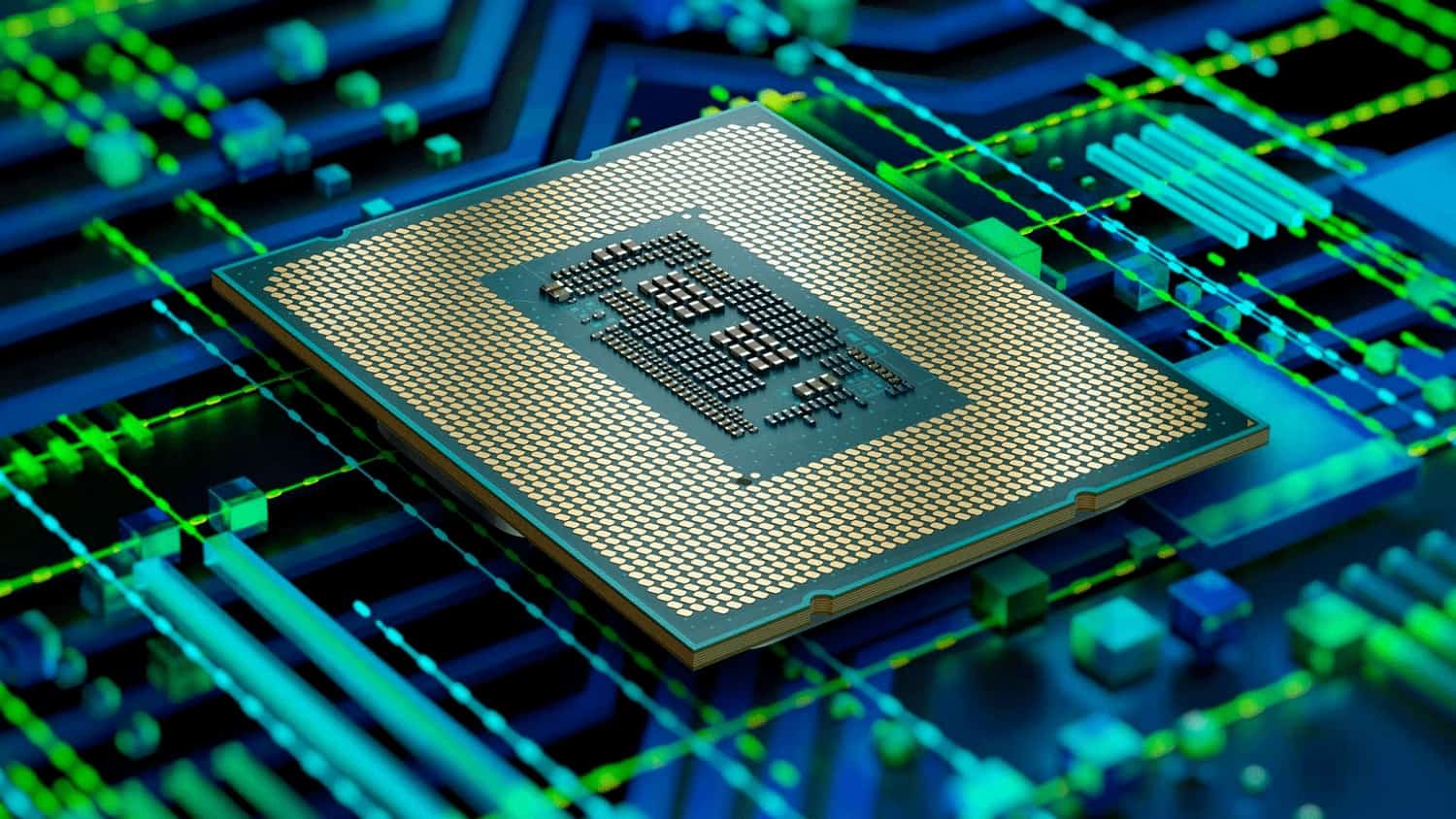

The Informationの独占スクープによると、Microsoftは、既に2019年から、内部コードネーム「Athena」と呼ばれる独自の新しい人工知能(AI)チップの開発を進めており、早ければ来年にも、Athenaを自社内やOpenAIで広く利用できるようにする可能性があるとのことだ。このチップの最初のバージョンは、Taiwan Semiconductor (TSMC) の5ナノメートルプロセスを使用すると伝えられている。

専門家によれば、これによってNVIDIAの存在が脅かされることはないが、ハイパースケーラーが独自のカスタムシリコンを開発する必要性を示唆している。

このチップは、Google(TPU)やAmazon(TrainiumおよびInferentiaプロセッサ・アーキテクチャ)が自社開発したものと同様に、大規模言語モデル(LLM)トレーニングに特化して設計されている。既に高度な生成AIモデルの規模は、その訓練に必要な計算能力よりも速く成長しているため、ハードウェアの開発も急務であり、こうした動きは当然の向きと見るべきだろう。

John Peddie Researchによると、AIチップの供給に関してはNVIDIAが圧倒的な市場リーダーであり、約88%の市場シェアを誇っている。各社は、1個数万ドルもするハイエンドGPU「A100」と「H100」へのアクセスを確保するためだけに競い合っており、GPU危機とも言える事態を引き起こしている。

Microsoftがコスト削減を図りながらジェネレーティブAI戦略を加速させようとしている今、同社が差別化されたカスタムAIアクセラレータ戦略を開発することは理にかなっているだろう。

高速化の必要性は、機械学習の推論をサポートするAIチップにも当てはまる。つまり、モデルが重み付けされ、ライブデータを使用して実用的な結果を生成する場合だ。例えば、ChatGPTが自然言語入力に対する応答を生成するたびに、推論にコンピュートインフラが使用される。

NVIDIAは非常に強力な汎用AIチップを製造しており、特にMLトレーニングを行う方法として、その並列計算プラットフォームCUDA(およびその派生製品)を提供している点で強みがある。しかし、推論には一般的にそれほど性能が必要ではなく、ハイパースケーラはカスタマイズされたシリコンで顧客の推論ニーズにも影響を与えることができると考えているようだ。特に、高コストのNVIDIAオプションを必要としない顧客に対して、ハイパースケーラが独自チップを開発し、より低コストのオプションを提供する事は理に適っているだろう。各社は、NVIDIAに対抗するだけでなく、汎用クラウドコンピュートにおいてIntelにも対抗できるよう、独自のシリコンを開発し続けると見られる。

Source

コメントを残す