HBM3Eメモリを世界で最初に出荷した企業であるMicronは、AI向けのこの高度な高帯域幅メモリの2024年度分の供給量の完売を報告し、加えて2025年の生産量の大半も既に割り当てられた事を報告している。MicronのHBM3E(MicronがHBM3 Gen2と呼ぶ)メモリは、NVIDIAのH200及びGH200アクセラレータの最初の認定製品であり、これに搭載される予定だ。

MicronのCEOであるの最高経営責任者(CEO)であるSanjay Mehrotra氏は、今週の決算説明会の準備発言で、「当社のHBMは2024年暦年で完売しており、2025年供給の圧倒的大部分はすでに割り当てられています。HBMのビットシェアは、当社のDRAM全体のビットシェアと同等になると、2025年暦年のいつかには引き続き見込んでいます」と、述べている。

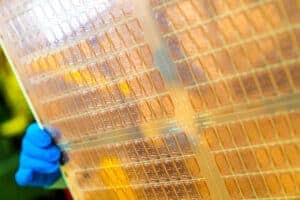

MicronのHBM3E製品は、8-Hiの24GBスタックで、1024ビット・インターフェース、9.2GT/秒のデータ転送速度、1.2TB/秒の総帯域幅を持つ。NVIDIAのAIおよびHPC向けH200アクセラレータは、このスタックを6個使用し、合計141GBのアクセス可能な高帯域幅メモリを提供する。

また、Micronは容量が50%増加した12-Hi 36GBスタックのサンプリングも開始した。これらのKGSDは2025年に立ち上がり、次世代のAI製品に使用される予定だ。一方、NVIDIAのB100とB200は、少なくとも当初は36GB HBM3Eスタックを使用しないようだ。36GBのHBM3Eスタックは次世代AIプロセッサーに使用され、2025年に生産が開始される予定だ。

HBMの製造には特殊なDRAMの製造が含まれるため、HBMの増産はMicronのメインストリーム向けDRAM ICの製造能力に大きく影響する。

「HBMの生産は、HBM以外の製品の供給増加を抑制するでしょう。業界全体では、HBM3Eは、同じ技術ノードで所定のビット数を生産するために、DDR5の約3倍のウェーハ供給量を消費します」と、Micronは述べている。

Source

- Micron: Fiscal Q2 2024 Earnings Call Prepared Remarks [PDF]

コメントを残す