MetaのチーフAIサイエンティストYann LeCun氏は、「人間の助けを借りず、世界の仕組みに関する内部モデルを学習することで、より迅速に学習し、複雑なタスクを達成する方法を計画し、不慣れな状況に容易に適応することができるアーキテクチャを作る」という遠大なビジョンを掲げているが、今回そのビジョンに前身が見られたと述べている。

MetaのAI研究者らは、このビジョンのコンポーネントに基づく最初のAIモデルを開発したと発表した。

Image Joint Embedding Predictive Architecture(I-JEPA)と呼ばれるこのモデルは、ピクセルそのものを比較するのではなく、画像の抽象的な表現を比較することで、外界の内部モデルを作成して学習することができる。つまり、人間が新しい概念を学ぶのに近い方法で学習することができるのだ。

I-JEPAは、人間が世界を受動的に観察しながら、その背景情報を大量に学んでいくという考えに基づいている。I-JEPAは、このような学習方法を模倣しようとするもので、世界に関する常識的な背景知識を捕らえ、それをデジタル表現に符号化し、後でアクセスできるようにする。課題は、このようなシステムが、ラベル付きデータセットとは対照的に、画像や音声などのラベルなしデータを用いて、これらの表現を自己教師付きで学習しなければならないことだ。

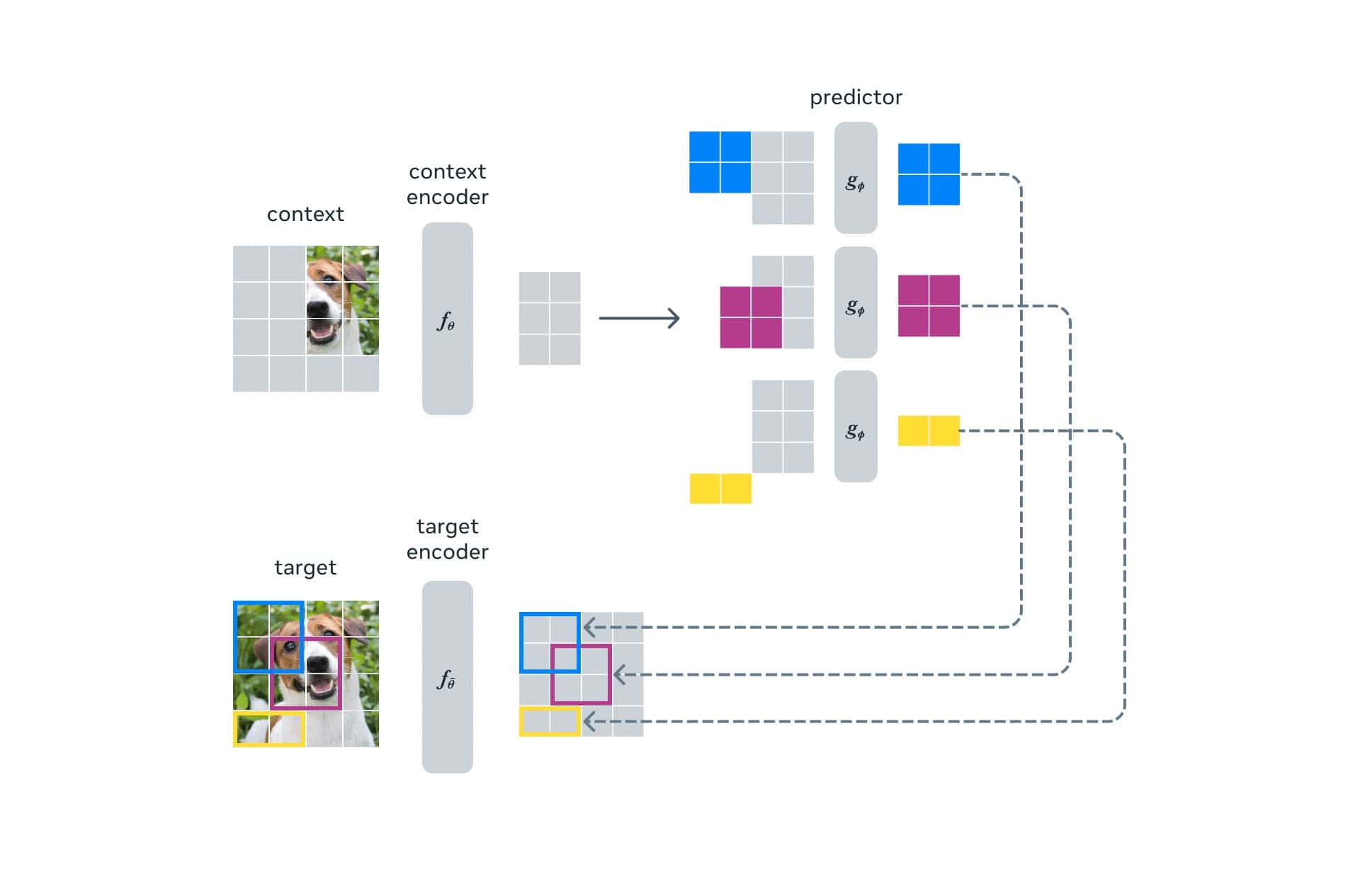

I-JEPAは、画像やテキストなどの入力の一部を、同じ入力の他の部分の表現を用いて予測することが出来る。これは、画像の一部を消したり、文章中の単語を隠したりするなど、入力の一部を取り除いたり歪めたりすることで学習し、失われた入力を予測しようとする新しい生成AIモデルとは異なるものだ。

Metaによれば、生成AIモデルが採用する手法の欠点は、世界は本質的に予測不可能であるにもかかわらず、欠落した情報をすべて埋めようとすることだ。その結果、生成的な方法は、無関係な細部に焦点を当てすぎるため、人が決して犯さないようなミスを犯すことが多い。例えば、人間の手を正確に再現しようとすると、余計な数字が加わってしまったり、他のミスを犯してしまったりするのだ。

I-JEPAは、このようなミスを防ぐために、ピクセルレベルの不要なディテールを排除した抽象的な予測対象を用いて、より人間に近い形で欠損情報を予測する。このように、I-JEPAの予測器は、部分的に観測可能なコンテキストに基づいて静止画像の空間的な不確実性をモデル化し、ピクセルレベルの詳細とは対照的に、画像内の未見領域に関するより高いレベルの情報を予測することが出来るのだ。

Metaは、I-JEPAが複数のコンピュータビジョンベンチマークで非常に優れた性能を示し、他の種類のコンピュータビジョンモデルよりもはるかに計算効率が高いことを示したと述べている。また、I-JEPAが学習した表現は、微調整を必要とせず、他のアプリケーションにも使用することができる。

「例えば、A100 GPUを16個使って6億3200万パラメータの視覚変換モデルを72時間以内に訓練し、ImageNetのローショット分類で、クラスあたり12個のラベル付き例だけで最先端の性能を達成しました。他の方法は、通常、同じ量のデータで訓練した場合、2~10倍のGPU時間を要し、より悪いエラーレートを達成します」と、Metaの研究者らはI-JEPAの処理効率性能の高さを主張する。

Metaは、I-JEPAが、手作りの画像変換でエンコードされた追加の知識を必要とせずに、既製の競争力のある表現を学習できるアーキテクチャに多くの可能性があることを実証していると述べている。I-JEPAの研究者は、I-JEPAのトレーニングコードとモデルのチェックポイントの両方をオープンソース化しており、次のステップとして、画像とテキストのペアデータやビデオデータなど、他のドメインにこのアプローチを拡張する予定だと述べている。

Metaは、「JEPAモデルは将来、映像理解のようなタスクにエキサイティングな応用ができるかもしれません。我々は、これは世界の一般的なモデルを学習するための自己教師付きメソッドを適用し、スケーリングするための重要なステップであると信じています」と、述べている。

論文

参考文献

- Meta AI: I-JEPA: The first AI model based on Yann LeCun’s vision for more human-like AI

- via VentureBeat: Meta releases I-JEPA, a machine learning model that learns high-level abstractions from images

研究の要旨

本論文では、手作業によるデータ補強に頼らず、高度に意味的な画像表現を学習するためのアプローチを示す。画像から自己教師付き学習を行うための非再生的アプローチであるImage-based Joint-Embedding Predictive Architecture(I-JEPA)を紹介する。I-JEPAの背後にある考え方は単純で、単一のコンテキストブロックから、同じ画像内の様々なターゲットブロックの表現を予測することである。具体的には、(a)十分に大きなスケール(意味的)を持つターゲットブロックをサンプリングし、(b)十分に情報量の多い(空間的に分布した)コンテキストブロックを使用することが重要である。経験的に、Vision Transformersと組み合わせた場合、I-JEPAは非常にスケーラブルであることがわかった。例えば、16台のA100 GPUを使用してImageNet上でViT-Huge/14を72時間以内に訓練し、線形分類からオブジェクトカウント、深度予測まで、幅広いタスクで強力なダウンストリーム性能を達成する。

コメントを残す