1年も経たずにIntelが第4世代Xeon(Sapphire Rapids)の後継となる「Emeral Rapids」を発表したのは同社の焦りを表しているのかも知れない。

AIがテック業界を席巻する中、IntelはプロセッサでのAI処理能力を強化することに注力している。今回、Intelが発表した第5世代Xeonプロセッサーもその流れを汲むものだ。とはいえ、このプロセッサーは、LLM処理に特化しているわけではなく、一般的な用途でも大きな性能向上が図られている。

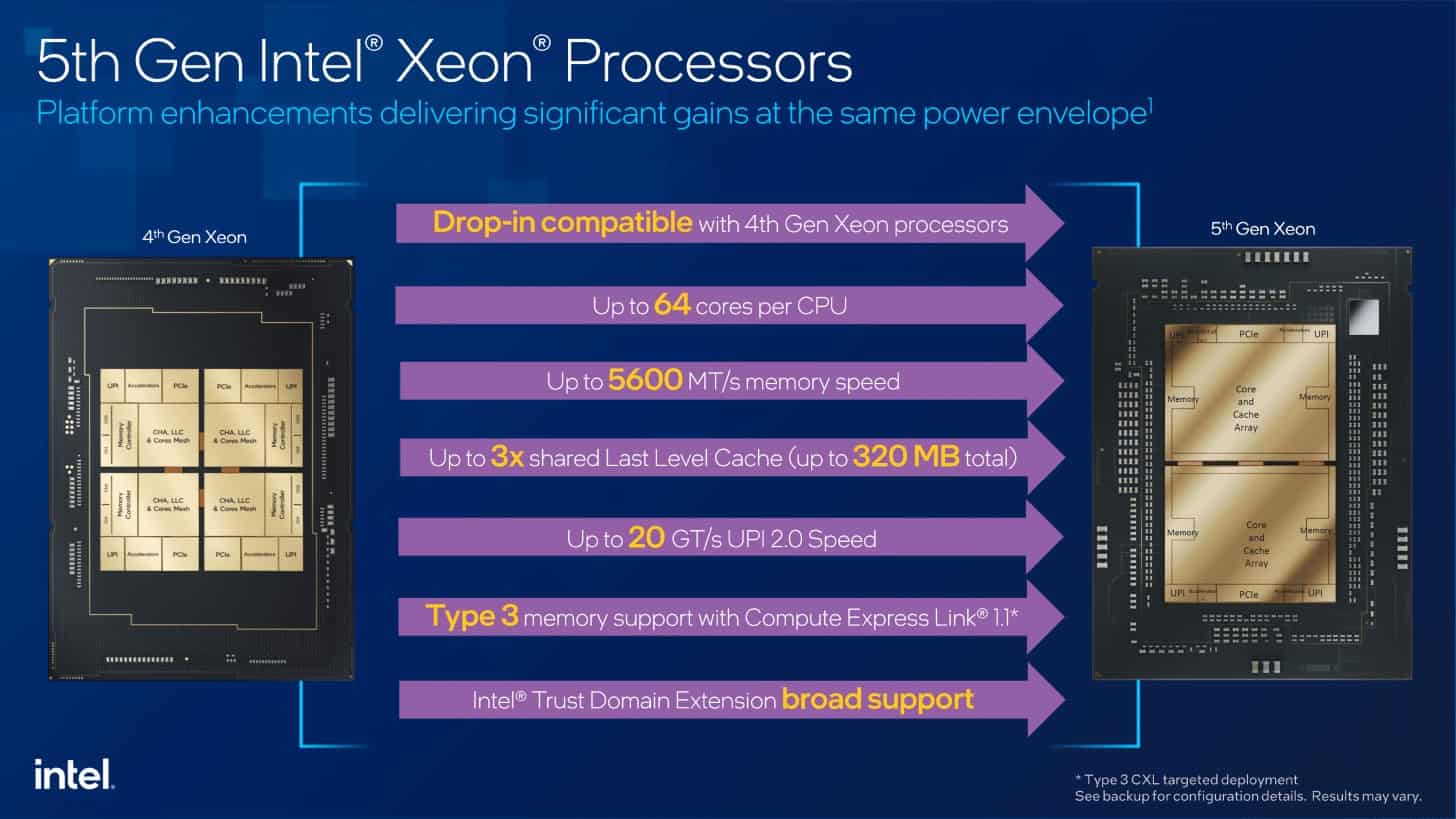

Sapphire Rapidsとともに、Emerald RapidsはEagle Streamプラットフォームを形成する。Sapphire Rapidsプロセッサを使用しているサーバーは、Emerald Rapidsに変更することが可能だ。全体として、80のPCI Express 5.0レーンと8つのDDR5メモリチャネルが残っているが、いくつかの改良点がある。

Intelは、第5世代Xeonの変更点の一部を、以前にリリースされたデスクトップ・プラットフォーム(別名Raptor Lake)から引き継いでいる。

Intel 7は継続、しかし新コア

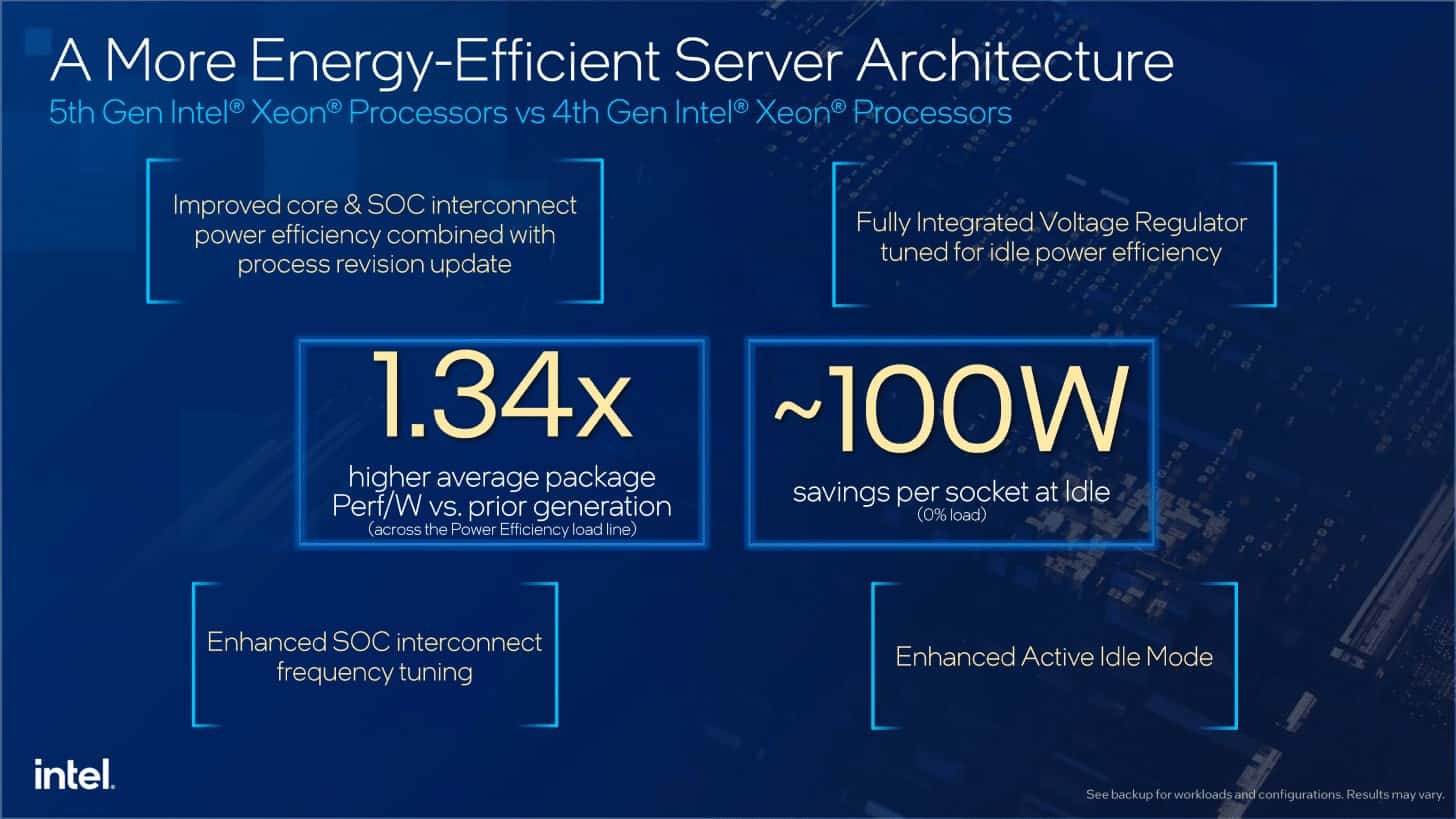

Emerald Rapidsプロセッサー用の3チップの生産は、Intel 7でも継続される。しかし、デスクトップ・プロセッサーと同様に、Intelは「Intel 7 Ultra」と呼ばれる改良生産について話している。半導体プロセスにおけるチャネルの移動度が改善され、電圧-クロック曲線上の他の動作ポイントに移動することが可能になった。これにより、Xeonプロセッサーがより効率的に動作するようになるはずで、これは対応する数値でも裏付けられている。

しかし、マイクロアーキテクチャはWillow Cove設計ではなく、コアあたり2MBのプライベートL2キャッシュと改良されたスケジューリングを備えたRaptor Coveへとアップデートが行われている。

Emerald Rapidsの最大拡張ステージは、従来の60コアから64コアになった。Intelはまた、従来の4つのXCCダイの代わりに2つのXCCダイのみを使用している。しかし、パッケージについては後ほど説明する。個々のコアのクロックレートに関しては、ほとんど変更はない。ブーストクロックは最大4.1GHzのままだ。

DDR5メモリはSapphire Rapidsの4,800 MT/sからEmerald Rapidsの5,600 MT/sになる。ただし、第4世代Xeonと同様、ここにもグラデーションがあるため、すべてのモデルに当てはまるわけではない。ただし、メモリ帯域幅は理論上16%増加する。しかし、それよりもはるかに革新的なのはラスト・レベル・キャッシュ(LLC)で、従来の最大105MBから320MBに増加した。これは、ほぼすべてのデータをキャッシュに保存できるアプリケーションにとって特に有益である。例えば、推論アプリケーションのような場合である。

Intelは、2つ以上のソケット間の通信にウルトラ・パス・インターコネクト(UPI)を利用している。Emerald Rapidsでは、IntelはUPI 2.0リンクを16GT/秒から20GT/秒に高速化している。しかし、この時点で、第5世代Xeonには4Sまたは8Sシステム用のプロセッサが存在しないことに留意すべきである。そのため、エメラルドラピッズは1Sおよび2Sサーバーに特化している。4ソケット以上の場合は、Sapphire Rapidsに頼るしかない。

アクセラレータIP数に変更はない。XCCダイはアクセラレーター・クラスターで提供される:

- 4x DSA

- 4x QAT

- 4x DLB

- 4x IAA

MCCとEE-LCCのダイが控えている:

- 1x DSA

- 2x QAT

- 2x DLB

- 1x IAA

各アクセラレーターについては以下の通りだ:

DSA(Data Streaming Accelerator):メモリアクセスはコアを経由せず、部分的にアウトソースされる。これはデータ分析や分散ストレージ・サービスに有効だ。

QAT(Quick Assist Technology):QATは現在コアの一部となっており、データストリームの暗号化と圧縮を目的としている。ネットワーク・セキュア・ゲートウェイとコンテンツ・デリバリー・ネットワークが、QATの想定されるアプリケーションの2つである。

DLB(Dynamic Load Balancer):DLBは、負荷がそれほど高くないワークロードに対しても、より優れた負荷分散とコアの有効利用を保証する。QoSとして、パイプラインの特定のパケットを優先させることもできる。

IAA(In-Memory Advanced Analytics Accelerator):データはメモリから読み出され、メモリに書き込まれる。解凍と圧縮はIAAで行われ、そこからLLCに転送される。インメモリデータベース、データ分析、データベース全般がIAAの応用分野である。

また、コアにはAMX(Advanced Matrix Extensions)とAVX命令セット拡張があり、アクセラレーターはアクセラレーター・クラスターの一部として外部に接続されている。

よりスリムなパッケージで低レイテンシを実現

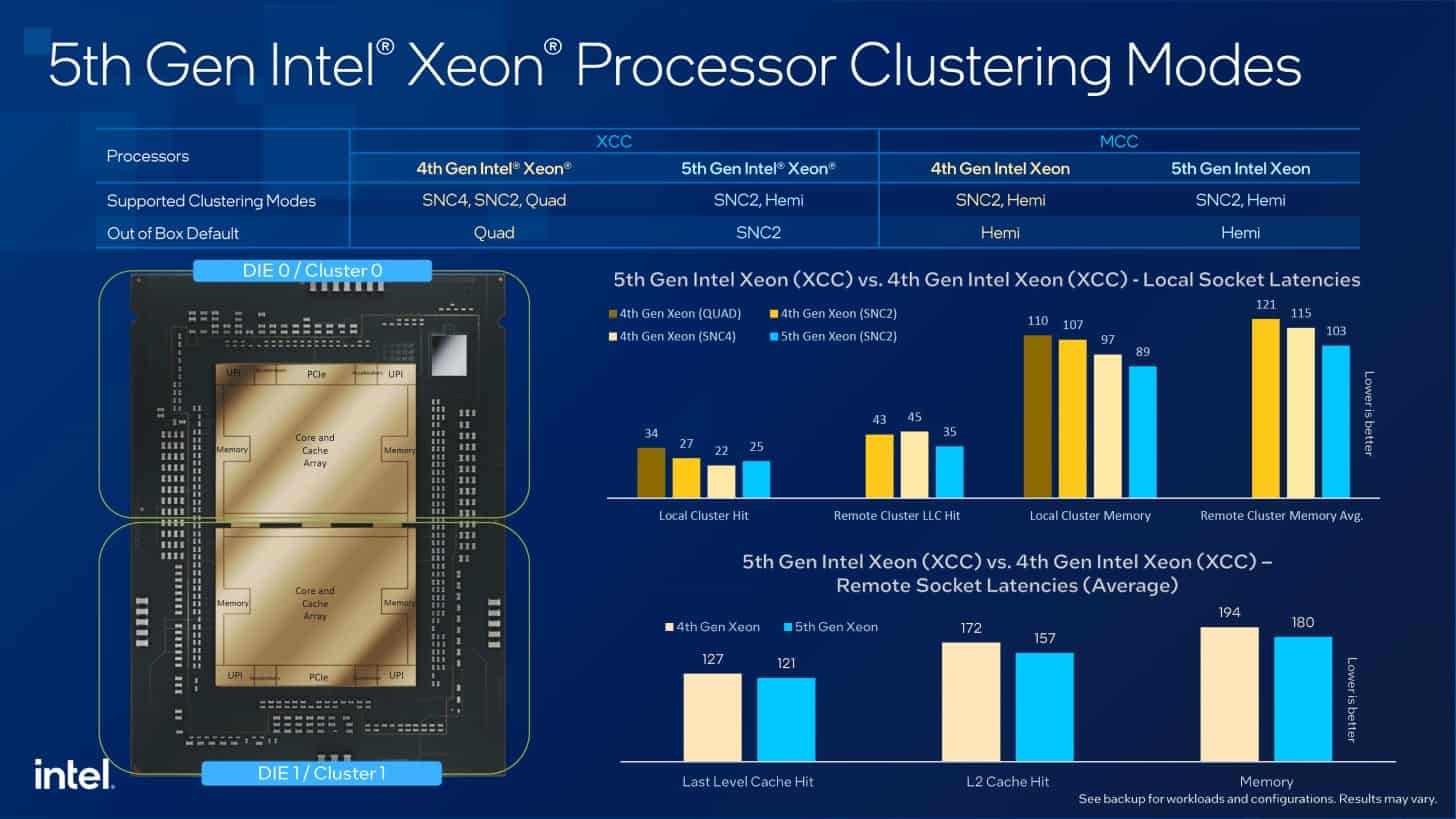

Sapphire Rapidsとしても知られる第4世代のXeonは、4つのXCCダイ(Extreme Core Count)または1つのMCCダイ(Medium Core Count)で構成されていた。Emerald Rapidsでは、Intelはパッケージを簡素化し、最大2個のXCCダイを使用するようになった。

XCCタイルあたり33個のコアがあり、そのうち最大32個がアクティブとなる。つまり、最もコア数の多いモデルは64コアということになる。互いにミラーリングされた南ダイと北ダイがある。2つのタイルは3つのEMIBインターフェイスを介して互いに接続されている。

MCCタイルは最大32コアで、技術的には34コアが利用可能である。しかし、ここでもIntelは生産をコントロールするために最大32コアを可能にしている。第5世代Xeonでは、IntelはEE LCC(Edge Enhanced Low Core Count)も復活させている。これは最大20コアを提供し、一部のモデルでのみ使用される。

Intelは、タイルのサイズに関する情報を提供していない。しかし、MCCダイについては、Intelは現在の最大サイズである約700mm²をほぼ完全に利用することは間違いないと推測される。

4タイルから2タイルへの削減は、たとえ個々のチップが大きくなったとしても、対応するモデルにとっていくつかの利点がある。これにより、チップ間の通信とデータ交換のレイテンシーが短縮される。また、LLCが大きくなることで、より高いヒット率が可能になり、その結果、データトラフィックが減少するため、より効率的になる。サブNUMAクラスタリングでは、IntelはすぐにSNC2を使用する。

部分負荷でより効率的に

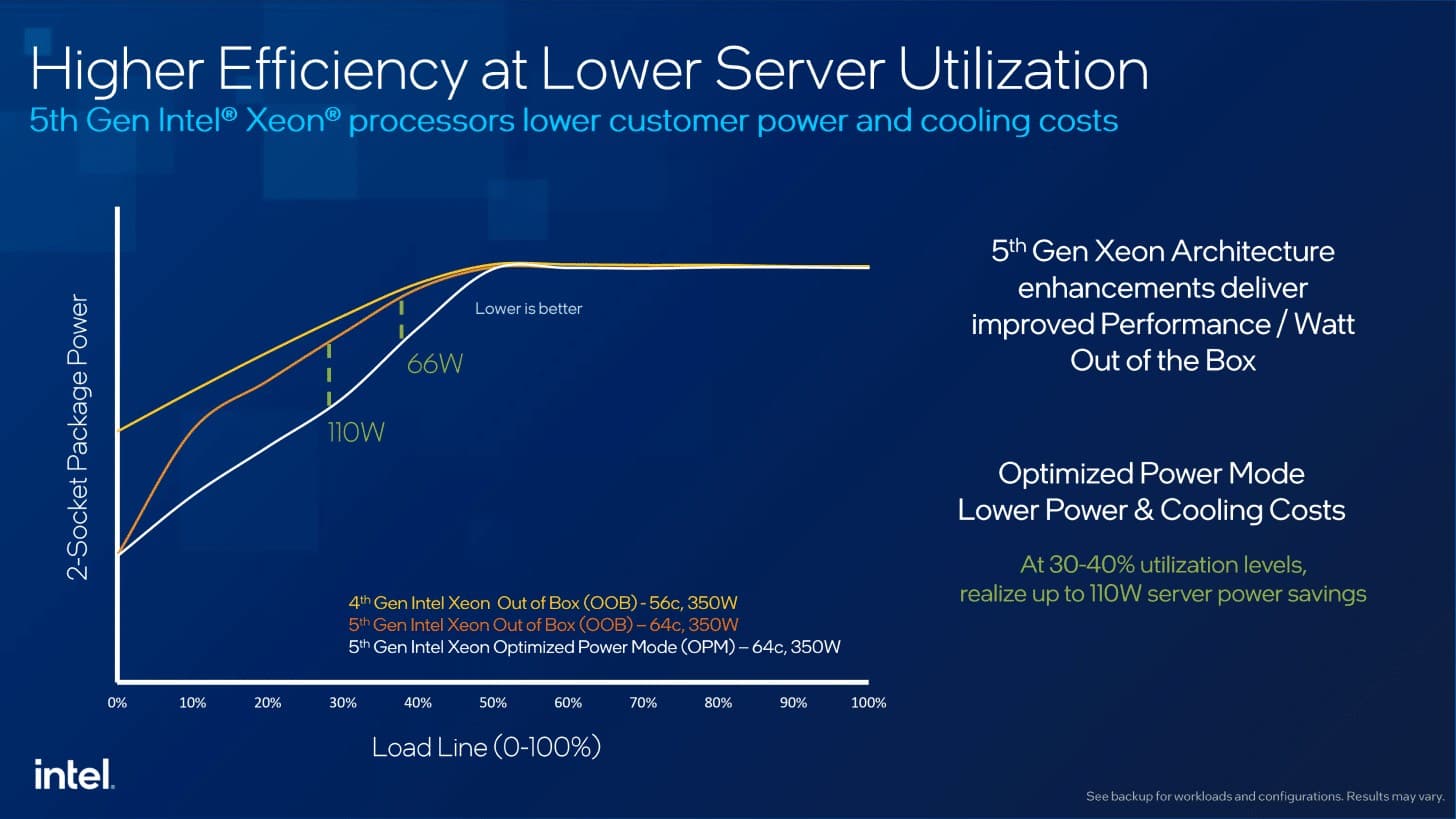

Intelはすでに第4世代XeonでOptimized Power Mode(OPM)を導入しており、これにより部分負荷時の消費電力を削減できる。Emerald Rapidsでは、IntelはOPMをさらに最適化し、50%負荷以下で消費電力を再び大幅に削減した。Intelは、この範囲とアイドル動作で最大110Wの節約になると述べている。

相互接続ソリューション、メッシュ、FIVR(完全統合型電圧レギュレーター)もさらに最適化されている。プロセッサーは動作点をより素早く変更できるようになり、その結果、より効率的に動作するようになるはずだ。

数百台、あるいは数千台のサーバーを擁するデータセンターでは、一見するとあまり効果がないように見えても、すぐにプラスの効果をもたらすことがある。もちろん、プロバイダーは可能な限りハードウェアを活用しようと努めており、アイドル状態のサーバーは多かれ少なかれ無駄な出費となる。

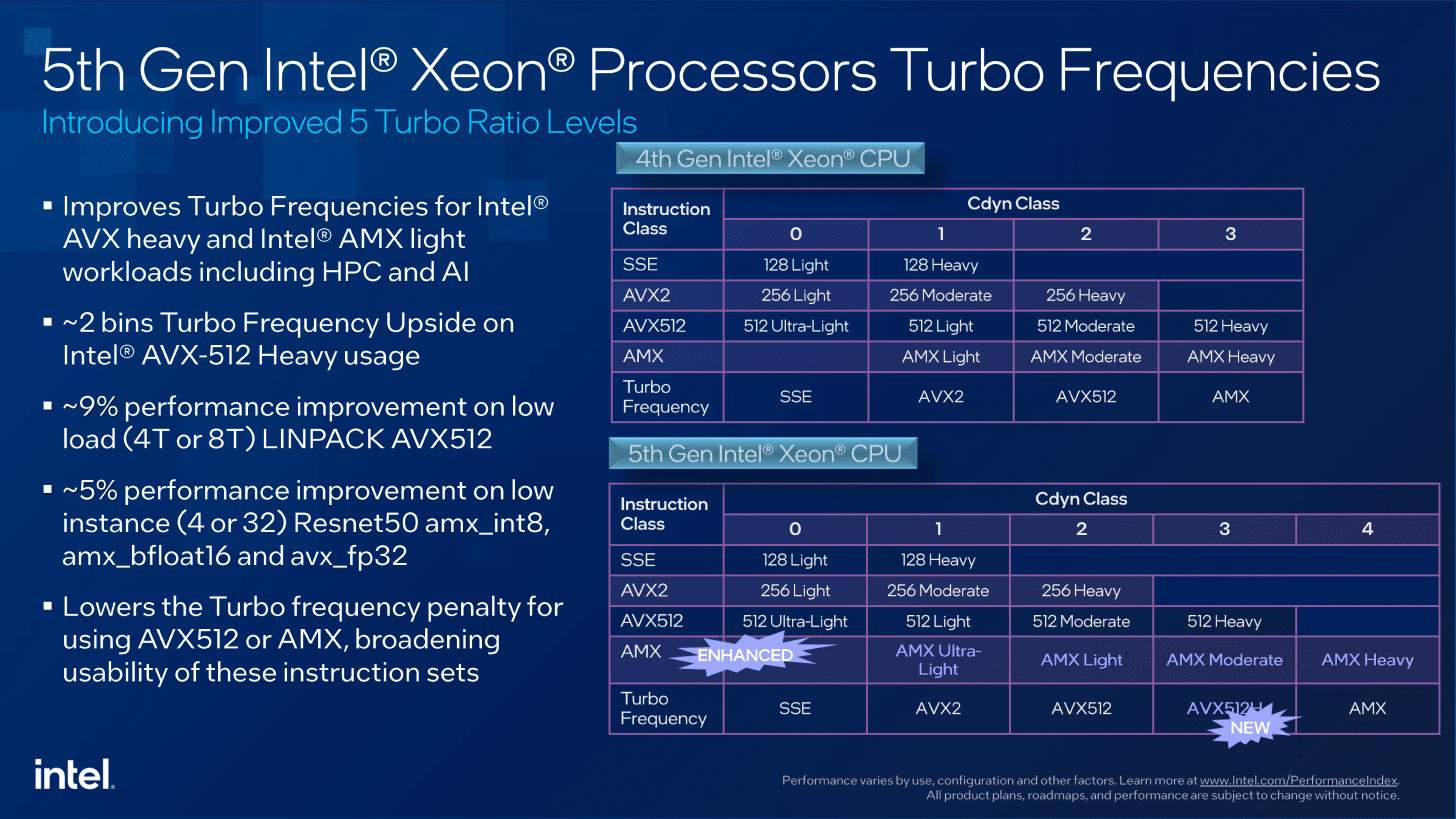

AVX512とAMXには、異なるクロックレートを達成する新しい負荷レベルがあります。これは一方ではピーク性能を向上させ、他方では効率化の可能性を提供する。

Intel独自の性能データ

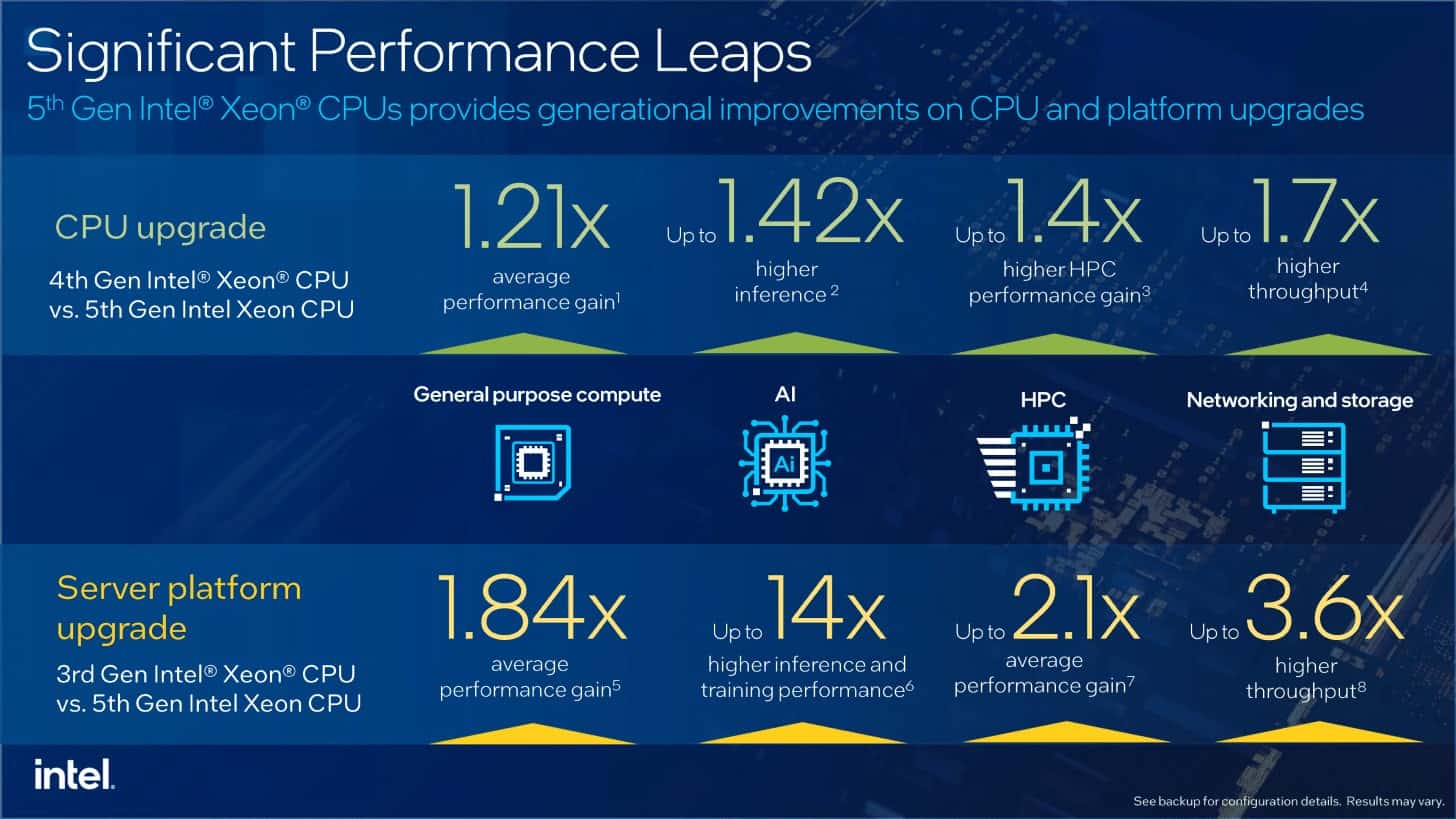

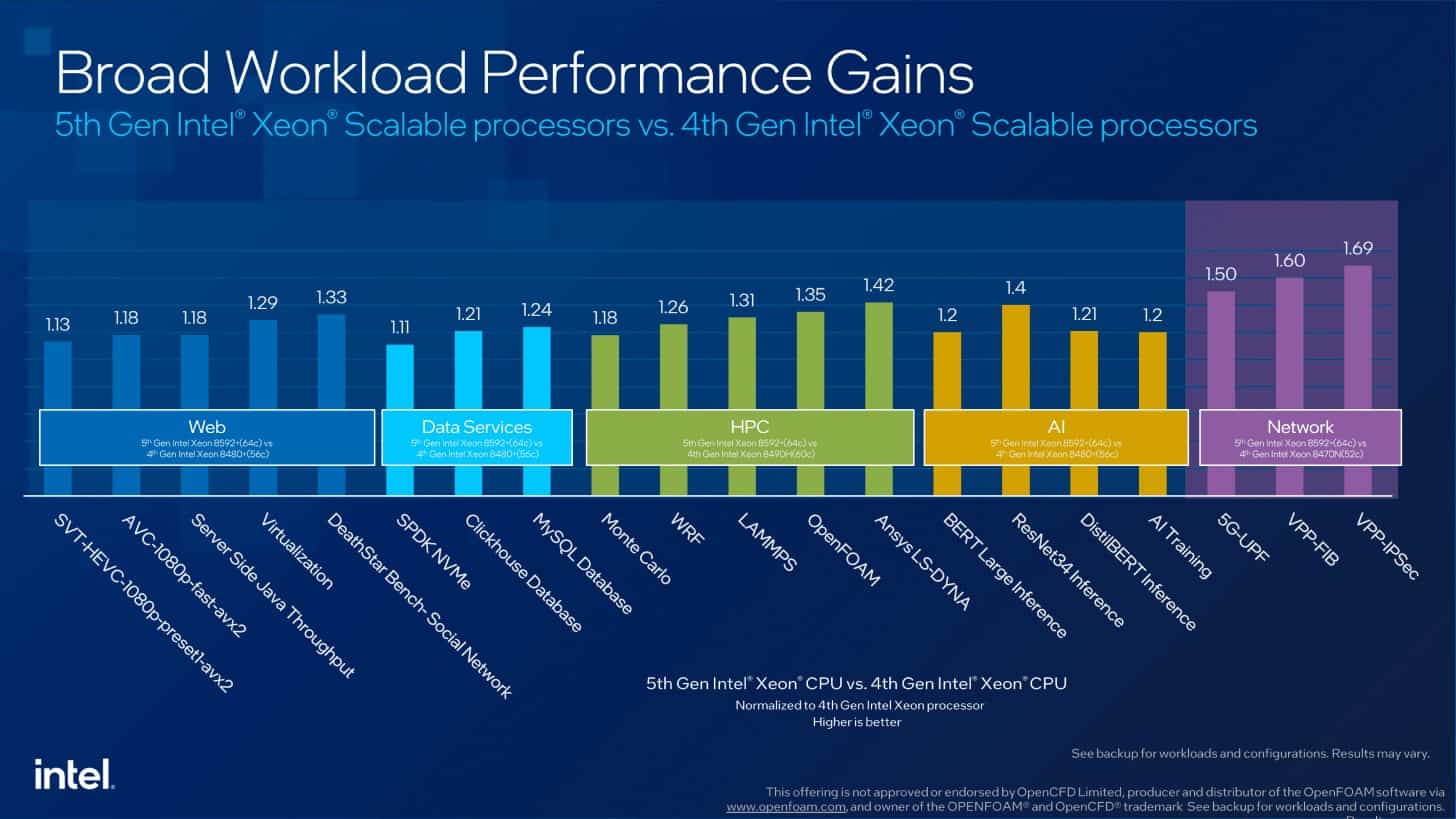

もちろん、Intelはベンチマークも公開している。これらのベンチマークは、第5世代Xeonを、その直接の前世代と、最もアップグレードの可能性が高い第3世代の両方と比較しています。Intelは、Sapphire Rapidsの56コアとEmerald Rapidsの64コア、そして第3世代Xeon(Ice Lake)の最大40コアを比較することが多い。

性能の向上はそれに応じて変化する。一方では、アーキテクチャの同時変更に伴うコア数の増加によって明らかになり、他方では、IntelはAIアプリケーション向けのAMXと第4世代以降の統合アクセラレータに注力している。

Intelは、Sapphire Rapidsと比較して、Emerald Rapidsプロセッサは汎用アプリケーションで21%の優位性があると見ている。HPCとAIアプリケーションでは、より大きなキャッシュにより約40%のメリットがある。Xeon第3世代まで遡れば、性能向上は80%以上となる。AMXの使用は、もちろん推論やAIアプリケーションで特に顕著だ。

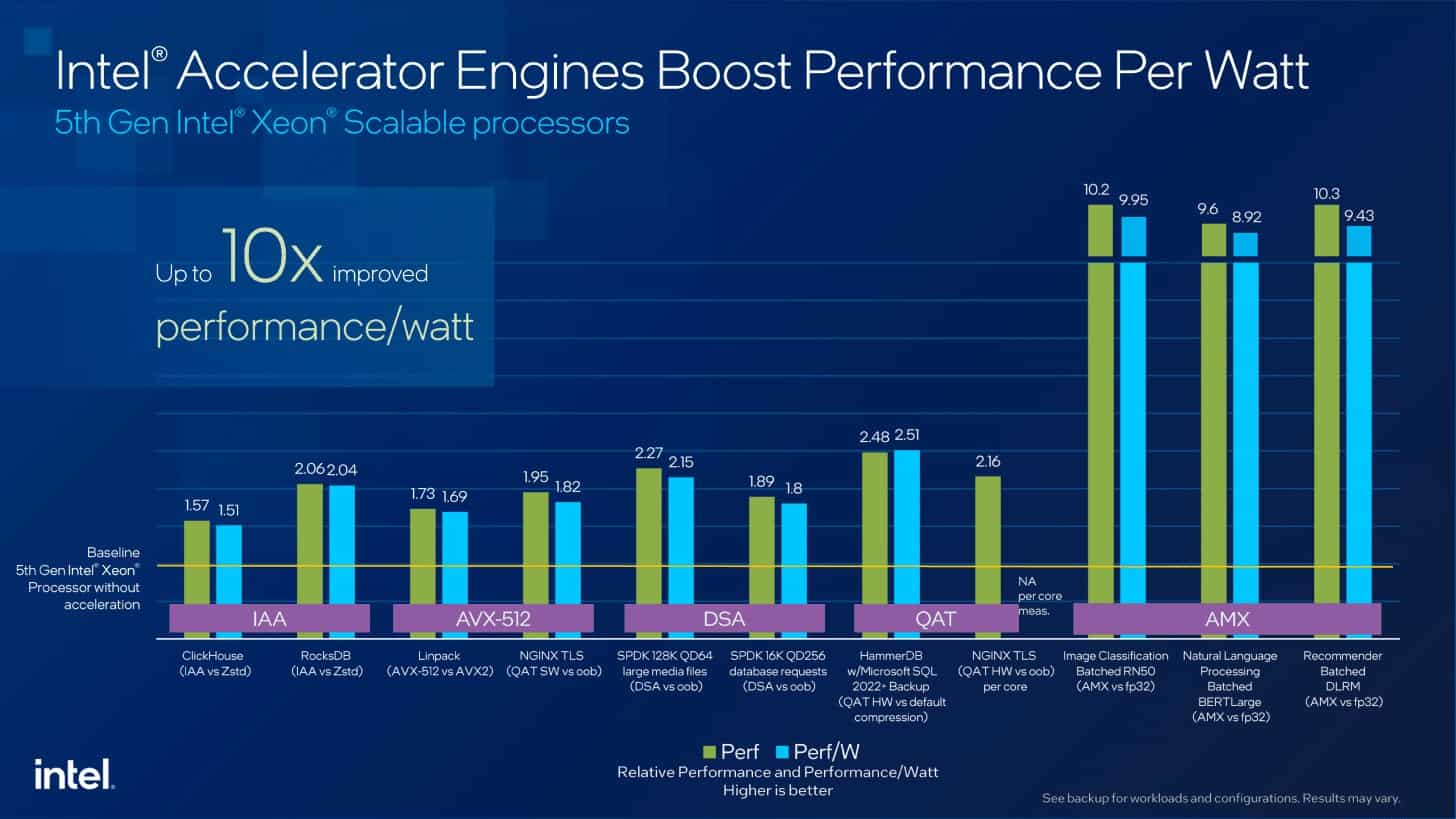

アクセラレーターだけに関して言えば、特定のアプリケーションでは、アクセラレーターを使わないアプリケーションに比べて2倍のパフォーマンスが想定できる。一方、Intelも、これを利用できるソフトウェアがより大規模に使われる状態になったのだろう。Granite Rapidsについては、Intelが再びアクセラレーターとその数を大幅に改善することが想定される。

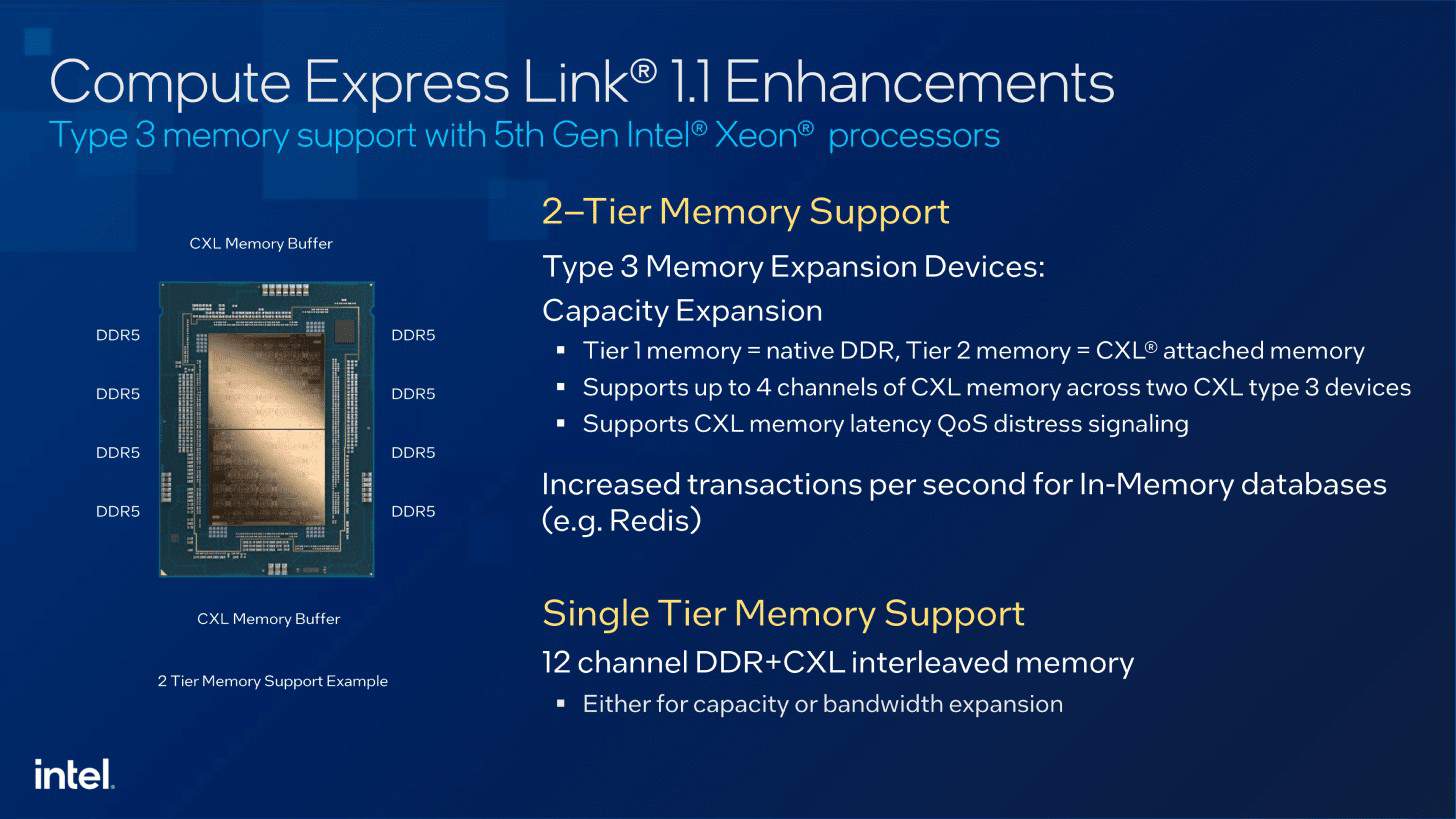

Compute Express Link 1.1

Compute Express Link、略してCXLは、徐々に速度を上げているようだ。AMDとIntelの両方がCXL 1.1をサポートしているが、全機能を網羅しているわけではない。CXLの物理的基盤はPCI Express 5.0である。

Emerald RapidsはSapphire Rapidsと同様にCXL 1.1をサポートしている。しかし、CXLハードウェアは進化しており、これはプロセッサも同様である。CXLは、CXL.memを介してメモリ拡張を可能にする。最大4つのデバイスがサポートされているが、Intelはスライドで4つのチャネルで2つのデバイスについて述べている。理論的には、1つのチャネルに1つのデバイスを接続することができるが、より高い帯域幅を必要とするため、通常は1つのデバイスにつき2つのチャネルが使用される。

CXLは、接続はDDR5メモリほど高速ではないが、メモリを大幅に拡張することが可能である。320MBのLLCと4TBのRAM、そしてCXLによるメモリ拡張。CXL 2.0 DRAMでは、Samsungはすでに128ギガバイトの対応ハードウェアを発表しており、35ギガバイト/秒を達成できるはずだ。

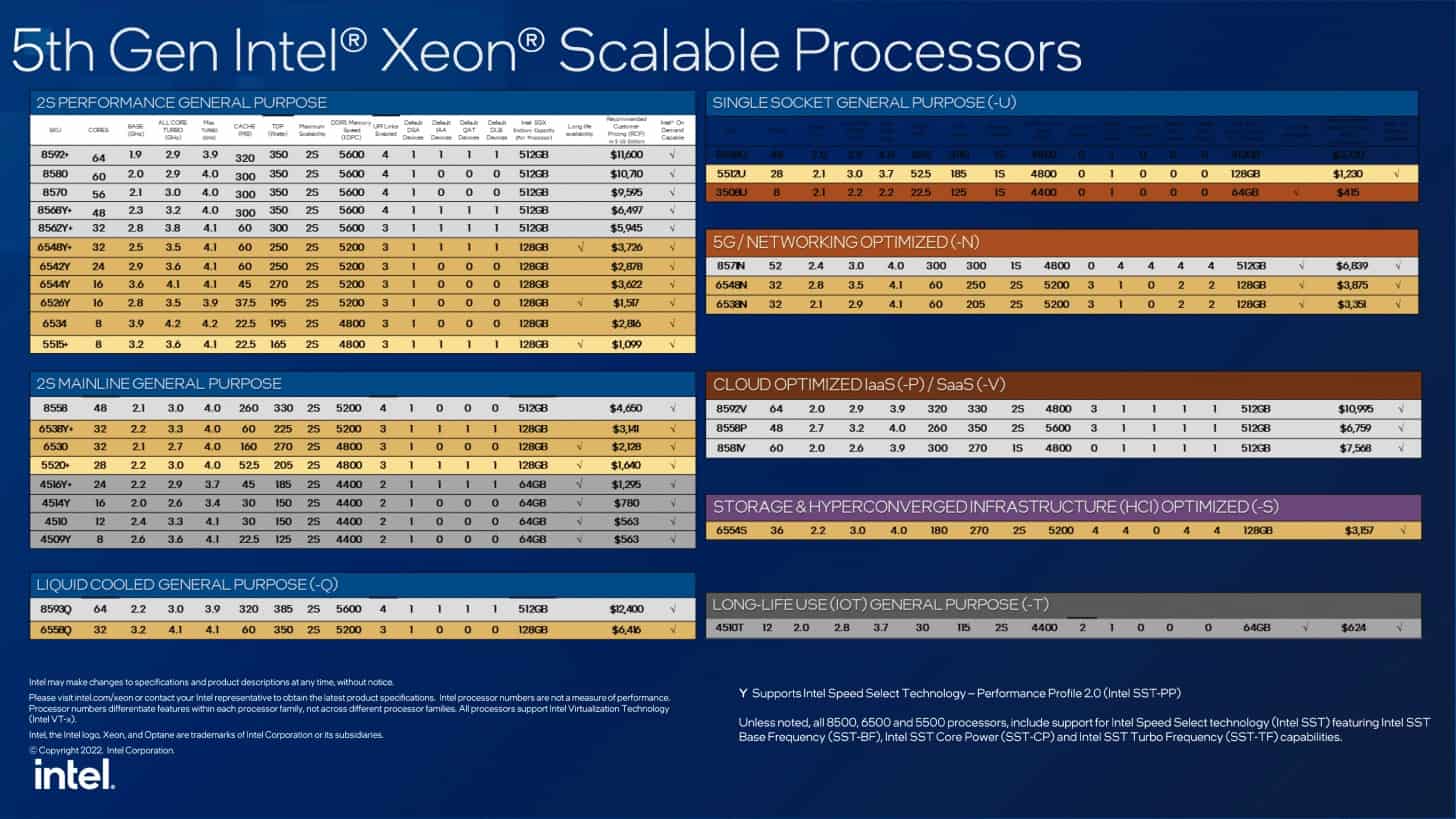

製品ファミリーのスリム化

Emerald Rapidsとしても知られる第5世代Xeonプロセッサーの製品群を見てみよう。以前と同様、Intelはこのシリーズで特定のアプリケーションに最適化されたモデルまたは完全なシリーズを提供している:

- クラウド:PおよびVシリーズ

- ネットワーク:Nシリーズ

- ストレージ: Sシリーズ

- 1ソケット: Uシリーズ

- 長寿命: Tシリーズ

- 水冷:Qシリーズ

しかし、すぐに目につくのは、4Sおよび8Sシステム用の第5世代Xeonプロセッサーのバリエーションがないことである。したがって、この顧客グループには第4世代が引き続き提供されることになる。

製品グループ内では、DDR5-5600がPlatinumシリーズの汎用プロセッサーでのみサポートされていることがまだ目立つ。ゴールドとブロンズでは、通常DDR5-5200からDDR5-4400までしか提供されない。これは第4世代のXeonではすでにそうでしたが、ここまでではなかった。そのため、対応するモデルを選択した場合のみ、より高いメモリ帯域幅の恩恵を受けることができる。

Emerald Rapidsプロセッサーの価格は若干高めだが、過剰ではない。64コアの最上位モデルは11,600米ドル。8コアの最小モデルはわずか415米ドルから購入できる。

また、すべてのモデルがTDX(Trust Domain Extensions)をサポートし、個々のVMを分離できるようになったことも特筆すべき点だ。これは、第4世代のXeonでは全モデルが対応していなかった。アクセラレーターの数はモデルによって異なる。オンデマンド・サービスによる予約は、引き続きOEMまたはSIを通じて提供される。Intelはインターフェイスを提供するだけである。プロバイダーが顧客に、提供するアクセラレーターがない、あるいは少なすぎるプロセッサー・モデルのサーバーを販売する場合、オンデマンドで追加することができる。つまり、このモデルでは何も変わらない。

第5世代Xeonプロセッサーが登場した。対応するサーバーは、主要なOEMやSIから入手可能である。主要なハイパースケーラはすでに対応プロセッサの使用を開始している。主要なクラウドプロバイダーにとって、Xeon世代間の移行はスムーズである。古いサーバーは一定期間後に製造中止となり、新しいサーバーにはEmerald Rapidsが搭載される。

Sources

コメントを残す