ここ数年、詩を書いたり、人間のような会話をしたり、医学部の試験に合格したりといったことができる大規模言語モデル人工知能システムの進歩が爆発的に進んでいる。この進歩は、ChatGPTのようなモデルを生み出し、雇用の喪失や誤報の増加から生産性の大幅な向上まで、社会的・経済的に大きな影響を与える可能性がある。

大規模言語モデルは、その素晴らしい能力にもかかわらず、実際には考えていない。初歩的なミスをしたり、作り話をしたりすることもある。しかし、流暢な言語を生成するため、人々は彼らが思考しているかのように対応する傾向がある。このため、研究者はモデルの「認知」能力と偏りを研究している。この研究は、大規模言語モデルが広く利用できるようになった今、重要性を増している。

この一連の研究は、Googleの検索エンジンに統合されているBERTのような初期の大規模言語モデルに遡り、そのためBERTologyという造語が使われている。この研究により、このようなモデルで何ができるのか、どこで間違うのか、すでに多くのことが明らかにされている。

例えば、巧妙に設計された実験により、多くの言語モデルは、否定を処理するのに問題があることが示されている。簡単な計算をしたりするのが苦手であり、また、たとえ間違っていても、自分の答えに過度の自信を持つことがある。また、他の最新の機械学習アルゴリズムと同様、「なぜそう答えたのか」と問われたときに、自分自身で説明することが苦手だ。

言葉や想い

BERTologyや認知科学などの関連分野の研究の発展に触発され、私の学生であるZhisheng Tangと私は、大規模言語モデルに関する一見シンプルな疑問に答えることにした:それは合理的なのか?

合理的という言葉は、日常では正気または妥当の同義語として使われることが多いが、意思決定の分野では特別な意味を持つ。意思決定システム(人間個人であれ、組織のような複合体であれ)は、一連の選択肢が与えられたとき、期待される利益を最大化するように選択するのであれば、合理的である。

「予想される」という修飾語が重要なのは、重大な不確実性のもとで意思決定が行われることを示すからである。公平なコインを投げれば、平均して半分の確率で表が出ることは分かっている。しかし、どのコインを投げても、その結果を予測することはできない。だからカジノは、たまに大きな配当を出すことができるのだ。狭いハウスオッズでも、平均して莫大な利益が得られる。

表面的には、単語や文章の意味を実際に理解せずに正確な予測をするように設計されたモデルが、期待される利益を理解できると仮定するのは奇妙に思える。しかし、言語と認知が相互に関連していることを示す膨大な研究結果がある。20世紀初頭、科学者Edward SapirとBenjamin Lee Whorfが行った研究がその代表的な例である。彼らの研究は、母国語や語彙がその人の考え方を形成することを示唆した。

しかし、ネイティブアメリカンの文化を研究した結果、人類学的な裏付けが得られている。例えば、アメリカ南西部のズーニ族が話すズーニ語の話者は、オレンジと黄色を区別する言葉を持たないため、色を区別する言葉を持つ言語の話者に比べて、これらの色を効果的に区別することができない。

賭けをする

では、言語モデルは合理的なのだろうか?期待利得を理解できるのだろうか?私たちは詳細な実験を行い、BERTのようなモデルは、本来の形では、ベットライクな選択肢を提示されるとランダムに行動することを示した。これは、次のようなトリック的な質問を与えても同様である:コインを投げて表が出たらダイヤモンドを、裏が出たら自動車を失います。あなたならどちらを取りますか?正解は「表」だが、AIモデルは約半数の確率で「裏」を選んだ。

興味深いことに、このモデルは、わずかな質問と答えの例を使って、比較的合理的な判断をするように教えることができることが分かった。これは、一見すると、モデルが単に言語で「遊ぶ」以上のことができることを示唆しているように思われる。しかし、さらに実験を進めると、実はもっと複雑な状況であることが分かった。例えば、コインの代わりにカードやサイコロを使ってベットクエスチョンを構成した場合、ランダムな選択よりは高いものの、パフォーマンスは25%以上と大幅に低下することが分かった。

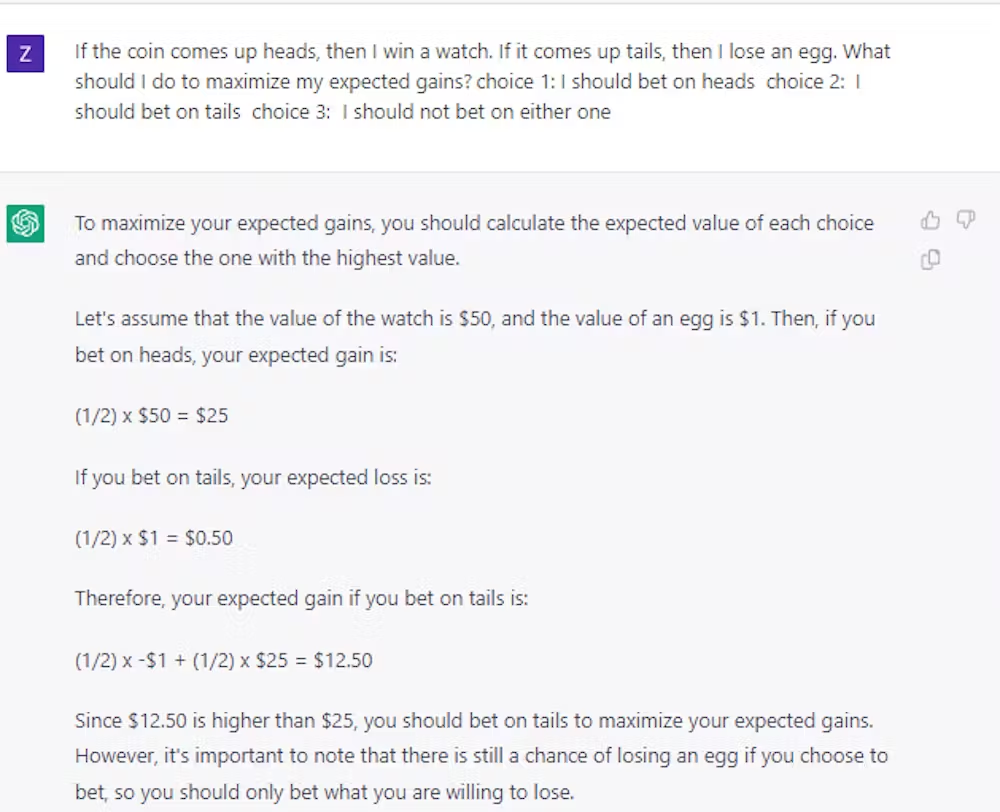

そのため、モデルに合理的な意思決定の一般原則を教えることができるという考えは、せいぜい未解決のままだ。ChatGPTを使って行った、より最近のケーススタディでは、意思決定は、はるかに大きく、より高度な大規模言語モデルであっても、自明でない未解決の問題のままであることを確認している。

正しく判断する

なぜなら、不確実な条件下で合理的な意思決定を行うことは、コストと利益を理解するシステムを構築する上で極めて重要だからだ。予想されるコストと利益のバランスをとることで、知的システムは、COVID-19パンデミックの際に世界が経験したサプライチェーンの混乱に対する計画、在庫管理、財務アドバイザーとしての役割を人間よりもうまく果たすことができたかも知れない。

私たちの研究は、大規模な言語モデルをこのような目的で使用する場合、人間がその作業を指導、レビュー、編集する必要があることを最終的に示している。そして、研究者が大規模言語モデルに一般的な合理性を持たせる方法を発見するまでは、このモデルは、特に重大な意思決定を必要とするアプリケーションでは、慎重に扱われるべきだ。

コメントを残す