新たな研究で、人間の脳活動から得られた信号をAIに処理させることにより、「高品質」なビデオを再構築する事に成功した事が報告された。この研究は、シンガポール国立大学と香港中文大学の共同で行われ、研究チームは、fMRIデータと、テキストから画像を生成するAIモデル、Stable Diffusionを使用して、脳波からビデオを生成するモデル「MinD-Video」を作成し、それによって実現している。

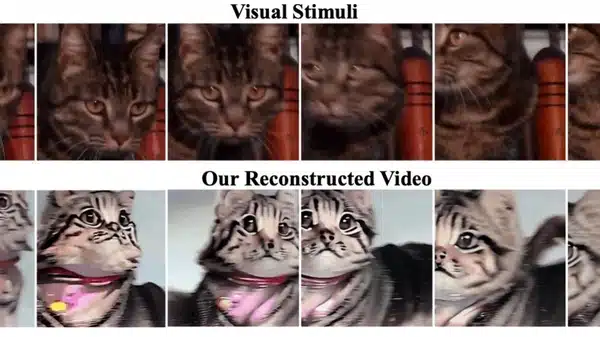

この研究では、被験者に示されたビデオとその脳活動に基づいてAIが生成したビデオとの間に高度な類似性が見られた。両者の違いは小さく、大部分は同じ主題と色彩で再現されていた。

MinD-Videoは、画像とビデオの脳デコーディングのギャップを埋めるために設計された「二つのモジュールパイプライン」として定義されている。システムの訓練には、ビデオとそれを視聴した被験者のfMRI脳波を含む公開データセットが使用された。

研究者たちは、この技術が神経科学から脳-コンピュータインターフェースまで、大規模なモデルが開発されるにつれて有望な応用があるとしている。特に、彼らはこれらの結果が三つの主要な発見を明らかにしたと述べている。一つは視覚皮質の優位性で、これは脳の一部が視覚知覚の主要な成分であることを示している。また、fMRIエンコーダは階層的に動作し、構造情報から始まり、より深い層でより抽象的で視覚的な特徴に移行すること。最後に、fMRIエンコーダは学習ステージごとに進化し、訓練が進むにつれてより微妙な情報を取り込む能力を示していることを発見した。

この研究は、AIを使用して人々の心を読むという分野のさらなる進歩を示している。以前、大阪大学の研究者たちは、fMRIデータとStable Diffusionを使用した技術で、脳活動から高解像度の画像を再構築できることを発見していた。

今回の新しい研究では、Stable Diffusionのモデルを拡張することで、より正確な可視化が可能になった。「GANなどの他の生成モデルに対する我々の安定拡散モデルの重要な利点の1つは、より高品質な動画を生成する能力にあります。fMRIエンコーダーが学習した表現を活用し、独自の拡散プロセスを利用することで、優れた品質であるだけでなく、元の神経活動との整合性がより高い動画を生成します」と、研究者は記している。

論文

参考文献

- Mind-Video

- via Motherboard: AI Reconstructs ‘High-Quality’ Video Directly from Brain Readings in Study

研究の要旨

脳活動から人間の視覚を復元することは、人間の認知過程を理解する上で魅力的な課題である。近年の研究では、非侵襲的な脳記録から静止画像を復元することに大きな成功を収めているが、動画という形で連続的な視覚体験を復元する研究は限られている。本研究では、大脳皮質の連続的なfMRIデータから時空間情報を学習するMind-Videoを提案し、マスクされた脳モデリング、時空間注意によるマルチモーダル対照学習、ネットワークの時間インフレを組み込んだ拡張安定拡散モデルとの協調学習を通じて、漸進的に学習する。敵対的ガイダンスを用いたMind-Videoにより、任意のフレームレートの高品質な動画を再構築できることを示す。復元された動画は、様々な意味的・画素レベルのメトリクスで評価された。我々は、意味的分類タスクにおいて平均85%の精度を達成し、構造的類似性指数(SSIM)において0.19を達成し、以前の最先端技術を45%上回った。また、本モデルが生物学的に妥当であり、確立された生理学的プロセスを反映した解釈可能なものであることも示している。

コメントを残す