OpenAIのDALL-E 3は、前モデルよりもクオリティの高い画像を生成する事に加えて、1つの大きな進化が注目された。それが、「ユーザーの入力したプロンプトを格段に正確に理解し、適切な画像を出力する性能を有している」という点だ。OpenAIはこれにより、DALL-E 3では複雑なプロンプトエンジニアリングの必要性を軽減する事に繋がると述べていたが、同社は今回、なぜDALL-E 3が従来の画像生成AIと比べてそうしたことが可能になったのか、DALL-E 3に関する論文を発表し、その理由を詳しく説明している。

DALL-E 3の論文の焦点は、「なぜDALL-E 3が既存のシステムと比較してプロンプトに正確に従うことができるのか」だが、これは論文のタイトルにその全てが端的に著されている。タイトルは、「Improving Image Generation with Better Captions:(より良いキャプションによる画像生成の改善)」だ。

DALL-E 3の実際のトレーニングに先立ち、OpenAIは独自のAI画像ラベラーをトレーニングし、それを実際のDALL-E 3画像システムのトレーニング用画像データセットの再ラベリングに使用したという。再ラベリングの過程で、OpenAIは特に詳細な説明に注意を払った。

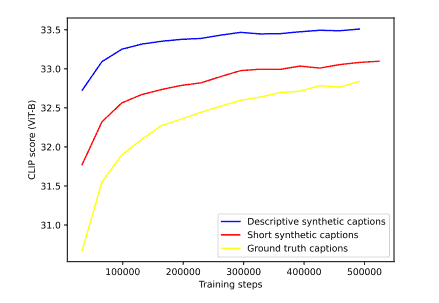

DALL-E 3のトレーニングの前に、OpenAIは実験的に3つの注釈タイプ(人間、短い合成、詳細な合成)で3つの画像モデルを訓練した。

短い合成注釈でさえ、ベンチマークでは人間の注釈を大幅に上回った。長い記述的注釈はさらに良い結果を出した。

OpenAIはまた、異なる合成注釈と人間の注釈スタイルをミックスして実験した。しかし、機械的注釈の割合が高いほど、画像生成はより良くなった。例えば、DALL-E 3には95パーセントの機械的注釈と5パーセントの人間による注釈が含まれている。

プロンプトの理解:DALL-E 3はMidjourney 5.2やStable Diffusion XLを上回っている

OpenAI は、DALL-E 3 のプロンプト理解の精度を、合成ベンチマークと人間のテスターでテストした。すべての合成ベンチマークにおいて、DALL-E 3 は、ほとんどのケースで、その前身である DALL-E 2 と Stable Diffusion XL を大幅に上回っている。

より関連性があるのは、プロンプトへの追従性、スタイル、一貫性の各次元における人間の評価である。特に、プロンプトの追従性については、Midjourneyと比較して、明らかにDALL-E 3が有利な結果となっている。

しかし、OpenAIの新しい画像AIは、スタイルと一貫性という点でもMidjourney 5.2よりかなり良いパフォーマンスを示しており、オープンソースの画像AI Stable Diffusion XLはさらに遅れをとっている。OpenAIによると、DALL-E 3は空間内のオブジェクトの位置(左、右、後ろなど)にまだ問題がある。

OpenAI は脚注で、画像ラベリングの革新は、DALL-E 3 の新機能の一部に過ぎず、DALL-E 2 よりも “多くの改善点”があると指摘している。OpenAI は、DALL-E 3 のその他の改良点については、論文で触れていない。

論文