OpenAIは、本日開催した初の開発者会議「OpenAI DevDay」で「GPT-4 Turbo」をはじめとした同社の基幹モデルに関する多くの発表を行った。開発者は、GPT-4をより低価格で利用でき、多くの新しいAPI機能を使う事が出来る様になる。

新しいGPT-4 Turboモデルは現在、OpenAI API経由でプレビューとして利用可能で、ChatGPTでも直接利用できるようになっている。OpenAIのCEOであるSam Altman氏によると、GPT-4 Turboは “より速く”、”よりスマート”になっているとのことだ。

また、GPT-4 Turboモデルは2023年4月時点の最新の知識を備えた物となっている事が明かされた。比較すると、オリジナルのChatGPTは2021年9月までしか知識がなかった。Altman氏は、OpenAIは今後もっと定期的にモデルを更新する予定だと述べた。

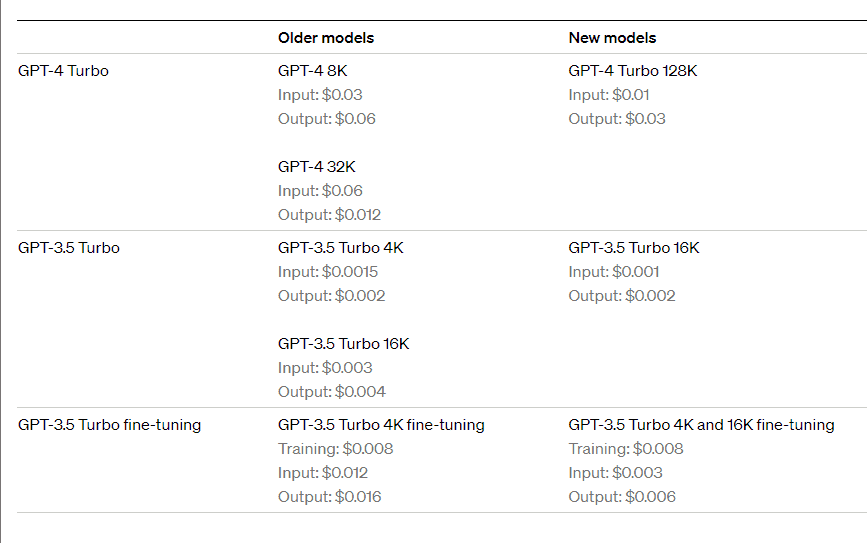

開発者にとっての最大の目玉は、GPT-4 Turboの大幅な値下げだろう。Turboの入力トークン(テキスト処理)は3分の1になり、出力トークン(テキスト生成)は半額になった。新しいTurboモデルは、入力トークンが1000トークンあたりGPT-4の0.03ドルに対して0.01ドルに、出力トークンがGPT-4の0.06ドルに対して0.03ドルとなっている。また、コンテキスト・ウィンドウが4倍大きい(後述)にもかかわらず、GPT-4 32Kよりもはるかに安価だ。

また、OpenAIはGPT-4 Turbo APIを拡張し、画像処理、DALL-E 3との統合、音声合成を行うことが可能になった「gpt-4-vision-preview」モデルを発表した。これにより画像を分析して生成し、テキストから人間のような音声を作成することができるようになる。

さらに、実験的なGPT-4チューニングプログラムと、大規模な独自データセットを持つ組織向けのカスタムモデルプログラムにも取り組んでいることが発表された。GPT-3.5の微調整は16Kモデルに拡張される予定だ。

GPT-4のコンテキスト・ウィンドウが拡大

おそらく最も重要な技術的変更は、いわゆるコンテキスト・ウィンドウの拡大だろう。すなわちGPT-4 Turboが一度に処理でき、出力を生成する際に考慮できる単語の数が大幅に増加している。以前は、コンテキスト・ウィンドウは最大32,000トークンだったが、新たなGPT-4 Turboは128,000トークンと4倍に拡大している。

Altman氏によれば、これは標準的な書籍で最大10万語、300ページに相当するという。彼はまた、128K-GPT-4 Turboモデルは、全体的なコンテキストの点で、「はるかに正確だ」と述べた。

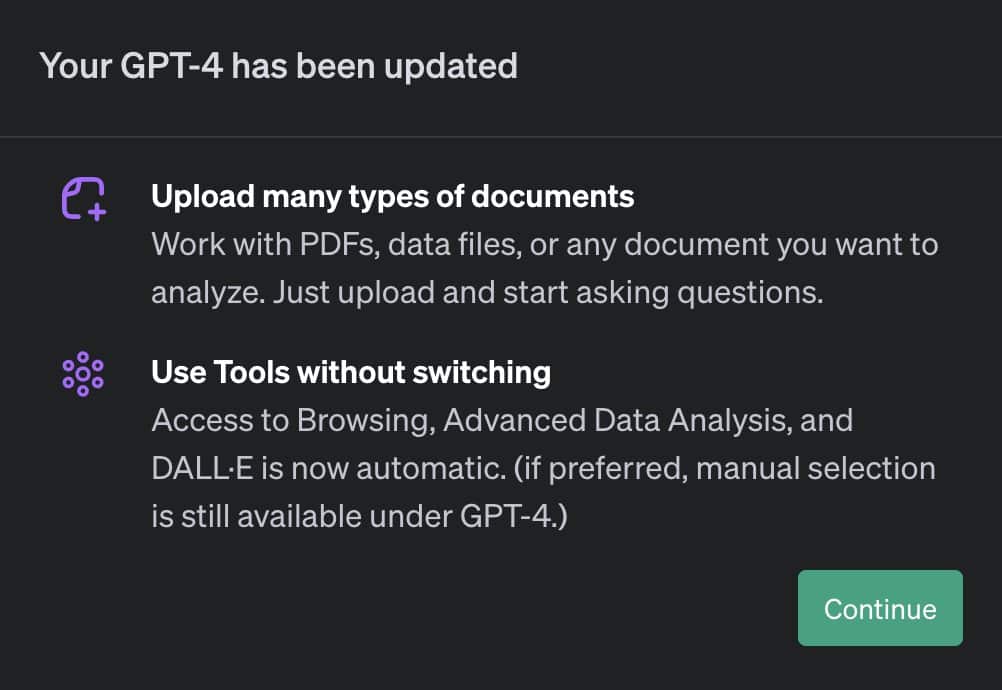

また、既に一部のユーザーでは有効になっていたGPT-4 Allモデルの存在も明らかにした。これによりChatGPTは、ユーザーの要求に応じて、プログラムコード(Advanced Data Analysis)や画像生成(DALL-E 3)の異なるGPTモデルを自動的に切り替えてくれる。以前は、ユーザーはデータを入力する前に適切なモデルを手動で選択する必要があったため大きな進歩だ。

Assistants APIと著作権保護

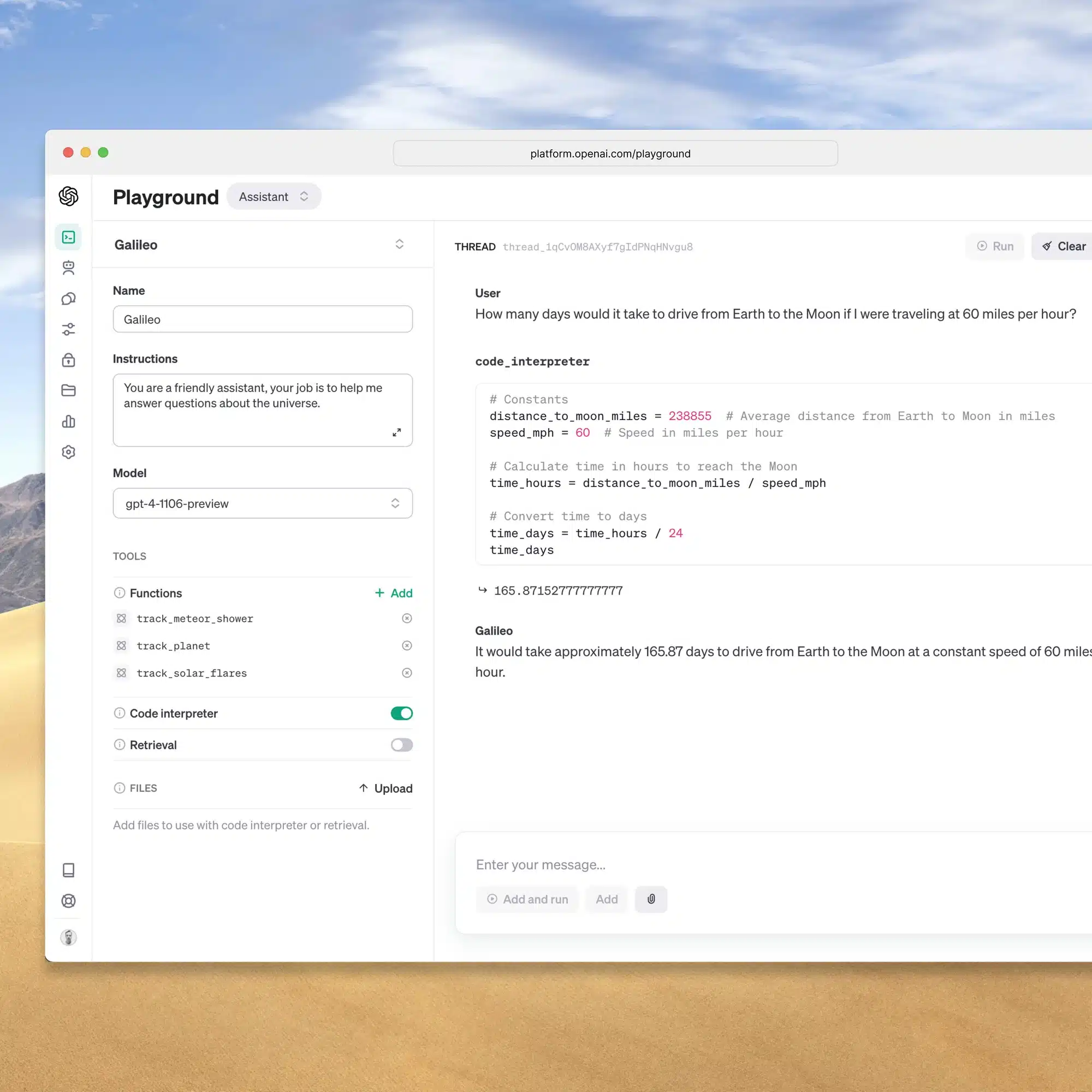

OpenAIはまた、開発者が支援AI機能をアプリケーションに統合するのを支援するAssistants APIを発表した。このAPIは永続スレッドと無限スレッドを可能にし、開発者はコンテキスト・ウィンドウの制限を克服することができる。

アシスタントは、区画化された環境でPythonコードを書き込み実行するCode Interpreter、外部の知識でアシスタントを豊かにするRetrieval、アシスタントがカスタム関数を呼び出すことを可能にするFunction Callなどの新しいツールにアクセスできる。

Assistants APIは、OpenAIのGPT製品と同じ機能に基づいている。開発者はコードを書くことなく、Assistants PlaygroundでAssistants APIベータ版を試すことができる。ベータ版は既に利用可能だ。

Altman氏によると、アシスタントは本格的なAIエージェントへの第一歩であり、将来的には新たな機能を追加する予定だという。

もうひとつの新サービスは「著作権保護」で、OpenAIのモデルを使って生成されたコンテンツの著作権侵害に関する法的請求から顧客を守り、その代金を支払う。この保護は、ChatGPT Enterpriseと開発者プラットフォームの一般公開されている機能に適用される。

以下のビデオで基調講演の全容を見ることができる。

Source

コメントを残す