ロサンゼルスで開催されたSIGGRAPHで、NVIDIAは、「GH200 Grace Hopper Superchip」の新たなバリエーションとして、HBM3eメモリを搭載した世界初のGPUチップを発表した。世界で最も複雑な生成AIワークロードを処理するために設計されたNVIDIA GH200プラットフォームは、アクセラレーテッド・コンピューティングの限界を押し広げるように設計されている。NVIDIAは、GPU分野での強みとCPU分野での取り組みを拡大することで、競争が激しく複雑なハイパフォーマンス・コンピューティング(HPC)市場を制覇するための半統合設計を実現しようとしている。

NVIDIAの現行のGH200 Grace Hopper Superchipは、96GBのHBM3メモリを搭載しており、帯域幅は4TB/秒未満である。対照的に、新モデルはメモリ容量を約50%増やし、帯域幅を25%以上向上させた。

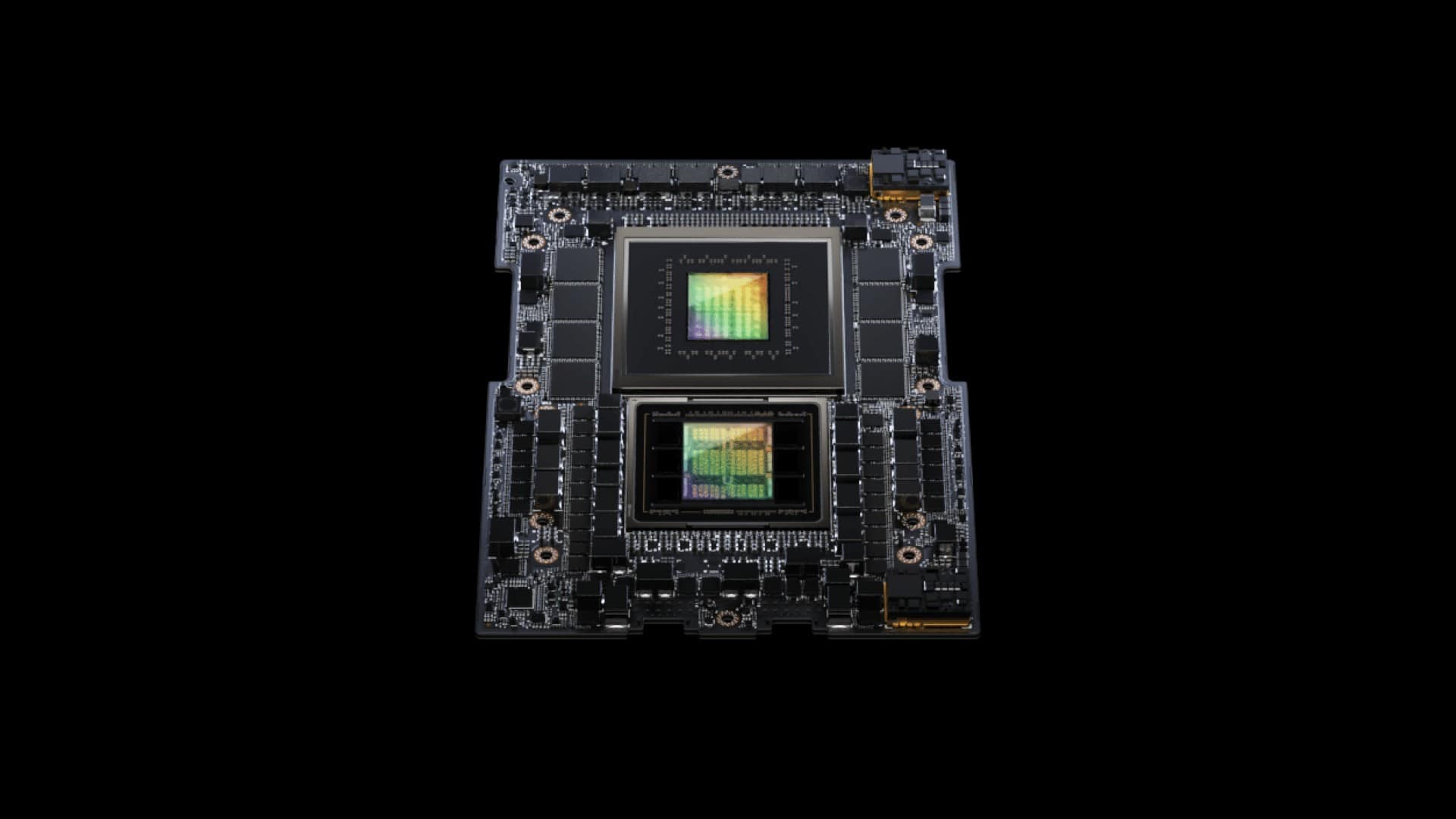

新しいGH200 Grace Hopper Superchipは、480GBのECC LPDDR5Xメモリを搭載した72コアのGrace CPUと、6つの24GBスタックで構成され、6,144ビットのメモリインターフェイスを使用する141GBのHBM3Eメモリと組み合わせたGH100コンピュートGPUをベースにしている。NVIDIAは物理的に144GBのメモリを搭載しているが、歩留まりを向上させるためにアクセスできるのは141GBのみである。

このような大規模な改良により、新プラットフォームは、オリジナルバージョンよりも大規模なAIモデルを実行することが可能になり、目に見えるパフォーマンス向上(これはトレーニングにおいて特に重要になる)を実現する。

SIGGRAPH2023の基調講演で、NVIDIAの社長兼CEOのJensen Huang氏は、「生成AIへの急増する需要に応えるために、データセンターは、特化したニーズを持つ高速化されたコンピューティングプラットフォームを必要としています。新しいGH200 Grace Hopper Superchipプラットフォームは、スループットを向上させるための卓越したメモリ技術と帯域幅、妥協することなくパフォーマンスを集約するためのGPU接続機能、データセンター全体に容易に展開できるサーバー設計により、これを実現します」と、述べている。

おそらくNVIDIAが共有する最も注目すべき詳細の1つは、HBM3e搭載の次期GPU GH200が、Computexで発表されたNVIDIA MGXサーバー仕様と「完全」互換であるということだ。これにより、システムメーカーは、展開可能な100以上の異なるバリエーションのサーバーを持つことができ、迅速かつ費用対効果の高いアップグレード方法を提供するように設計されている。

NVIDIAは、HBM3eを搭載したGH200 GPUは、現在のHBM3メモリよりも最大50%高速なメモリ性能を提供し、最大10TB/秒の帯域幅を実現し、チップあたり最大5TB/秒を実現すると主張している。

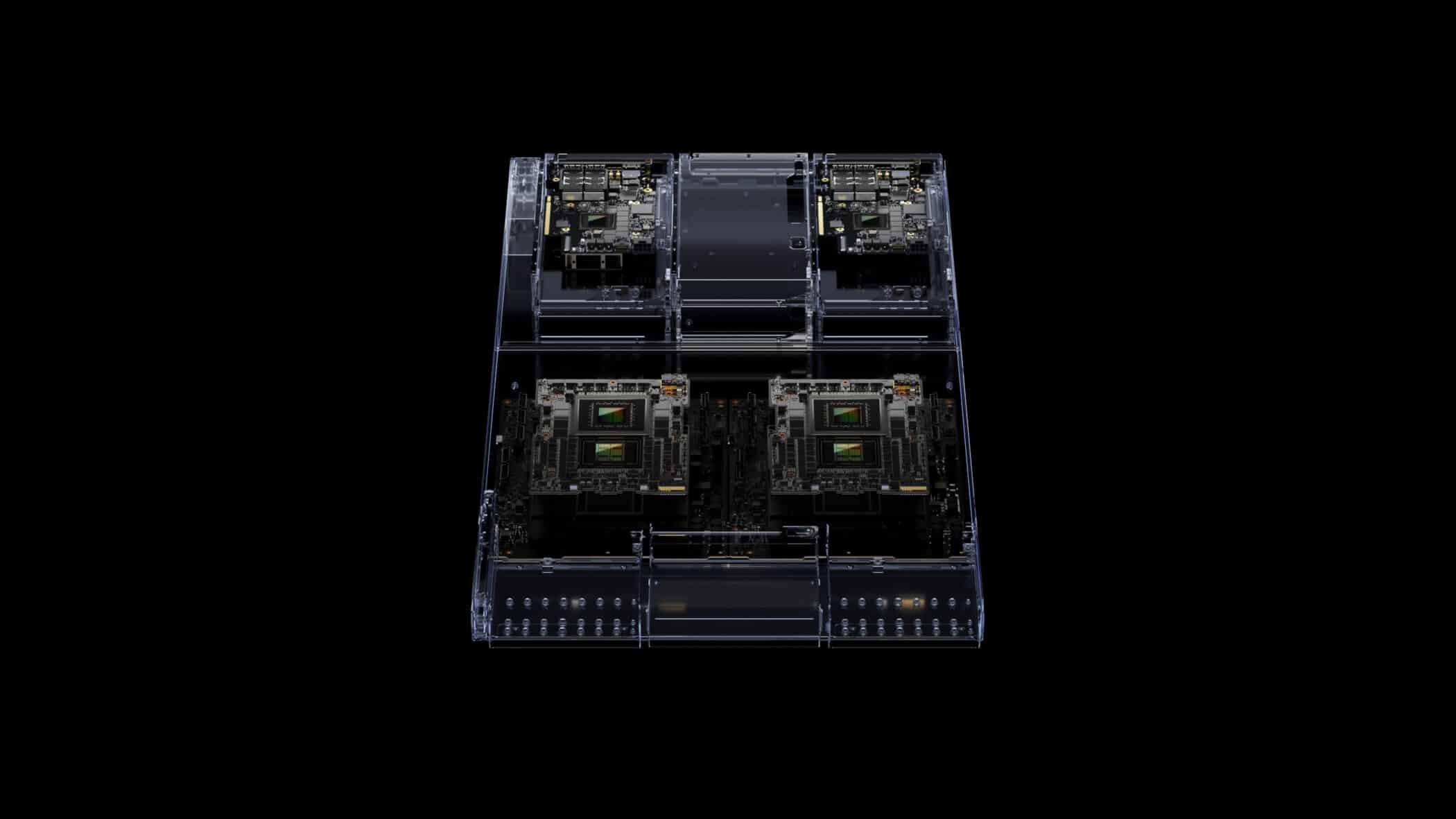

NVIDIAのGrace Hopperプラットフォームをベースに構築されたAIスーパーコンピュータ「DGX GH200」の発表については、すでに取り上げた。DGX GH200は、NVIDIAのアーキテクチャで完全に構築された24ラックのクラスタで、1台のDGX GH200が256個のチップを組み合わせ、120TBのCPU接続メモリを提供している。これらはNVIDIAのNVLinkを使用して接続されており、最大96個のローカルL1スイッチにより、GH200ブレード間で即時かつ瞬時の通信が可能だ。NVIDIAのNVLinkは、高速でコヒーレントな相互接続により、GH200のCPUメモリへのフルアクセスを可能にし、デュアル構成時には最大1.2TBのメモリへのアクセスを可能にする。

NVIDIAは、主要なシステムメーカーが2024年第2四半期にHBM3eメモリを搭載したGH200ベースのシステムを提供する予定であるとしている。また、HBM3メモリを搭載したGH200は、現在フル生産中であり、今年末までに発売される予定である。HBM3eメモリを搭載したGH200については、今後数ヶ月のうちにNVIDIAからさらに多くの情報が得られるだろう。

Sources

コメントを残す