本日、MetaとMicrosoftが生成AIアプリやサービス向けの大規模言語モデル(LLM)の次世代バージョンであるLlama 2を発表したが、Metaは、更にこのLlama 2をモバイルデバイスで駆動させるために、Qualcommと新たなパートナーシップを締結したことを発表した。これにより、Qualcomm Snapdragonチップを搭載したモバイル・デバイスで最新のLLMが使用できるようになるのだ。

Qualcommはプレスリリースの中で、今回のパートナーシップの目的は、ChatGPTやBingチャットボットといった現在の生成AI製品が使用しているようなクラウドベースのサービスに接続することなく、手元のデバイスだけでLlama 2ベースのアプリやサービスを実行できるようにすることだと述べている。

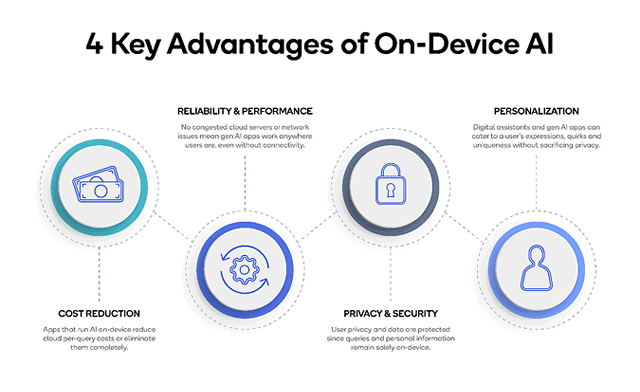

OpenAIのChatGPTを運営するために「目玉が飛び出る程の金額」がサーバー維持に使われていることを考えると、このアプローチには企業にとって大きな意味を持つが、ユーザーにとっても大きな意味を持つ。デバイス上で処理が完結するLLMならば、オンラインでの情報漏洩などの懸念のない、プライベートでより信頼性の高い、パーソナライズされた体験が期待できるだろう。また、オンラインサービスに接続する必要がないためパフォーマンスも向上する。

Qualcommは2024年中に、Snapdragonチップを使用するデバイスでLlama 2ベースのAIサービスのサポートを開始する予定だ。Qualcommの最新世代のチップが必要なのか、あるいは現行のSnapdragonチップとの後方互換性を確保できるのかについては、まだ明らかになっていない。

Metaによると、Llama 2は第一世代のLlama LLMよりも40%多いデータで学習されたという。同社はすでにMicrosoftとの提携を発表しており、Llama 2をAzureサービス上で商用および研究ユーザー向けに無料で提供するほか、Windows PC上でLLMをローカルにダウンロードして実行する方法も提供している。

Sources

コメントを残す