NVIDIAは、OpenAIのGPT-4ような大規模言語モデル(LLM)専用に設計されたHopper GPUの新しいバリエーションである、「H100 NVL」を発表した。

H100 NVLは、時流を適切に捉え、NVIDIAのAI分野での更なる成功を実現するために、大規模言語モデル(LLM)での利用という単一の市場を対象としている。このカードがNVIDIAの通常のサーバー向け製品とは異なるのは、すでにブリッジ接続された2枚のH100 PCIeボードであることもさることながら、大きな特徴として、大きなメモリ容量が挙げられる。このデュアルGPUカードは、188GBのHBM3メモリ(カードあたり94GB)を提供し、H100ファミリーの中だけでなく、これまでのどのNVIDIA製品よりもGPUあたりのメモリ容量が多くなっている。

| H100 NVL | H100 PCIe | H100 SXM | |

|---|---|---|---|

| FP32 CUDAコア数 | 2 x 16896? | 14592 | 16896 |

| Tensorコア数 | 2 x 528? | 456 | 528 |

| ブーストクロック | 1.98GHz? | 1.75GHz | 1.98GHz |

| メモリ周波数 | ~5.1Gbps HBM3 | 3.2Gbps HBM2e | 5.23Gbps HBM3 |

| メモリバス幅 | 6144-bit | 5120-bit | 5120-bit |

| メモリ帯域幅 | 2 x 3.9TB/sec | 2TB/sec | 3.35TB/sec |

| VRAM | 2 x 94GB (188GB) | 80GB | 80GB |

| FP32 Vector | 2 x 67 TFLOPS? | 51 TFLOPS | 67 TFLOPS |

| FP64 Vector | 2 x 34 TFLOPS? | 26 TFLOPS | 34 TFLOPS |

| INT8 Tensor | 2 x 1980 TOPS | 1513 TOPS | 1980 TOPS |

| FP16 Tensor | 2 x 990 TFLOPS | 756 TFLOPS | 990 TFLOPS |

| TF32 Tensor | 2 x 495 TFLOPS | 378 TFLOPS | 495 TFLOPS |

| FP64 Tensor | 2 x 67 TFLOPS? | 51 TFLOPS | 67 TFLOPS |

| インターコネクト | NVLink 4 18 Links (900GB/sec) | NVLink 4 (600GB/sec) | NVLink 4 18 Links (900GB/sec) |

| GPU | 2 x GH100 (814mm2) | GH100 (814mm2) | GH100 (814mm2) |

| トランジスタ数 | 800億 × 2 | 800億 | 800億 |

| TDP | 700W | 350W | 700-800W |

| 製造プロセス | TSMC 4N | TSMC 4N | TSMC 4N |

| インターフェース | 2 x PCIe 5.0 (Quad Slot) | PCIe 5.0 (Dual Slot) | SXM5 |

| アーキテクチャ | Hopper | Hopper | Hopper |

このSKUの提供は、まさにChatGPTの爆発的ヒットや、その後のBing、Bardの登場によるAI需要の急増を見据えたものだろう。GPTファミリーのような大規模言語モデルは、多くの点でメモリ容量に制約があり、すべてのパラメータ(最大のGPT-3モデルの場合、175B)を保持するために、H100アクセラレータでさえすぐにいっぱいになってしまうからだ。その結果、NVIDIAは、GPUあたり80GBを上限とする通常のH100パーツよりも、GPUあたりでもう少し多くのメモリを提供する新しいH100 SKUを用意したのだ。

すべてのGH100 GPUには、6スタックのHBMメモリ(HBM2eまたはHBM3)が搭載されており、1スタックあたり16GBの容量がある。しかし、歩留まりの関係で、NVIDIAは6つのHBMスタックのうち5つを有効にした状態で通常のH100パーツを出荷するだけだ。したがって、各GPUには公称96GBのVRAMが搭載されているが、通常のSKUでは80GBしか使用出来ない。

H100 NVLは、6つのスタックすべてが有効化された特別なSKUとなる。6番目のHBMスタックをオンにすることで、NVIDIAは、それがもたらす追加メモリと追加メモリ帯域幅にアクセスすることが出来る。価格もそれに伴い高額になるが、LLM市場の活況を考えれば、ほぼ完璧なGH100パッケージに対して十分に高いプレミアムを支払ってでも手に入れようとする需要はあるだろう。

ただし、1枚のカードで96GBをすべて利用できるわけではない。むしろ、総容量188GBのメモリでは、カード1枚あたり実質94GBを利用できることになる。NVIDIAは、本日の基調講演に先立つ事前説明会で、この設計上の癖について詳しく説明していないが、これも歩留まりを考慮して、HBM3メモリスタック内の不良セル(またはレイヤー)を無効にするためにNVIDIAに多少の余裕を持たせているものと思われる。その結果、新しいSKUは、GH100 GPUあたり14GBのメモリを提供し、17.5%のメモリ増加を実現した。一方、このカードの総メモリ帯域幅は7.8TB/秒であり、個々のボードでは3.9TB/秒になる。

メモリ容量の増加に加えて、多くの点で、より大きなデュアルGPU/デュアルカードH100 NVL内の個々のカードは、PCIeカードに配置されたH100のSXM5バージョンによく似ている。通常のH100 PCIeは、より低速なHBM2eメモリの使用、より少ないアクティブSM/テンソルコアの使用、およびより低いクロックスピードによって、いくらか足かせとなっているが、NVIDIAがH100 NVLについて提示しているTensorコア性能値は、すべてH100 SXM5と同等で、このカードが通常のPCIeカードのようにさらに削減されていないことを表している。この製品の最終的な完全な仕様はまだ決まっていないが、ここで提示されたものがすべてだとすると、H100 NVLに搭載されるGH100は、現在入手可能なGH100の中で最も高いビンディングを持つことになる。

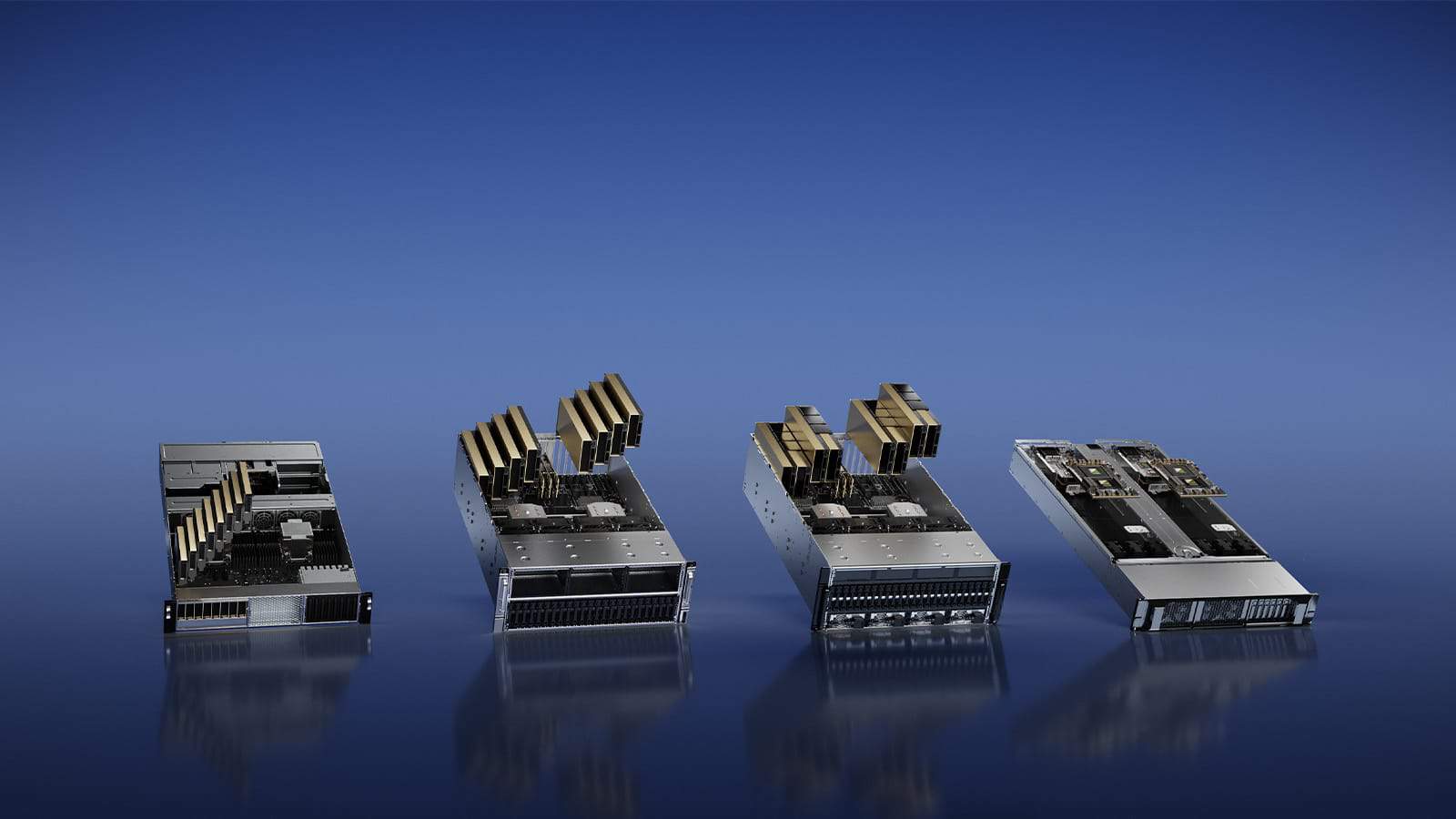

H100 NVLはシングルGPUパーツではなく、むしろデュアルGPU/デュアルカードパーツであり、ホストシステムにはそのように提示される。ハードウェア自体は、2つのPCIeフォームファクターH100をベースにしており、3つのNVLink 4ブリッジを使用して一緒に縛られている。物理的には、NVIDIAの既存のH100 PCIeデザイン(NVLinkブリッジを使用してすでにペアリング可能)とほぼ同じであるため、違いは2ボード/4スロットという巨大な構造ではなく、むしろ内部のシリコンの品質にある。別の言い方をすれば、今日、通常のH100 PCieカードを組み合わせることが出来るが、H100 NVLのメモリ帯域幅、メモリ容量、テンソルスループットには敵わないだろう。

驚くべきことに、大きなスペックアップにもかかわらず、TDPの上昇は少ない。H100 NVLは700Wから800Wのパーツで、ボードあたり350Wから400Wとなり、その下限は通常のH100 PCIeと同じTDPとなる。この場合、NVIDIAはピーク性能よりも互換性を優先しているように見える。350W以上(400W以上)のPCIeカードを扱えるサーバー・シャーシはほとんどなく、TDPを維持する必要があることを意味する。それでも、より高い性能数値とメモリ帯域幅を考えると、NVIDIAがどのように余分な性能を負担しているのかは不明だ。

それ以外の点では、本質的に最高のH100バリエーションをリリースするというNVIDIAの決定は、SXMパーツに対する一般的な好みからすると異例の選択だが、LLM顧客のニーズという文脈では理にかなっている決定と言えるだろう。大規模なSXMベースのH100クラスタは、8GPUまで簡単にスケールアップできるが、2つのGPU間で利用できるNVLinkバンド幅は、NVSwitchを経由する必要があるため、制約がある。2GPUの構成であれば、1組のPCIeカードを組み合わせる方がはるかに直接的で、固定リンクによってカード間の帯域幅は600GB/秒が保証されるだろう。

しかし、それ以上に重要なのは、既存のインフラにH100 NVLを迅速に導入できることだ。GPUをペアリングするために特別に作られたH100 HGXキャリアボードをインストールする必要があるのではなく、LLMの顧客は、新しいサーバー構築にH100 NVLを放り込むか、既存のサーバー構築の比較的早いアップグレードとして、H100 NVLを使用出来る。NVIDIAは、ここでは非常に特殊な市場を狙っているので、SXMの通常の利点(およびNVIDIAが総力を挙げて取り組む能力)は、ここでは適用されないかも知れない。

全体として、NVIDIAは、H100 NVLが、前世代のHGX A100の12倍のGPT3-175B推論スループットを提供すると宣伝している(H100 NVL 8個対A100 8個)。LLMワークロード用にシステムをできるだけ早く導入し、スケールアップしたいと考えている顧客にとっては、魅力的なことであることは間違いないだろう。しかし、H100 NVLは、最速のPCIe H100オプションであり、最大のGPUメモリプールを持つオプションとして、特定のニッチに貢献することになるだろう。

最後に、NVIDIAによると、H100 NVLカードは今年の後半に出荷が開始される予定だ。同社は価格を提示していないが、実質的にGH100のトップモデルであることから、最高値で取引されることが予想される。特に、LLMの爆発的な普及が、サーバーGPU市場の新たなゴールドラッシュとなりつつあることを考えれば、なおさらだ。

Source

コメントを残す