Googleは、いずれGoogle検索に登場するChatGPTの競合であるBardを発表して以来、デモンストレーションにおいて、このチャットボットが間違った回答を示したことから批判され、株価が急落するなど散々な目に遭った。未だ登場していないBardとは異なり、MicrosoftのBingには早速ChatGPTを元にした独自のチャットボットが搭載され、多くのユーザーが早く使いたいと殺到しているが、こちらも完璧に動作するわけではないようだ。Microsoftのデモを詳しく分析してみると、多くの間違いが見つかったという。

独立系AI研究者のDmitri Brereton氏によると、Microsoftは、Bingの公開デモでいくつかのミスを犯しているとのことだ。例えば、ペットの掃除機の賛否を偽ったり、バーやレストランの説明をでっち上げたり、事実と異なる財務データを回答として報告したりと、しばしば独自の情報を作り上げていたという。

具体的には、ペットの毛の掃除機について調べるというデモが行われた。Brereton氏によると、Bingは選んだ機種の1つについて、「音が大きく、コードが短い」と説明していた。しかし、Bingが引用した情報源では、静かでコードレスであるとなっている。また、メキシコ旅行の計画を支援する際、Bingはナイトライフを楽しむための場所をいくつか提案したが、推奨されたバーのいくつかに、実際には何百もレビューがあるにもかかわらず、レビューがないと述べている。また、ゲイバーであることを伏せて人気のあるバーが推薦されていた。

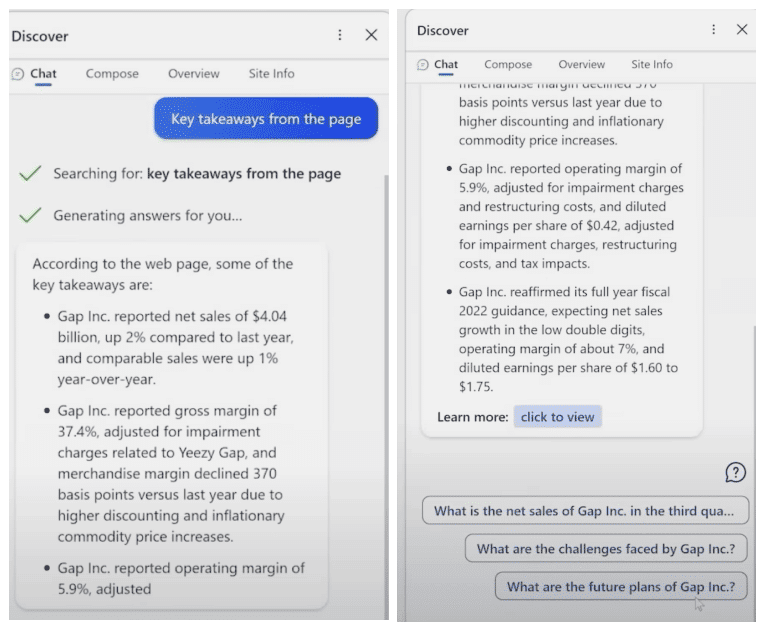

だが、これよりもさらに問題なのは、PDFの要約の方だ。デモでは、MicrosoftがBingに、Gapの2022年第3四半期の財務報告書から得られる情報を生成するよう依頼した。ここでBingは、いくつかの数字をでっち上げているのだ。たとえば、営業利益率が5.9%であるとしているが、この数字は文書のどこにも出てこない。GapとLululemonのデータを比較するように言われると、さらに悪いことに、Bingは全く根拠のない数字を作りだし、全くのデマを吐き出したという。

こういったことがすぐに明らかにならなかったのは、Gapの財務状況がどうなっているのか、すべてを把握しており、画面に一瞬だけ映った内容から判断できるような人がいなかったため、これまで指摘を免れた訳だ。しかし、これらの回答は、GoogleがBardにおいて、ジェイムズ・ウェッブ宇宙望遠鏡について質問され、有名な失敗を犯したのと同様に明らかな間違いである。

チャットボットを搭載した新しいBingは、少数のテスターに提供され始めている。だが、このデモが示すとおり、新しいBingが信じるに値するものになるには、もっと多くのテストが必要だろう。

Source

コメントを残す