Microsoftは、与えられた3秒間の音声サンプルから、そこに録音されている人の声を忠実にシミュレートできる新しい音声合成AIモデル「VALL-E」を発表した。このVALL-Eは、一度特定の音声を学習すれば、その後はその人が何かを話す音声を忠実に合成し、しかも話し手の感情のトーンまで再現できるという。まさに、ディープフェイクに打って付けの技術なのだ。

ただし、やはりそのことを懸念してか、MicrosoftはVALL-Eのコードは公開しておらず、我々がVALL-Eの機能をテストすることはできない。研究者たちは、この技術がもたらす社会的弊害の可能性を認識しているようで、論文の結論として、彼らはこう書いている。

「VALL-Eは話者の同一性を保ったまま音声を合成できるため、音声識別の偽装や特定の話者へのなりすましなど、モデルの誤用による潜在的なリスクを抱え込む可能性があります。そうしたリスクを軽減するために、音声クリップがVALL-Eで合成されたものかどうかを判別する検出モデルを構築することが可能です。また、モデルのさらなる開発にあたっては、Microsoft AI Principlesを実践していく予定です。」

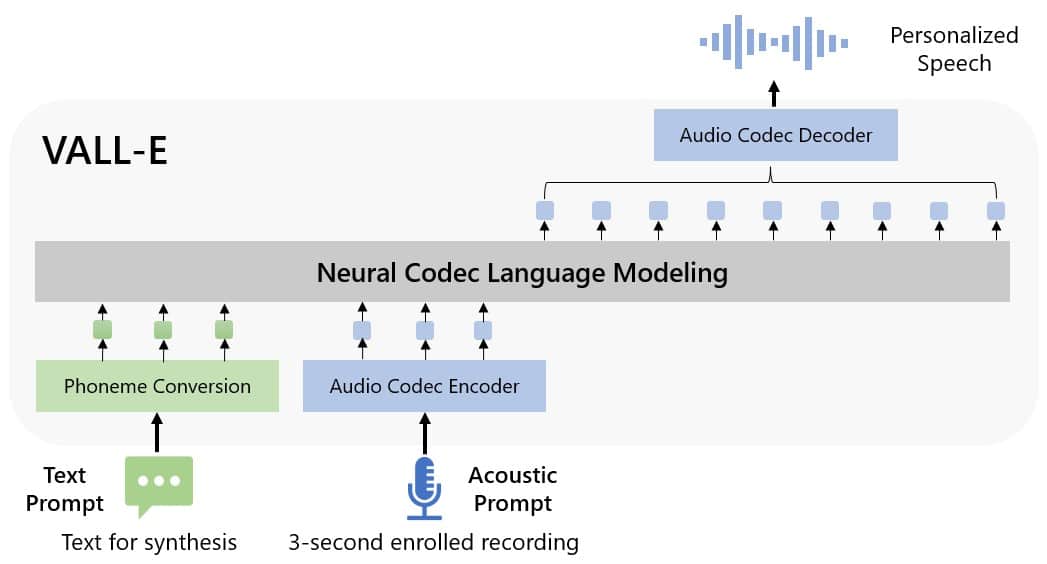

MicrosoftはVALL-Eを「ニューラルコーデック言語モデル」と呼んでいるが、これはMetaが2022年10月に発表したEnCodecという技術をベースにしている。一般的に波形を操作して音声を合成する他の音声合成手法とは異なり、VALL-Eはテキストと音響プロンプトから個別の音声コーデックコードを生成する。基本的には「人の声を分析し、その情報をEnCodecによって『トークン』と呼ばれる個別の要素に分解し、学習データを使って、その声が3秒間のサンプル以外のフレーズを話した場合にどう聞こえるかを『知っている』ものに一致させる」と、VALL-Eの論文では説明されている。

Microsoftは、VALL-Eの音声合成機能を、Metaが作成したLibriLightという音声ライブラリで学習させている。LibriVoxのパブリックドメインオーディオブックを中心に、7,000人以上の話者による6万時間に及ぶ英語の音声が収録されている。そのため、提供される3秒間のサンプルの音声がトレーニングデータの音声に近いものであればある程、VALL-Eは良い結果をもたらしてくれる。

Microsoftは、VALL-Eのサンプルサイトにおいて、AIモデルが動作する際の音声サンプルを数十種類提供している。サンプルの表記はそれぞれ、「Speaker Prompt」は、VALL-E が模倣する必要がある元データとなる3 秒間の音声を示す。「Ground Truth」は、同じ話者が比較目的で特定のフレーズを発声した既存の録音だ 。そして「BaseLine」は従来の音声合成方式による合成例であり、「VALL-E」サンプルはVALL-Eモデルからの出力である。

実際に、それぞれを聞き比べてみると、VALL-Eの結果には、コンピュータが生成したように聞こえる物もあるが、実際に人間の音声にしか聞こえないような精巧なものもあるから驚きだ。

VALL-Eは、話者の声の音色や感情表現を再現するだけでなく、サンプル音声の「音響環境」を模倣することも可能だという。例えば、サンプル音声が電話の音声であった場合、合成された音声出力は電話の音響特性や周波数特性をシミュレートまでして、まるで受話器越しに話しているような音声まで再現出来るとのことだ。また、サンプル(「多様性の合成」セクション)では、VALL-Eが生成プロセスで使用するランダムシードを変更することで、声色のバリエーションを無数に生成できることが示されている。

VALL-Eは、GPT-3などの他の生成AIモデルと組み合わせることで、高品質な音声合成アプリケーションや、録音されたある人物の音声から、本来は述べていない様な事を話させるような音声コンテンツの作成などに利用できると考えられている。

論文

参考文献

研究の要旨

音声合成(TTS)のための言語モデリングアプローチを紹介する。具体的には、既製のニューラルオーディオコーデックモデルから得られた離散コードを用いてニューラルコーデック言語モデル(VALL-Eと呼ぶ)を学習し、TTSを従来のような連続信号回帰ではなく、条件付き言語モデリングタスクと見なす。事前学習段階では、TTSの学習データを既存のシステムの数百倍にあたる6万時間の英語音声にスケールアップする。VALL-Eは、文脈内学習機能を持ち、未知の話者の3秒間の録音を音響プロンプトとして用いるだけで、高品質なパーソナライズ音声を合成することが可能である。実験の結果、VALL-Eは、音声の自然さと話者の類似性の観点から、最先端のゼロショットTTSシステムを大幅に上回ることが分かった。また、VALL-Eは、合成時に話者の感情や音響プロンプトの音響環境を保持できることがわかった。

コメントを残す