「OpenAI」は、Teslaなどで有名なElon Musk氏が設立した人工知能研究機関だが、同機関の訓練されたAIは、『Minecraft』を人間とほぼ同じようにプレイ出来る様になったようだ。

新たな方法でAIが膨大な動画データの意味を理解できるように

OpenAIがGPTで成し遂げた機械学習の成果は、目を見張る物だが、今回の研究では同じような方法で基礎モデルを構築することが出来なかった。

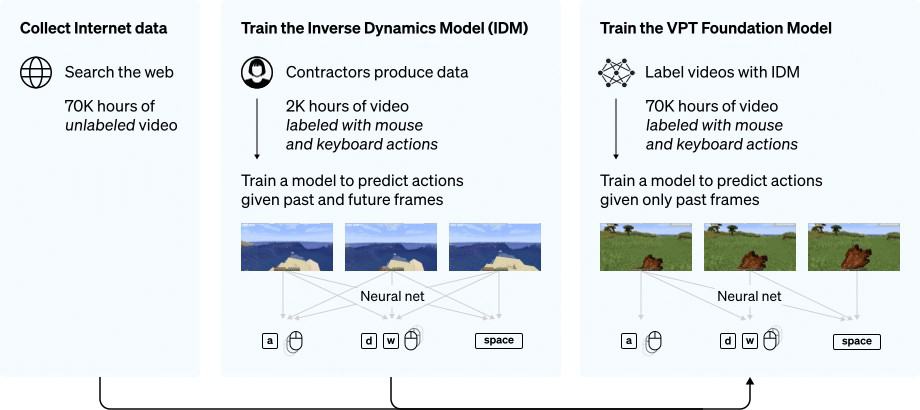

通常、機械学習では、膨大なデータを用いてコンピューターがデータから反復的に学習し、そこに潜むパターンを見つけ出し、基礎モデルを構築していく。今回のMinecraftにおいても、世界中で公開されている膨大な動画データを学習に用いているが、これらの動画は「何が起こったか」を記録しているだけで、「どのように達成したか」、つまり、マウスの動きやキーの押した順番などの「アクションラベル」が欠如しており、それが言語領域での研究とは違い、新たな課題となった。

そこで研究者達が新たに取り入れた方法が、「Video PreTraining(VPT)」と呼ばれる手法だ。

まず実際にMinecraftをプレイしている人のサンプルデータセットを2,000時間分収集し、AIに学習させる。このサンプルデータセットには、プレイ映像だけでなく、正確なキー入力やマウスの動きも含めたデータが含まれている。

つまり前段階として、動画の各ステップで実行されるマウスの動きとキーの押し順を予測するモデル「Inverse Dynamics Model:逆動力学モデル」(IDM)を学習しておくわけだ。ここで重要なことは、IDMは過去と未来の情報を使って、各ステップでの行動を推測することができるということだ。これは、過去の映像フレームのみから行動を予測する行動クローンよりもはるかに簡単で、必要なデータ量もはるかに少なくて済みむ。次に、学習したIDMで膨大なYouTubeの動画データ(サバイバルモードのみ約7万時間)を学習して複雑な行動を習得するのだ。

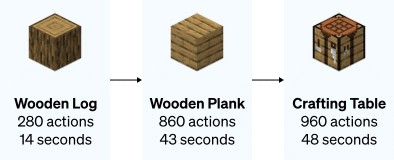

その後、このモデルは、木を切り倒して丸太を集めたり、丸太を実際の工作台にしたりといった行動を動画からコピーすることができたとのこと。

このAIモデルが可能になったことは、それだけに留まらない。泳いだり、狩りをしたり、食事をしたりと、複雑な動作も可能となった。さらに、ジャンプを繰り返しながらブロックを下に置くことで空中に浮く「空中浮遊」も可能になっている。

研究者たちは、AIに与えられたデータをもとに「基礎モデル」を作り、そこから行動を微調整したり、新たな行動を学習させたりすることができたという。このAIは、木や石の道具を作ったり、宝箱を荒らしたり、さらにはシェルターを作ったりと、ゲーム序盤のスキルを実行できることが指摘されている。

基礎モデルに投入されるデータが多ければ多いほど、AIはより能力を発揮することができた。研究者たちは「強化学習」を使って、特に難しい課題を実行した場合にAIに「ご褒美」を与えることもした。この報酬システムは非常に効果的なもので、モデルは最終的にダイヤモンドのツルハシを作ることに成功した。ダイヤモンドのツルハシを作るには、長くて複雑な一連のタスクが必要となる。下に示した通り、原木集めから始まり、作業台、木のツルハシ、石、石のツルハシ、かまど、鉄鉱石、鉄、鉄のツルハシ、ダイヤモンドと段階を踏んでダイヤモンドのツルハシが作れるようになる。

結果AIは、10分でダイヤモンドのツルハシを作成する事に成功している。通常このタスクを人間が行うと、平均20分以上(2万4000アクション)かかるとのことで、なんと2倍以上の速度でこなすことが可能になったとのことだ。

これは機械学習の魅力的な応用であり、ゲームがコンピューターのトレーニングにいかに利用できるかを示している。もしかしたら、このAIモデルはゲームそのものに組み込まれ、人間の対戦相手とプレイするのと同じような、より自然なチャレンジができるようになるかも知れない。

論文

参考文献

研究の要旨

テキスト、画像、その他のモダリティに対する広範で一般的な能力を持つモデルを学習するための手法として、ノイズの多いインターネット規模のデータセットに対する事前学習が盛んに研究されてきた。しかし、ロボット工学、ビデオゲーム、コンピュータ利用などの多くの逐次的な判断領域では、一般に入手可能なデータには、同じように行動事前分布を学習するために必要なラベルが含まれていない。我々は、インターネット規模の事前学習パラダイムを、半教師付き模倣学習を通じて逐次的な意思決定領域に拡張し、エージェントがオンラインのラベル無しビデオを見て行動することを学習する。具体的には、少数のラベル付けされたデータで、膨大なラベル付けされていないオンラインデータ(ここでは、Minecraftで遊ぶ人々のオンラインビデオ)をラベル付けするのに十分正確な逆動力モデルを訓練し、そこから一般の行動事前分布を訓練することができることを示す。マウスとキーボードを20Hzで操作するヒューマンインタフェースにもかかわらず、この行動事前分布は自明なゼロショット能力を持ち、強化学習ではゼロから学習することが不可能な難しい探索タスクに対して、模倣学習と強化学習の両方を用いて微調整が可能であることを示す。多くのタスクにおいて、我々のモデルは人間レベルのパフォーマンスを示し、我々は、熟練した人間がゲームプレイで20分以上(24,000環境アクション)かかるダイヤモンドツールを製作できるコンピュータエージェントを、初めて報告した。

コメントを残す