スマホのカメラは多眼レンズのトレンドを歩んでいるが、そもそも「カメラにレンズは必要なのだろうか?」という、全く異なる前提からレンズのないカメラも開発されている事はご存じだろうか?日本においても、東京工業大学によってレンズレスカメラが開発されている。これは、被写体から発せられた光がシート状の特殊なマスクを通して符号化され、センサー上にパターンとして投影され、それを機械学習によって従来の写真のように再構築するものだ。被写体の光を受けるという意味では、従来のカメラの流れを汲んだものだ。

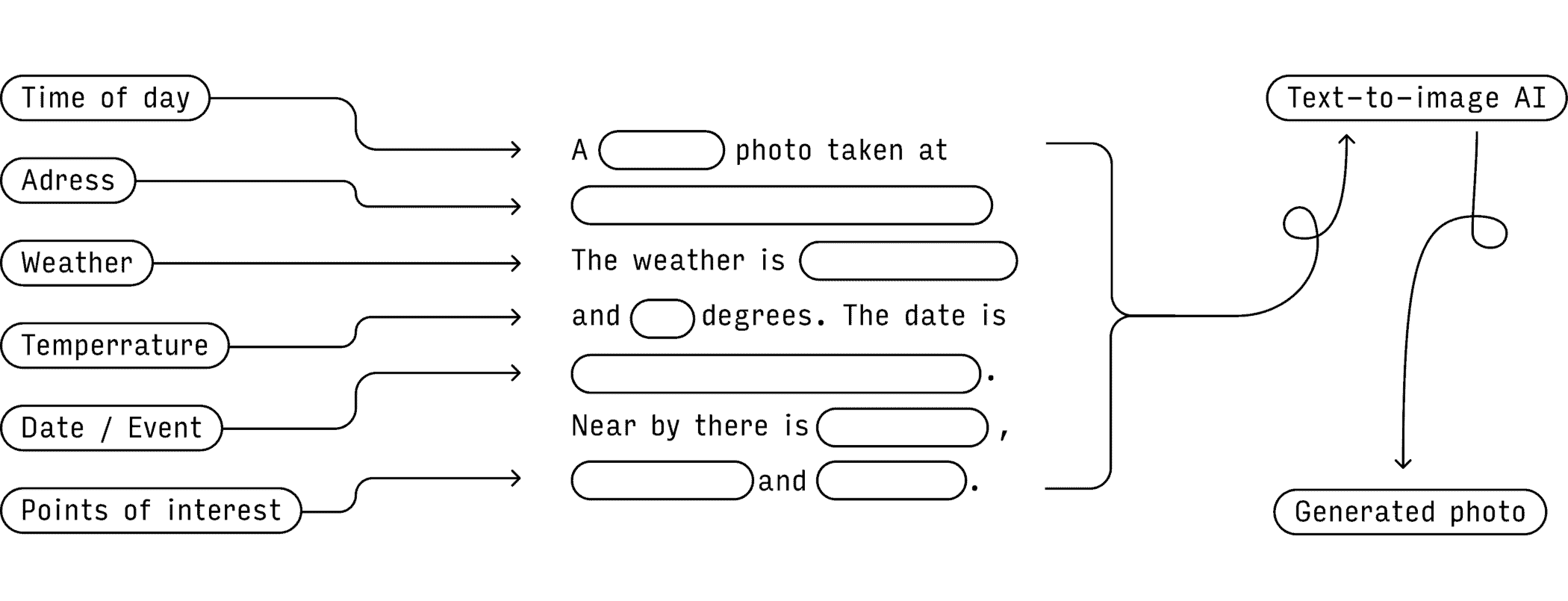

だが、今回オランダのデザイナーBjørn Karmann氏がRaspberry Piを用いて開発したカメラは、更にぶっ飛んでいる。これは、ユーザーの位置情報と、入力された文字情報をAIによって処理する事によって写真を“生成”するのだ。

Karmann氏は先週、自身のパッションアートプロジェクト「Paragraphica」をツイートで紹介した。「プロトタイプは完全に動作しており、アナログカメラに似たデータ範囲とAI画像設定をコントロールできる物理的なダイヤルを備えている」と彼は述べている。

Paragraphicaは、従来のカメラと同様に、3つのダイヤルで写真の見た目に影響するデータやAIのパラメーターをコントロールすることが出来る。ユーザーは、1つ目のダイヤルで、カメラが周囲の場所やデータを検索する半径(メートル)を設定することが出来る。2つ目のダイヤルは、写真にノイズを加えたり減らしたりするものだ。3つ目のダイヤルで、ユーザーがテキストの指示/プロンプトにどれだけ忠実にカメラを従わせるかを決めることが出来る。

光を必要としないため、レンズも必要ない

撮影者の居場所がわかってしまうので、プライバシーが心配という意見もあったが、このカメラは概ね好評だった。カメラの動作にはインターネットが必要で、気象データにアクセスし、GPSでユーザーの位置を把握する。この種のモデルとしては初めて、現在、Stability AIのテキストから画像へのStable Diffusionモデルが使用されている。このモデルは、テキストによるプロンプトをもとに画像を生成するものだ。

結果として得られる「写真」は、単なるスナップショットではなく、あなたの場所と、おそらくAIモデルがその場所をどのように「見て」いるかを、複雑かつ微妙に反映したものだと、Karmann氏はブログ記事で述べている。

その場所から連想される感情や気分を写真に収めることができるのだが、撮影者が見た風景そのままには撮影できない。

Karmann氏は、この製品を商品化したり、写真に挑戦したりする意図はないと明言する。彼の製品は、むしろ創造的緊張の時代におけるAIの役割に疑問を投げかけているのだ。

正面から見ると、赤い触手が飛び出しているようで、ちょっと不気味な見た目だ。これは、地下で生活し、狩りをする星鼻のモグラからインスピレーションを得たという。この動物は、指のような触角で世界を認識するように進化し、珍しい知的な “見る”方法を獲得したと、ブログでKarmann氏は詳しく説明している。

Source

コメントを残す