Stability AIはこのほど、2つの日本語大規模言語モデル「Japanese Stable LM 3B-4E1T」と「Japanese Stable LM Gamma 7B」を発表した。前者は約30億のパラメータを誇り、後者は70億のパラメータを持つモデルである。これらのモデルはApache 2.0ライセンスのもと、商用利用が可能となっている。

?日本語大規模言語モデル「Japanese Stable LM 3B-4E1T」と「Japanese Stable LM Gamma 7B」をリリースしました?

— Stability AI 日本公式 (@StabilityAI_JP) October 25, 2023

約30億と70億のパラメータを持つこれらのモデルは、日本語タスクの性能評価でトップクラスです✨

さらに、Apache 2.0ライセンスで商用利用も可能?… pic.twitter.com/N9M31UhdL0

これらのモデルは、過去にリリースされた英語モデル、具体的にはStability AIが2023年8月に、Mistral AIが9月にそれぞれ発表した「Stable LM 3B-4E1T」と「Mistral-7B-v0.1」をベースに構築されている。これらのモデルは当初、主に英語のデータで学習されたため、英語の能力は高いが、日本語のデータが少ないため、日本語の能力は限られていた。

日本語能力を向上させるため、これらのモデルはWikipedia、mC4、CC-100、OSCAR、SlimPajama(Books3を除く)などのソースから約1000億トークンに及ぶ日本語と英語のデータセットを利用し、事前学習を継続した。

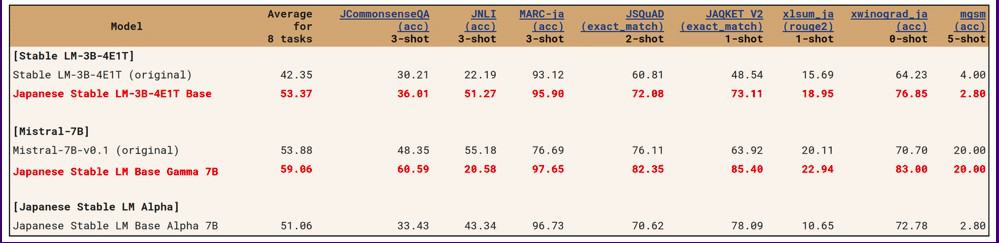

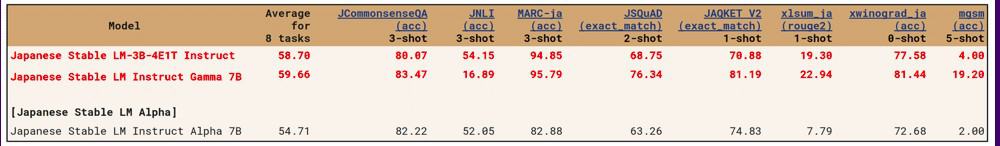

これらのモデルの性能評価は、2023年8月にリリースされた「Japanese Stable LM Alpha」と同じ手法で行われた。評価対象は日本語理解ベンチマーク(JGLUE)タスクで、文分類、文対分類、質問応答、文章要約の計8タスクである。

日本語安定版LM 3B-4E1Tは、パラメータが30億個しかないにもかかわらず、日本語安定版LM Base Alpha 7Bよりも優れた性能を示した。Japanese Stable LM Gamma 7Bはさらに高いスコアを達成し、これらのモデルによって日本語の自然言語処理が著しく進歩したことを示している。

Source

コメントを残す