テキストから画像を生成する「Stable Diffusion」で有名なStability AIは、ビデオ生成AIで先行するRunwayML等を凌駕すると主張する、「Stable Video Diffusion」をリリースした。

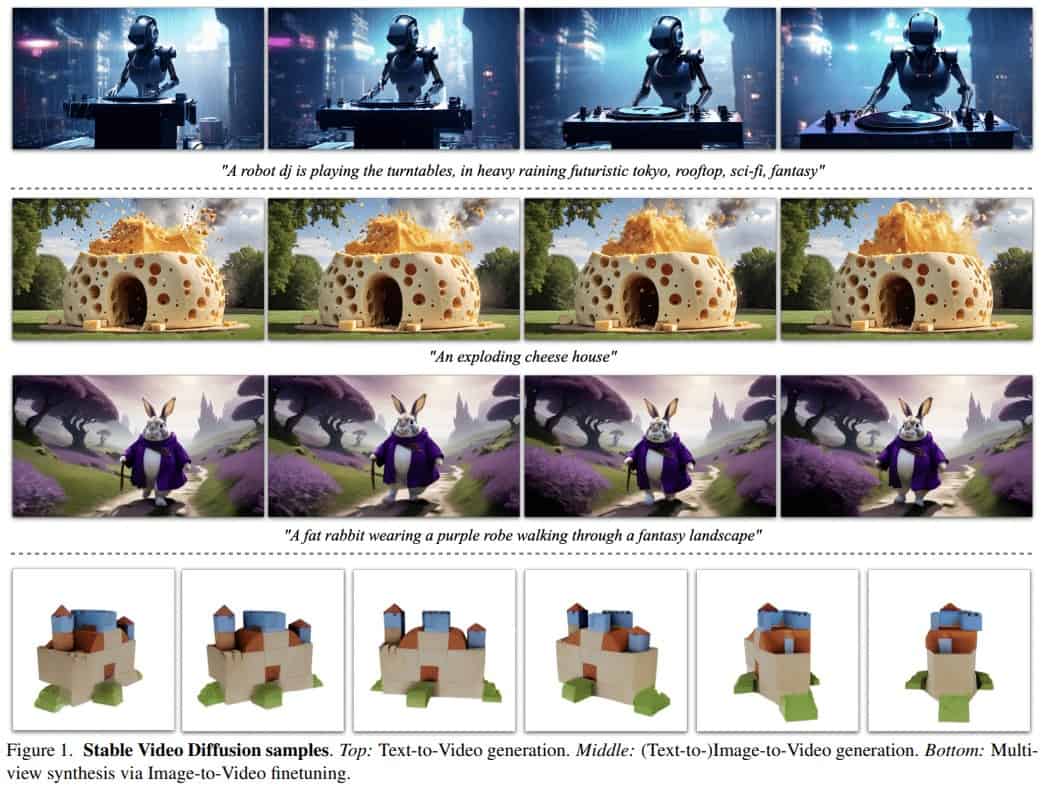

この新しいツールは、2つの画像から動画へ変換するモデルという形でリリースされており、それぞれ576×1024の解像度で3~30フレーム/秒の速度で14~25フレームの長さを生成することができる。1つのフレームからマルチビュー合成が可能で、マルチビューデータセットで微調整ができる。

Stable Video Diffusionモデルは、Stable Diffusion画像モデルをベースに、Stability AIによって、特別にキュレートされた高品質のビデオデータのデータセットでトレーニングされた。

とれーにんぐにあたっては、テキストから画像への事前トレーニング、低解像度ビデオの大規模なデータセットによるビデオの事前トレーニング、そして最後に高解像度ビデオのはるかに小規模なデータセットによるビデオの微調整が行われたと言う。

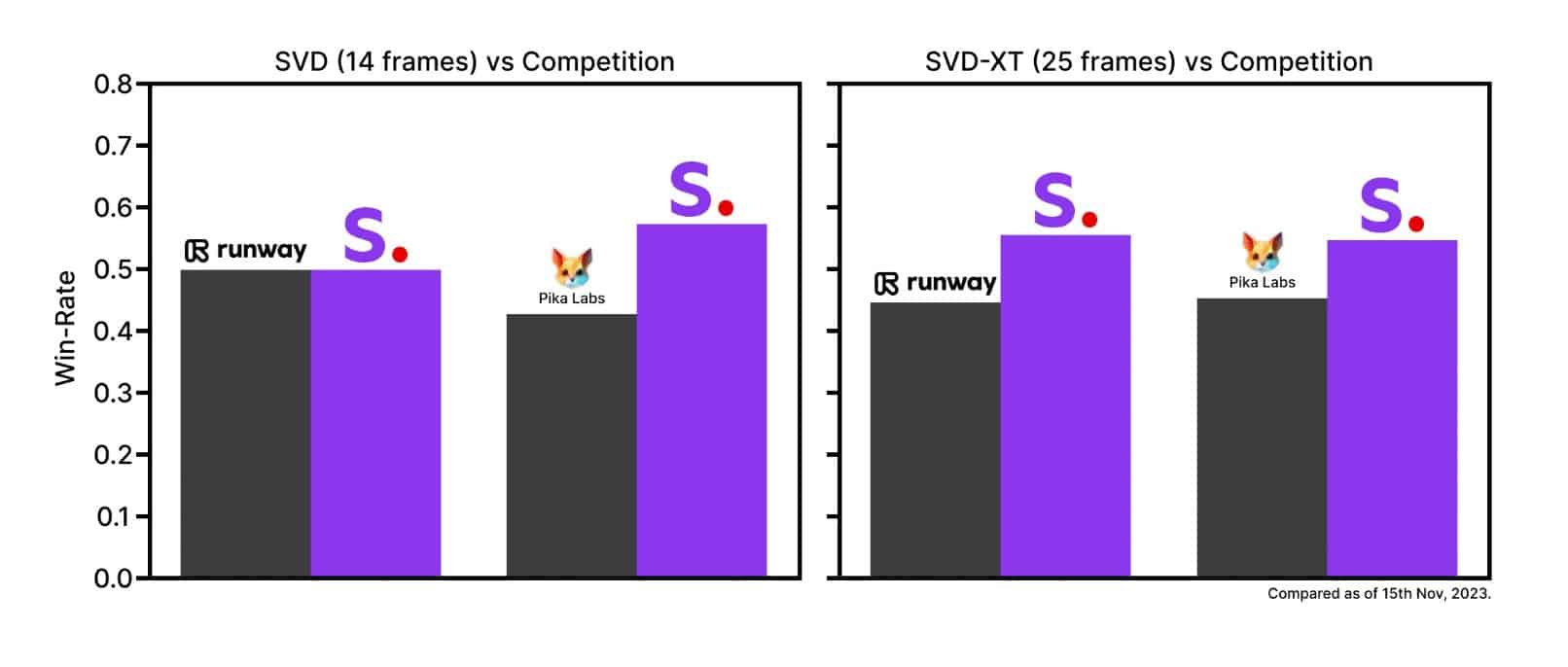

商用モデルを上回るパフォーマンス

Stability AIによると、リリース時点で、Stable Video Diffusionは、ユーザー嗜好調査において、RunwayMLやPika Labsなどの主要な商用モデルを上回ったという。Stability AIは、人間の評価者にウェブ・インターフェースで生成された動画を見せ、視覚的品質とプロンプトの追従性の観点から動画の品質を評価してもらった。結果は以下の通りだ。

ただし、最近Metaが発表した新しいビデオモデルであるEmu Videoもかなり優秀で、RunwayML等に大差をつけており、Stable Video Diffusionが現状最高のビデオ生成AIモデルというわけではなさそうだ。ただし、Emu Videoは研究論文と静的なウェブ・デモしかないため、ユーザーが実際に試してみる事ができる物としてはStable Video Diffusionが最も優秀と言える。

Stability AIの研究者たちは論文の中で、大量の動画データをキュレーションし、大量で乱雑な動画コレクションを生成動画モデルに適したデータセットに変換する手法も提案している。このアプローチは、動画生成のための堅牢な基礎モデルの学習を単純化するように設計されている。

まずはStable Video Diffusionは研究用バージョンが提供

Stable Video Diffusionはまた、マルチビューデータセットに微調整を加えた単一画像からのマルチビュー合成など、様々な下流タスクに容易に適応できるように設計されている。Stability AIは、Stable Diffusionで行ったのと同様に、この基盤の上に構築され拡張されるモデルのエコシステムを開発する予定だ。

現時点では、Stable Video Diffusionは研究目的でのみ利用可能であり、実世界や商用アプリケーションではない。潜在的なユーザーは、「テキストからビデオへのインターフェイスを特徴とする今後のウェブ体験」へのアクセス待ちリストに登録することができる、とStability AIは書いている。このツールは、広告、教育、エンターテインメントなどの分野での潜在的なアプリケーションを紹介する予定だ。

論文

- Stability AI: Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets [PDF]

参考文献

- Stability AI: Introducing Stable Video Diffusion

- GitHub: Stability-AI/generative-models

- Hugging Face: stabilityai/stable-video-diffusion-img2vid-xt

研究の要旨

高解像度で最先端のテキストから動画、画像から動画生成のための潜在動画拡散モデル、Stable Video Diffusionを紹介する。近年、2次元画像合成のために学習された潜在拡散モデルは、時間レイヤーを挿入し、小規模で高品質なビデオデータセット上で微調整することにより、生成的ビデオモデルへと変化している。しかし、文献に記載されている学習方法は様々であり、ビデオデータをキュレーションするための統一的な戦略について、この分野はまだ合意していない。本論文では、動画LDMの学習を成功させるための3つの異なる段階(テキストから画像への事前学習、動画の事前学習、高品質動画の微調整)を特定し、評価する。

コメントを残す