人工ニューラルネットワークは、私たちの脳のデジタル版のようなものだ。ルールではなくデータから学習し、言語の翻訳からチェスまで、並外れたタスクをこなすことができる。しかし、どのようにそれを行うのだろうか?その計算の背後にある論理は何なのか?そしてどうすれば安全で信頼できるのだろうか?

AIの頭脳:その仕組みは?

これらは、コンピューター科学者と神経科学者の双方を困惑させている疑問の一部である。後者もまた、人間の脳の働きを理解する上で同様の課題に直面している。私たちの頭の中にある何十億ものニューロンは、どのようにして私たちの思考、感情、意思決定を生み出しているのだろうか?長年の研究と医学の進歩にもかかわらず、私たちは脳についてもっと学ぶ必要がある。

幸いなことに、人工ニューラルネットワークは生物学的なものよりも研究しやすい。ネットワーク内のすべてのニューロンの活動を測定し、それらをオン/オフすることで操作し、異なる入力に対してネットワークがどのように反応するかを見ることができる。

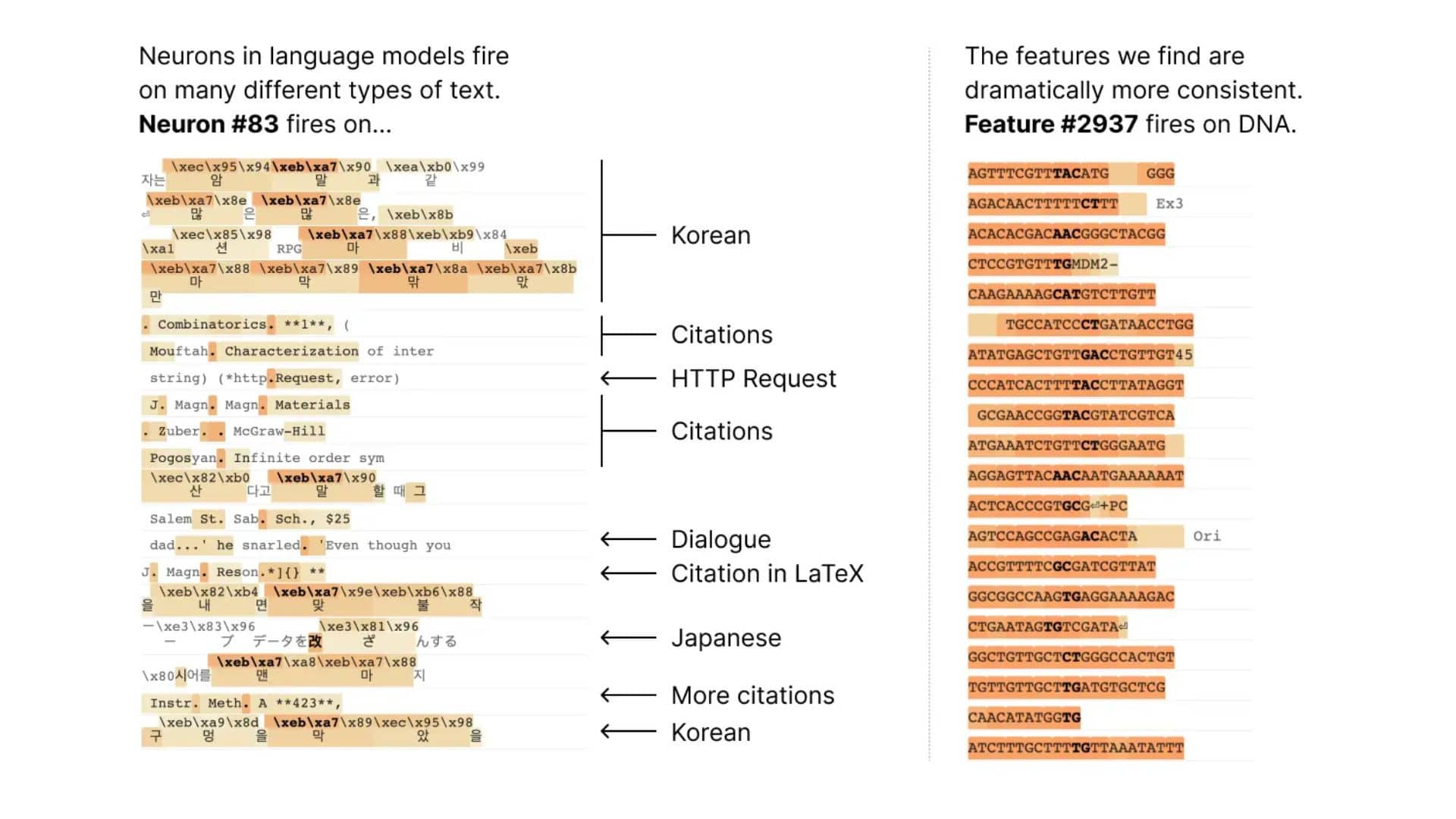

しかし、このアプローチには限界がある。個々のニューロンには明確な意味や機能がないのだ。例えば、小さな言語モデルの1つのニューロンは、学術文献、英会話、ウェブリクエスト、韓国語のテキストを見たときなど、さまざまな状況でアクティブになる可能性がある。視覚モデルでは、1つのニューロンが猫の顔や車の前面に反応することがある。同じニューロンでも文脈によって異なる意味を持つ。

Anthropicで働く元OpenAIの頭脳の研究者たちによる新しい論文は、人工ニューラルネットワークを理解するためのより良い方法を提案している。個々のニューロンを見るのではなく、パターンや特徴を形成するニューロンの組み合わせを見るのだ。これらの特徴はニューロンよりも具体的で一貫性があり、ネットワークの動作のさまざまな側面を捉えることができる。

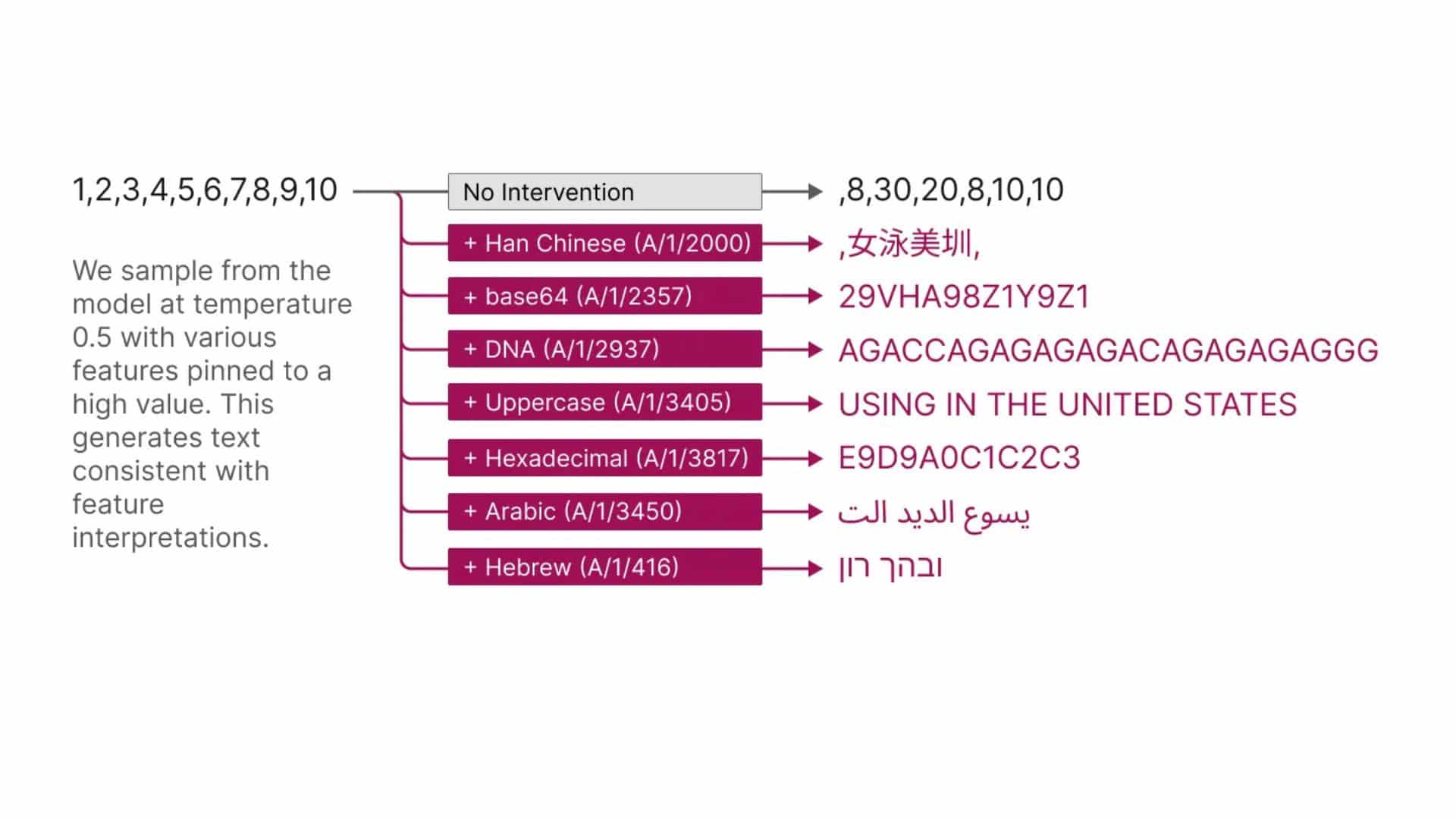

論文『Towards Monosemanticity: Decomposing Language Models With Dictionary Learning』は、自然言語処理に広く使われている小さな変換モデルで、これらの特徴を見つける方法を示している。研究者らは辞書学習を用いて、512個のニューロンを持つレイヤーを4,000以上の特徴に分解している。これらの特徴は、DNA配列、法律用語、Webリクエスト、ヘブライ語テキスト、栄養成分など、多様なトピックや概念を表している。これらの特徴のほとんどは、ニューロンだけを見ると隠されている。

特徴

研究者たちは、ニューロンよりも特徴の方が解釈しやすいことを証明するために、2つの方法を用いている。まず、人間の評価者に各特徴が何をするものかを理解するのがどれだけ簡単かを評価してもらう。その結果、特徴量(赤)はニューロン(青緑)よりも高いスコアを獲得した。次に、大規模な言語モデルを使って各特徴の短い説明を生成し、別のモデルを使って、レポートに基づいて各特徴がどの程度活性化するかを予測する。ここでも、特徴量はニューロンよりも高いパフォーマンスを示している。

また、特徴量を使うことで、ネットワークの動作をより正確に制御することができる。以下に示すように、人為的に特徴を活性化させることで、その特徴の意味に合った異なる出力をネットワークに出させることができる。

しかし、これで終わりではない。研究者たちはまた、特徴セットを拡大して全体として検証している。研究者たちは、学習された特徴が異なるモデル間で普遍的であることを発見した。つまり、あるモデルの特徴を研究することで得られた教訓は、他のモデルにも一般化できる可能性があるのだ。研究者たちはまた、学習する特徴の数を調整する実験も行っている。モデルを小さな特徴セットに分解すると、理解しやすい粗いビューが得られ、大きな特徴グループに分解すると、微妙なモデルの特性を明らかにする、より洗練されたビューが得られる。

この研究は、AnthropicがAIの安全性に関する長期的な研究の賭けである機械論的解釈可能性に投資した結果。これまでは、個々のニューロンが解釈不可能であるという事実が、言語モデルを機械論的に理解するための深刻な障害となっていた。ニューロン群を解釈可能な特徴に分解することで、その障害を克服できる可能性がある。これにより、最終的にはモデルの挙動を内部から監視し、制御できるようになり、企業や社会への導入に不可欠な安全性と信頼性が向上することを期待している。

彼らの次の課題は、このアプローチを、彼らが成功裏に使用している小さなモデルから、何倍も大きく、かなり複雑なフロンティアモデルへとスケールアップすることである。彼らは初めて、大規模な言語モデルを解釈する上で、科学よりもむしろ工学が次の主要な障害になると感じている。

この研究は、人工ニューラルネットワークを理解し、改善するための新たな可能性を開くものである。また、コンピューター科学と神経科学の間のギャップを埋めるものでもある。両分野は、複雑なシステムを解読するという同じような目標と課題を共有しているからだ。互いの手法や洞察から学ぶことで、より自然で人工的な知能の秘密を解き明かすことができるだろう。

論文

研究の要旨

最新の論文「 Towards Monosemanticity: Decomposing Language Models With Dictionary Learning」では、個々のニューロンよりも優れた分析単位が存在するという証拠を概説している。特徴量と呼ばれるこれらの単位は、ニューロンの活性化のパターン(線形結合)に対応する。これは、複雑なニューラルネットワークを理解できる部分に分解する道を提供し、神経科学、機械学習、統計学における高次元システムを解釈するこれまでの取り組みを基礎としている。変換言語モデルでは、512個のニューロンを持つレイヤーを4000個以上の特徴に分解し、DNA配列、法律用語、HTTPリクエスト、ヘブライ語テキスト、栄養ステートメント、その他もろもろのものを個別に表現する。このようなモデルの特性のほとんどは、個々のニューロンの活性を単独で見るときには見えない。

コメントを残す