OpenAIは、人間を超える知能を手に入れた人工知能(AI)の暴走をあらかじめ制御する方法を見出すために結成した「Superalignmentチーム」の最初の成果を発表した。

「我々は、超知能-人間よりも圧倒的に賢いAI-が今後10年以内に開発される可能性があると考えている」と、OpenAIの投稿は始まっている。このようなシステムを制御・管理することは大きな課題である。

OpenAIのSuperalignmentチームはその目標のために、社内全体で利用可能なコンピューティングリソースの20%を研究に充てる事が出来るとされている。

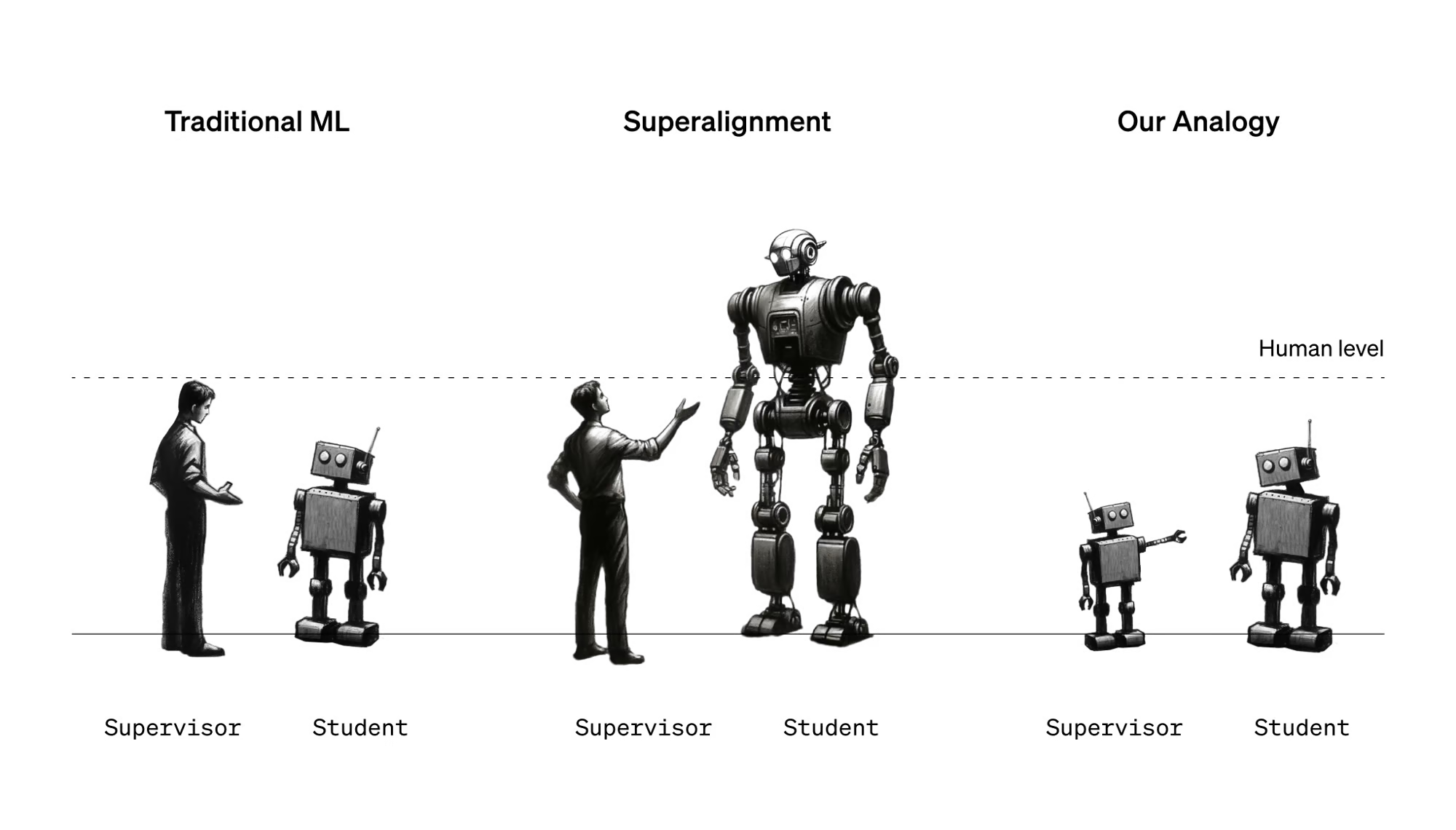

このチームの目標のひとつは、人間がRLHF(人間のフィードバックからの強化学習)を通じて弱いモデルを監督するのと同じように、人間やAIシステムが優れたシステムを監督できるかどうか、またどのように監督できるかを調査することである。

人工超知能の文脈では、研究チームは人間を「弱い監督者」と見なしている。課題は、弱い監督者が、強いモデルの能力を制限することなく、いかにしてはるかに強いAIモデルをコントロールし、信頼できるかということだ。

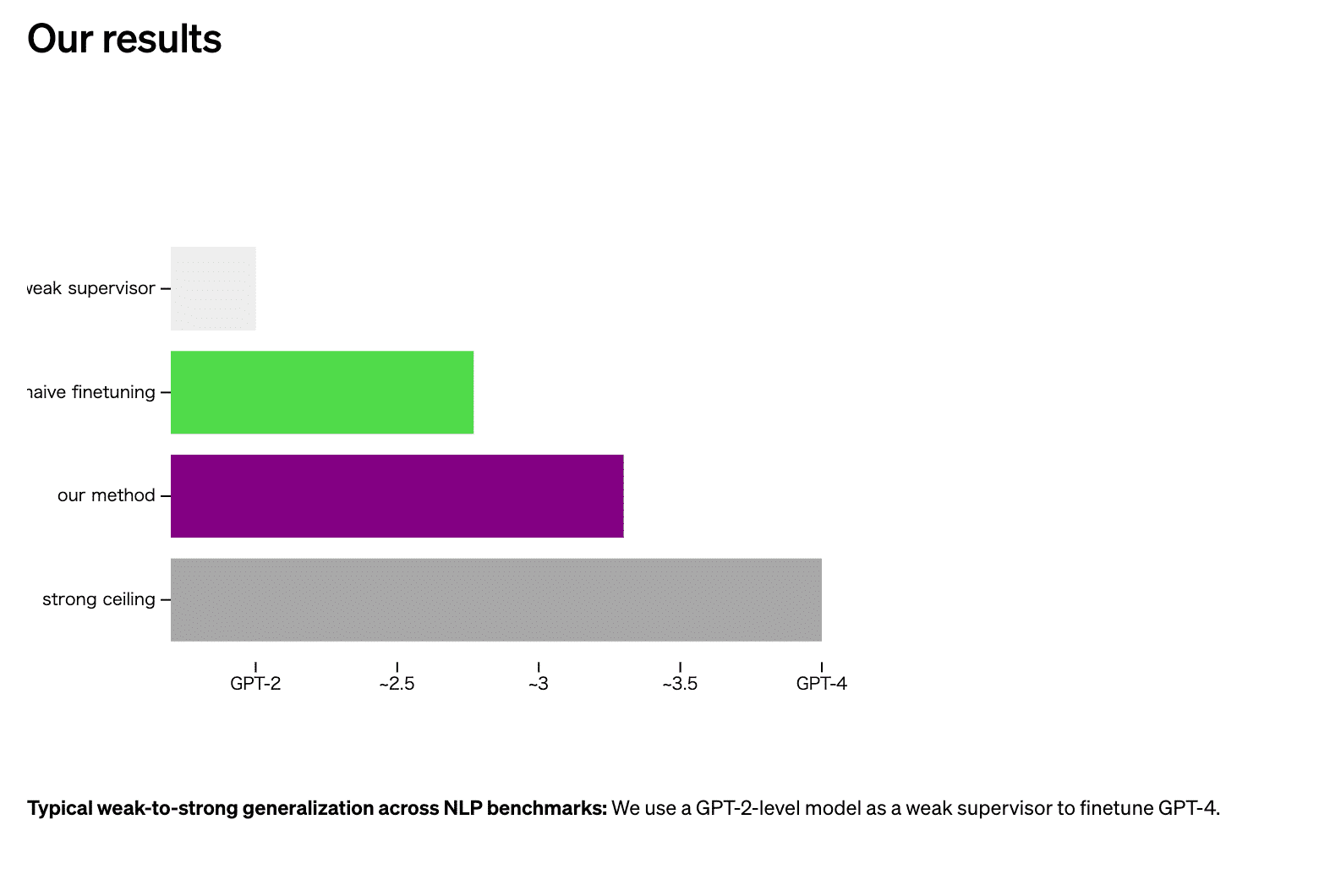

この課題を探求するために、OpenAIは、より小さく、より強力でないAIモデルを使って、より大きく、より強力なAIモデルを監督するというアナロジーを提案している。ここでは、強力なGPT-4モデルを、小さく劣る微調整されていないGPT-2モデルで監督する方法がとられた。

GPT-2がGPT-4を監視

彼らは3つの異なる方法を使用し、そのうちの2つはGPT-2の出力をガイドとして、あるいは微調整のために使用した。しかし、これではGPT-3に匹敵するモデルの性能は得られなかった。微調整の際に補助的な信頼損失を追加することで、強いモデルがより確信に満ちた性能を発揮し、必要であればGPT-2と矛盾することを促す単純な方法を用いると、結果として得られたモデルの性能は概ねGPT-3とGPT-3.5の間になった。これは、GPT-4の微調整とRLHFバージョンのレベルではないが、より弱いモデルが、より高度なモデルの固有の能力を監督し、研究チームが「弱いものから強いものへの汎化」と呼ぶものを達成する方法があることを示した。

同社は、この方法を限界のある概念実証と考えている。この結果は、RLHFのような方法は、さらなる開発なしに超人モデルにスケールアップすることは難しいが、そのような開発は可能であることを示している。

OpenAIがアライメントのための資金提供プログラムを開始

「我々の設定は、将来の超人モデルのアライメントに関するいくつかの重要な困難を捉えており、今日からこの問題に対する実証的な進展を開始することができると考えています」と同社は述べている。

同社はコードを公開し、超人的なAIアライメントに取り組む大学院生や学者、その他の研究者を対象にGoogleの元CEOであるEric Schmidt氏と協力し、1,000万ドルの助成金プログラムを開始する。

これらの助成金では、特に以下のような研究方向への助成を希望している:

- 弱から強への一般化:人間は超人的なモデルに対して弱い監督となる。弱い監督から強いモデルがどのように汎化するかを理解し、コントロールすることは可能か?

- 解釈可能性:モデルの内部をどのように理解できるか?また、例えばAIの嘘発見器を作るためにそれを利用できるか?

- スケーラブルな監視:複雑なタスクに関する他のAIシステムの出力を評価する人間を支援するために、AIシステムをどのように利用できるか?

- その他、正直さ、思考の連鎖の忠実さ、敵対的な堅牢性、検証とテストベッドなど、多くの研究方向があるが、これらに限定されるものではない。

Sources

コメントを残す