Dellは先日の決算説明会で、NVIDIAの次世代BlackwellラインアップがB100 AIアクセラレータだけでなく、現行世代のHopperのように、後にアップグレード版が提供されるという事実を明らかにした。Dellがこれを明らかにしたことからも、NVIDIAはすでにこの情報を、NVIDIAの最新のAIおよびコンピューティング対応ハードウェアを使用してサーバーやデータセンターを運用するDellのような最大のパートナーに開示しているようだ。

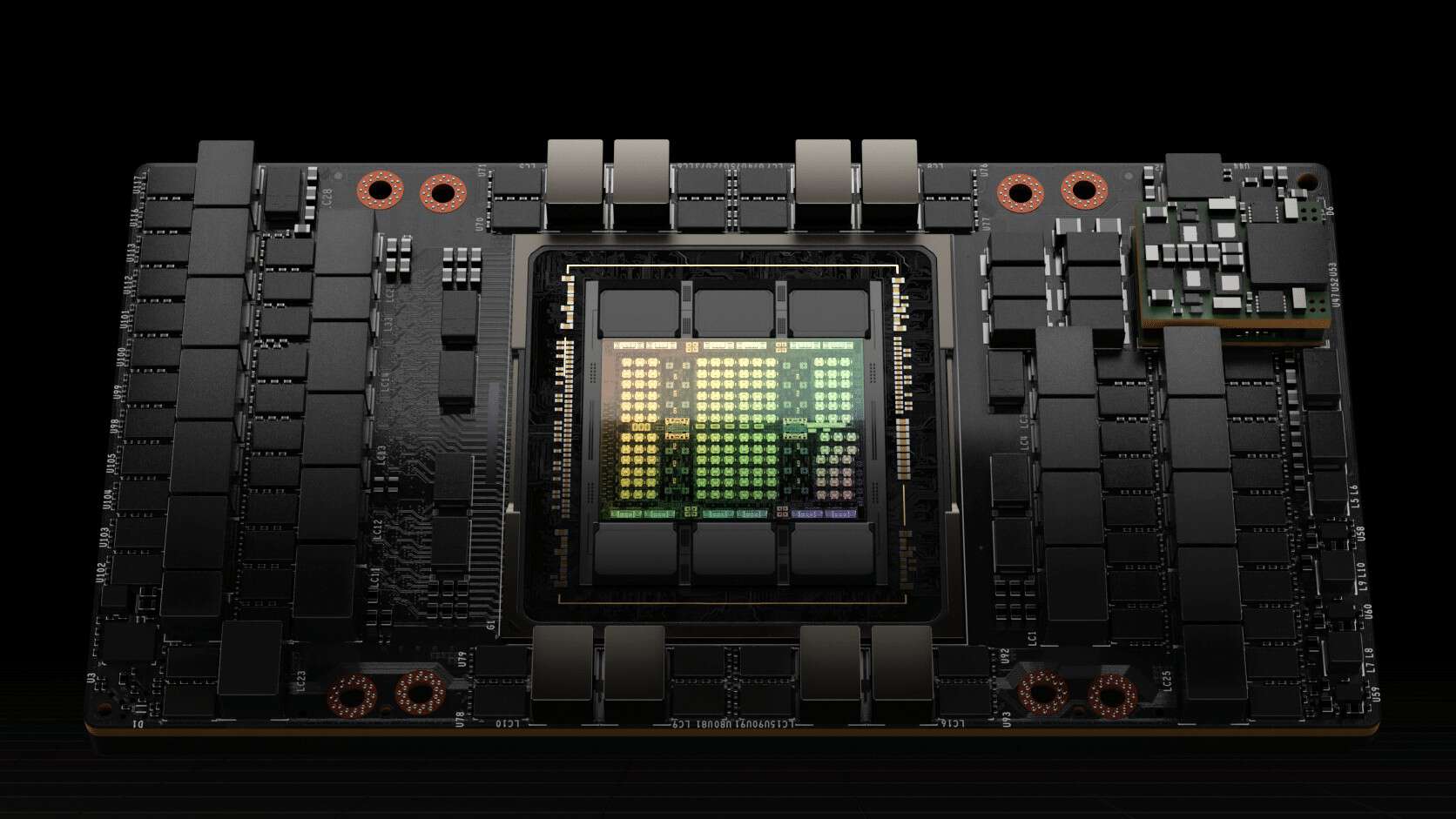

NVIDIAのBlackwell GPUは今月のGTC 2024で正式デビューし、今年の年末までに登場する事が予想される。現在のロードマップでは、NVIDIA B100、GB200、GB200NVLが示されており、B100はGPU自体のコードネーム、GB200はSuperchipプラットフォーム、GB200NVLはスーパーコンピューティング用途の相互接続プラットフォームである。

現在、NVIDIAのBlackwell GPUはモノリシック設計を採用するかもしれないという報告があるが、具体的なことはまだ何もわかっていない。分かっているのは、Hopper H200 GPUと同様に、第1世代のBlackwell B100はHBM3eメモリを活用するということだ。そのため、アップグレードされたB200のバリエーションは、より高いメモリ容量、アップグレードされたスペック、強化された機能とともに、さらに高速なバージョンのHBMメモリを使用することになる可能性がある。Samsungは、Blackwell GPUの主要なメモリ・プロバイダーであると言われている。

またDellによると、これらのAIアクセラレータの消費電力は最大1,000ワットにも上り、旧世代より40%増加するため、DellはこれらのGPUを冷却するために工学的な工夫を必要とするようだ

もちろん、H200とそのパフォーマンス向上に期待しています。また、B100とB200で何が起こるかにも期待しています。エンジニアリングの信頼性を際立たせるもうひとつのチャンスがそこにあると考えています。熱的な側面における我々の特徴として、GPUあたり1,000ワットのエネルギー密度を達成するために直接液冷を必要としないことが挙げられます。

それは来年のB200で実現します。私たちにとって、エンジニアリングと、私たちがどれだけ速く動けるか、そして、液冷を大規模に実行させるための専門知識を提供するために業界のリーダーとして行ってきた仕事、流体の化学的性質や性能、相互接続の仕事、私たちが行っているテレメトリ、私たちが行っているパワーマネジメントの仕事などを紹介する機会は、市場に存在するであろう驚異的な計算能力、強度、能力を活用するために、大規模に市場にそれを提供する準備を整えることを本当に可能にしてくれます。

Tom’s Hardwareは、チップが消費する電力量と必要な放熱を考えると、NVIDIAのB100は同社初のデュアルダイ設計になるかもしれないとの考えを示している。

Gigabyteのロードマップで少し前に指摘されたように、CPUとGPUの両方に対する電力要件は今後も増加し続ける。これらを克服するために、各社は先進的なプロセス技術とパッケージング技術を活用し、より高い電力効率を確保しながら、チップ開発コストを最適な状態に維持する。

Sources

コメントを残す