NVIDIAは本日、GPU全体の大規模言語モデルに対する処理パフォーマンスを向上させる、新たなAIソフトウェア・スタック「TensorRT LLM」を発表した。同社によると、NVIDIA TensorRT-LLMを用いることで、Hopper AI GPUによる大規模言語モデルパフォーマンスが最大8倍向上させることも可能だという。

NVIDIAのTensorRT-LLMは、高度に最適化されたオープンソースライブラリとして発表され、HopperなどのNVIDIAのAI GPUで、すべてのラージ言語モデルで最速の推論性能を実現する。NVIDIAは、SmoothQuant、FlashAttention、fMHAといった最先端の技術を備えた最新のAIカーネルを活用することで、GPUを最適化するために、オープンソースコミュニティ内のすべてのLLMと協力してきた。オープンソースの基盤には、GPT-3(175B)、Llama Falcom(180B)、BloomなどのLLMのSOTA推論最適化バージョンが含まれている。

また、TensorRT-LLMは、Infinibandインターコネクトを備えた複数のNVLINKサーバ間で自動並列化を行うように最適化されている。これまでは、複数のサーバ/GPUにまたがる大規模な言語モデルを手動で割り当てる必要があったが、Tensor-RT LLMではそれが不要となる。

TensorRT-LLMがもたらす最大のアップデートの1つは、In-Flightバッチングと呼ばれる新しいスケジューラで、他のタスクとは独立してGPUに入ったり出たりすることが可能だ。これにより、同じGPUで大きな計算負荷のリクエストを処理しながら、複数の小さなクエリを動的に処理できるようになる。このプロセス全体がGPUをより効率的にし、H100のようなGPUのスループットを最大2倍という大幅な向上へと導く。

TensorRT-LLMスタックは、HopperのTransformerエンジンとそのFP8計算機能を中心に最適化されている。このライブラリは、自動FP8変換、カーネルフュージョン用のDLコンパイラ、混合精度オプティマイザを提供し、NVIDIA独自のSmoothquaintアルゴリズムのサポートにより、精度を損なうことなく8ビット量子化性能を実現する。

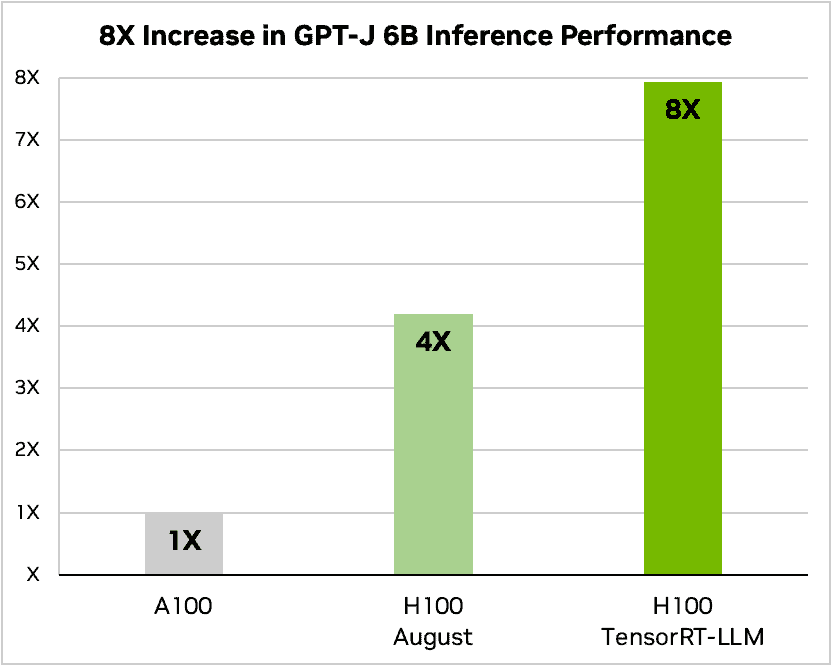

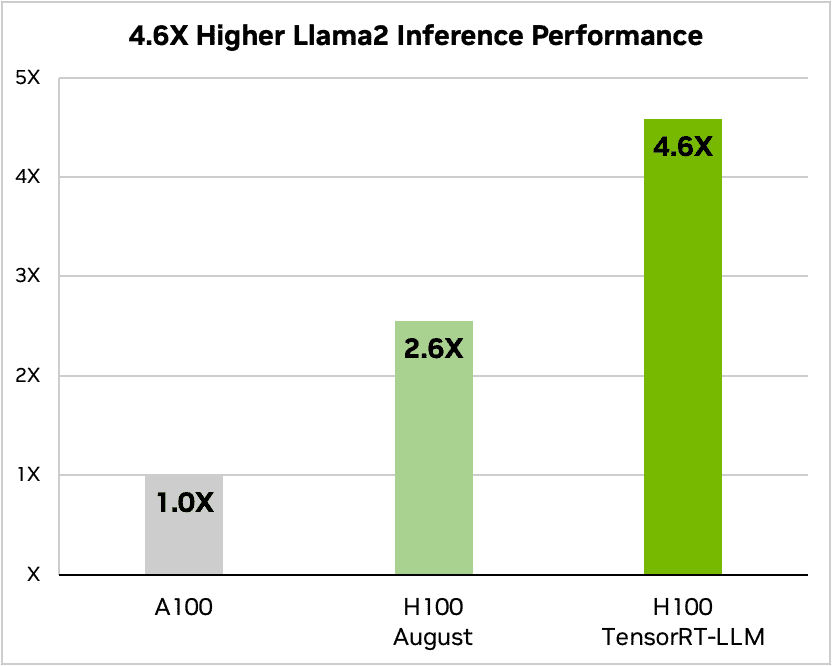

NVIDIAは、8月のA100とH100の性能、およびTensorRT-LLMを使用したH100の性能を比較している。GPT-J 6B(推論)では、H100はすでに4倍のパフォーマンス向上を提供しているが、TensorRT-LLMを使用することで、この特定のテストでは8倍の向上が見られるという。Llama2では、TensorRT LLMを使用することで最大5倍、TensorRT-LLMを使用しない標準的なH100と比較するとほぼ2倍の向上が見られるとのことだ。

NVIDIAは、TensorRT-LLMを使ってLLMを高速化するために、Meta、Grammarly、Deci、anyscaleなどのすべての主要な推論ワークロードと協力していると述べている。利用可能性に関しては、TensorRT-LLMは現在早期アクセスが可能で、来月にはフルリリースが予定されている。サポートに関しては、TensorRT-LLMは、A100、H100、L4、L40、L40S、HGX、Grace Hopperなど、現在生産中のすべてのNVIDIAデータセンター&AI GPUでサポートされるとのことだ。

Databricks社のエンジニアリング担当副社長Naveen Rao氏は、TensorRT-LLMを「使いやすく、トークンのストリーミング、インフライトバッチング、ページアテンション、量子化などの機能が満載」と評価した。同氏は、TensorRT-LLMがNVIDIA GPU上のLLMに最先端の性能を提供し、最終的にはコスト削減によって顧客に利益をもたらすと強調した。

TensorRT-LLMにアクセスするには、開発者はNVIDIA Developer Programを通じて早期アクセスを申し込むことが可能だ。

Source

- NVIDIA Developer Technical Blog: NVIDIA TensorRT-LLM Supercharges Large Language Model Inference on NVIDIA H100 GPUs

コメントを残す