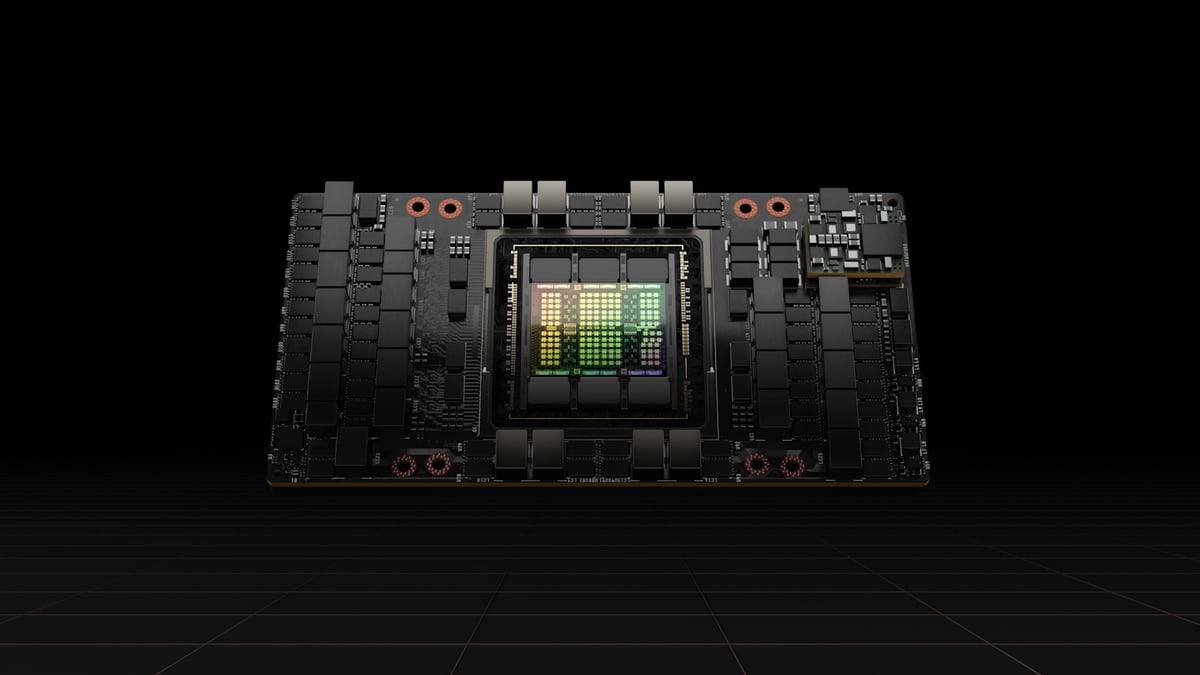

NVIDIAは、現在開催中のGTC2022において、同社の次世代GPUアーキテクチャ「Hopper」及び、その「Hopper」ベースのデータセンター向けGPU「NVIDIA H100」を発表した。

アメリカのコンピューター科学者である 「Grace Hopper (グレース ホッパー) 」にちなんで名付けられたこの新しいアーキテクチャは、前世代「Ampere」アーキテクチャから実に2年ぶりのアップデートとなる。

NVIDIA H100 GPU

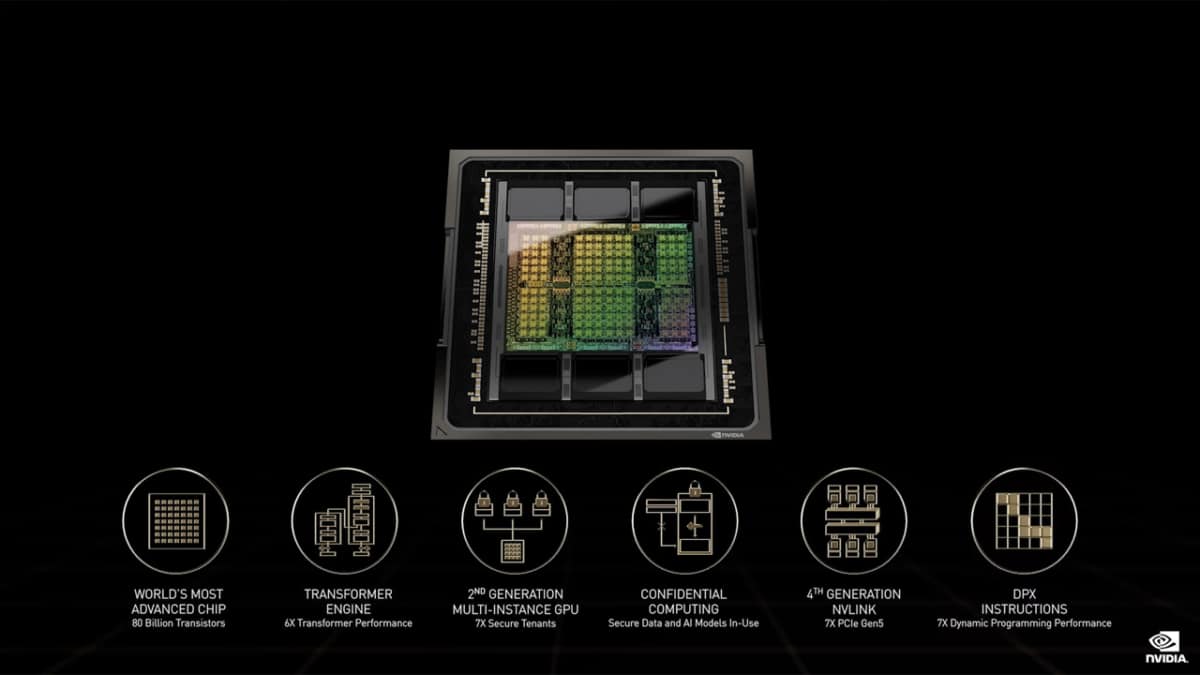

NVIDIAはH100において、6つのテクノロジーブレイクスルーを実現しているという。

4nmプロセスで製造され、総トランジスタ数800億

H100は、PCI Express(以下,PCIe) 5.0 をサポートする最初のGPUであり、16レーン接続での理論帯域幅は128GB/sとなる。また、グラフィックメモリに「HBM3」をサポートする最初の GPU となっている。メモリの総容量は80GBまでサポート。また、GPU-HBM間では3TB/s のメモリ帯域幅になり、前世代のA100から1.5倍の高速化を実現している。

新しい Transformer Engine

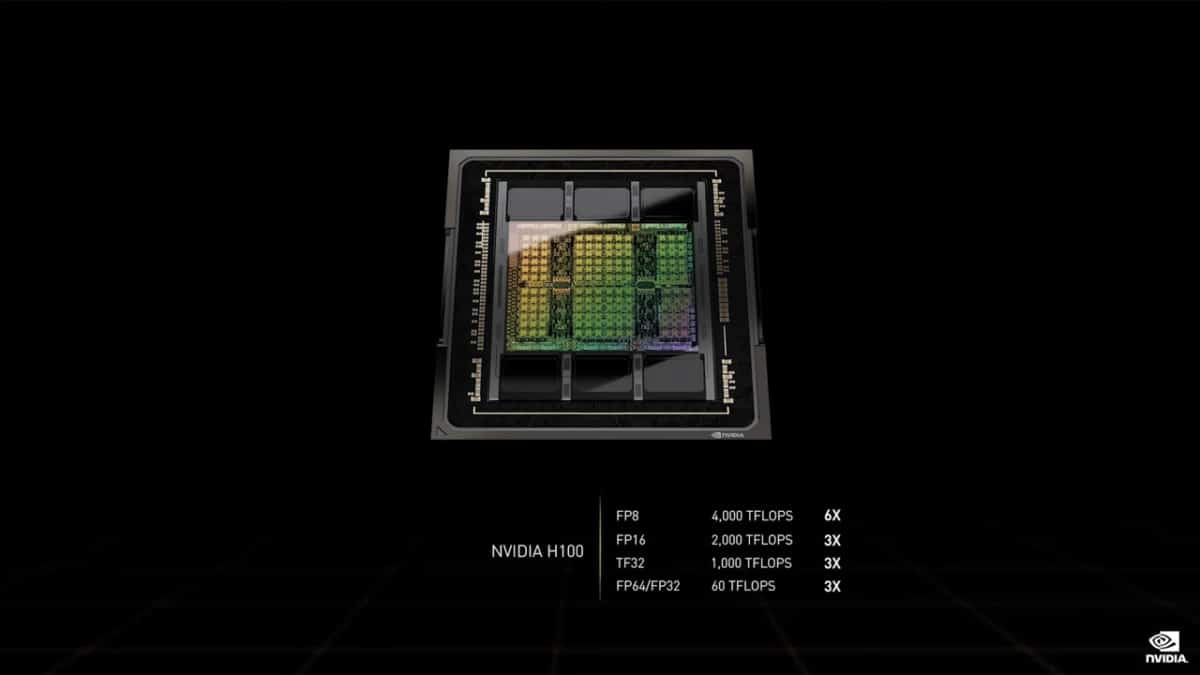

H100は、FP16で最大2,000TFLOPS、TF32で最大1,000TFLOPS、汎用FP64で60TFLOPSの計算が可能だ。また、FP8 のサポートも強化しており、最大 4,000 TFLOPS の演算が可能で、A100(ネイティブの FP8 サポートがないため FP16 に頼らざるを得なかった)の 6 倍の速度を実現している。パフォーマンスを最適化するために、NVIDIAは新しい「Transformer Engine」を搭載しており、ワークロードに応じてFP8とFP16のフォーマットを自動的に切り替えられるという。

第 2 世代の Secure Multi-Instance GPU

Multi-Instance GPU(MIG)テクノロジーにより、単一の GPU を 7 つの小さな独立したインスタンスに分割し、多様なジョブを処理できる。「Hopper」アーキテクチャは、各 GPU インスタンスのクラウド環境で安全なマルチテナント構成を提供することにより、MIG の能力を前世代の最大 7 倍に拡張する。

コンフィデンシャル コンピューティング

H100 は、処理中に AI モデルと顧客データを保護するコンフィデンシャル コンピューティング機能を備えた世界初のアクセラレータとなる。これにより、GPU内部のデータをすべて暗号化して取り扱う事が出来るという。顧客は、共有クラウド インフラストラクチャだけでなく、ヘルスケアや金融サービスなどプライバシーに特に敏感な業界のために、連合学習 (Federated Learning) にコンフィデンシャル コンピューティングを適用することも可能だ。

第 4 世代 NVIDIA NVLink

最大規模の AI モデルを高速化するために、NVLink は新しい外部 NVLink Switch と組み合わせて、サーバーを超えたスケールアップ ネットワークとして NVLink を拡張し、NVIDIA HDR Quantum InfiniBand を使用する前世代の 9 倍の帯域幅で最大 256 基の H100 GPU を接続する。

DPX 命令

H100では、CUDAのプログラミングモデルが新しい「DPX」命令に対応した。これにより、動的計画法(ゲノミクス、量子コンピューティング、ルート最適化などのアルゴリズムで使用される問題解決手法)を、CPUと比較して最大40倍高速化するという。

動的計画法とは、膨大な計算量が必要となる主問題を複数の小さな問題に分割し、その小さな問題の計算結果を記録しながら最終的に主問題を解いていくポピュラーなアルゴリズムだ。これにより、時間と計算量を節約することが可能となる。

動的計画法を活用した物には、倉庫環境で自律動作ロボット群の最適なルートを見つけるための Floyd-Warshall アルゴリズム、および DNA やタンパク質の分類と折りたたみのシーケンス アラインメントで使用される Smith-Waterman アルゴリズムが含まれる。

NVIDIA H100 GPUにおいて対応した「DPX」命令は、NVIDIA Ampere アーキテクチャベースの GPU と比較して、動的計画法のアルゴリズムを最大で 7 倍、また一般的なCPUと比較して、最大40倍加速させることができるという。

NVIDIA H100の幅広い製品展開

H100の発表に伴い、搭載製品なども多数発表された。

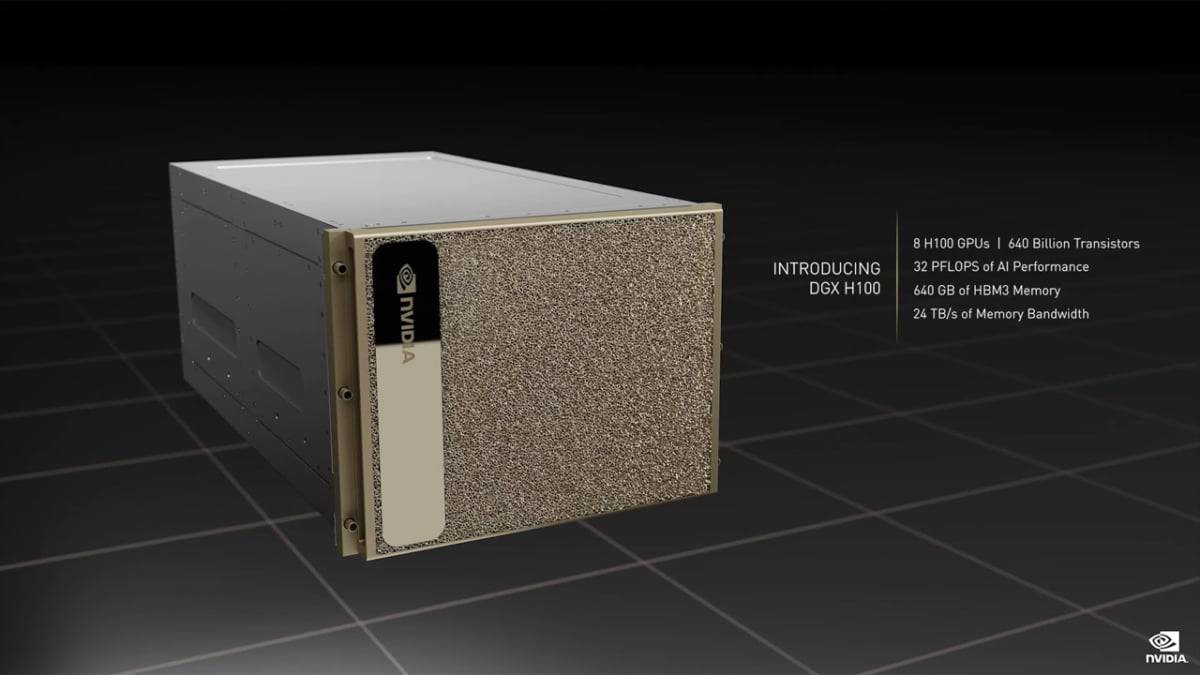

「DGX H100」と派生商品

「DGX H100」は、H100を8基搭載したAI開発の基本システムだ。大規模言語モデル、レコメンダー システム、ヘルスケア研究、気候科学の大規模なコンピューティング用途を想定している。

また、NVLink Switchを用いてDGX H100を32基相互接続することで、計256基のH100を搭載したスーパーコンピュータシステム「DGX POD with DGX H100」も発表された。

さらに,18台のDGX SuperPOD with DGX H100を,360基のNVLink Switchと500基のQuantum-2 InfiniBandスイッチで相互接続した巨大なスーパーコンピュータシステム「NVIDIA EOS」も発表された。NVIDIA EOSにおけるH100 GPUの総数は4608基となり、FP8で18 EFLOPS,FP64で275 PFLOPSという世界最速のAI開発向けスーパーコンピュータになるとのことだ。

その他、既存のサーバーに搭載できるH100システムとして、PCIe 4.0 x16接続で使える「H100 CNX」が発表となった。

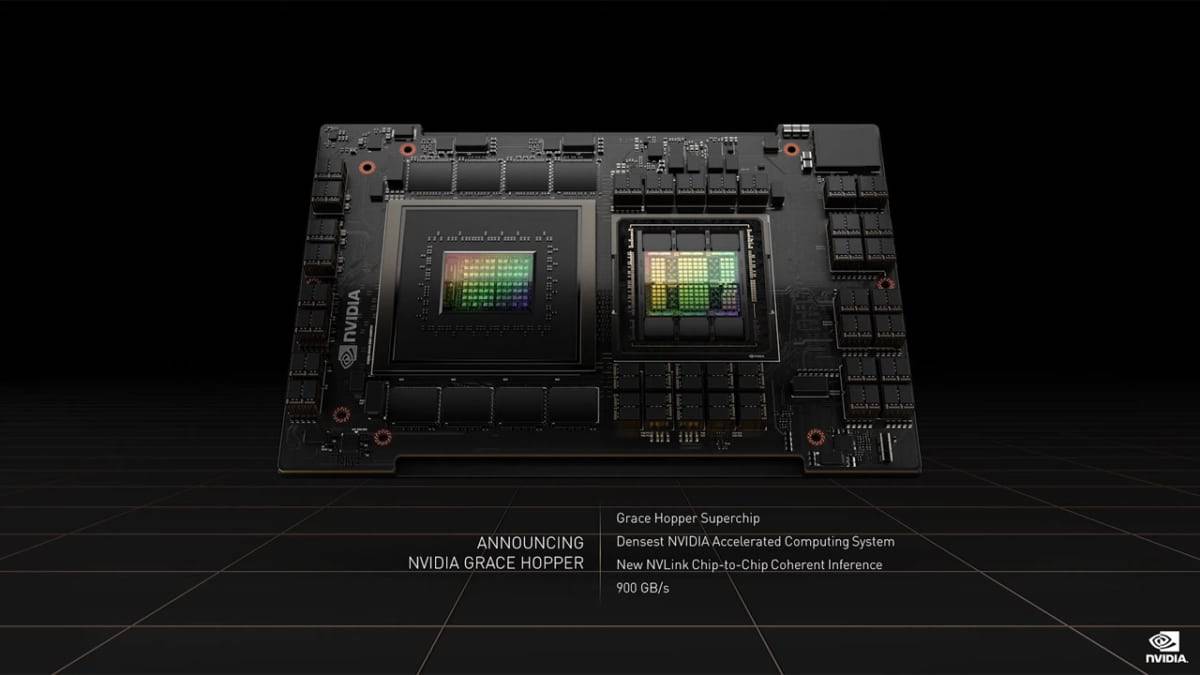

「Grace Hopper Superchip」

2021年に発表したArmアーキテクチャベースのサーバ向けCPU「Grace」と、今回発表となったH100と同じHopperアーキテクチャーベースのGPUを1パッケージ化した「Grace Hopper Superchip」を発表した。

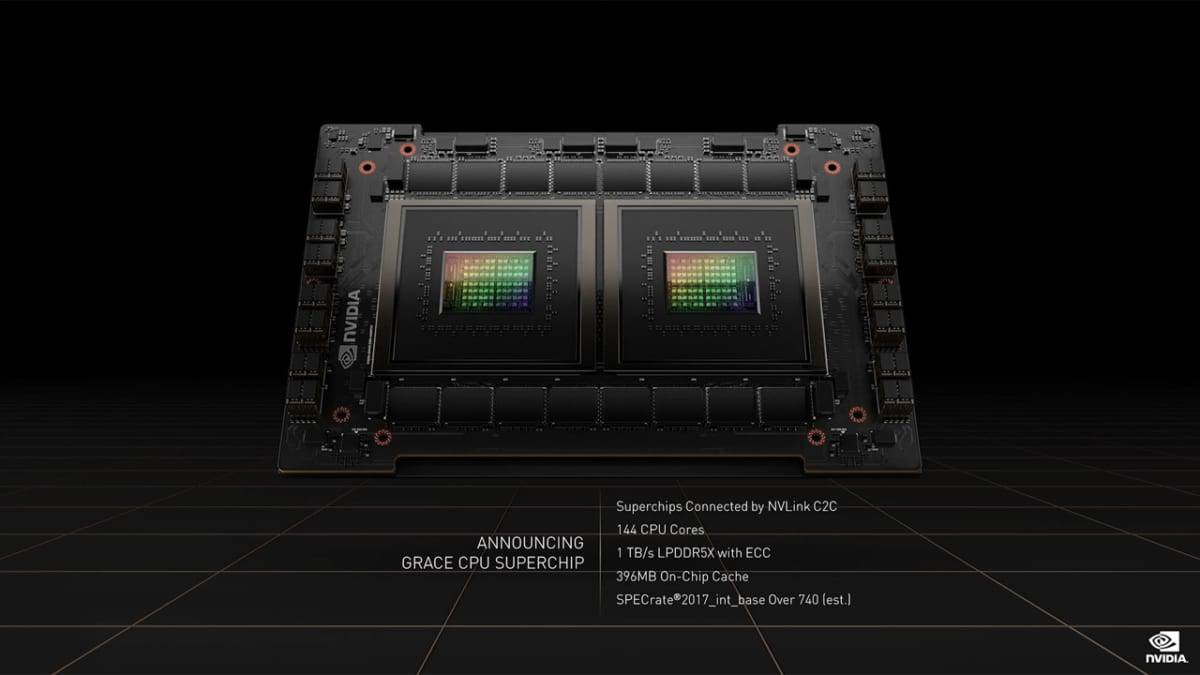

またGraceを2ダイ1パッケージにまとめた「Grace CPU Superchip」も同時に発表となっている。

ゲーム向けGeForceへの影響

今回発表されたのは、あくまで「サーバー向けGPU」となり、ゲーム向けのコードネーム「Ada Lovelace」とは異なる物になるが、アーキテクチャとしては同じ「Hopper」が採用されるため、一定の参考にはなるだろう。

PCIe5.0の採用や、HBM3への対応などは可能性が高そうだ。また、Tensor CoreのFP8対応、CUDA CoreのDPX命令対応、AES256暗号化対応セキュリティ機能と言った機能も実装される可能性がある。

年末には発売されるとされる、GeForce RTX 4000シリーズだが、その性能を想像し、今から楽しみだ。

NVIDIAデータセンター向けGPU仕様一覧

| GH100 | GA100 | GV100 | GP100 | |

|---|---|---|---|---|

| トランジスタ数 | 800億個 | 542億個 | 211億個 | 153億個 |

| ダイサイズ | 814mm² | 828mm² | 815mm² | 610mm² |

| アーキテクチャ | Hopper | Ampere | Volta | Pascal |

| 製造プロセスルール | TSMC N4 | TSMC N7 | 12nm FFN | 16nm FinFET + |

| GPUクラスター | 132/114* | 108 | 80 | 56 |

| CUDAコア | 16896/14592* | 6912 | 5120 | 3584 |

| L2キャッシュ | 50MB | 40MB | 6MB | 4MB |

| Tensorコア | 528/456* | 432 | 320 | – |

| メモリバス | 5120ビット | 5120ビット | 4096ビット | 4096ビット |

| メモリー容量 | 80 GB HBM3 / HBM2e * | 40 / 80GB HBM2e | 16/32 HBM2 | 16GB HBM2 |

| TDP | 700W / 350W * | 250W / 300W / 400W | 250W / 300W / 450W | 250W / 300W |

| インターフェース | SXM5 / * PCIe Gen5 | SXM4 / PCIe Gen4 | SXM2 / PCIe Gen3 | SXM / PCIe Gen3 |

| 発売年 | 2022 | 2020 | 2017 | 2016 |

Source

コメントを残す