最近オンラインをよく利用している人なら、『Midjourney』や『DALL-E 2』のようなテキスト画像生成ツールによって作成された幻想的な画像を目にしたことがあるかもしれない。

AIジェネレーターを使った画像作成は、かつてないほどシンプルになった。しかし同時に、私たちの最新の研究が示すように、これらの出力は偏見を再生産し、不平等を深める可能性がある。

画像生成AIの仕組み

AIベースの画像ジェネレーターは、テキスト入力を受けて、説明に一致する1つ以上の画像を生成する機械学習モデルを使用する。これらのモデルを訓練するには、数百万枚の画像を含む膨大なデータセットが必要である。

Midjourneyは、そのアルゴリズムの正確な動作方法については不透明であるが、ほとんどのAI画像ジェネレーターは“拡散 (Diffusion)”と呼ばれるプロセスを使用している。拡散モデルは、学習データにランダムな「ノイズ」を加え、このノイズを除去することでデータを復元するように学習することで機能する。モデルは、プロンプトと一致する画像が得られるまでこのプロセスを繰り返す。

これは、ChatGPTのような他のAIツールを支える大規模言語モデルとは異なる。大規模言語モデルは、ラベル付けされていないテキストデータで学習され、それを分析して言語パターンを学習し、プロンプトに対する人間のような応答を生成する。

バイアスはどのように起こるのか?

生成AIでは、入力が出力に影響を与える。ユーザーが特定の肌色や性別の人だけを画像に含めたいと指定すれば、モデルはそれを考慮する。

しかしそれ以上に、モデルは特定の種類の出力を返すデフォルトの傾向も持っている。これは通常、基礎となるアルゴリズムがどのように設計されているか、または学習データに多様性がないことの結果だ。

私たちの研究では、Midjourneyが一見一般的な用語を、専門的なメディア職業(「ニュース・アナリスト」、「ニュース・コメンテーター」、「ファクト・チェッカー」など)と非専門的な職業(「ジャーナリスト」、「レポーター」、「特派員」、「報道関係者」など)の文脈でどのように視覚化するかを調査した。

我々は昨年8月に結果の分析を開始した。それから半年後、時間の経過とともに何か変化があったかどうかを確認するため、同じ質問に対して追加の画像セットを作成した。

この期間に合計で100以上のAIが生成した画像を分析した。結果は時間の経過とともにほぼ一貫していた。以下は、結果に現れた7つのバイアスである。

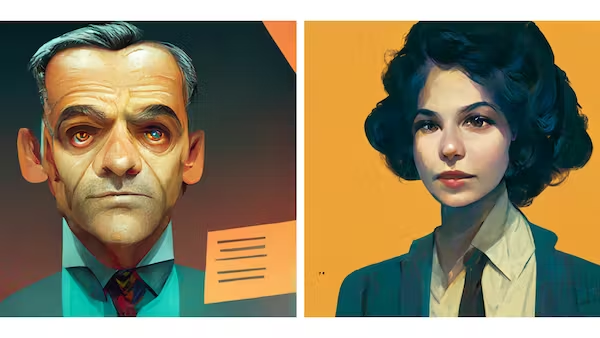

1と2。年齢差別と性差別

非専門職の場合、Midjourneyは若い男女の画像だけを返した。専門的な職種では、若い人と年配の人の両方が表示されたが、年配の人は常に男性だった。

これらの結果は、高齢者は非専門的な仕事では働かない(あるいは働けない)、高齢の男性だけが専門的な仕事に向いている、あまり専門的でない仕事は女性の領域である、といった思い込みを含む多くの偏見を暗黙のうちに補強している。

また、男女の表現方法にも顕著な違いがあった。例えば、女性は若くてシワがないが、男性はシワがあっても「許される」。

AIはまた、より流動的なジェンダー表現の例を示すのではなく、ジェンダーを二元論として提示しているように見えた。

3.人種的偏見

「ジャーナリスト」、「記者」、「特派員」などの用語で返された画像はすべて、肌の白い人ばかりが登場する。デフォルトで白人であるとするこの傾向は、システムに組み込まれた人種的ヘゲモニーの証拠である。

これは、基礎となるトレーニングデータの多様性と代表性の欠如を反映している可能性がある。

4と5階級主義と保守主義

画像に登場する人物はすべて、外見も「保守的」であった。例えば、タトゥーやピアス、型破りなヘアスタイルなど、保守的な主流派の描写と区別できるような属性を持つ人物はいなかった。

また、ボタン付きのシャツやネクタイなど、階級を示す正装をしている者も多かった。このような服装は、テレビの司会者などの特定の役割には求められるかもしれないが、一般的な記者やジャーナリストの服装を正確に反映しているとは限らない。

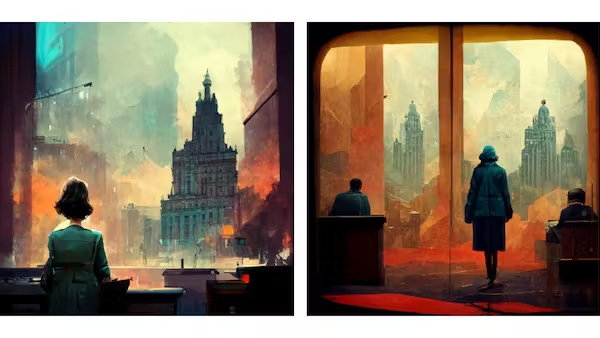

6.都市主義

AIは、場所や地理的な背景を特定することなく、すべての人物を高層ビルやその他の大きな都市ビルがそびえ立つ都市環境に配置した。世界人口の半分強しか都市に住んでいないにもかかわらず、である。

このようなバイアスは、私たちが自分自身をどのように見ているか、そして社会の他の部分とのつながりの度合いに影響を与える。

7.時代錯誤

デジタル技術がサンプルに占める割合は低かった。代わりに、タイプライター、印刷機、特大のビンテージカメラなど、明らかに異なる時代のテクノロジーがサンプルを埋め尽くしている。

最近では、多くの専門家が似たような姿をしているため、AIは役割の表現をより明確にするために、(歴史的なものを含む)より明確なテクノロジーを利用しているようだ。

今度、AIが生成した画像を目にしたとき、それがどの程度幅広い人々を代表しているのか、また、その中の表現から誰が利益を得る立場にあるのか、自問してみてほしい。

同様に、自分で画像を生成する場合は、プロンプトを作成する際に潜在的なバイアスを考慮すること。そうでなければ、社会が何十年もかけて学び直そうとしてきた有害な固定観念を、無意識のうちに強化してしまうことになりかねない。

コメントを残す