複雑なニューラルネットワークの働きを解釈するという課題は、特にその規模と洗練度が増すにつれて、人工知能開発における大きなハードルとなってきた。これらのモデルが進化するにつれて、その挙動を理解することは、効果的な展開と改善のためにますます重要になってくる。だがニューラルネットワークを説明する従来の方法は、多くの場合、人による大規模な監視を必要とし、スケーラビリティを制限していた。マサチューセッツ工科大学(MIT)のコンピュータ科学・人工知能研究所(CSAIL)の研究者たちは、事前に訓練された言語モデルから構築された自動解釈エージェント(AIA)を利用して、ニューラルネットワークの動作を自律的に実験・説明する新しいAI手法を提案することで、この問題に取り組んでいる。

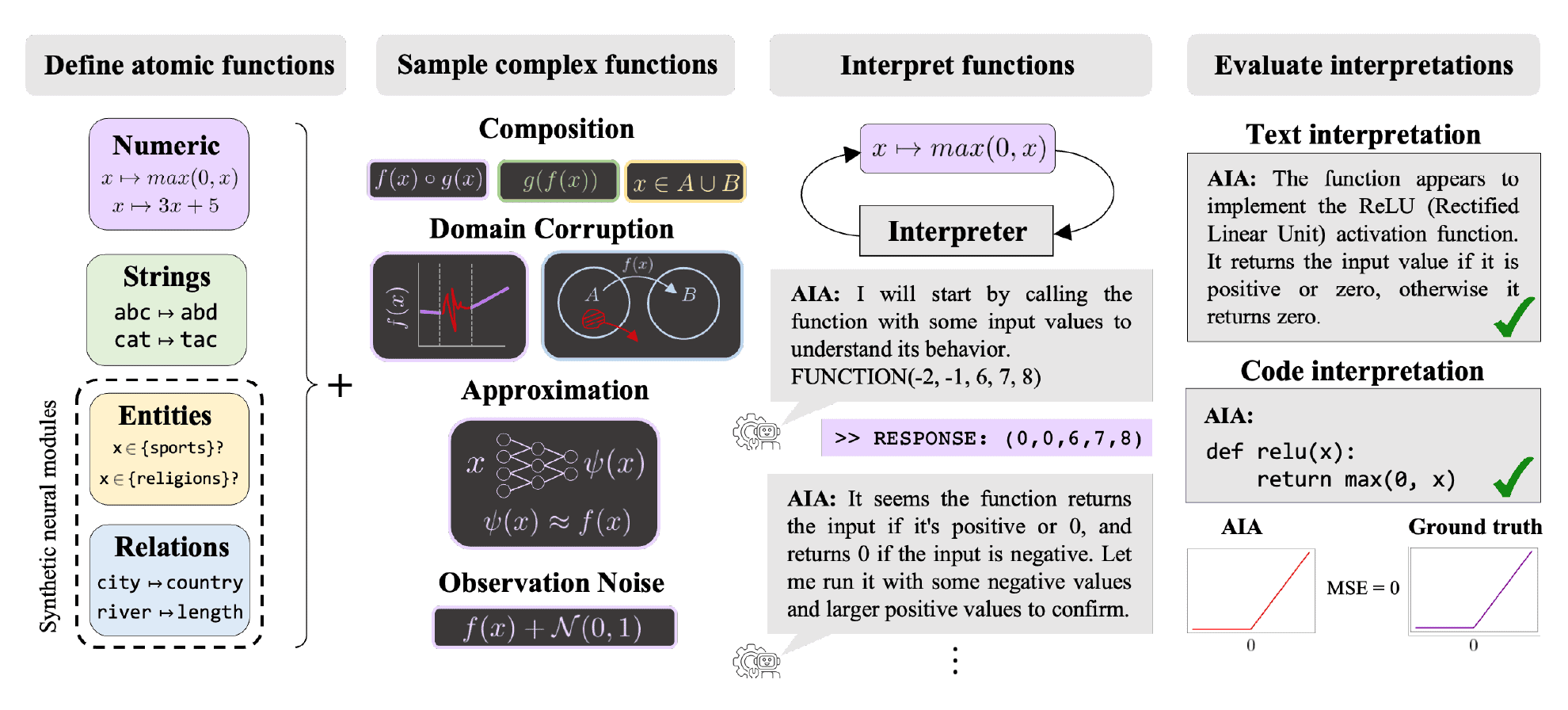

従来のアプローチでは、ニューラルネットワークを解釈するために人間が実験や介入を行うのが一般的だった。しかし、MITの研究者たちは、AIモデルの力をインタープリターとして活用する画期的な手法を導入した。この自動解釈エージェント(Automated Interpretability Agents: AIA)は、仮説形成、実験的検証、反復学習に積極的に取り組み、科学者の認知プロセスをエミュレートする。複雑なニューラルネットワークの説明を自動化することで、この革新的なアプローチは、GPT-4のような複雑なモデル内の各計算を包括的に理解することを可能にする。さらに、「機能解釈と記述」(FIND)ベンチマークを導入し、実世界のネットワーク構成要素に対する説明の正確さと質を評価する基準を設定した。

AIAは、科学者が他のコンピューター・ネットワークを設計し、テストを実行する実験プロセスを模倣するように設計されている。

AIAは、システムの機能やエラーに関する言語記述、システムの動作を再現するコードなど、さまざまな形式で説明を提供する。

MITの研究者によれば、AIAは既存の解釈的アプローチとは異なる。彼らは仮説生成、実験的テスト、反復学習に積極的に参加する。この積極的な参加により、彼らは他のシステムに対する理解をリアルタイムで洗練させ、複雑なAIシステムがどのように機能するかについて、より深い洞察を得ることができる。

FINDベンチマーク

研究者の重要な貢献は、FIND(Function Interpretation and Description)ベンチマークである。このベンチマークには、学習済みネットワークの計算に似た関数のテストベッドが含まれている。これらの関数には、その動作の説明がついている。

研究者は多くの場合、関数の真実のラベルや学習された計算の記述にアクセスすることができない。FINDの目標は、この問題を解決し、解釈可能性手順を評価するための信頼できる基準を提供することである。

FINDベンチマークの一例は、合成ニューロンである。これは言語モデルにおける実際のニューロンの振る舞いを模倣したもので、”地上交通機関”のような特定の概念に対して選択的である。

AIAはこれらのニューロンにブラックボックスでアクセスし、ニューロンの応答をテストするための入力を設計する。例えば、「自動車」に対するニューロンの選択性を、他の交通手段に対してテストする。

そのために、あるニューロンが他の入力よりも「車」に強く反応するかどうかを判断する。そしてその記述を、合成ニューロンの真実の記述、つまり “地上交通機関 “の記述と比較する。こうして、個々のニューロンの役割を割り出すのである。

しかし、説明を提供するモデル自体がブラックボックスであるため、解釈方法の外部評価がますます重要になってきている。

FINDベンチマークは、観測された行動をモデル化し、数学的推論から文字列の記号操作まで様々な領域をカバーする、既知の構造を持つ関数群を提供することで、このニーズに応えることを目的としている。

この研究の共著者であるSarah Schwettmann氏は、このアプローチの利点を強調する。AIAは独自に仮説を立て、検証することができる。そのため、他の方法では発見が困難な行動を発見することができる。

「ground truth(真実の根拠)」によるベンチマークは、言語モデルの進化を促してきた。Schwettmann氏は、FINDが解釈可能性研究において同様の役割を果たすことを期待している。

現在、FINDベンチマークは、AIAアプローチの改善が必要であることを示している。ベンチマークに含まれる関数の半分近くを記述できないのだ。

AIAは、「特にノイズや不規則な振る舞いをする関数のサブドメインにおいて」、より細かい詳細を見逃してしまう。とはいえ、AIAは既存の解釈手法よりも優れた性能を示した。

研究チームはまた、ニューラルネットワークを用いてより正確な実験を行うために、AIAの能力を向上させるツールキットにも取り組んでいる。このツールキットは、入力の選択と仮説検証の精緻化のためのより良いツールをAIAに提供することを目的としている。

チームはまた、実世界のシナリオでモデルを分析する際に正しい質問をする方法を調査することで、AIの解釈可能性に関する実用的な課題にも焦点を当てている。目標は、自動化された解釈可能性手順を開発することである。

これらの方法は、AIシステムが導入される前に、起こりうるエラーや隠れたバイアス、予期せぬ挙動を人間がチェックし、診断できるようにすることを目的としている。次のステップとして、研究者たちは他のAIシステムをテストする自律型に近いAIAを開発したいと考えている。人間の科学者が監督し、助言する。高度なAIシステムは、人間の科学者の当初の考えを超えた新しい実験や質問を開発することができる。

論文

参考文献

- MIT News: AI agents help explain other AI systems

研究の要旨

ニューラルネットワークのサブモジュールに、人間が読み取れるような記述でラベリングすることは、多くの下流タスクに有用である。現在までのところ、学習されたネットワークのメカニズム的な記述のほとんどは、小さなモデル、限定された現象、そして大量の人手によって行われています。サイズと複雑さが増すモデルにおいて、人間が解釈可能なすべてのサブ計算にラベルを付けるには、記述を自動的に生成し、検証できるツールがほぼ確実に必要となる。最近、学習されたモデルをイン・ザ・ループでラベリングに使用する技術が普及し始めているが、その有効性を評価する方法は限られており、場当たり的である。オープンエンドラベリングツールをどのように検証し、比較すればよいのだろうか。本稿では、自動解釈可能性手法の構成要素を評価するためのベンチマーク・スイートであるFIND(Function INterpretation and Description)を紹介する。FINDには、訓練されたニューラルネットワークの構成要素に似た関数と、我々が生成しようとする種類の付随する記述が含まれている。これらの関数は、テキストと数値の領域にわたって手続き的に構築されており、ノイズ、合成、近似、バイアスなど、実世界のさまざまな複雑性を含んでいる。我々は、事前に訓練された言語モデル(LM)を使用して、関数の動作のコードベースおよび自然言語記述を生成する方法を評価する。さらに、AIA(Automated Interpretability Agent)が関数記述を生成する新しい対話的手法を紹介する。AIAは、既製のLMに関数へのブラックボックスアクセスを追加したもので、仮説の形成、実験の提案、新しいデータに照らした記述の更新など、科学者の役割を果たしながら、関数構造を推論することができる。しかし、FINDは、LMベースの記述は、局所的な詳細が欠落している一方で、大域的な機能挙動を捉えていることも明らかにした。これらの結果は、FINDが、より洗練された解釈可能性手法を実際のモデルに適用する前に、その性能を評価するのに有用であることを示唆している。

コメントを残す