AI分野における目覚ましい進歩として、Microsoft Azure Cognitive Service ResearchとUNC NLP(自然言語処理)チームの研究者が、複数のモダリティにまたがる高品質なコンテンツをシームレスに生成する能力を備えた最先端の生成モデル、「CoDi」を発表した。この画期的な開発により、世界と人間の理解をより包括的に理解するための新たな可能性が開かれ、没入感のある人間とAIとの相互作用のためのプラットフォームが提供され、人間とコンピュータとの関わり方が変革される。

Composable Diffusion(CoDi)は、統合的でコンポーザブルなマルチモーダルAIの開発を目指すMicrosoftのi-Codeプロジェクトによって発表された。これは、マルチモーダルAI能力の向上に特化した研究イニシアチブである。幅広いソースからの情報をシームレスに統合し、首尾一貫したアウトプットを生成する能力を持つCoDiは、人間とコンピュータの相互作用のいくつかの分野に革命をもたらすことを約束する。

論文では、CoDiを、テキスト、画像、動画、音声など様々なモダリティのコンテンツを処理し、同時に生成できる革新的な生成モデルとして紹介している。入力モダリティの多様な組み合わせから相乗的なコンテンツ生成を可能にすることで、CoDiは統合的でコンポーザブルなマルチモーダルAIシステムの探求における重要な一歩を提示するとのことだ。このモデルは、特定の入力モダリティに限定された従来の生成AIシステムとは異なるものだ。

今日のほとんどのモダリティの組み合わせではトレーニングデータセットが乏しいため、研究者たちは入力と出力の両方の空間でモダリティを一致させるアラインメント戦略を用いた。その結果、CoDiはどのような入力の組み合わせでも自由に条件付けができ、訓練データに存在しないモダリティであっても、どのようなモダリティの集合でも生成することができる。

CoDiが変革をもたらす可能性のある分野のひとつに、障害を持つ人がより効果的にコンピューターと対話できるようにする支援技術がある。CoDiは、テキスト、画像、動画、音声のコンテンツをシームレスに生成することで、より没入感のあるアクセシブルなコンピューティング体験をユーザーに提供することができる。

さらにCoDiは、包括的かつインタラクティブな学習環境を提供することで、カスタム学習ツールを再構築する可能性を秘めている。生徒は、様々なソースからの情報をシームレスに統合したマルチモーダルコンテンツに参加することで、教科への理解と関与を深めることができる。

クロスモーダルAI開発における課題

従来の単一モダリティAIモデルの限界に対処するため、CoDiは、モダリティ固有の生成モデルを組み合わせるという、しばしば面倒で時間のかかるプロセスに対する解決策を提供する。

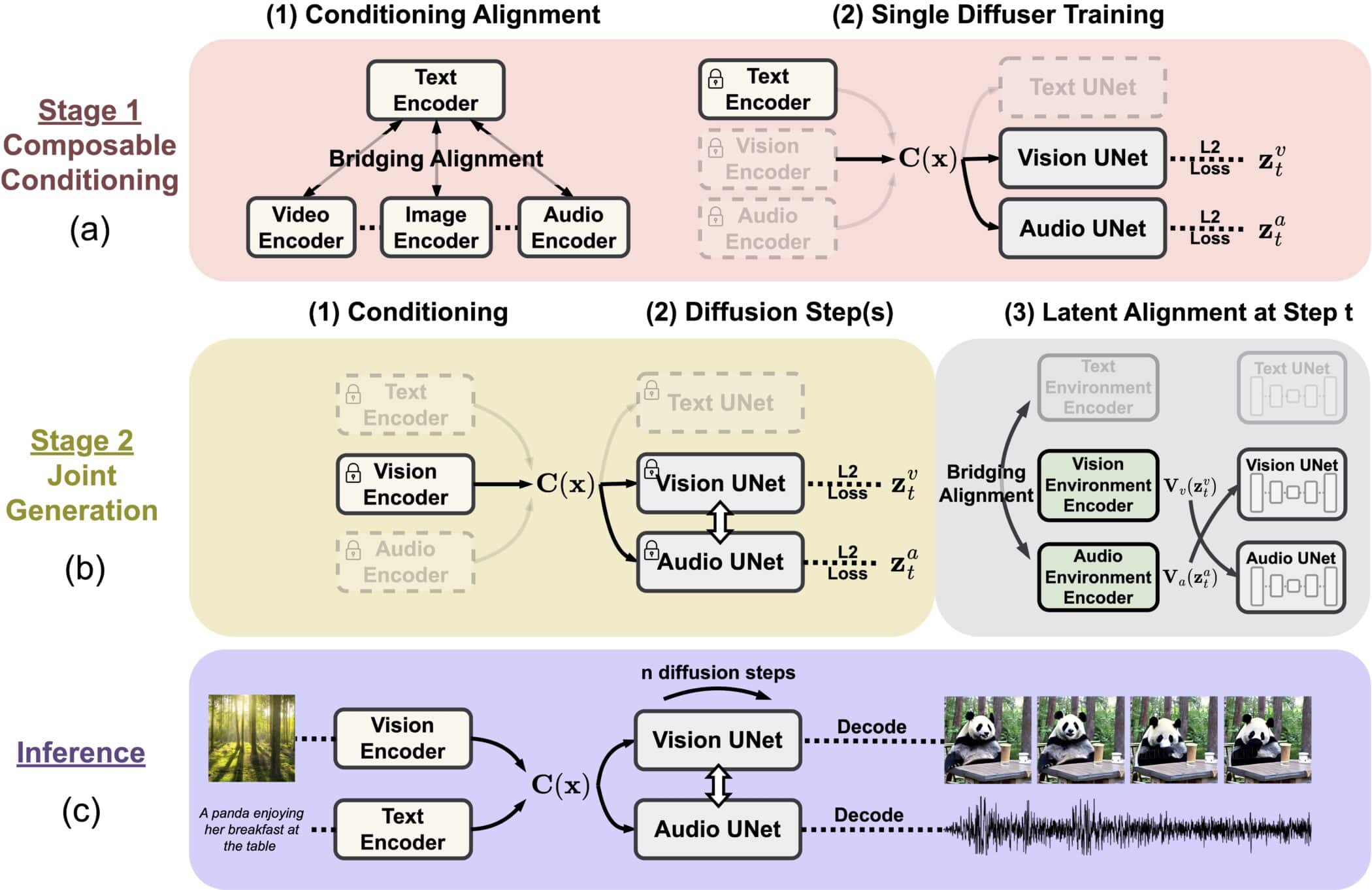

この斬新なモデルは、拡散プロセスにおけるアライメントを橋渡しし、時間的にアライメントされたビデオとオーディオのような、絡み合ったモダリティの同期生成を容易にする、独自のコンポーザブル生成戦略を採用している。

CoDiのトレーニングプロセスにも特徴がある。画像、ビデオ、音声、言語などの入力モダリティを共通の意味空間に投影する。これにより、マルチモーダル入力を柔軟に処理することができ、クロスアテンションモジュールと環境エンコーダーにより、あらゆる出力モダリティの組み合わせを同時に生成することができる。

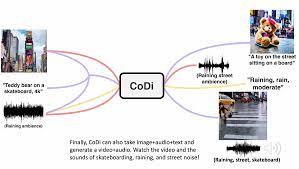

研究者らは、CoDiの能力の例を示し、別々のテキスト、音声、画像のプロンプトから同期したビデオと音声を生成する能力を実証している。ある例では、”teddy bear on skateboard, 4k, high resolution “というテキスト、タイムズスクエアの画像、雨音が入力された。

CoDiは、タイムズスクエアの雨の中でスケートボードをするテディベアの短いビデオを低画質ながら生成し、雨音とストリートノイズを同期させた。

CoDiの潜在的な用途は数多くある。研究者たちは、教育や障害者のためのアクセシビリティといった産業で使用できる可能性を強調している。

我々の研究は、より魅力的で総合的な人間とコンピュータのインタラクションに向けた重要な一歩であり、生成AIにおける将来の研究のための強固な基盤を確立するものである。

コンテンツ制作もまた、CoDiによって革新される。複数のモダリティにわたって高品質のアウトプットを生成するこのモデルの能力は、コンテンツ作成プロセスを合理化し、クリエイターの負担を軽減する可能性がある。魅力的なソーシャルメディア投稿の生成、インタラクティブなマルチメディア・プレゼンテーションの作成、魅力的なストーリーテリング体験の作成など、CoDiの機能は、コンテンツ生成の状況を再構築する可能性を秘めている。

AI分野が進歩を続ける中、CoDiのようなモデルは、マルチモーダルAIシステムの開発における重要なマイルストーンとなる。CoDiは、テキスト、画像、動画、音声にまたがる高品質のコンテンツをシームレスに生成する能力を備えており、より没入的で相互接続された人間とAIの未来の可能性を示している。研究者たちの研究成果は、さまざまな領域におけるAIの可能性を最大限に引き出し、コンピューターとの関わり方に革命を起こすことに一歩近づいたと言える。

論文

参考文献

- Microsoft Research Blog: Breaking cross-modal boundaries in multimodal AI: Introducing CoDi, composable diffusion for any-to-any generation

- CoDi: Any-to-Any Generation via Composable Diffusion

研究の要旨

我々は、入力モダリティの任意の組み合わせから、言語、画像、動画、音声などの出力モダリティの任意の組み合わせを生成することができる新しい生成モデル、Composable Diffusion(CoDi)を発表する。既存の生成AIシステムとは異なり、CoDiは複数のモダリティを並行して生成することができ、その入力はテキストや画像のようなモダリティのサブセットに限定されません。多くのモダリティの組み合わせの学習データセットがないにもかかわらず、我々は入力空間と出力空間の両方でモダリティを揃えることを提案する。これにより、CoDiは、訓練データに存在しないモダリティであっても、任意の入力の組み合わせを自由に条件付けし、任意のモダリティ群を生成することができる。CoDiは、拡散プロセスにおけるアライメントを橋渡しすることで共有マルチモーダル空間を構築する新しいコンポーザブル生成戦略を採用しており、時間的にアライメントされたビデオとオーディオのような、絡み合ったモダリティの同期生成を可能にする。高度にカスタマイズ可能で柔軟なCoDiは、強力なジョイントモダリティ生成品質を達成し、シングルモダリティ合成のためのユニモーダル最先端技術を凌ぐか同等である。デモとコードを含むプロジェクトページはcodi-gen.github.ioにある。

コメントを残す