Microsoftは、アプリ開発者のAIを取り入れた独自のアプリや体験の構築を支援するツールキット「Windows AI Studio」を発表した。Windows AI Studioは、Visual Studio Codeの拡張機能からアクセスでき、開発者はAIの開発と導入をより簡単に始めることができる。

Microsoftは、新しいWindows AI Studioについて以下のように説明している:

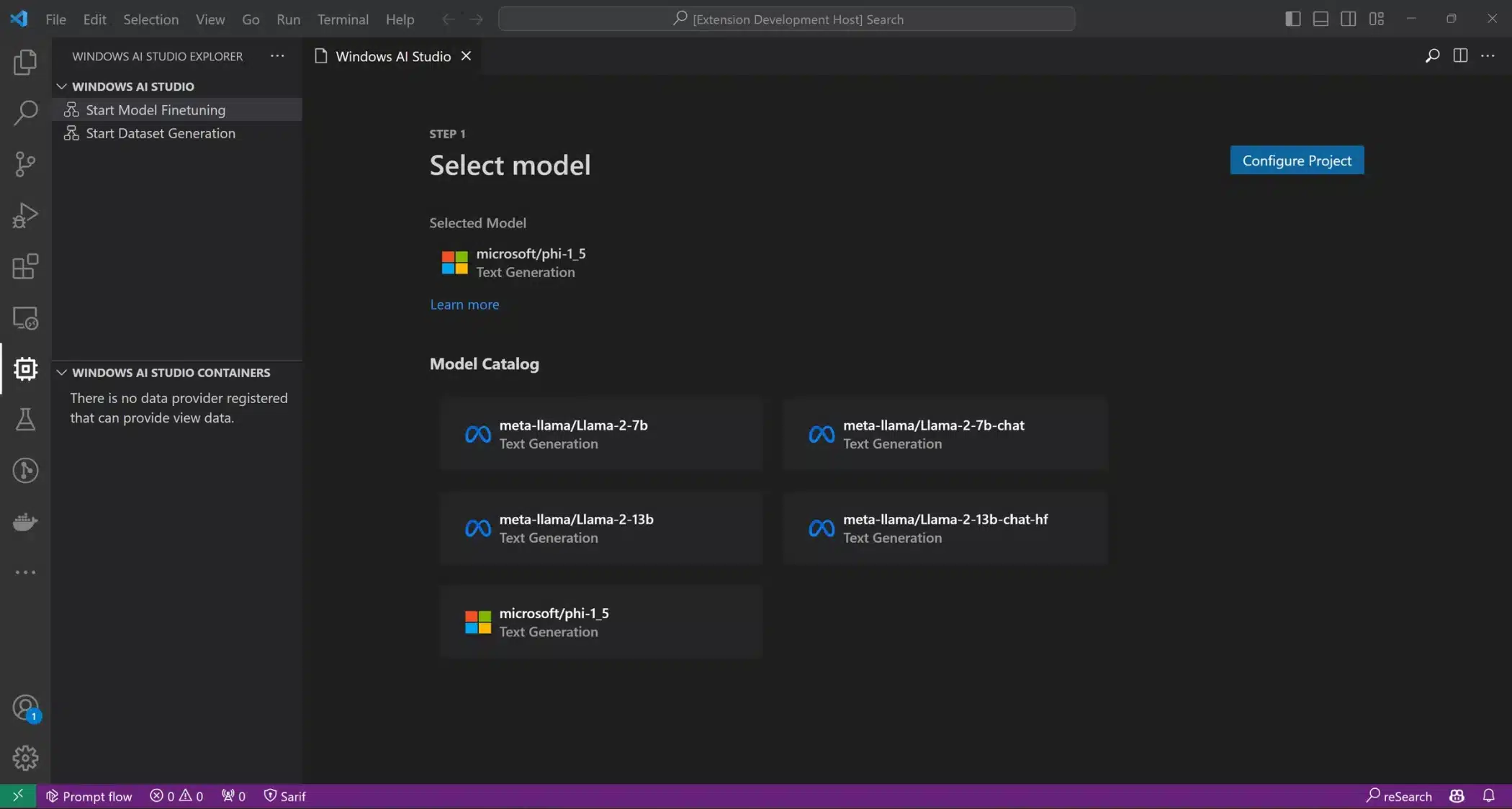

「Windows AI Studioは、Azure AI StudioやHugging Faceのような他のカタログから、最先端のAI開発ツールやモデルをまとめることで、生成AIアプリ開発を簡素化し、開発者がWindowsアプリでローカルに使用するために、最先端のスモール言語モデル(SLM)を微調整、カスタマイズ、デプロイできるようにします。これには、Phi、Llama 2、Mistralのような一般的なSLMを微調整するためのモデル構成UIとガイド付きウォークスルーを含む、e2eガイド付きワークスペースのセットアップが含まれます。開発者は、ワークスペースに統合されたPrompt FlowとGradioテンプレートを使用して、微調整したモデルを迅速にテストすることができます」。

Windows AI Studioは、開発者が何から始めるべきかを選択する手助けをしてくれる。Azure AI StudioやHugging Faceのようなところからツールやモデルを選べるので、開発者は人気のあるSmall Language Model(SLM)から選び、ニーズに合わせて微調整やカスタマイズができる。実際、このアプリには、Phi、Llama 2、MistralなどのSLMをカスタマイズしやすくするためのガイド付きセットアップ・プロセスが含まれている。

そして、Windows AI Studioは、ツールキットに組み込まれているPrompt FlowとGradioテンプレートを使った素早いテストも提供するので、意図したとおりに動作しているかどうかを素早く判断し、準備が整うまで継続的に微調整することができる。それが完了したら、ONNXモデル変換とOliveによる最適化を通じてモデルを最適化し、最後にモデルをアプリに統合することが出来るのだ。

Microsoftは加えて、Windows AI Studioが、Llama2-7B、Mistral-7B、Stable Diffusion XLなど、特にWindows GPUおよびNPU向けに最適化されたモデルを強調して表示するようになるとしている。これらの最適化されたモデルは、Windowsの機械学習APIであるDirectMLとONNX Runtimeを最大限に活用し、Windows上で可能な限り効率的に実行される。現在、Microsoftは、Llama 2 7Bが様々なWindowsハードウェア上でローカルに実行され、パフォーマンスを発揮するサンプルを公開している。

NVIDIAも同様に、TensorRT-LLMのアップデートを明らかにした。TensorRT-LLMは当初、H100 GPU上で大規模言語モデル(LLM)をより効率的に実行する方法としてWindows向けに発表された。しかし、この最新のアップデートにより、TensorRT-LLMは、8GB以上のRAMを搭載したGeForce RTX 30および40シリーズGPUを搭載したPCに提供される。

さらに、NVIDIAは近々、新しいラッパーを通じて、TensorRT-LLMをOpenAIのChat APIと互換性を持たせる予定だ。これにより、開発者はPC上でローカルにLLMを実行できるようになり、個人データをクラウドに保存することを懸念する開発者にとって理想的なものとなる。NVIDIAによると、次のTensorRT-LLM 6.0リリースでは、推論が最大5倍高速化され、新しいMistral 7BとNemotron-3 8Bモデルもサポートされる。

Windows AI Studioは、Microsoftの新しいCopilot Studioに加わるものだ。Copilot Studioは、企業顧客がMicrosoft Copilotに基づいて独自のAIチャットボットを作成できるサービスである。Copilot Studioはまた、Azure AIとその関連サービスとの統合が深まり、高度な機能を持つようになる。Microsoftによると、管理者はCopilotがどのように使用されているか、ユーザーの感情などを監視する完全な分析スイートを利用できるようになるという。

Sources

コメントを残す