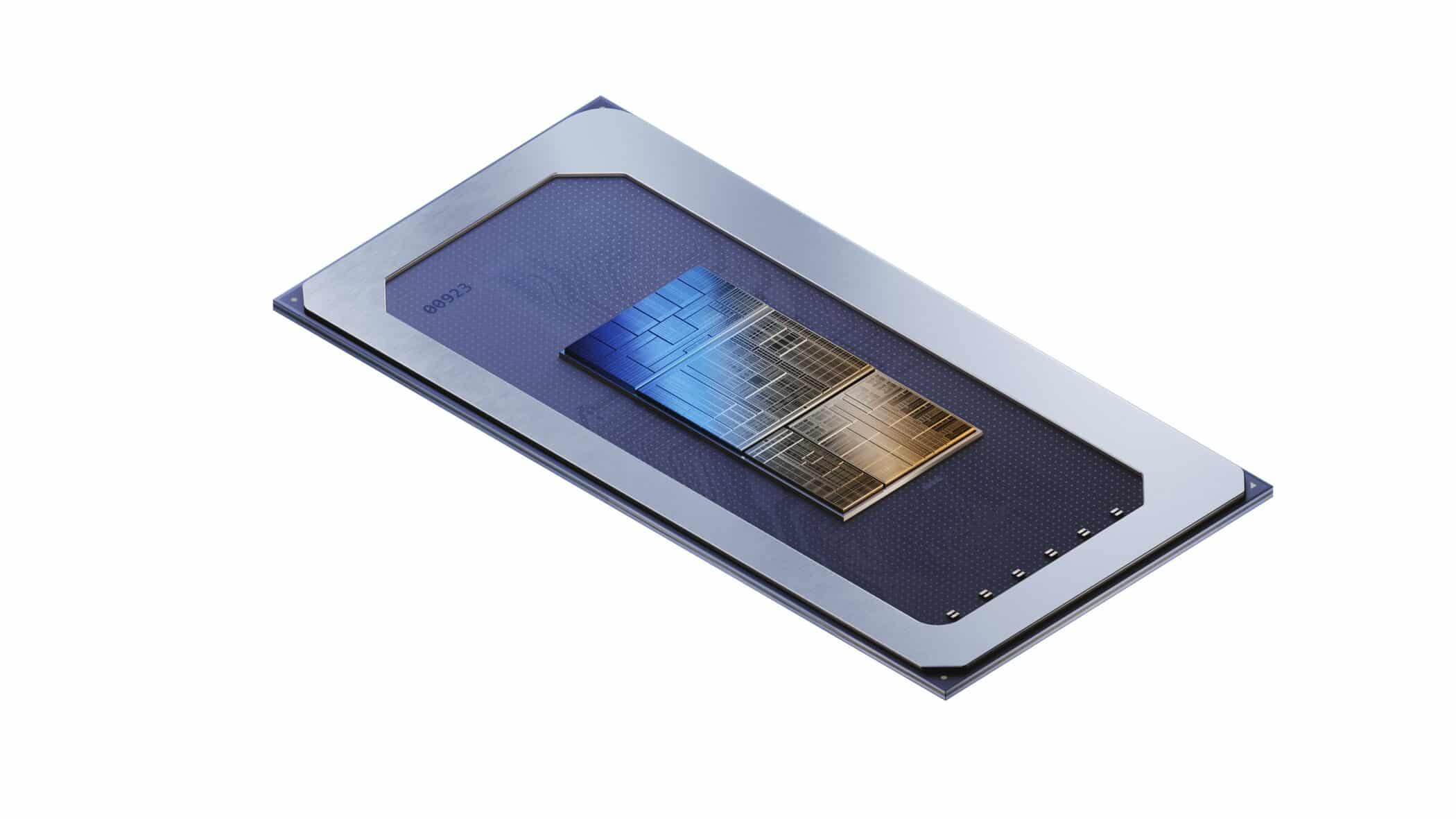

Intelは、同社の新しいMeteor Lakeノートパソコンに搭載されているNeural Processing Unit(NPU)と連動するためのWindowsおよびLinuxシステム用ユーザースペースライブラリ「NPUアクセラレーション・ライブラリ」をオープンソース化し、開発者や経験のある一般ユーザーが、Meteor LakeなどのIntel AI CPUを利用してAIチャットボットなどのAIエンジンを最適に動作させることが出来る様にしている。

今回の発表は、Intel自身の公式発表に先立ち、同社のテック・エバンジェリストであるTony Mongkolsmai氏によってもたらされた。

このライブラリは現在GitHubで公開されている。NPUアクセラレーション・ライブラリは、Meteor Lake「Core Ultra」シリーズなどのCPUラインナップから搭載されたNPUの潜在能力を活用するための便利なPythonライブラリだ。高レベルのインターフェースを提供することで開発を簡素化し、TensorFlowやPyTorchのような一般的なフレームワークをサポートすることで、開発者はAI関連のタスクを効率化するためにライブラリの機能を活用する力を得ることができる。

Mongkolsmai氏は、Intel Core Ultra CPUを搭載したMSI Prestige 16 AI EvoラップトップでNPUアクセラレーション・ライブラリを実行していた。彼はこのマシンでTinyLlamaとGemma-2b-it LLMモデルをパフォーマンスの中断なしに実行することができる事を示し、IntelのNPUを用いて、開発者のためのエッジAI環境をどのように促進するかを見せている。以下は、Intelの開発チーム自身によるライブラリの説明である:

Intel® NPU アクセラレーション・ライブラリーは、Intel® Neural Processing Unit (NPU) のパワーを活用し、互換性のあるハードウェア上で高速計算を実行することで、アプリケーションの効率を高めるために設計された Python ライブラリーです。

ライブラリーのパフォーマンスを大幅に向上させるため、以下のような主要機能の実装に取り組んでいます:

- 8ビット量子化

- 4ビット量子化とGPTQ

- NPU-ネイティブ混合精度推論

- Float16サポート

- BFloat16(脳浮動小数点フォーマット)

- torch.compileサポート

- LLM MLP水平フュージョン実装

- 静的形状推論

- MHA NPU推論

- NPU/GPUヘテロ計算

- Paper

NPUアクセラレーション・ライブラリはその名の通りNPU向けに作られており、現時点ではMeteor Lakeしか実行できない。今年後半に予定されているArrow LakeとLunar LakeのCPUにもNPUは搭載され、この傾向も続くだろう。これらの次期CPUは、Meteor Lakeの3倍のAI性能を提供し、ラップトップやデスクトップ・シリコン上でさらに大規模なLLMを実行できるようになる可能性が高い。

Intel NPUアクセラレーション・ライブラリーは、8ビット量子化、Float16サポート、torch.compileサポート、静的形状推論、その他の機能をサポートしている。これは、GitHubからダウンロードするか、PIP経由でインストールすると便利だ。

Source

- GitHub: intel/intel-npu-acceleration-library

コメントを残す