急速に進化する大規模言語モデル(LLM)の世界では、プロンプト・インジェクション攻撃という新たな脅威が出現している。これらの攻撃は、ChatGPTのようなチャットボットの出力を操作し、システムの脆弱性を突くものだ。こうしたセキュリティ上の懸念が高まっている中、今回これらの攻撃に対抗するための驚くべきソリューションが提案されている。

プロンプト・インジェクション攻撃は、新しい現象ではない。SQLクエリが信頼できない入力を受け入れるようになってから、ずっと存在するものだ。この攻撃は、チャットボットのテキストプロンプトのような信頼できる入力に信頼できない入力を追加し、その両方を受け入れるようにしてプログラムをだますという手法だ。これにより、ユーザーはLLMのプログラミングを回避することが出来る。

この問題を解決する可能性がある方法について、Andrew Ng氏とIsa Fulford氏による開発者向けのプロンプト・エンジニアリングに関する講座で新たに提案されたものがある。Fulford氏は、信頼できる入力と信頼できない入力を区別するために「デリミタ」を使用することを提案した。しかし、この解決策は、SQLデータベースには有効だが、トークン・ベースの入力システムのため、LLMには適用できない。

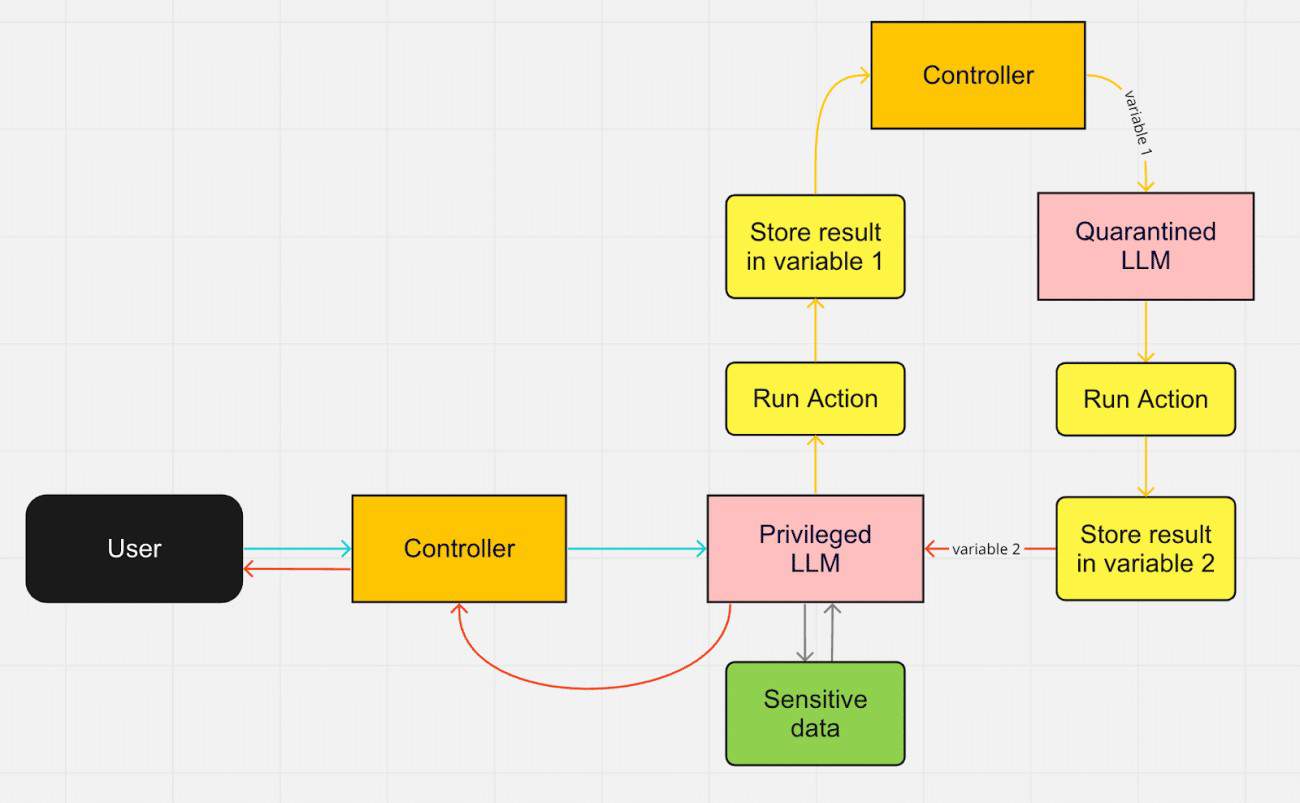

Datasette氏の創設者でDjangoの共同開発者であるSimon Willison氏は、LLMを2つ使うという応急処置を提案した。このデュアルLLMアーキテクチャでは、1つのLLMは特権を持ち、信頼できる入力を受け付け、もう1つは隔離され、信頼できないコンテンツを処理するのだ。コントローラーコンポーネントは、LLMをトリガーしてユーザーと対話する。特権LLMのみにデータへのアクセスを与え、その出力を隔離LLMを通して解析することで、プロンプト・インジェクション攻撃から保護することができるという考えだ。

しかし、このような保護の必要性は短期間で終わるかも知れない。専門家によると、プロンプト・エンジニアリングとプロンプト・インジェクションは、過渡期の技術似すぎないという意見もある。将来のLLMは、慎重に構築されたプロンプトを必要としない可能性があるという訳だ。OpenAIのCEOであるSam Altman氏も、5年後にはプロンプト・エンジニアリングを行う必要が無くなると考えている。また、トークン化が廃止され、プロンプト・インジェクション攻撃の攻撃ベクトルが減少する可能性を示唆する研究結果も出てきている。

LLMにおけるプロンプト・インジェクションは最近発見された脆弱性であり、その影響のほとんどは、機密データや強力なツールにアクセスできるLLMにある。しかし、現在のLLMを中心としたAI研究のペースは、既存の技術を陳腐化させる可能性が高い。その結果、プロンプト・インジェクション攻撃は、問題にならなくなるまで緩和されるかも知れない。

Sources

- Simon Willison’s Weblog: The Dual LLM pattern for building AI assistants that can resist prompt injection

コメントを残す