清華大学、上海人工知能研究所、01.AIの研究者は、大規模言語モデルを進歩させる上で重要な側面の1つである、モデルが依拠する学習データの質に焦点を当て、混合品質データを使用してオープンソースの言語モデルを強化するという課題に取り組むための「OpenChat」と呼ばれる新しいフレームワークを開発した。

専門家が生成したデータと最適でないデータを含む混合品質データは、言語モデルの学習において重要な課題となる。GPT-4のような最先端のモデルによって生成された専門家データは一般的に高品質であり、学習のためのゴールドスタンダードとして機能する。一方、GPT-3.5のような古いモデルで生成された最適でないデータは、品質が低く、学習中に問題が発生する可能性がある。今回の研究は、このような混合品質のデータシナリオを認識し、オープンソースの言語モデルの命令追従能力を向上させることを目的としている。

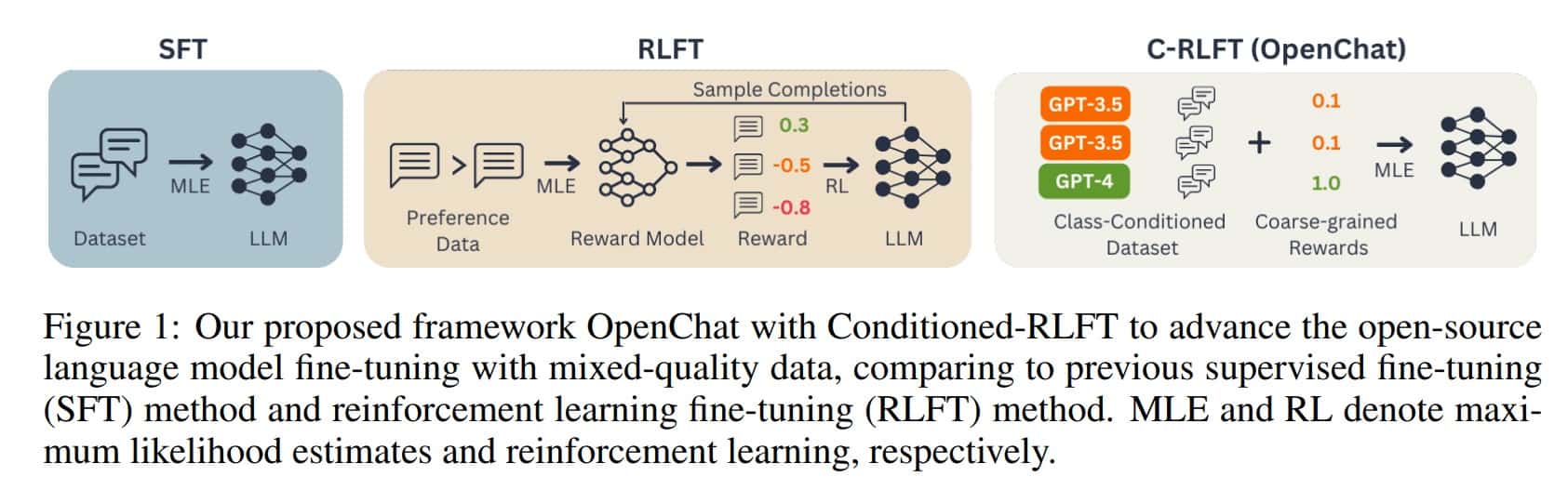

一般的に言語モデルのトレーニングで使用されている手法の1つに、教師ありファインチューニング(SFT)がある。SFTでは、モデルは、正しい応答を生成するガイドとなる、質の高い専門家が生成したデータを使用して、指示に従うタスクで訓練される。さらに、強化学習ファインチューニング(RLFT)手法も人気がある。RLFTでは、人間から嗜好のフィードバックを収集し、その嗜好に基づいて報酬を最大化するようにモデルを訓練する。

LLaMAやLLaMA2のようなオープンソースの言語モデルは、誰でもプログラムコードを検査し理解することができるが、多くの場合、SFTやRLFTのようなテクニックを使用して洗練され最適化される。

これらの手法は、使用されるすべてのデータが同じ品質であることを前提としている。しかし実際には、データセットは通常、最適なデータと比較的質の低いデータが混在している。これは言語モデルの性能を損なう可能性がある。

この問題を解決するため、研究者らは、OpenChatという革新的な手法を提案している。OpenChatは、オープンソースの言語モデルを混合品質データを使って強化する革新的なフレームワークである。その中核にあるのは、条件付き強化学習微調整(C-RLFT)であり、学習プロセスを簡素化し、報酬モデルへの依存を減らす新しい学習方法である。

C-RLFTは、異なるデータソースをその品質に基づいて区別することで、言語モデルの入力情報を充実させる。この区別は、クラス条件付きポリシーの実装によって実現される。そして、このポリシーは、モデルが専門家が作成したデータ(品質が高い)と最適でないデータ(品質が低い)を区別するのに役立ちつ。そうすることで、C-RLFTはモデルに明示的なシグナルを与え、指示追従能力を向上させることができる。

C-RLFTは複雑な強化学習や高価な人間のフィードバックを必要としないため、比較的簡単に実装できる。研究者たちによれば、RLを使わない教師あり学習は1ステップで十分であり、AIは強化学習のような試行錯誤の手法に頼ることなく、正解のあるいくつかの例から学習する。これは時間と計算量の節約になる。

C-RLFTはベンチマークで可能性を示す

C-RLFTには、他の手法にはない利点がいくつかある。C-RLFTは良いデータと悪いデータが混在していても動作するため、データの質にあまり依存しないのだ。また、C-RLFTは複雑な学習・評価プロセスを必要としないため、他の手法よりも実装が容易であり、異なるデータ品質を特別に使用するため堅牢である。高価な人間のフィードバックに依存しないため、C-RLFTは費用対効果も高い。

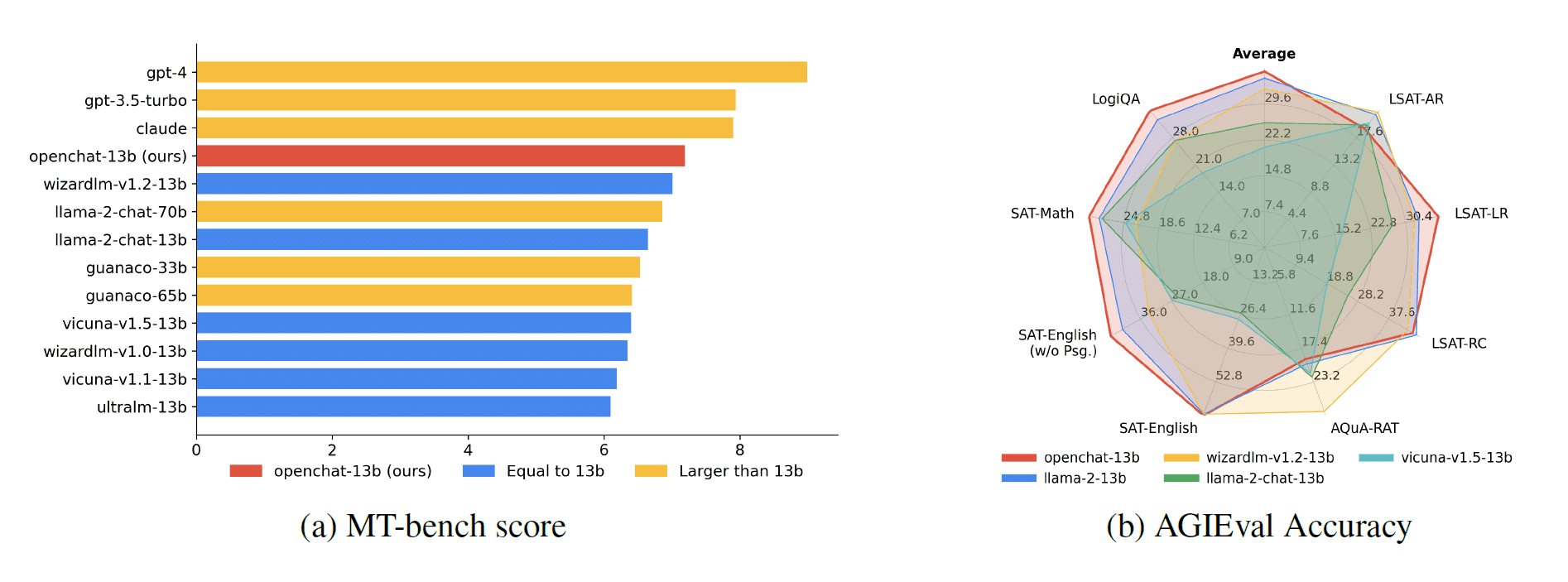

OpenChat、特にOpenChat-13 bモデルの性能は、様々なベンチマークで評価されている。使用された注目すべきベンチマークの1つはAlpacaEvalで、モデルの命令追従能力が試される。Openchat-13bは、LLaMA-2のような他の130億パラメータオープンソースモデルを凌駕する顕著な結果を示した。Openchat-13bは、より高い勝率と命令追従タスクにおける優れた性能を達成し、C-RLFT手法の有効性を実証している。

データの質の重要性は、研究チームによって強調された重要な側面である。その量には限りがあるものの、専門家データは言語モデルの性能を向上させる上で重要な役割を果たす。エキスパートデータと最適でないデータを区別する能力は、C-RLFT法と相まって、モデル性能の大幅な向上につながる。この発見は、言語モデルの学習を確実に成功させるために、高品質の学習データを管理することの重要性を強調している。

研究者たちは改善の余地があると見ている。例えば、異なるデータソース間の報酬の分配をさらに改良することができる。また、この方法は将来、論理的推論など、他の分野の言語モデルの能力を向上させるために利用できるかもしれない。

OpenChatフレームワークと関連するすべてのデータとモデルはGithubで公開されている。オンラインデモはこちらから。OpenChat v3 のモデルは Llama をベースにしており、Llama ライセンスの下で商用利用が可能だ。

論文

参考文献

- GitHub: imoneoi/openchat

- via The Decoder: OpenChat framework aims to optimize open-source language models

研究の要旨

今日では、LLaMAのようなオープンソースの大規模言語モデルが登場している。最近の開発では、これらのモデルを人間の目標に合わせるために、教師あり微調整(SFT)や強化学習微調整(RLFT)が取り入れられている。しかし、SFT法は質の異なる全ての訓練データを等しく扱うのに対し、RLFT法は質の高いペアワイズデータやランキングベースのプリファレンスデータを必要とする。本研究では、OpenChatと名付けられた新しいフレームワークを提示する。具体的には、嗜好ラベルのない、少量の専門家データと多くの割合の準最適データからなる一般的なSFT学習データを考える。我々は、C(onditioned)-RLFTを提案する。これは、異なるデータソースを粗視化された報酬ラベルとみなし、補完的なデータ品質情報を活用するためにクラス条件付きポリシーを学習する。興味深いことに、C-RLFTにおける最適な方針は、RLを用いない1段階の教師あり学習によって容易に解くことができる。3つの標準的なベンチマークでの広範な実験を通して、C-RLFTで微調整された我々のopenchat-13bは、13bオープンソース言語モデルの中で最高の平均性能を達成した。さらに、AGIEvalを用いてモデルの汎化性能を検証したところ、openchat-13bのみがベースモデルを上回る結果となりました。最後に、OpenChatの有効性と頑健性を明らかにするために、一連の分析を行います。我々のコード、データ、モデルはhttpsのURLで公開されている。

コメントを残す