ChatGPTが脚光を浴びて以来、1年も経たずして、現在では多くの商用およびオープンソースの大規模言語モデル(LLM)が、ちまたには溢れている。これら、数多くのLLMの性能を測るために、いくつかのベンチマークテストが存在するが、今回支援能力をテストするために特別に開発されたベンチマークの結果は、OpenAIのGPT-4が、依然としてこの分野で際立っていることを示している。

ベンチマークテスト「AgentBench」は、”実世界の実用的な任務”におけるLLMの支援能力を測定するために特別に設計された標準化されたテストである。すべてのテストはリアルタイムの対話環境で実施される。このため、このベンチマークは、大規模言語モデルが合計8つの領域で日常のさまざまなタスクをどの程度処理できるかという測定目的に特に適している。

- オペレーティング・システム:ここでは、LLMはコンピュータのオペレーティングシステムの使用に関連するタスクを実行しなければならない。

- データベース:この環境は、LLMがどれだけデータベースを使いこなせるかを問う。

- 知識グラフ:この環境では、LLMが知識グラフをどれだけ扱えるかが試される。

- デジタルカードゲーム:LLMがどれだけデジタルカードゲームを理解し、戦略を立てることができるかをテストする。

- ラテラルシンキングパズル:この課題では、LLMがいかに創造的に問題を解決できるかが試されます。既成概念にとらわれない発想が求められる。

- 予算:Alfworldのデータセットに基づき、予算内で発生するタスクについてのシナリオだ。

- インターネット・ショッピング:このシナリオでは、LLMがネットショッピングに関連するタスクをどれだけこなせるかをテストする。

- Web閲覧:Mind2Webデータセットに基づき、LLMがインターネット利用に関するタスクをどの程度こなせるかをテストする。

GPT-4が圧倒的な高性能を示す

清華大学、オハイオ州立大学、カリフォルニア大学バークレー校の研究チームは、複数のプロバイダーから提供された25の大規模言語モデルと、オープンソースのモデルをテストした。

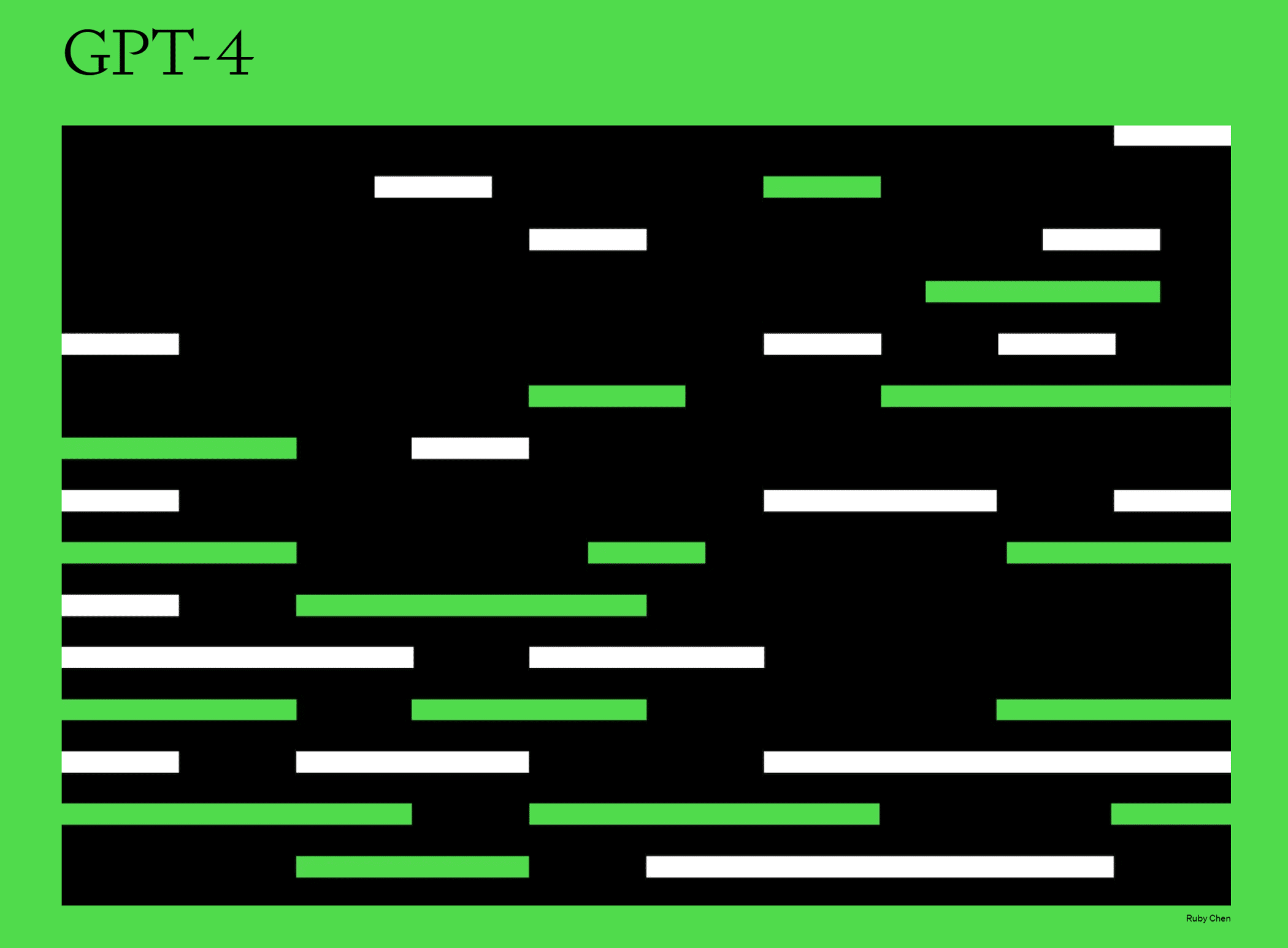

その結果OpenAIのGPT-4が4.41という最高の総合スコアを達成し、ほぼすべての分野で優位に立った。インターネット・ショッピングのタスクだけは、GPT-3.5がトップだった。

競合他社AnthropicのClaudeモデルは、OpenAIの無料モデルGPT-3.5 Turboを抑え、総合スコア2.77で僅差で続いた。商用モデルの平均スコアは2.24だった。

GPT-4と市販モデルやオープンソースモデルとの差は、全般的にさらに顕著だ:オープンソース・モデルの平均性能スコアはわずか0.42ポイントで、一般的にすべての複雑なタスクで失敗しており、GPT-3.5に大きく遅れをとっている、と研究者たちは書いている。Llama-13BをベースとしたOpenChatは、1.15ポイントを獲得し、オープンソース・モデルの中で最高のパフォーマンスであった。研究者らは、「我々は、トップレベルのLLMが複雑な実世界のミッションに取り組めるようになってきている一方で、オープンソースのコンペティターにはまだ長い道のりがあることを明らかにした」と、論文の中で述べている。

ただし、今回の研究には、GoogleのPaLM 2やClaude 2、Aleph Alphaのモデル、その他のオープンソースのモデルなど、多くの商用モデルが含まれていない事にも注意が必要だ。

そこで研究チームは、より広範な性能比較のために、ツールキット、データセット、ベンチマーク環境をGithub上で研究コミュニティに公開している。詳細情報とデモは、プロジェクトサイトで閲覧できる。

論文

参考文献

研究の要旨

大規模言語モデル(LLM)は、従来の自然言語処理タスクにとどまらず、実世界の実用的なミッションをターゲットとして、ますます賢く自律的になりつつある。その結果、LLMをエージェントとして、対話的な環境における困難なタスクで評価することが急務となっている。このベンチマークは、LLM-as-Agentの推論能力と意思決定能力をマルチターン・オープンエンドの生成設定で評価するためのもので、現在8つの異なる環境から構成されています。25のLLM(APIとオープンソースモデルを含む)を対象とした我々の広範なテストは、トップクラスの商用LLMが複雑な環境においてエージェントとして行動する強力な能力を示す一方で、オープンソースの競合製品との間には性能に大きな格差があることを示している。また、体系的なLLMの評価に向けて、より広い範囲をカバーし、より深い考察を行う進行中のプロジェクトの構成要素としての役割も果たしている。データセット、環境、AgentBenchの統合評価パッケージは、このhttps URLで公開されている。

コメントを残す