GoogleのAI研究部門であるGoogle DeepMindは、新AIモデル「RT-2(Robotics Transformer 2)」を発表した。これは、インターネットからかき集めたデータを使用し、平易な言語コマンドによってより優れたロボット制御を可能にする “世界初”のVLA(Vision-Language-Action)モデルとのことだ。同社によると、最終的な目標は、SF作品に登場する架空のロボットのように、人間の環境をナビゲートできる汎用ロボットを作ることである。

同社によると、ロボットのトレーニングは「至難の業」だという。なぜなら、ロボットは世界の各オブジェクト、環境、タスク、状況について、何十億ポイントものデータをトレーニングする必要があるからだ。しかし、RT-2を使えば、より汎用的なロボットになることが大いに期待できるとGoogleは言う。

人間があるタスクを学習しようとするとき、私たちはよく本を読んだり観察したりする。これと同じように、RT-2はオンライン上のテキストや画像で訓練された大規模言語モデル(LLM)を利用している。RT-2はこの情報を使って、たとえロボットがそのタスクをこなすように特別に訓練されていなくても、パターンを認識し、アクションを実行するのだ。

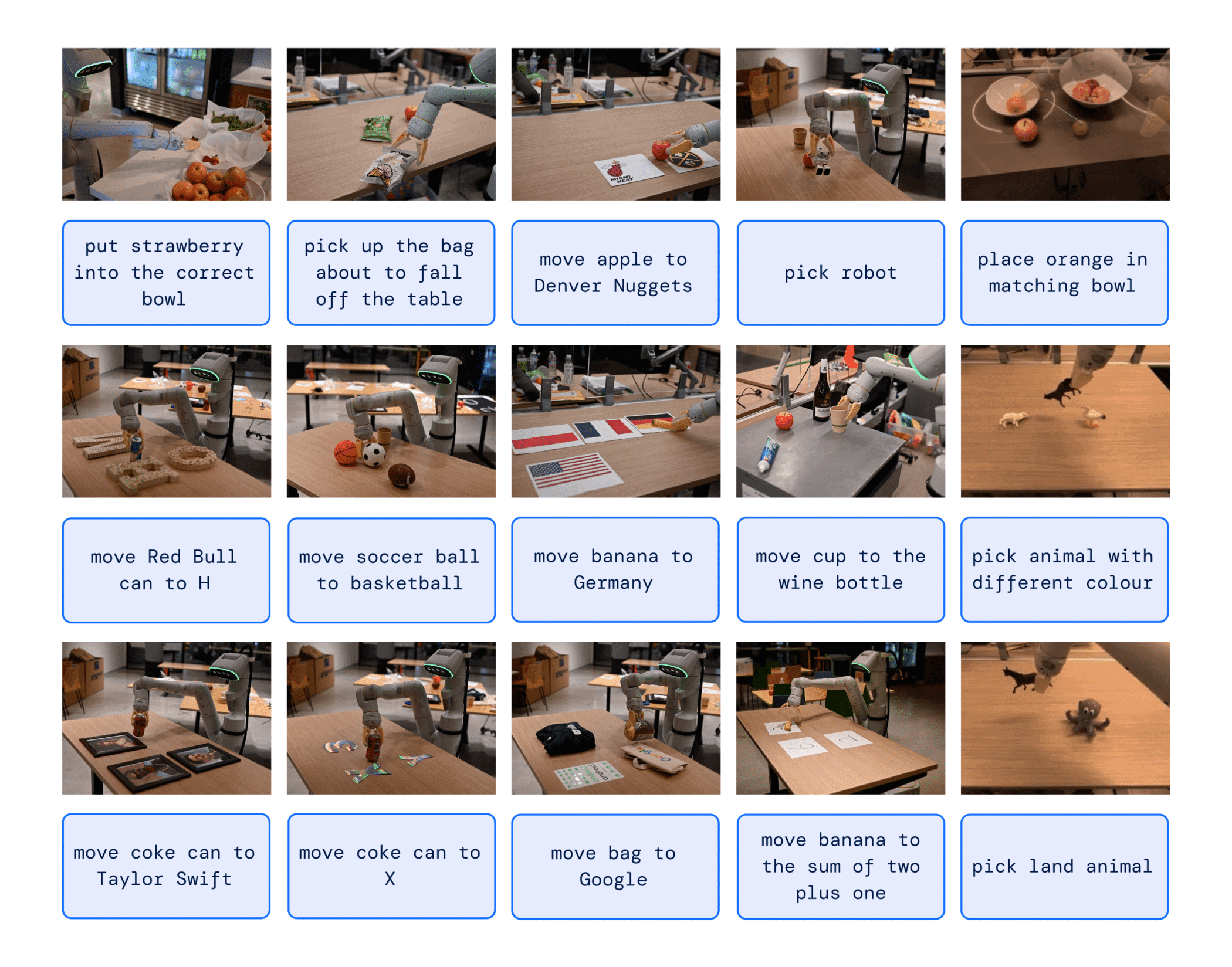

例えば、RT-2は特別な訓練を受けていなくてもロボットがゴミを認識し、捨てることができるという。RT-2は、ゴミとは何か、ゴミは通常どのように捨てられるかを理解し、その行動を導く。RT-2は、潜在的な曖昧さにもかかわらず、廃棄された食品の包装やバナナの皮さえゴミと見なすのだ。

別の例として、New York Times紙は、Googleのエンジニアが「絶滅した動物を拾ってくれ」と命令すると、RT-2ロボットがテーブルの上に置かれた3つの置物の中から恐竜を探し出し、選び出したと伝えている。

この能力は注目に値する。というのも、ロボットは通常、手動で取得した膨大な数のデータから訓練されるため、あらゆる可能性のあるシナリオを網羅するには時間とコストがかかり、そのプロセスは困難だからだ。簡単に言えば、実世界はダイナミックな混乱状態にあり、状況や物体の構成が変化する。実用的なロボット・ヘルパーは、明示的にプログラムすることが不可能な方法で、その場で適応できる必要がある。

Transformerを実世界に応用

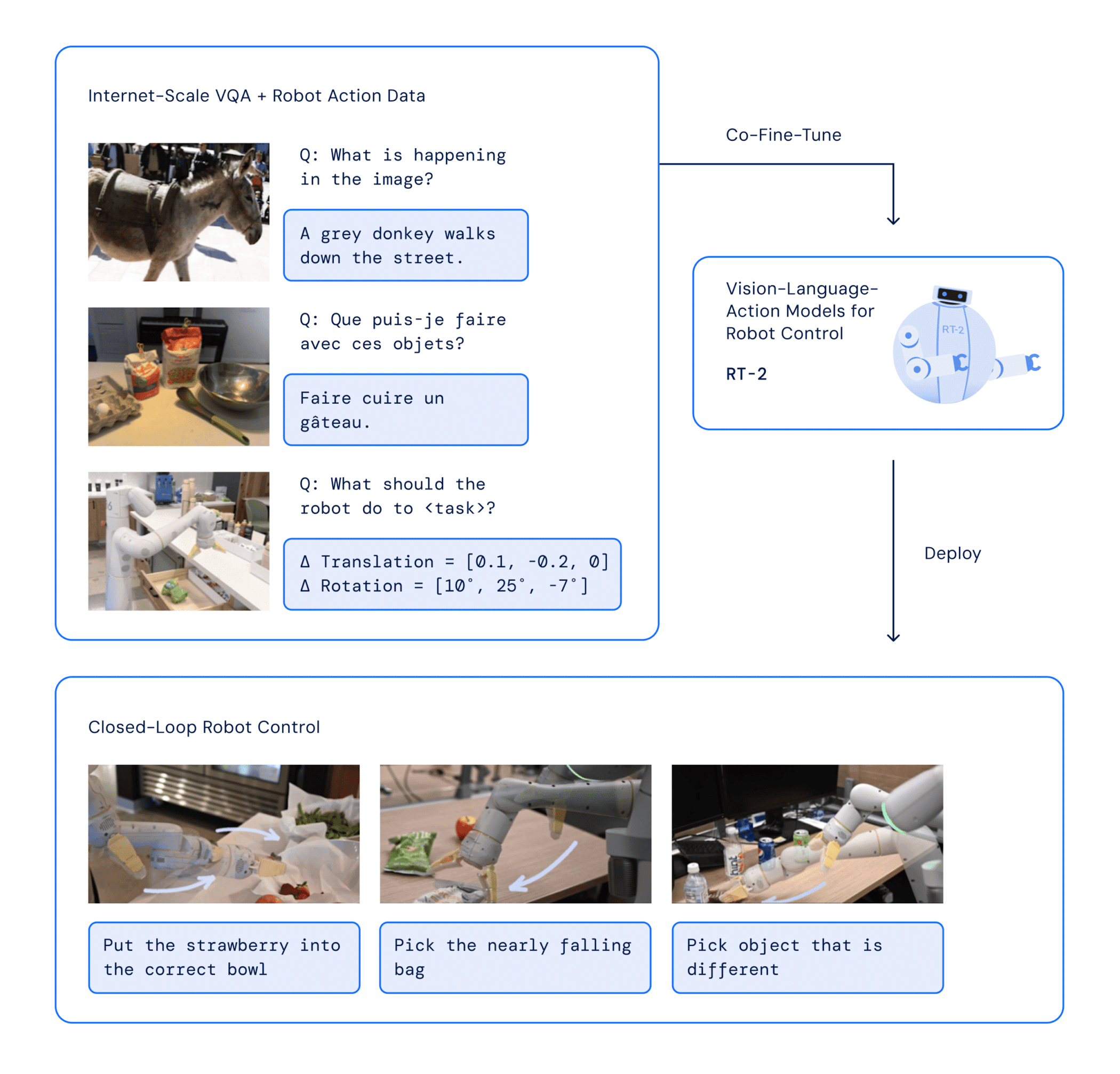

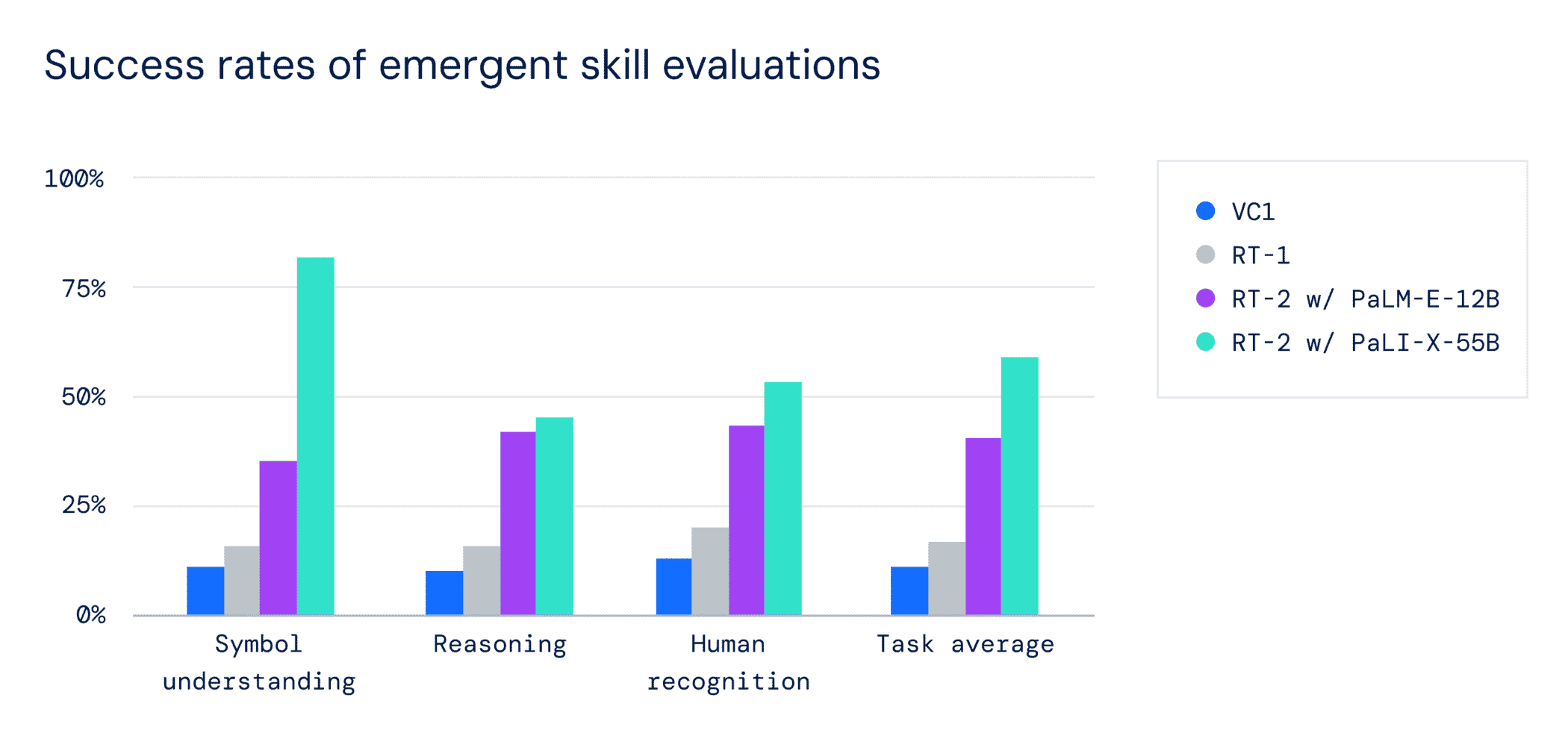

Google DeepMindはRT-2で、情報を汎化する能力で知られるTransformer AIモデルの強みを生かす戦略を採用した。RT-2は、Pathways Language and Image model(PaLI-X)やPathways Language model Embodied(PaLM-E)を含む、Googleにおける以前のAI研究を活用している。さらに、RT-2はその前身モデル(RT-1)のデータで共同学習された。RT-1は、13台のロボットによって「オフィスのキッチン環境」で17カ月にわたって収集された。

RT-2のアーキテクチャは、ロボット工学とWebデータで事前に訓練されたVLMモデルを微調整することを含む。その結果、モデルはロボットのカメラ画像を処理し、ロボットが実行すべき行動を予測する。

RT-2は情報を処理するために言語モデルを使用するため、Googleはアクションをトークン(伝統的に単語の断片)として表現することにした。「ロボットを制御するためには、ロボットがアクションを出力するように訓練する必要があります。我々は、モデルの出力において、アクションをトークンとして表現することで、この課題に取り組んでいます」と、同社は語る。

RT-2の開発において、研究者たちはロボットの最初のバージョンであるRT-1で行ったのと同じように、ロボットの動作をより小さなパーツに分解する方法を用いた。彼らは、これらの動作を一連のシンボルやコード(「文字列」表現)にすることで、Webデータの処理に使用しているのと同じ学習モデルを使用して、ロボットに新しいスキルを教えることができることを発見した。

このモデルはまた、思考の連鎖推論を利用し、代替ツール(即席ハンマーとしての石)を選んだり、疲れた人に最適な飲み物(エナジードリンク)を選んだりするような、多段階の推論を可能にする。

Googleによると、6,000回以上の試行で、RT-2は「見た」タスクと呼ばれる訓練済みのタスクでは、前身のRT-1と同等の性能を発揮したという。しかし、新しい “見えない”シナリオでテストしたところ、RT-1の32%に対し、RT-2はほぼ倍の62%のパフォーマンスを示した。

同社は、RT-2が解き放つ可能性に興奮しているが、人間中心の環境で役に立つロボットを実現するためには、多くの作業を行う必要があると述べている。Google DeepMindによれば、最終的には、VLAモデルから汎用の物理的ロボットが生まれ、実世界のタスクを実行するための推論、問題解決、情報の解釈が可能になるという。

RT-2はロボット工学にとって大きな前進ではあるが、ターミネーター・ロボットが登場したと宣言するのは公正ではないだろう。このモデルはまだ人間の入力と監視を必要とし、実際のロボット操作では技術的に大きな限界がある。

とはいえ、これまで不可能であった、あるいは容易でなかったタスクをこなす興味深いロボットが誕生することを期待したい。

論文

- Google DeepMind: RT-2:Vision-Language-Action Models Transfer Web Knowledge to Robotic Control (PDF)

参考文献

- Google DeepMind: RT-2: New model translates vision and language into action

- Google The Keyword: Speaking robot: Our new AI model translates vision and language into robotic actions

- The New York Times: Aided by A.I. Language Models, Google’s Robots Are Getting Smart

研究の要旨

我々は、インターネット・スケールのデータで学習した視覚言語モデルを、どのようにエンド・ツー・エンドのロボット制御に直接組み込むことができるかを研究している。エンド・ツー・エンドのロボット制御に直接組み込むことで、汎化を促進し、創発的な意味論的推論を可能にする方法を研究する。我々の目標は、単一のエンド・ツー・エンドの学習済みモデルで、ロボットの観察結果を行動にマッピングする学習と、Web上の言語および視覚言語データに対する大規模な事前学習の利点を享受することを可能にすることである。この目的のために、我々は、ロボットの軌跡データと、視覚的な質問応答のようなインターネットスケールの視覚言語タスクの両方で、最先端の視覚言語モデルを共同微調整することを提案する。他のアプローチとは対照的に、我々はこの目標を達成するためのシンプルで一般的なレシピを提案する:自然言語応答とロボットのアクションの両方を同じフォーマットに適合させるために、我々はアクションをテキストトークンとして表現し、自然言語トークンと同じようにモデルの学習セットに直接組み込む。このようなモデルを視覚言語行動モデル(VLA)と呼び、その一例をRT-2と呼ぶ。私たちの広範な評価(6k回の評価トライアル)は、私たちのアプローチがパフォーマンスの高いロボットポリシーを導き、RT-2がインターネットスケールのトレーニングから様々な創発的能力を得ることを可能にすることを示している。これには、新しいオブジェクトへの汎化が大幅に改善されたこと、ロボット訓練データには存在しないコマンドを解釈する能力(オブジェクトを特定の数字やアイコンの上に置くなど)、ユーザーコマンドに応答して初歩的な推論を実行する能力(最小または最大のオブジェクトや他のオブジェクトに最も近いものをピックアップするなど)が含まれる。さらに、思考の連鎖推論を取り入れることで、RT-2が多段階の意味推論を行うことができることを示す。例えば、即席のハンマーとして使用するためにどの物体を拾うべきか(石)、あるいは疲れている人に最適な飲み物の種類はどれか(エナジードリンク)などを見つけ出すことができる。

コメントを残す