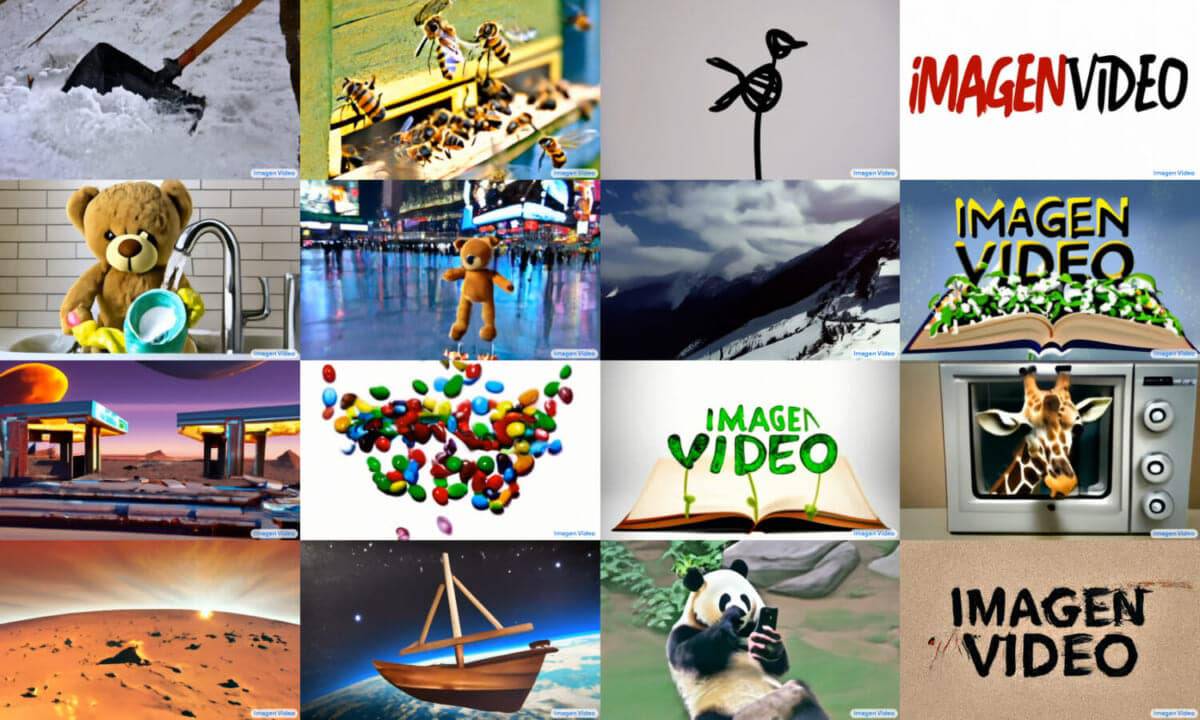

Googleが、文章によるプロンプトから1280×768の動画を毎秒24フレームで生成できる「Text-to-Video」AIの「Imagen Video」の開発を発表した。現在は研究段階だが、Google Imagenから5ヶ月での登場は、動画合成モデルの急速な発展の現れだろう。

- 論文

- 参考文献

OpenAIのテキストから画像への生成ツールDALLE-2の発表からわずか半年、AI 拡散モデルの分野における進歩は急速に加熱している。GoogleのImagen Videoの発表は、Metaがテキストから動画へのAIツール「Make-A-Video」を発表してから1週間も経たないうちに行われた。

Googleの研究論文によると、Imagen Videoには、有名画家の作品(例えばフィンセント・ファン・ゴッホの絵画)に基づく動画の生成、オブジェクト構造を保持したままの3D回転オブジェクトの生成、さまざまなアニメーションスタイルでのテキストレンダリングなど、注目すべき様式的能力がいくつか含まれているとのことだ。Googleは、汎用的な映像合成モデルによって、「高品質なコンテンツ生成の難易度を大幅に下げることができる」と期待している。

Imagen Videoの能力の鍵は、7つの拡散モデルの「カスケード」であり、最初のテキストプロンプト(「皿洗いをする熊」など)を低解像度ビデオ(16フレーム、24×48ピクセル、3fps)に変換し、ステップごとに徐々に高解像度、高フレームレートにアップスケールしていくものである。最終的に出力される映像は5.3秒になります。

Imagen Videoのウェブサイトに掲載されている動画の例は、ありふれたもの(「コーンに滴る溶けたアイスクリーム」)から幻想的なもの(「嵐の海で海賊船同士の激しい戦闘を飛ぶ」)まで様々だ。

Googleの発表と時を同じくして、一つのText-to-Videoモデルも本日正式にデビューした。Phenakiと呼ばれるこのモデルは、詳細なプロンプトから長い動画を作成することができる。このように、テキストプロンプトから3Dモデルを作成できるDreamFusionとともに、拡散モデルに関する競争的な開発は急速に進んでおり、arXivに掲載されるAI論文の数は、一部の研究者にとって最新動向を把握することが困難なほど指数関数的に増加している。

Google Imagen Videoの学習データは、Googleによると、一般に公開されているLAION-400M image-text datasetと「1400万のビデオ-テキストペアと6000万のイメージ-テキストペア」から得ている。その結果、Googleによってフィルタリングされた「問題のあるデータ」で学習させたが、それでも性的に露骨な内容や暴力的な内容、さらには社会的ステレオタイプや文化的バイアスが含まれる可能性がある。同社はまた、そのツールが 「偽の、憎悪に満ちた、露骨な、または有害なコンテンツを生成する」ために使用される可能性があることを懸念している。

そのため、すぐに一般公開されることはなさそうだ。「我々はこれらの懸念が軽減されるまで、Imagen Videoモデルまたはそのソースコードを解放しないことを決定した」とGoogleは述べている。

論文の概要

我々は、ビデオ拡散モデルのカスケードに基づいて、テキスト条件付きビデオ生成システムであるイマージェン ビデオを発表する。テキストプロンプトが与えられると、Imagen Videoはベースビデオ生成モデルと、インターリーブされた空間および時間ビデオ超解像モデルのシーケンスを用いて高解像度ビデオを生成する。我々は、特定の解像度における完全畳み込み時間的・空間的超解像モデルの選択、拡散モデルのvパラメータ化の選択などの設計上の決定を含む、高解像度テキスト-ビデオモデルとしてシステムをスケールアップする方法について説明する。さらに、拡散に基づく画像生成に関する先行研究の知見を確認し、ビデオ生成の設定に移行する。最後に、高速かつ高品質なサンプリングのために、分類器不要のガイダンスとともに、ビデオモデルに漸進的蒸留を適用します。我々は、Imagen Videoが忠実度の高いビデオを生成できるだけでなく、様々な芸術的スタイルの多様なビデオやテキストアニメーションを生成し、3Dオブジェクトを理解する能力を含む、高度な制御性と世界知識を持つことを発見しました。

コメントを残す